Ampere A100 от Nvidia — самый мощный ИИ-ускоритель до момента появления Hopper H100, не говоря уже о H200 и грядущем Blackwell GB200. Но, как оказалось, есть более продвинутая версия A100, она улучшена по сравнению с обычной моделью. Ускоритель свободно продаётся в Китае, несмотря на санкции со стороны США. Возможно, Nvidia экспериментировала с ускорителем, либо же его модифицировали специально для Китая.

Особенности продвинутой модели

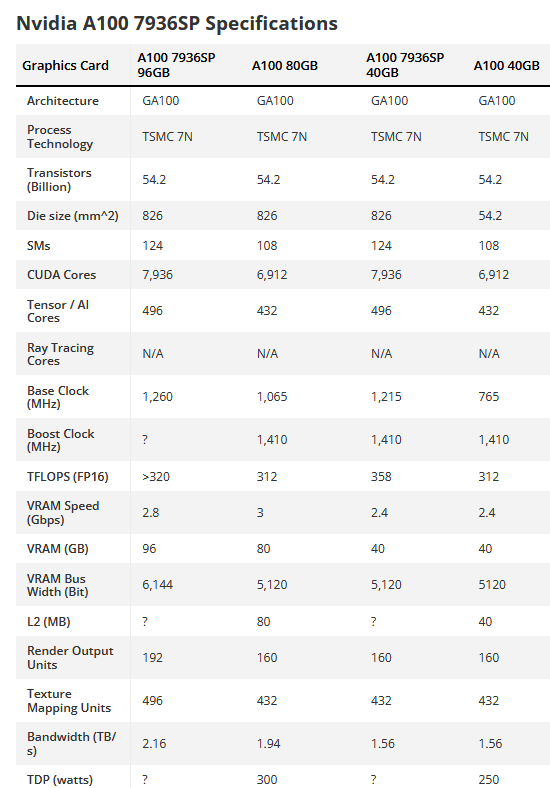

Несмотря на улучшенные характеристики, у A100 7936SP тот же чип, что и у обычного А100. Однако у первого 124 включённых SM (Streaming Multiprocessors) из 128 возможных на чипе GA100. Хотя это и не максимальная конфигурация, но у A100 7936SP на 15% больше ядер CUDA, чем у стандартного A100, что означает значительный прирост производительности.

Число тензорных ядер также повышается пропорционально количеству SM. Если судить только по спецификациям, увеличение количества ядер SM, CUDA и Tensor на 15% может аналогичным образом повысить общую производительность для ИИ на 15%.

Nvidia предлагает A100 в конфигурациях 40 Гб и 80 Гб. A100 7936SP также выпускается в двух вариантах. Модель A100 7936SP 40 Гб имеет базовую тактовую частоту на 59% выше, чем A100 80 Гб, сохраняя при этом ту же тактовую частоту в режиме Boost 1 410 МГц. С другой стороны, A100 7936SP 96 Гб показывает базовую тактовую частоту на 18% выше, чем обычный A100, а также позволяет обеспечить до 96 Гб общей памяти.

Подсистема памяти A100 7936SP 40 Гб идентична A100 40 Гб. 40 Гб HBM2 работает со скоростью 2,4 ГБ/с через 5 120-битный интерфейс памяти с использованием пяти стеков HBM2. Такое решение обеспечивает максимальную пропускную способность памяти до 1,56 ТБ/с. Однако стоит обратить внимание на модель A100 7936SP 96 Гб. Видеокарта имеет на 20% больше памяти HBM2, чем предлагает Nvidia, благодаря шестому включённому стеку HBM2. Обучение очень больших языковых моделей может потребовать немалого объёма памяти, поэтому дополнительные возможности лишними явно не будут.

Похоже, что A100 7936SP 96 Гб имеет обновлённую подсистему памяти по сравнению с A100 80 Гб — память HBM2 работает со скоростью 2,8 ГБ/с вместо 3 ГБ/с, но располагается на более широкой 6 144-битной шине памяти, что помогает компенсировать разницу. В результате пропускная способность A100 7936SP 96 Гб примерно на 11% выше, чем у A100 80 Гб.

У A100 40 Гб и 80 Гб — TDP 250 Вт и 300 Вт соответственно. Учитывая более продвинутые характеристики, A100 7936SP, скорее всего, также с улучшенным TDP. Но здесь нюанс: поскольку A100 7936SP, вероятно, инженерный прототип, ускоритель может не использовать все три разъёма питания, но энергопотребление у него выше, чем у стандартного A100, благодаря дополнительным ядрам CUDA и памяти HBM2.

Ещё интересно то, что многие китайские продавцы выкладывают A100 7936SP на eBay. Модель на 96 Гб стоит от $18 000 до $19 800.

Откуда это всё? Здесь можно лишь догадываться, являются ускорители техническими образцами, вышедшими из лаборатории Nvidia, или это специализированные модели, разработанные производителем чипов для определённого клиента.

Как вообще эти чипы поступают в Китай?

С момента появления А100 и более мощных чипов их поставки запрещены в Китай со стороны США. Но пути обхода есть, и китайцы активно их используют. Речь идёт о небольших каналах, позволяющих поставлять в КНР относительно скромные партии чипов. Их в основном закупают научно-исследовательские центры и университеты. Причём поставщики остаются неизвестными, поскольку производители в их число не входят. Так, представитель Nvidia в 2023 году заявил, что компания соблюдает все законы об экспортном контроле.

Журналистам Reuters ещё в прошлом году удалось найти информацию о поставках в страну малых партий ИИ-ускорителей. Так, например, Харбинский технологический институт приобрёл шесть чипов Nvidia A100 для создания и развития «модели глубокого обучения», а в декабре 2022 года Китайский университет электронных наук и технологий закупил один A100 для пока неизвестных целей. Это лишь то, что «лежит на поверхности», но, вероятно, есть теневые каналы поставок, по которым в Китай поступают более крупные партии. К слову, Университету Цинхуа удалось приобрести свыше 80 чипов А100 после санкций 2022 года. Кроме того, закупали чипы и Университет Цунцина, компания Shandong Chengxiang Electronic Technology и другие.

В целом, речь идёт о сотнях небольших каналов поставок, которые при желании можно отследить. Одно можно сказать с уверенностью: всё это используется китайцами по назначению — для развития ИИ-технологий.

Отдельные попытки не потерять клиентов из Китая предпринимают и производители. Так, Nvidia относительно недавно анонсировала карту GeForce RTX 4090D. Чип выпущен специально под требования китайского рынка, без нарушения санкционных постановлений. Вероятно, есть и другие инструменты обхода экспортного контроля, которые и используют как компании из КНР, так и их партнёры.

Комментарии (3)

DOLARiON

21.04.2024 14:44Вот кстати! А 4090 никто не пытался чип памяти перепаивать? Я пытался гуглить и не нашел ничего подобного... Я думаю это было бы очень интересно взять с 4090 с 80гб памяти, пусть даже и оттестированной перепайке

Grigory_Otrepyev

Это все конечно интересно, а в блоге МТС так и не хотят все же рассказать про себя? что у них падало вместе с ЦОД и почему?

electrofetish

Лучше спросить, когда наступит прогресс в сотовой коммуникации и будем платить только за потраченное электричество на узлах: у нас жеж конкуренция? или нет?