Ссылка на первую часть истории для тех, кто ее пропустил

Хочу продолжить свое повествование о сборке «деревенского суперкомпьютера». И поясню почему он так назван — причина простая. Я сам живу в деревне. И название — легкий троллинг над теми кто кричит в интернете «За МКАД жизни нет!», «Русская деревня спилась и вымирает!» Так вот, где-то это может быть и так, а я буду исключением из правил. Не пью, не курю, делаю вещи которые не всякому «городскому креаклу(с)» по уму и карману. Но вернемся к нашим баранам, точнее — серверу, который в конце первой части статьи уже «подавал признаки жизни».

Плата лежала на столе, я полазил по BIOS настраивая его по своему вкусу, накатал Ubuntu 16.04 Desktop для простоты и решил подключить к «супер-машине» видеокарту. Но под рукой была только GTS 250 с приклеенным здоровенным не родным вентилятором. Которую я и установил в PCI-E 16x слот около кнопки питания.

«Снимал на пачку Беломора(с)» так что прошу не пинать за качество фото. Лучше я прокомментирую то, что на них запечатлено.

Во первых — оказалось что при установке в слот — даже коротая видеокарта упирается платой в разъемы памяти, в которые по этому случаю ее нельзя установить и даже приходится опускать защелки. Во вторых железная крепежная планка видеокарты закрывает кнопку питания, так что ее пришлось снять. Кстати и сама кнопка питания — подсвечена двухцветным светодиодом, который горит зеленым когда все в порядке и мигает оранжевым если какие-то проблемы, замыкание и сработала защита БП или питание +12VSB завышено или занижено.

На самом деле, эта материнская плата не предназначена чтобы в ее слоты PCI-E 16x включались видеокарты «напрямую», они все присоединяются на райзерах. Для установки карты расширения в слоты около кнопки питания есть угловые райзеры, низкий для установки коротких карт длиной до первого радиатора процессора, и высокий угловой с разъемом дополнительного питания +12В для установки видеокарты «над» штатным низким 1U кулером. В него можно включать большие видеокарты вроде GTX 780, GTX 980, GTX 1080 либо специализированные GPGPU-карты Nvidia Tesla K10-K20-K40 или «вычислительные карты» Intel Xeon Phi 5110p и ему подобные.

Зато в GPGPU-райзер включаемый в EdgeSlot карту можно включить напрямую, только опять же подключив дополнительное питание таким-же разъемом как на высоком угловом райзере. Кому интересно — на eBay этот гибкий райзер называется «Dell PowerEdge C8220X PCI-E GPGPU DJC89» и стоит около 2.5-3 тысяч рублей. Угловые райзеры с дополнительным питанием штука намного более редкая и мне пришлось договариваться чтобы их купили из специализированного магазина серверных запчастей через Шопотам. Вышли они по 7 тысяч за штуку.

Скажу сразу, «рисковые парни(тм)» могут подключить даже пару GTX 980 к плате китайскими гибкими райзерами 16х как сделал один человек на «Том Самом Форуме», китайцы кстати делают вполне неплохо работающие на PCI-E 16х 2.0 поделки в стиле Термалтэковских гибких райзеров, но если у вас от такого однажды прогорят цепи питания на плате сервера — винить будете только себя. Я не стал рисковать дорогим оборудованием и использовал оригинальные райзеры с дополнительным питанием и один китайский гибкий, посчитав что подключение одной карты «напрямую» плату не спалит.

Потом приехали долгожданные разъемы для подключения дополнительного питания и я сделал хвост для своего райзера в EdgeSlot. И такой-же разъем, но с иной распиновкой использован чтобы подать дополнительное питание на материнскую плату. Этот разъем как раз около этого самого разъема EdgeSlot, там интересная распиновка. Если на райзере 2 провода +12 и 2 общих, то на плате 3 провода +12 и 1 общий.

Вот собственно та самая GTS 250 включена в GPGPU-райзер. Дополнительное питание у меня кстати берется на райзеры и материнку — со второго разъема питания +12В CPU моего БП. Я решил что так будет сделать более правильно.

Быстро сказка сказывается, да медленно посылки в Россию из Китая и других мест земного шара едут. Потому в сборке «суперкомпьютера» были большие промежутки. Но вот наконец ко мне приехала серверная Nvidia Tesla K20M с пассивным радиатором. Причем совершенно нулевая, с хранения, заклеенная в родную коробку, в родной пакет, с гарантийными бумажками. И начались страдания как же ее охлаждать?

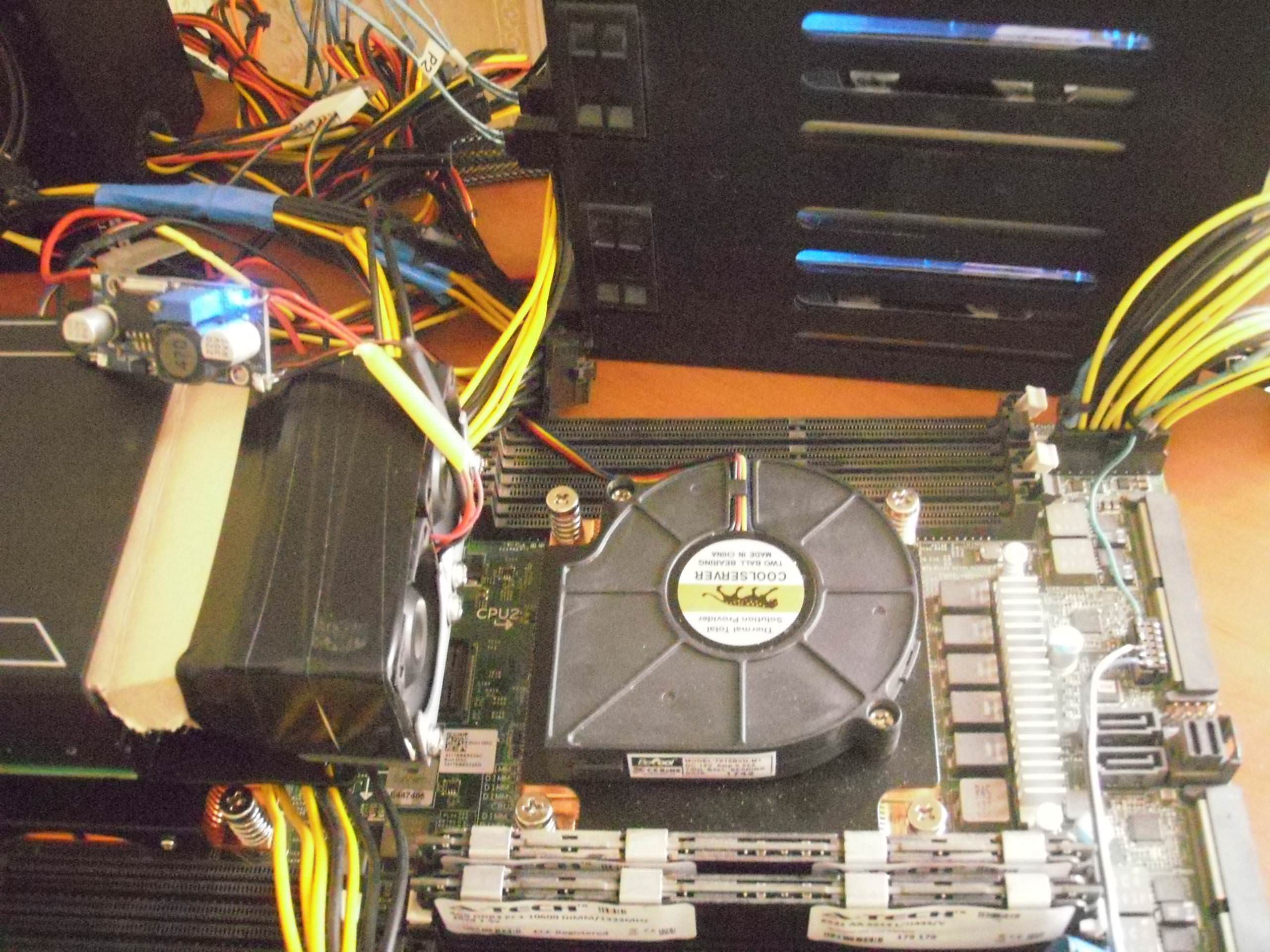

Сначала был куплен из Англии кастомный кулер с двумя маленькими «турбинами», вот оно на фото, с самодельным картонным диффузором.

И оказались они полной лажей. Шумели сильно, крепление не подошло вообще, дули слабо и давали такую вибрацию что я боялся что от платы Теслы компоненты отвалятся! Почему они были отправлены в помойку почти сразу.

Кстати, на фото под Теслой видны установленные на процессоры радиаторы LGA 2011 1U серверные медные с улиткой от Coolerserver купленные с Алиэкспресса. Весьма достойные хотя и шумноватые кулеры. Подошли идеально.

Но собственно пока я ждал новый кулер на Теслу, на этот раз заказав аж из Австралии улитку большую BFB1012ЕН с распечатанным на 3D-принтере креплением, дошло дело до системы хранения данных сервера. На плате сервера есть разъем mini-SAS через который выведены 4 SATA и еще 2 SATA обычными разъемами. Все SATA стандарта 2.0 но меня это устраивает.

Интегрированный в чипсет RAID intel C602 не плох и главное пропускает команду TRIM для SSD, что внешние RAID-контроллеры недорогие многие не умеют.

На еВау я купил кабель mini-SAS to 4 SATA длиной в метр, а на Авито — корзину горячей замены в 5,25" отсек на 4 х 2,5" SAS-SATA. Так что когда приехал кабель и корзина — в нее были установлены 4 терабайтных Сигейта, в BIOS был собран RAID5 на 4 устройства, начал я ставить серверную Ubuntu… и уткнулся в то что программа разметки дисков не давала на рейде сделать swap-раздел.

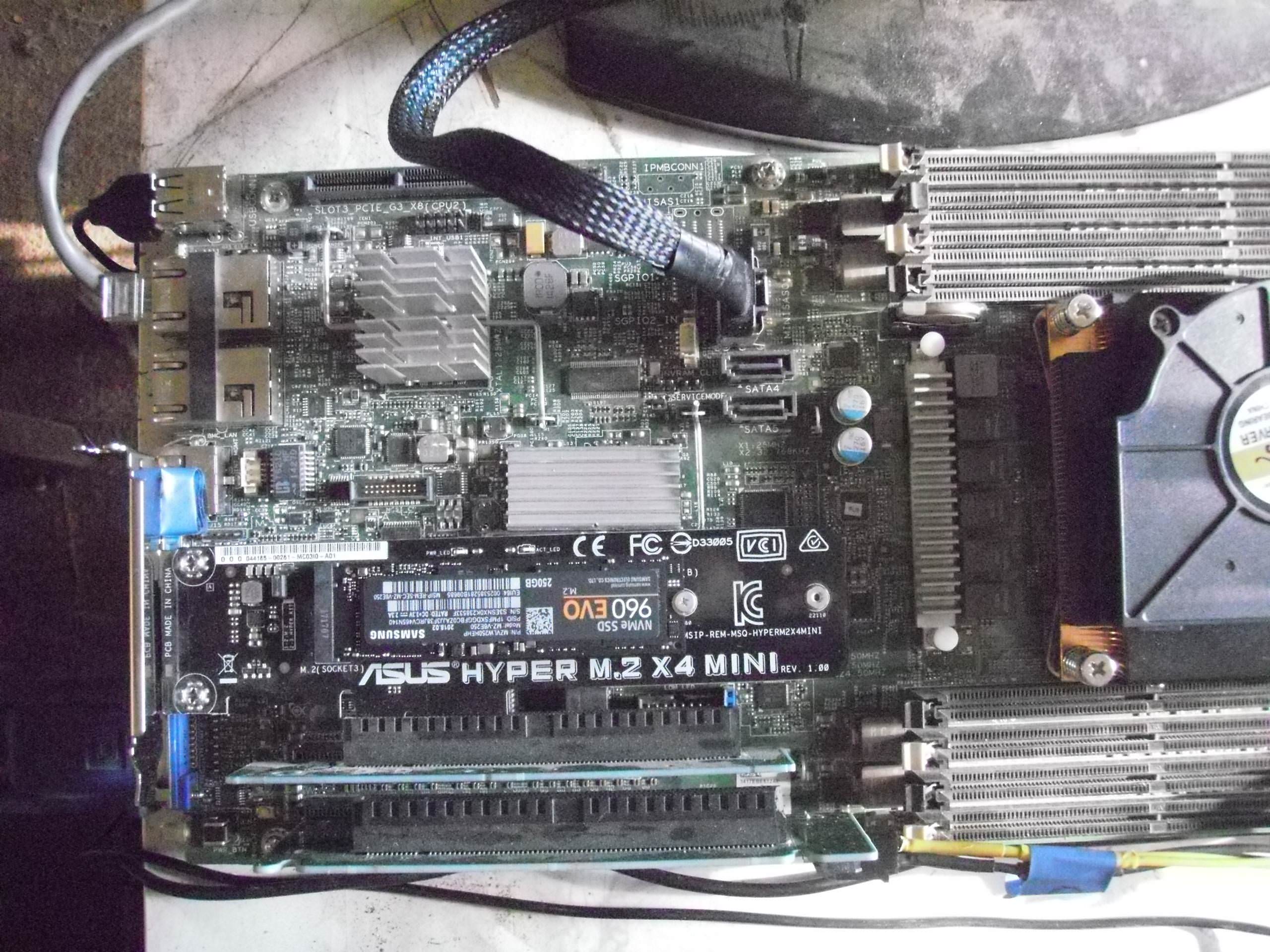

Решил я проблему в лоб — купил в DNS PCI-E to M.2 адаптер ASUS HYPER M.2 x 4 MINI и M.2 SSD Samsung 960 EVO 250 Gb реши что под swap надо выделить максимально скоростное устройство, раз система будет работать с высокой вычислительной нагрузкой, а памяти все равно заведомо меньше чем размер данных. Да и память на 256 гб дороже была чем этот SSD.

Вот этот самый переходник с установленным SSD в низком угловом райзере.

Предвидя вопросы — «А почему не сделать всю систему на М.2 и иметь максимальную скорость доступа выше чем у рейда на SATA?» — отвечу. Во первых на 1 и более Тб М2 SSD стоят для меня слишком дорого. Во вторых — даже после обновления BIOS на последнюю версию 2.8.1 сервер все равно не поддерживает загрузку в M.2 NVE устройств. Я делал опыт когда система ставила /boot на USB FLASH 64 Gb а все остальное на М.2 SSD, но мне не понравилось. Хотя в принципе такая связка вполне работоспособна. Если М.2 NVE большой емкости подешевеют — я возможно вернусь к такому варианту, но пока SATA RAID как система хранения меня вполне устраивает.

Когда с дисковой подсистемой я определился придя к комбинации 2 х SSD Kingston 240 Gb RAID1 "/" + 4 x HDD Seagate 1 Tb RAID5 "/home" + M.2 SSD Samsung 960 EVO 250 Gb «swap» пришло время продолжить свои опыты с GPU. Тесла у меня уже была и как раз приехал австралийский кулер со «злой» улиткой кушающей аж 2.94А по 12В, второй слот занимала М.2 и для третьего я одолжил «на опыты» GT 610.

Вот на фото все 3 устройства подключены, причем М.2 SSD через гибкий Термалтэковский райзер для видеокарт который на 3.0 шине работает без ошибок. Он вот такой, из множества отдельных «ленточек» на подобии тех из которых сделаны кабели SATA. PCI-E 16x райзеры сделанные из монолитного плоского шлейфа вроде как у старых IDE-SCSI — в топку, они замучают ошибками из-за взаимных наводок. И как я уже говорил, китайцы делают теперь тоже такие райзеры как у Термалтэка но короче.

В комбинации с Теслой К20 + GT 610 я много чего пробовал, заодно выяснив что при подключении внешней видеокарты и переключении на нее вывода в BIOS не работает vKVM, что меня не особо расстроило. Все равно использовать на этой системе внешнее видео я не планировал, на Теслах нет видеовыходов, а удаленная админка по SSH и без Х-сов работает прекрасно когда слегка вспомнишь что такое командная строка без GUI. Зато IPMI + vKVM очень упрощает управление, переустановку и прочие моменты с удаленным сервером.

Вообще у этой платы IPMI шикарен. Отдельный порт 100 мбит, возможность перенастроить инжекцию пакетов на один из 10 Гбит портов, Web-сервер встроенный для управления питанием и контроля серверов, закачка прямо из него Java-клиента vKVM и клиента удаленного монтирования дисков или образов для переустановки… Единственное — клиенты под старую Java Оракловскую, которая уже не поддерживается в Linux и для удаленной админки пришлось завести ноутбук с Win XP SP3 с этой самой древней Жабой. Ну и клиент медленный, для админки и всего такого хватает, но в игрушки не поиграешь удаленно, FPS маленький. Да и видео ASPEED которое интегрировано с IPMI слабенькое, только VGA.

В процессе разбирательства с сервером я многое узнал и многому научился в области профессионального серверного железа фирмы Dell. О чем совсем не жалею, как и о потраченном с пользой времени и деньгах. Продолжение познавательной истории про собственно сборку каркаса со всеми компонентами сервера будет позднее.

Ссылка на часть 3: habr.com/ru/post/454480

Комментарии (59)

bisquitie

02.06.2019 01:14Жду часть про корпус. В своём подобном конструкторе я делал корпус из папье-маше :-)

Saber-Toothed Автор

02.06.2019 01:22Корпуса как такового там нет, только каркас из алюминиевого уголка. Нечему гореть + хорошая вентиляция.

Dr_Sigmund

02.06.2019 02:22Вообще у этой платы IPMI шикарен. Отдельный порт 100 мбит, возможность перенастроить инжекцию пакетов на один их 10 Гбит портов, Web-сервер встроенный для управления питанием и контроля серверов, закачка прямо из него Java-клиента vKVM и клиента удаленного монтирования дисков или образов для переустановки…

Это довольно стандартно для серверов. У Lenovo/IBM примерно то же самое.

Единственное — клиенты под старую Java Оракловскую, которая уже не поддерживается в Linux и для удаленной админки пришлось завести ноутбук с Win XP SP3 с этой самой древней Жабой.

Держать ради этого отдельный ноутбук — перебор, разве что он используется ещё для других дел. Задача для виртуалки. Делал то же самое для управления старым сервером IBM.

osmanpasha

02.06.2019 08:07Поразительно, одна из киллер-фич java для бизнеса — обратная совместимость чуть ли не с самой первой версией. Как так, что приходится виртуалки заводить и ноутбуки с виндой?

Saber-Toothed Автор

02.06.2019 10:15Такая вот ситуация оказалась.

MAXXL

02.06.2019 12:24а свежие прошивки BIOS-а эту проблему не решают? У SUPERMICRO на старых прошивках тоже под старую Java был IPMI, а в свежих добавили HTML5, теперь можно с любого компа и с любой операционки.

Saber-Toothed Автор

02.06.2019 15:06-1Я пока не стал обновлять firmware IPMI. Есть более насущные дела.

SergeyMax

02.06.2019 16:18+1У хьюлета iLO тоже использует Джаву, но даже с самой древней моделью можно удалённо работать из современной операционки (правда потребуется некоторое шаманство с настройками безопасности IE).

Akela_wolf

02.06.2019 14:51Вот мне тоже интересно. Почему клиент под старую версию джавы не заводится под новой? Compile once, run everywhere!

kmeaw

02.06.2019 15:43+1Потому что там не просто клиент на Java, а он ещё platform-specific nativelib привозит, о чём написано внутри jnlp-файла.

Dr_Sigmund

03.06.2019 02:38Мой старый IBM не использовал JNLP, просто открывал отдельную страницу с двумя апплетами — консоль и управление монтированием образов.

Dr_Sigmund

03.06.2019 02:39Ответил на такой же вопрос osmanpasha. Дело не в самом Java-коде, а в подписях.

Dr_Sigmund

03.06.2019 02:36Насчёт Dell не уверен, а у моего IBM протухла подпись на апплетах. Честно говоря, уже не помню, что именно — то ли просто истёк срок действия сертификата (а тайм-стампа подписи не было), то ли JRE стала ругаться на устаревший алгоритм подписи, то ли и то и другое вместе. До каких-то пор проблему удавалось решать путём настройки исключений безопасности в JRE для адреса RSAII (старый IBM-овский контроллер OOB-управления), потом это как-то перестало помогать. Решил вопрос при помощи виртуалки с XP, старой JRE и отмотанными на несколько лет назад часами. Кардинально решить было бы можно, переподписав апплеты своими сертификатами, но контроллер сделан на PowerPC, о котором я кроме названия ничего не знаю, образ прошивки то ли заархивирован, то ли зашифрован… слишком много возни для старого сервера, давно запланированного к выводу из эксплуатации.

Tatikoma

02.06.2019 15:57У меня была аналогичная проблема с HP iLO. Решилось установкой старой Java в chroot, — немного удобнее, чем отдельный ноутбук.

alexyr

02.06.2019 10:10+1Стоит в начале статьи добавить ссылку на первую часть, для тех кто её пропустил… Не что-то суперкритичное, но так будет вежливо по отношению к читателям.

Saber-Toothed Автор

02.06.2019 10:44Сегодня во второй половине дня или вечером будет третья часть истории, уже не только с картинками но и со ссылками на мой Ютуб-канал где есть целый плейлист про этот «деревенский суперкомпьютер».

Кому хочется спойлеров — смотреть сюда: www.youtube.com/watch?v=Sl0CkpcR0qI&list=PL3zeXynsAkrnywl1nXQeHzKNdw09V4D7E

Кому хочется «полной научной фантастики» — сюда: www.youtube.com/watch?v=GDv7wRRAWXk&list=PL3zeXynsAkrnywl1nXQeHzKNdw09V4D7E&index=13

3aBulon

02.06.2019 11:15эээ, а райзеры которыми уже несколько лет майнеры балуются вам не подойдут? 200р пачка стоят, до питание отдельно, ничего не сгорит.

Saber-Toothed Автор

02.06.2019 13:03Райзеры работают по PCI-E 16x превращая ее в 1x. Загрузка-выгрузка всей памяти видеокарты что происходит регулярно при расчетах научных или глубинном обучении нейросети через него занимает до десятка секунд на карту с 5-6 гб памяти. Что приемлемо для майнингра где DAG-файл загружается пару раз в час максимум и неприемлемо для работы где обновление данных происходит десятки раз в секунду.

Chugumoto

03.06.2019 00:15есть х16-х16 шлейфовые с отдельным питанием, правда только +12В. +3.3В таки с материнки…

raamid

02.06.2019 11:18А как же вам удалось установить SSH без монитора, не поделитесь рецептом? А то гуглится только вариант настройки для Raspberry Pi.

Saber-Toothed Автор

02.06.2019 13:06+2Почему без монитора? Монитор был подключен к VGA платы, просто в BIOS видео было определено как onboard — встроенное, вместо add-in — внешнее. Установил Ubuntu Server. поднял SSH-клиент, настроил сеть и вошел уже по ней через SSH с рабочего ноутбука Dell.

После чего монитор-клавиатуру-мышку отключил подоткнув в роутер патчкорд на Delicated-NIC IPMI.

После чего уже совершенно спокойно накатил обновление системы через Shell, подключил репозитарий проприетарный Nvidia, установил дрова nvidia-418, потом накатил CUDA 10.1 + CUDA Toolkit. Дальше что ему надо будет накатывать уже друг-астроном, я ему сделал аккаунт в sudo.

Goodwinnew

02.06.2019 12:17Сделано интересно. Но есть более простой вариант для LGA 2011 — Huanan на X79. Там получаем установку того же серверного процессора 2011, ту же дешевую серверную память, и в большом плюсе = SATA3 и PCIe 3.0. Причем сами платы новые. Отпишитесь в комментах, кто реально делал систему на этих платах, плиз. Ваше мнение?

Saber-Toothed Автор

02.06.2019 13:16+2Во первых Хуананы — достаточно кривые и глючные платы. Ютуб полном «анус запеканус» купивших их. Во вторых они только на один Ксеон, а надо два. В третьих надо минимум два полноценных PCI-E 16x, а на Делловской плате их 3, пускай и оказалось что «с нюансами». В третьих Tesla K20 = PCI-E 16x 2.0. И это не считая того что Делловская плата в настройке биос позволяет выбрать генерацию PCI-E 1.0. 2.0 3.0 В четвертых я использую RAID 1 SSD, 5 HDD и NVE SSD — что и так дает мне практический максимальную реально достижимую скорость. Если мне совсем сильно надо будет SATA3 — я лучше внешний RAID-контроллер возьму чем Хуанан «инстинно китайского качества, не подделку какую-то».

Пока для меня по соотношению цена-качество лидируют старые серверные платы Dell. Если же я буду собирать не сервер а допустим РС — то конечно и плату буду использовать другую, но скорее всего не китайского бренда.

nidalee

02.06.2019 14:30Во вторых они только на один Ксеон

Нет, есть и на два (пример, хоть и не очень удачный, ибо 2 PCI-E), только другого производителя. А учитывая объемы головной боли с пропиетарными разъемами, стандартами и неудобным форм-фактором вашей платы, проще было купить 2 хуанана (1 в запас) и не знать проблем в стандартном корпусе ПК. Думаю, что цена вопрос осталась бы прежней.

Лично у меня односокетный хуанан прекрасно работает с начала года, так что с ними все не так плохо.

Впрочем, каждому свое.

firez

02.06.2019 16:25+2Купите б/у supermicro и будет Вам счастье. Всё отлично документировано, все разъёмы стандартные, полно вариантов под 2 и 4 сокета. Форм-фактор, правда, может быть EEATX, но в большой корпус встанет без проблем.

nidalee

02.06.2019 16:27-1Тоже вариант, но есть некоторые сомнения, что плата, которой столько лет, прослужит дольше новой китайской.

Saber-Toothed Автор

02.06.2019 21:54Старые серверные платы надежнее новых китайских Хуананов и прослужат дольше особенно если в нормально вентилируемом корпусе, а не в тесном железном ящике где +70С 24/7 несколько лет подряд.

vitalyvitaly

04.06.2019 01:36Есть еще вариант с сокетом 1356. Я видел подозрительно дешевые предложения таких серверных плат в Европе, что-то порядка 40 евро, как двухпроцессорные, так и с одним выпаянным процессором. Существует кажется и Хуанан 1356. Как оно вообще в эксплуатации?

firez

04.06.2019 10:48Покупал в Германии двухпроцессорный б/у сервер в сборе на этом сокете, обошёлся примерно в 150€. Всё работает отлично, но для меня главный минус — то, что поддержка 1356 закончилась на ESXi 6.5.

Chugumoto

03.06.2019 00:21Во вторых они только на один Ксеон, а надо два

не только на 1…

xeon-e5450.ru/socket-2011/motherboards/huananzhi-x79-ver-aa1

nidalee

02.06.2019 14:48+1Отвечу и вам: я делал систему с одним процессором и без видеокарты, под рендер на CPU.

Работает все без нареканий, только нет управления вентиляторами, кроме кулера процессора.

У кого-то не работает сон (что вообще ни разу не критично для машины, которая занимается рендером\вычислениями), у кого-то при установке частоты памяти выше 1600 отваливается одна плашка памяти (что тоже не критично, 1600 хватает с головой, учитывая четырехканал).

Ничего не греется и не отваливается.

Что касается SATA3, то она может быть и не нужна, хотя SSD RAID на SATA2 это, прямо скажем, странно. PCIe 3 этим картам, скорее всего, не нужен. (UP: там SAS, отбой тревоги, хотя NVME все же лучше).

Из плюсов остается только M.2 NVME, адекватный форм-фактор и совместимость со всеми БП и прочим железом «из магазина». Из минусов разве что китайское нестабильное качество, которое лично для меня отбивается ценой, ну и возможно нет китайских плат на 3 PCIe x16.

Chugumoto

03.06.2019 08:43если односокетных, то есть хуанан х79 делюкс гейминг

у него физических слота х16 3, правда что там у них по линиям — не подскажу

nidalee

03.06.2019 12:28Это да, но человек-то хочет двухсокетный.

Chugumoto

03.06.2019 15:22я тоже хочу :)

но пока денег нет… 2680в2 юзаю на ней. правда старенькой без м2 еще

а так думаю будет хорошая замена…

сейчас пишу с x7dal-e с парой е5440 и 24гб озу

еще недособрал на x8dal-i c парой х5660 и 48гб озу. не хочет бутиться со вторым процом :(

а вот АТХ-совместимые материнки под 2011-0 от супермикры что-то от 20к пока находятся только… хотя недавно видел примерно такого формфактора за 4к+самому доставлять… и с дисковой подсистемой там не так вкусно…

holomen

02.06.2019 14:09Хотел еще в первой части спросить… А почему не чтонить вроде такого — HP Dl380 G7 2 X HEX E5649@2.53Ghz 32Gb RAM Server 2 x 146GB SAS за пару сотен?

Saber-Toothed Автор

02.06.2019 15:12+1Так вышло, к тому-же Теслы не во всякий готовый сервер вставишь. И сборка по частям позволяет растянуть расходы как на компоненты так и на пересылку. Которая для целого сервера до меня просто конская.

Кроме того в вашем примере старые Ксеоны с малым числом ядер и малая поддерживаемая память, у меня в планах нарастить постепенно оперативку до 256 а то и 512 гб чтобы было меньше транзакций на диски при работе с большой нейронкой.

holomen

02.06.2019 15:56Которая для целого сервера до меня просто конская.

~двести долларов — это уже с пересылкой. По крайней мере мне показывает что сам лот 160 и пересыл 60.

Кроме того в вашем примере старые Ксеоны с малым числом ядер

6 ядер — мало?

и малая поддерживаемая память, у меня в планах нарастить постепенно оперативку до 256 а то и 512 гб

до 288ГБ на процессор, т.к. контроллер памяти в процессоре. Т.е. 512гиг памяти установить не вижу препятствий.

Во сколько вам обошлась эта плата с процессорами кулерами и памятью? Подозреваю что заметно больше $200.

Но конечно более новый процессор и пляски вокруг теслы — да, причины понятные.

Saber-Toothed Автор

02.06.2019 17:58Не может быть пересылка серверного ящика стоит 60 долларов! Это сынок фантастика!(с) Мне пересылка платы стоила около 70-ти.

Да, 6 ядер мало.

Документацию на тот сервер почитайте. Наверняка память там DDR2 потом что процессоры Х5ххх и наверняка на 771 сокете. И объем 64-128 гигов максимум.

Да, цена у меня вышла около штуки баксов на круг, но я не жалею. Производительное решение надежное + опыт, повысил свой скилл профессионально-дипломный.

holomen

02.06.2019 18:13-1Не может быть пересылка серверного ящика стоит 60 долларов! Это сынок фантастика!(с) Мне пересылка платы стоила около 70-ти.

ибей сам говорит что пересыл будет стоить 60:

Наверняка память там DDR2 потом что процессоры Х5ххх и наверняка на 771 сокете. И объем 64-128 гигов максимум.

Нет, 1366 сокет, ддр3-800/1066/1333, до 288гиг

Да, 6 ядер мало.

так 6 ядер на один процессор. А их два — итого 12. Или 24 маркетинговых.

А у вашего, как я подозреваю (т… к интел про 2604 не признается) 8? Итого 12vs16, но в пять раз дороже фактически…

А если это просто опечатка и процессор 2640, то по ядрам вообще один в один, но памяти макисмум больше может и поновее.

Зато в предложенном мной в нагрузку корпус, блок питания, винты, охлаждение,… Да что там говорить — просто готовый к включению.

Про сложности с теслой помню. Но мне по остальным параметрам интересно понять.

isden

02.06.2019 18:44-1> ибей сам говорит что пересыл будет стоить 60:

GBP же. В баксах 73 пишут. Ну и в РФ они не доставляют вообще, т.е. добавьте еще стоимость доставки из Украины.

Saber-Toothed Автор

02.06.2019 19:43Дьявол скрыт в деталях(с)

Золотой по доставке сервер получается, как я собственно и говорил.

Saber-Toothed Автор

02.06.2019 19:42+1У меня Е5-2650L — по 8 ядер + гипертрейдинг при 70 Вт на процессор и память ддр3 1866 которую эти процессоры поддерживают.

holomen

02.06.2019 21:25Но за килобакс. Или по 6 ядер (тоже с НТ, конечно), и память до 1333, но в пять раз дешевле ))

угу, раки — они везде — и большие и маленькие )))

Saber-Toothed Автор

02.06.2019 21:57Под килобакс с двумя Теслами, покупкой второй платы и кучей чего еще. Если ваш сервер который вы все показываете доводить до уровня моего + пересылка с Украины или еще откуда куда его доставят — будет дороже чем мой за килобакс. Если в ваш вообще Теслы можно установить.

Или вы спорите только чтобы поспорить?

Хотя на самом деле практика — критерий истины. Купите тот сервер, организуйте к себе доставку, поставьте равноценные процессоры пускай и под 1366, память, диски, потом пару Тесла К20Х — после чего напишите познавательную статьи и смету расходов озвучьте для почтенной публики.

Chugumoto

03.06.2019 00:38Не может быть пересылка серверного ящика стоит 60 долларов! Это сынок фантастика!(с) Мне пересылка платы стоила около 70-ти.

я в 2016 покупал думал что материнку x8dal-i, 2 куллера и портшилд с израиля на ебее за 150 + 14,82 USD доставка… а мне в итоге притаранили еще с корпусом и бп…

Saber-Toothed Автор

03.06.2019 00:44Значит вам повезло. Мне цены заряжали в десятки тысяч за доставку в Россию.

Chugumoto

03.06.2019 08:45тут немаловажную роль играет откуда заказывать. израиль то например ближе, чем штаты

ArkadyGamza

02.06.2019 17:26-2На хабре была тема где раздавали старое серверное железо бесплатно под благие цели.

A1exXx

03.06.2019 09:13можно вопрос чем обусловлен выбор платы? Насколько я в курсе предполагаются gpu расчёты. Т.Е. можно было заказать «майнинговую» плату. Кстати недавно брал себе «китайца» под lga2011(есть и двухсокетовые) m2 распаян, uefi есть, грузимся с ssd без костылей «из коробки»

Saber-Toothed Автор

03.06.2019 17:47Майнинговая плата не подходит, майнинг идет по pci-e 1x что для GPGPU совершенно неприемлемо, там надо честные 16х пусть и 2.0

alexbers

03.06.2019 10:23Решил я проблему в лоб — купил в DNS PCI-E to M.2 адаптер ASUS HYPER M.2 x 4 MINI и M.2 SSD Samsung 960 EVO 250 Gb реши что под swap надо выделить максимально скоростное устройство, раз система будет работать с высокой вычислительной нагрузкой, а памяти все равно заведомо меньше чем размер данных. Да и память на 256 гб дороже была чем этот SSD.

В этом месте, скорее всего, будет просадка по производительности т.к. скорость современных ssd на порядок меньше скорости памяти.

Плюс системы с таким большим swap-разделом может быть, разве что, если задача так написана, что считывает все 256гб из диска в память, а потом "скармливает" данные видеокарте по 10ГБ.

NickViz

03.06.2019 11:48пожалуйста, купите себе фотоаппарат. ну или более-менее свежий телефон. глаза вытекают такое смотреть.

Статья интересная, железяки прикольные — хочется под… т.е. рассмотреть, и тут…

Saber-Toothed Автор

03.06.2019 17:48Фото были сделаны больше года назад, с тех пор появился старый смартфон для съемки видео. Он и фото приличные делает.

Saber-Toothed Автор

Вот и вторая часть истории, как я и обещал.

Chugumoto

вопрос про 3 теслы. а можно поподробнее про ошибку?

как мне кажется там не в кол-ве линий дело, а в размере адресного пространства, отводимого материнкой для общения с пси-е устройствами… примерно такое можно видеть у ксеон фи. уж очень большой кусок им нужен и не все материнки могут его предоставить… а которые могут… там в биос настроечки покрутить надо…

www.pugetsystems.com/labs/hpc/Will-your-motherboard-work-with-Intel-Xeon-Phi-490 что-то вроде такого читал, когда к фи присматривался

Saber-Toothed Автор

В BIOS на эту тему никаких настроек к сожалению нет, а более-менее штатно к системе подключается только 2 GPGPU, а по документации и вовсе только один.