Доброго времени суток, товарищи Хабровчане.

Сегодня будет небольшая статья про установку «турбинных» карт NVIDIA GeForce GTX 1070 Founders Edition в бокс Nvidia Tesla S2050 Server позволяющий установить 4 GPU-карты и подключить их к серверу через интерфейсные карты Nvidia P797 HIC по шине PCI-E 16x 2.0 полной ширины. Бокс был предварительно доработан, чтобы мог работать не только с GPU-картами Nvidia Tesla M2050.

Обзор карт GTX 1070 Founders Edition тут.

Видео-обзор бокса Nvidia Tesla S2050 тут:

Второй обзор тут:

Немного истории — во времена GPU архитектуры Fermi и поколения видеокарт GTX 480-580 фирма Nvidia уже «давно и успешно» продвигала архитектуру GPU CUDA и связанное с ней программное обеспечение, а так-же специализированные «вычислительные» карты серии Tesla и профессиональные видеокарты Quadro, отличающиеся чипом GPU с большим числом ядер «двойной точности», прошивкой BIOS карты и наличием контроля ошибок памяти ЕСС.

Крупные клиенты «распробовали» преимущества даваемые этой архитектурой, но сами «чипы» уже были «малы». Специализированная карта для GPU вычислений Nvidia Tesla M2050 построенная на поколении архитектуры Fermi имела на борту 6 Gb памяти, но всего 448 CUDA-ядер, карта была близким родственником GTX 480. Потом были карты Tesla М2070, М2090 с 512 CUDA-ядер (родня GTX 580) и все теми-же 6 гигами оперативки, но сильно это на ситуацию не влияло. Ядер нужно было больше и за это клиенты были готовы платить.

Простой путь — увеличить количество карт в системе споткнулся о количество слотов PCI-E 16x, которое обычно не превышает 4-х в самых дорогих игровых PC и двухпроцессорных серверах. Кроме того сервера 1U и 2U высоты не позволяют устанавливать «видеокарты» нормальных размеров, но фирме Nvidia очень хотелось денег и ее инженеры проблему решили. Решений было два. Долгое — разработка новой архитектуры Kepler с большим числом ядер улучшенного дизайна.

Быстрым было создание внешнего «бокса» с коммутаторами PCI-E 16x и своими блоками питания для установки четырех GPU-карт и подключением их к системе через интерфейсные карты P797 HIC со специальными кабелями позволяющие на один слот PCI-E 16x 2.0 сервера подключать по 2 GPU-карты в боксе не урезая ширину шины. Так были созданы «волшебные коробки» Nvidia Tesla S2050 Server для подключения GPU-карт с пассивным охлаждением с TDP 225 Вт. Хотя строго говоря Nvidia Tesla S2050 это просто внешние боксы для видеокарт, по мотивам которых были сделаны боксы для GPU Dell C410x, а сами они были созданы на основе более ранних боксов Tesla S870 под более ранние GPU.

С боксами Nvidia Tesla S870 я не сталкивался, хотя те кто сталкивался писали что в нем нет контроля установленных GPU-карт. А вот в более поздний S2050 контроль карт был добавлен, чтобы пользователи не устанавливали «непредусмотренные фирмой карты». Встроенный микроконтроллер бокса опрашивает слоты PCI-E 16x 2.0 и если не обнаруживает ни одной карты Tesla M2050 — отключает фронтальные вентиляторы оставляя питание на электронике, что ведет к выходу из строя как карт так и греющихся как утюги PCI-E 16x коммутаторов, в прочем у этой проблемы есть простое решение.

Для того чтобы использовать в этом боксе любые другие GPU-карты с PCI-E 16x 2.0 или 3.0 карты работающие в боксе по PCI-E 16х 2.0, либо видеокарты необходимо выполнить две доработки бокса. Первая заключается в замыкании контактов кнопки контроля открытия крышки бокса, которая расположена на узкой объединительной плате посередине корпуса. Она нажимается пластиковым воздуховодом, который при подгонке под ваши карты будет смещен и питание бокса перестанет выключаться.

Вторая проблема — блокировка вентиляторов с «неродными» картами мной была решена перерезанием синего провода идущего в жгуте на объединительную плату вентиляторов передней панели. Синий провод управляет оборотами вентиляторов и после его перерезания контроллер не может их выключить, правда и обороты теперь не регулируются, но это не критично на мой взгляд.

Мной, для моих задач было куплено 2 бокса Tesla S2050 c кабелями и интерфейсными картами чтобы подключить к серверу ASUS RS720 8 GPU для работы с deep learning. Боксы предназначены для GPU с пассивными радиаторами продольной продувки, но ставшие сейчас доступным по цене Tesla K20M 5Gb и К20Х 6 Gb меня не удовлетворяют по объему памяти. Tesla K40 12 Gb — еще пока слишком дороги. Самым бюджетным вариантом оказались GTX 1070 8Gb которые сейчас начали достаточно массово скидывать майнеры.

По конструкции радитора охлаждения для бокса подходят только карты с продольной продувкой, проще говоря — варианты карт с центробежной турбиной. У карт в 1-2-3 вентиляторами ребра радиатора расположены поперек карты на тепловых трубках и в боксе они не будут работать как надо. А у турбинных карт ребра радиатора расположены вдоль, что и предопределило мой выбор в пользу GTX 1070 Founders Edition. Пару которых мне и подарил на день рождения мой хороший друг, по совместительству главный спонсор моих проектов Дмитрий из Химок.

Примерка карт к боксу, фоторепортаж со всеми нюансами.

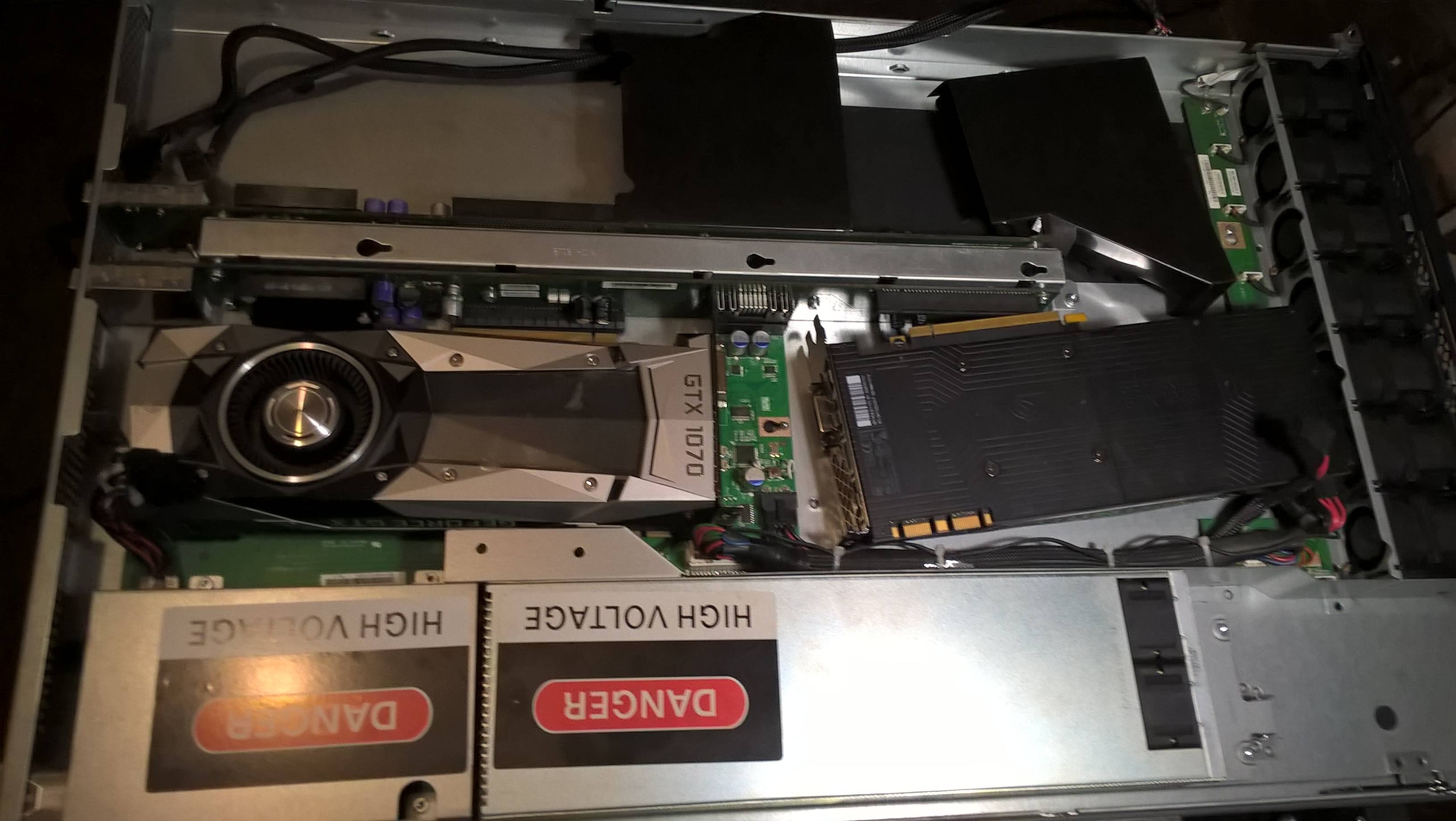

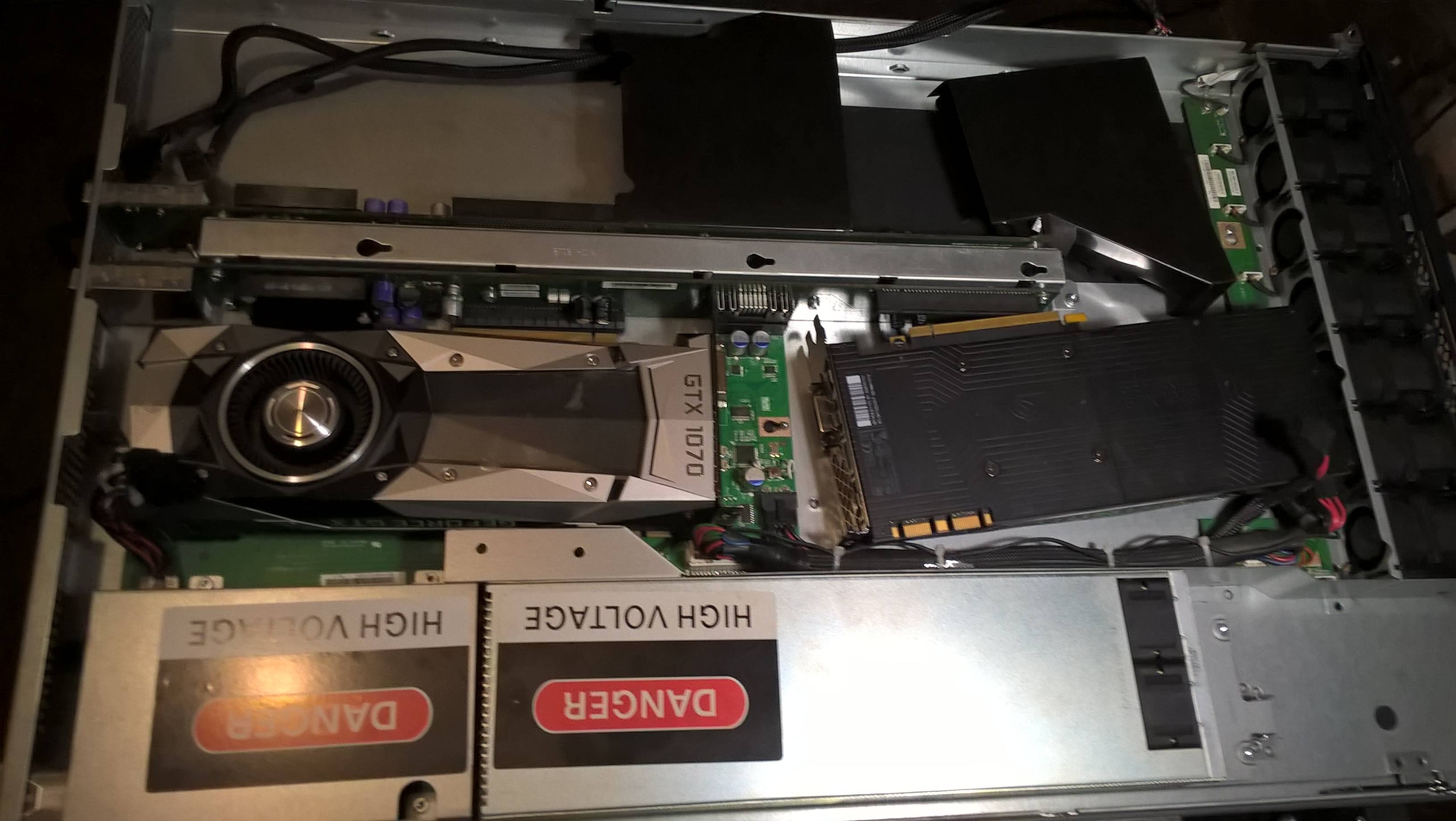

Примерка общего плана.

Открутил задние крепежные планки от карт, они мешались, теперь примеряю.

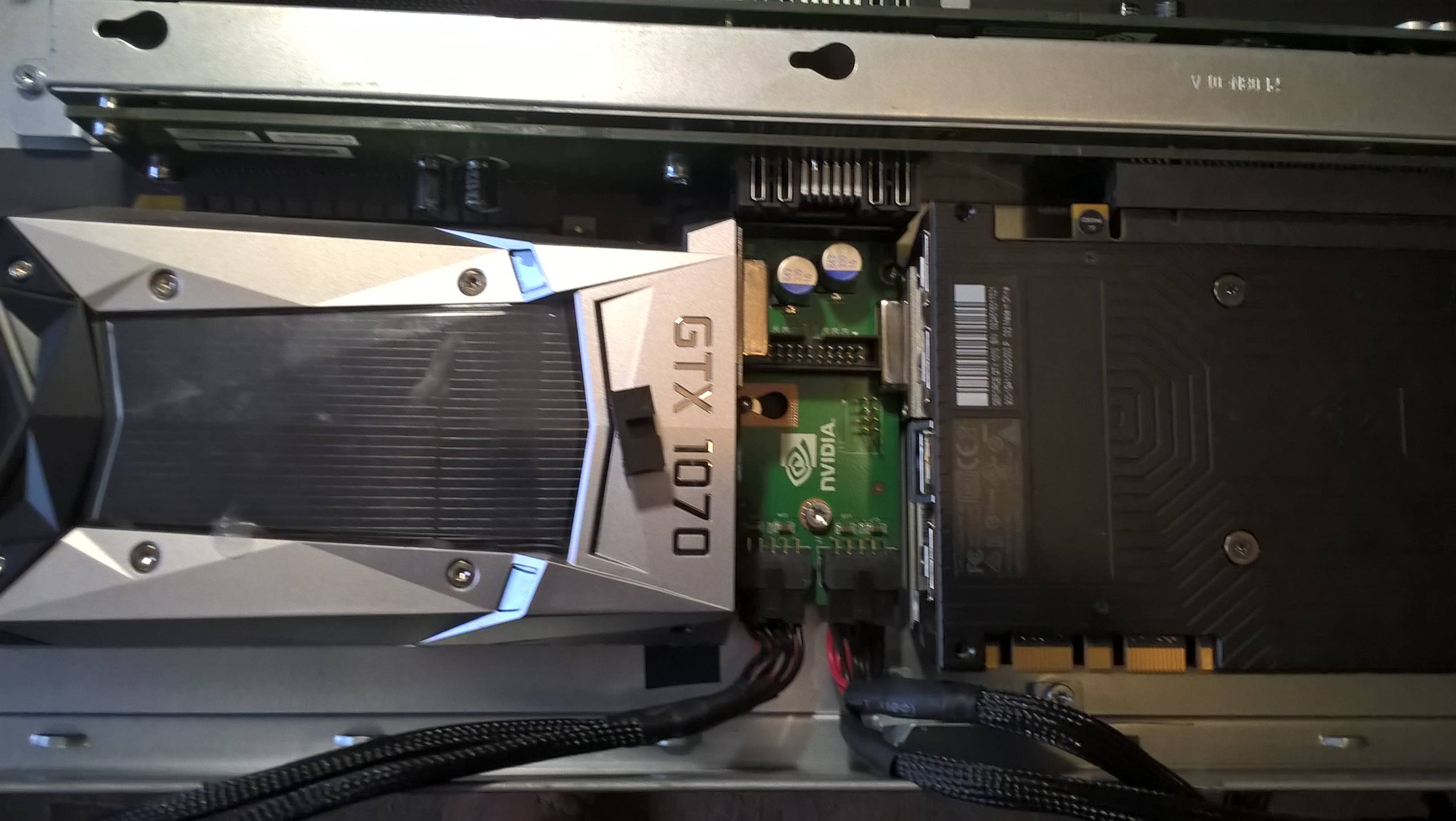

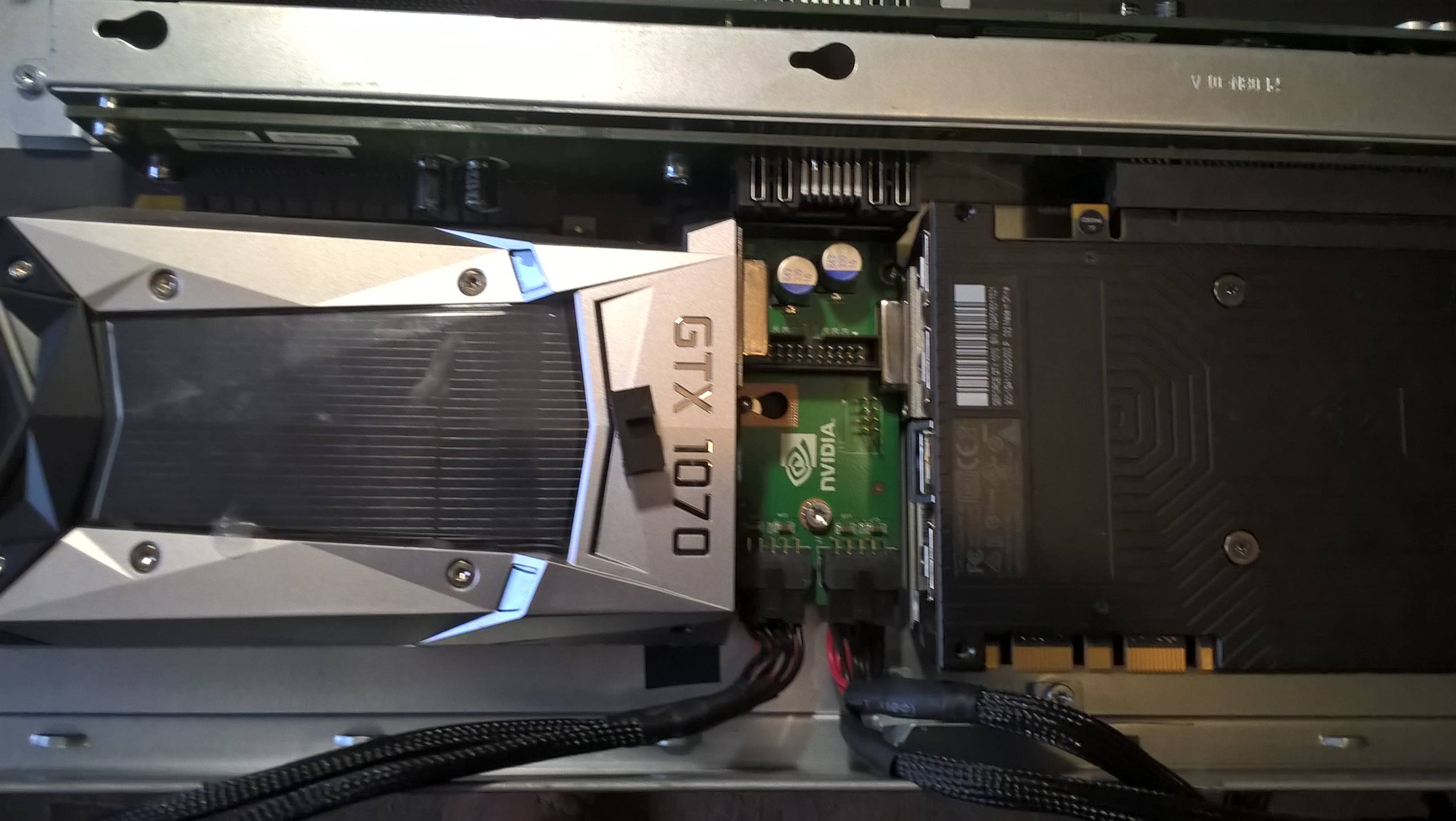

Разъемы местами упираются в объединительную плату. Надо подкладывать изоленту чтобы ничего не замыкало. Разъемы бы конечно вовсе лучше отпаять, но у меня нет паяльной станции и достаточно компетентного знакомого мастера тоже.

А здесь разъем видеокарты упирается в разъем на объединительной плате. Решил эту проблему осторожно сняв утконосами черный пластик со штырей разъема на плате бокса. Все равно мне в него нечего включать.

Кое-где придется подгибать корпуса разъемов вложив изоляцию внутрь чтобы не замкнуть выводы в разъеме.

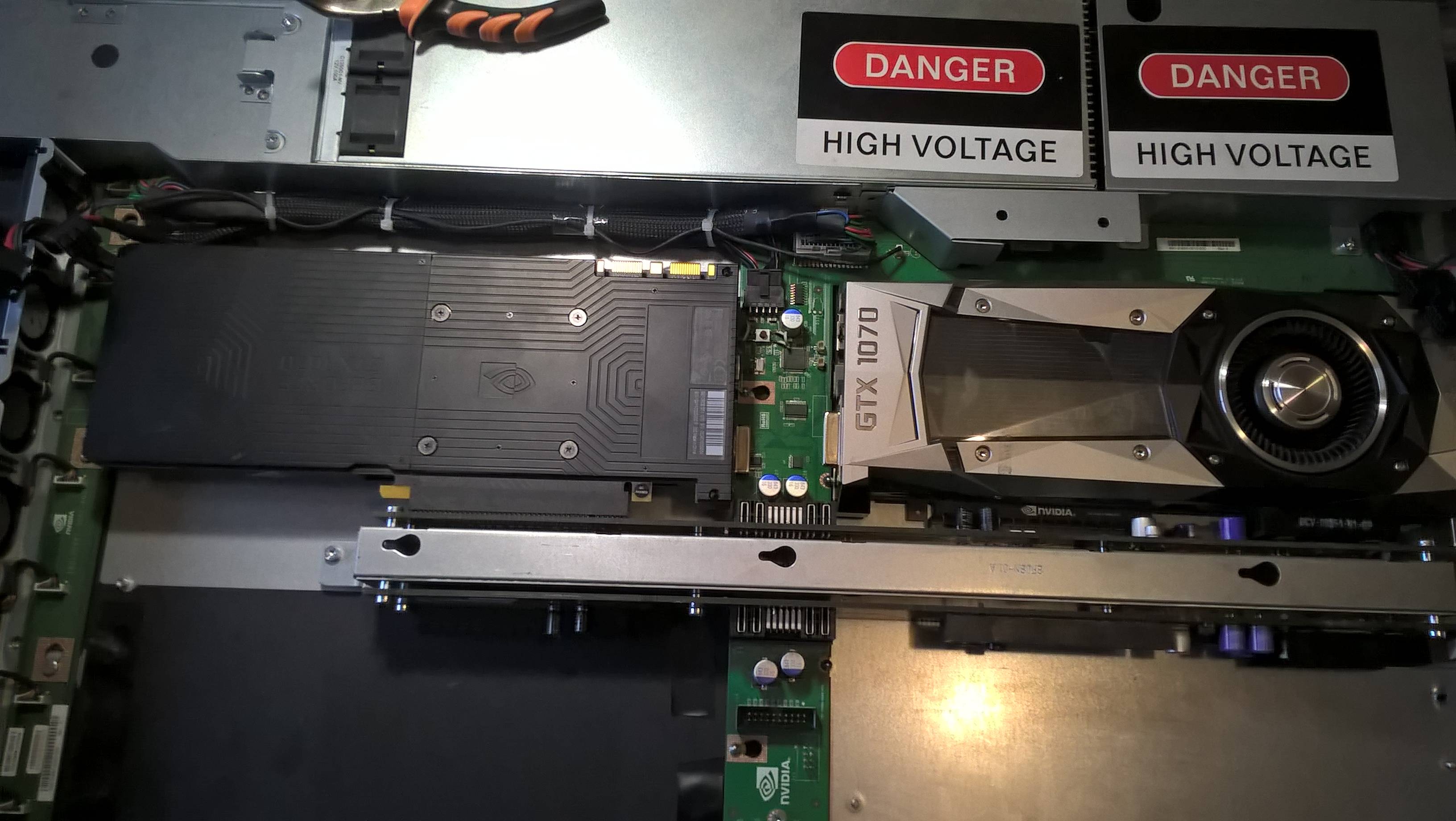

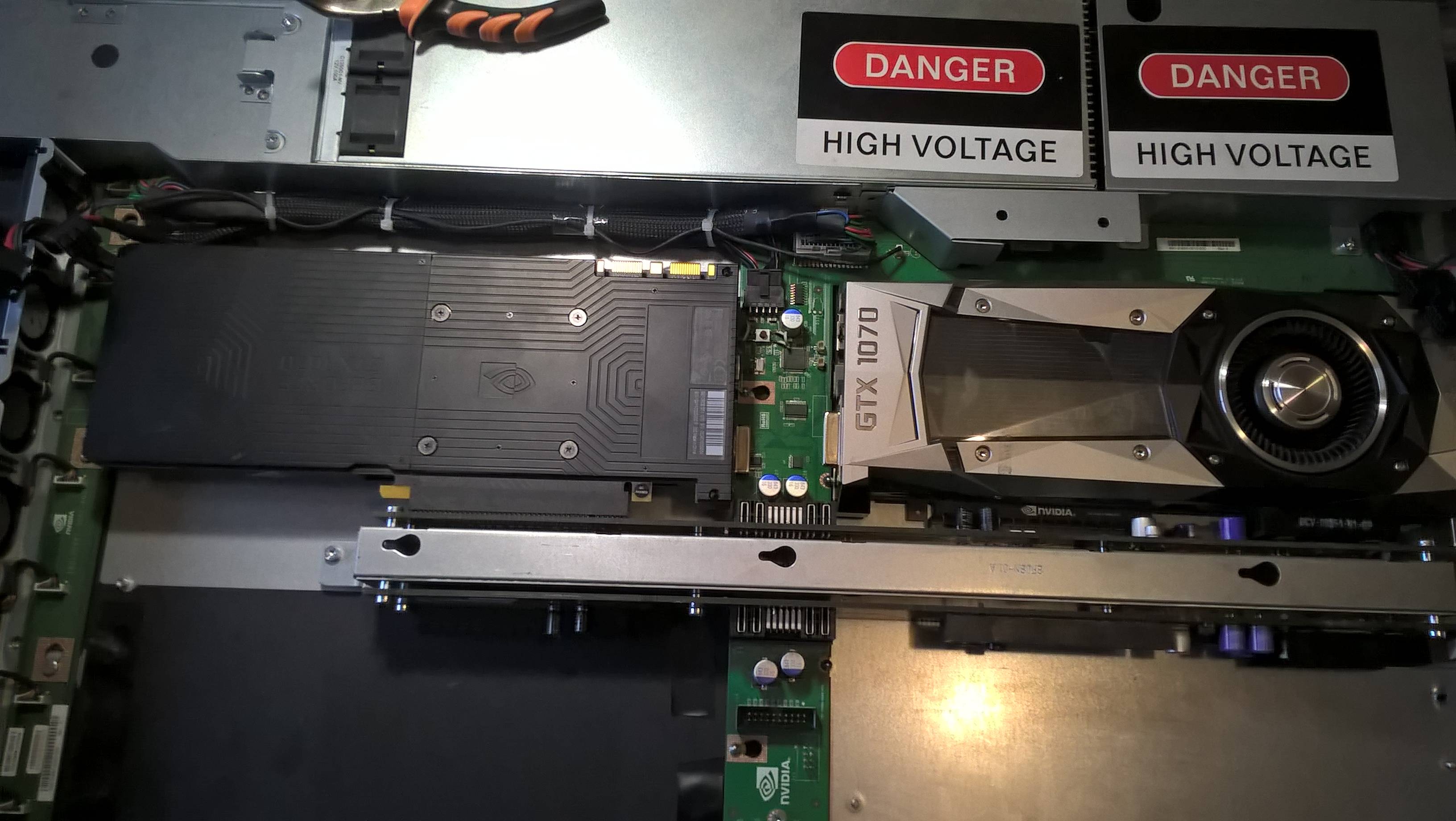

Продолжение примерки карт в боксу.

Та самая «кнопка с доработкой» чтобы подавалось питание на электронику даже с открытой крышкой или сместившимся воздуховодом.

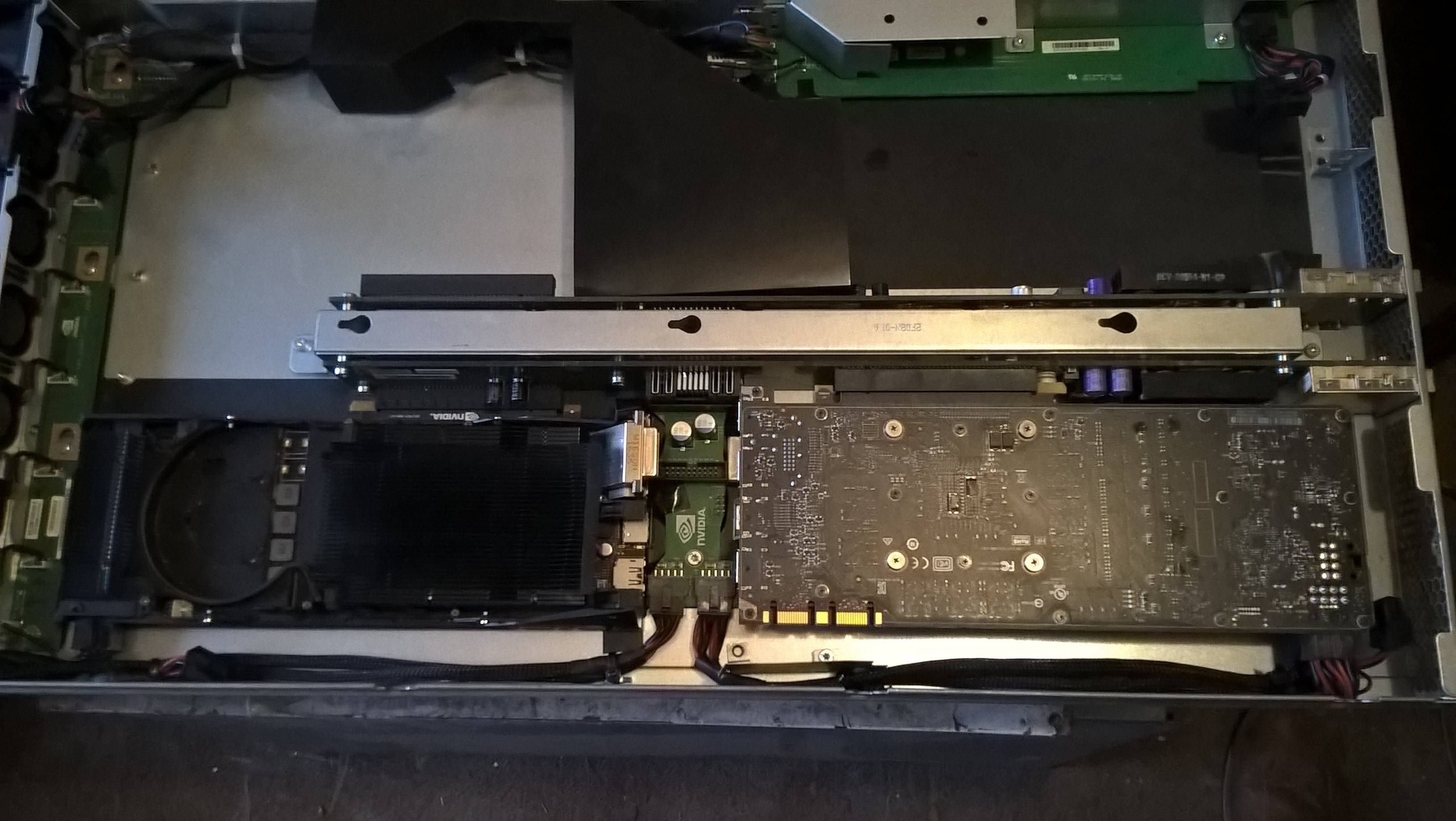

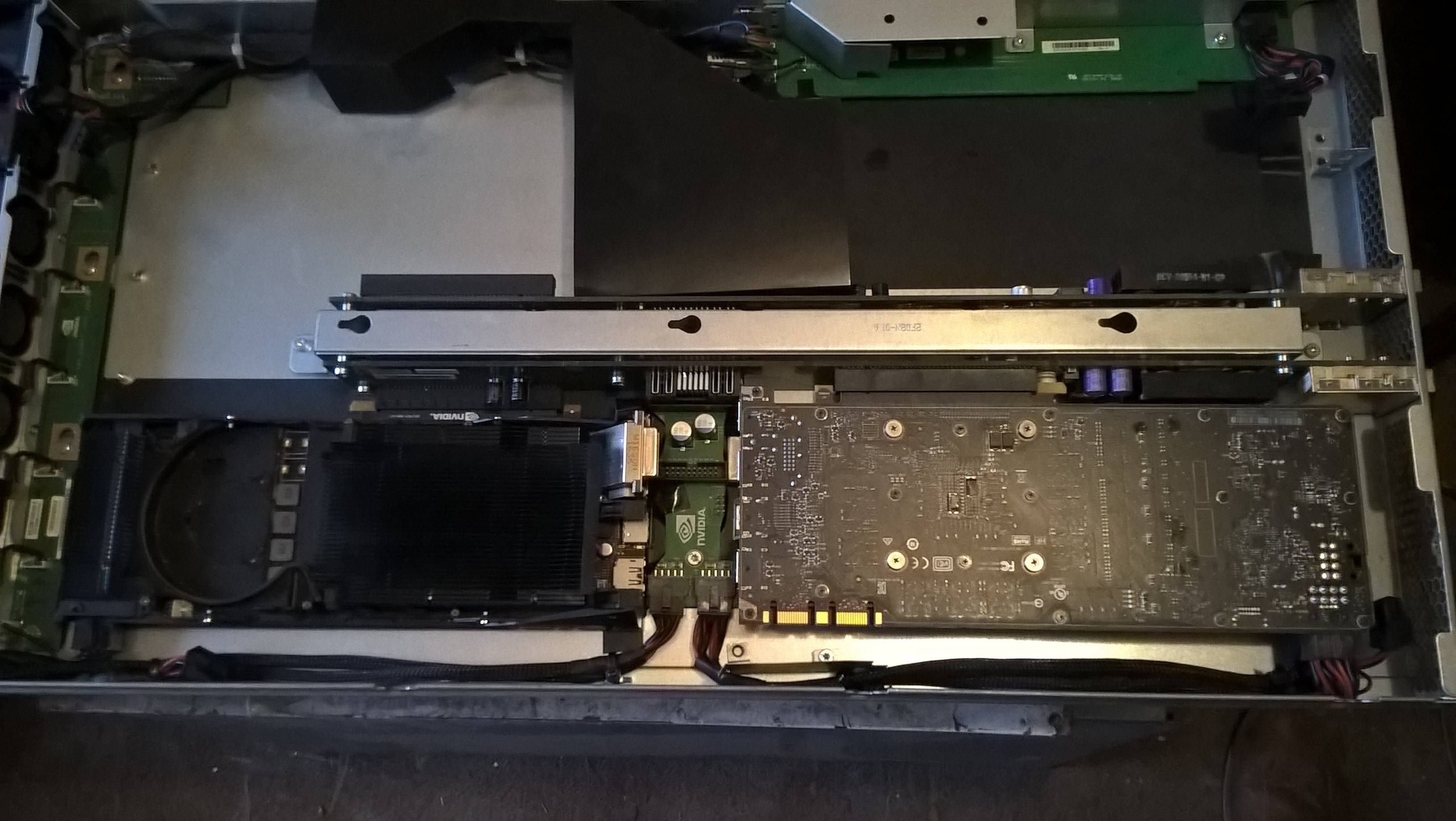

Кроме того пришлось доработать карты. Доработка карт сводится к удалению декоративных кожухов и самих турбин, которые мешают продувке радиаторов карт фронтальными кулерами бокса.

И вот таков получился результат. Позднее подключу бокс к серверу, накачу ОС и буду тестировать карты под нагрузкой смотря изменения температуры. Но ничего страшного не должно быть, бокс продувал карты М2050 с TDP 225 Вт, тогда как у GTX 1070 TDP 150 Вт, есть запас по охлаждению и питанию.

Сегодня будет небольшая статья про установку «турбинных» карт NVIDIA GeForce GTX 1070 Founders Edition в бокс Nvidia Tesla S2050 Server позволяющий установить 4 GPU-карты и подключить их к серверу через интерфейсные карты Nvidia P797 HIC по шине PCI-E 16x 2.0 полной ширины. Бокс был предварительно доработан, чтобы мог работать не только с GPU-картами Nvidia Tesla M2050.

Обзор карт GTX 1070 Founders Edition тут.

Видео-обзор бокса Nvidia Tesla S2050 тут:

Второй обзор тут:

Немного истории — во времена GPU архитектуры Fermi и поколения видеокарт GTX 480-580 фирма Nvidia уже «давно и успешно» продвигала архитектуру GPU CUDA и связанное с ней программное обеспечение, а так-же специализированные «вычислительные» карты серии Tesla и профессиональные видеокарты Quadro, отличающиеся чипом GPU с большим числом ядер «двойной точности», прошивкой BIOS карты и наличием контроля ошибок памяти ЕСС.

Крупные клиенты «распробовали» преимущества даваемые этой архитектурой, но сами «чипы» уже были «малы». Специализированная карта для GPU вычислений Nvidia Tesla M2050 построенная на поколении архитектуры Fermi имела на борту 6 Gb памяти, но всего 448 CUDA-ядер, карта была близким родственником GTX 480. Потом были карты Tesla М2070, М2090 с 512 CUDA-ядер (родня GTX 580) и все теми-же 6 гигами оперативки, но сильно это на ситуацию не влияло. Ядер нужно было больше и за это клиенты были готовы платить.

Простой путь — увеличить количество карт в системе споткнулся о количество слотов PCI-E 16x, которое обычно не превышает 4-х в самых дорогих игровых PC и двухпроцессорных серверах. Кроме того сервера 1U и 2U высоты не позволяют устанавливать «видеокарты» нормальных размеров, но фирме Nvidia очень хотелось денег и ее инженеры проблему решили. Решений было два. Долгое — разработка новой архитектуры Kepler с большим числом ядер улучшенного дизайна.

Быстрым было создание внешнего «бокса» с коммутаторами PCI-E 16x и своими блоками питания для установки четырех GPU-карт и подключением их к системе через интерфейсные карты P797 HIC со специальными кабелями позволяющие на один слот PCI-E 16x 2.0 сервера подключать по 2 GPU-карты в боксе не урезая ширину шины. Так были созданы «волшебные коробки» Nvidia Tesla S2050 Server для подключения GPU-карт с пассивным охлаждением с TDP 225 Вт. Хотя строго говоря Nvidia Tesla S2050 это просто внешние боксы для видеокарт, по мотивам которых были сделаны боксы для GPU Dell C410x, а сами они были созданы на основе более ранних боксов Tesla S870 под более ранние GPU.

С боксами Nvidia Tesla S870 я не сталкивался, хотя те кто сталкивался писали что в нем нет контроля установленных GPU-карт. А вот в более поздний S2050 контроль карт был добавлен, чтобы пользователи не устанавливали «непредусмотренные фирмой карты». Встроенный микроконтроллер бокса опрашивает слоты PCI-E 16x 2.0 и если не обнаруживает ни одной карты Tesla M2050 — отключает фронтальные вентиляторы оставляя питание на электронике, что ведет к выходу из строя как карт так и греющихся как утюги PCI-E 16x коммутаторов, в прочем у этой проблемы есть простое решение.

Для того чтобы использовать в этом боксе любые другие GPU-карты с PCI-E 16x 2.0 или 3.0 карты работающие в боксе по PCI-E 16х 2.0, либо видеокарты необходимо выполнить две доработки бокса. Первая заключается в замыкании контактов кнопки контроля открытия крышки бокса, которая расположена на узкой объединительной плате посередине корпуса. Она нажимается пластиковым воздуховодом, который при подгонке под ваши карты будет смещен и питание бокса перестанет выключаться.

Вторая проблема — блокировка вентиляторов с «неродными» картами мной была решена перерезанием синего провода идущего в жгуте на объединительную плату вентиляторов передней панели. Синий провод управляет оборотами вентиляторов и после его перерезания контроллер не может их выключить, правда и обороты теперь не регулируются, но это не критично на мой взгляд.

Мной, для моих задач было куплено 2 бокса Tesla S2050 c кабелями и интерфейсными картами чтобы подключить к серверу ASUS RS720 8 GPU для работы с deep learning. Боксы предназначены для GPU с пассивными радиаторами продольной продувки, но ставшие сейчас доступным по цене Tesla K20M 5Gb и К20Х 6 Gb меня не удовлетворяют по объему памяти. Tesla K40 12 Gb — еще пока слишком дороги. Самым бюджетным вариантом оказались GTX 1070 8Gb которые сейчас начали достаточно массово скидывать майнеры.

По конструкции радитора охлаждения для бокса подходят только карты с продольной продувкой, проще говоря — варианты карт с центробежной турбиной. У карт в 1-2-3 вентиляторами ребра радиатора расположены поперек карты на тепловых трубках и в боксе они не будут работать как надо. А у турбинных карт ребра радиатора расположены вдоль, что и предопределило мой выбор в пользу GTX 1070 Founders Edition. Пару которых мне и подарил на день рождения мой хороший друг, по совместительству главный спонсор моих проектов Дмитрий из Химок.

Примерка карт к боксу, фоторепортаж со всеми нюансами.

Примерка общего плана.

Открутил задние крепежные планки от карт, они мешались, теперь примеряю.

Разъемы местами упираются в объединительную плату. Надо подкладывать изоленту чтобы ничего не замыкало. Разъемы бы конечно вовсе лучше отпаять, но у меня нет паяльной станции и достаточно компетентного знакомого мастера тоже.

А здесь разъем видеокарты упирается в разъем на объединительной плате. Решил эту проблему осторожно сняв утконосами черный пластик со штырей разъема на плате бокса. Все равно мне в него нечего включать.

Кое-где придется подгибать корпуса разъемов вложив изоляцию внутрь чтобы не замкнуть выводы в разъеме.

Продолжение примерки карт в боксу.

Та самая «кнопка с доработкой» чтобы подавалось питание на электронику даже с открытой крышкой или сместившимся воздуховодом.

Кроме того пришлось доработать карты. Доработка карт сводится к удалению декоративных кожухов и самих турбин, которые мешают продувке радиаторов карт фронтальными кулерами бокса.

И вот таков получился результат. Позднее подключу бокс к серверу, накачу ОС и буду тестировать карты под нагрузкой смотря изменения температуры. Но ничего страшного не должно быть, бокс продувал карты М2050 с TDP 225 Вт, тогда как у GTX 1070 TDP 150 Вт, есть запас по охлаждению и питанию.

Комментарии (6)

Saber-Toothed Автор

13.11.2019 21:17Я не зарывался так глубоко в историю GPU, потыкал GTX 580 с его 512-ю ядрами, потом перепрыгнул на GTX 780/780Ti Tesla K20M/K20X. Для меня GPU + CUDA начались с Кеплера.

PainAssembly

13.11.2019 22:19CUDA началась с GTX 8000 Series, 10-11 лет назад.

Ну, не стоит путать Fermi и Kepler, разница огромная.

x67

13.11.2019 23:00А в чем она состоит? И почему это так важно для конечного потребителя?

Denai

14.11.2019 01:55GeForce 400 — Fermi

GeForce 600 — Kepler

https://en.wikipedia.org/wiki/Fermi_(microarchitecture)

https://en.wikipedia.org/wiki/Kepler_(microarchitecture)#Features

Разница для вас зависит от того чем пользуетесь)

PainAssembly

Если я не ошибаюсь, то серии NVIDIA GeForce GTX 400 и 500 основаны на 40нм кристаллах с архитектурой NVIDIA Fermi. Kepler пришёл с дебютом 600ой серии, кристалл был уже 28нм, а ядер CUDA там было аж втрое больше чем у предшественника(512 CUDA ядер на кристалле GF100 в составе GTX 580 против 1536 CUDA ядер на кристалле GK104 в составе GTX 680). Причём хочу сказать что GF100 являлся самым крупным и высокопроизводительным в семействе Fermi, а GK104 был средним кристаллом в семействе Kepler, так что GTX 680 на самом деле не является прямым последователем GTX 580.