Рынок облачного гейминга в России развивается ударными темпами. Здесь у нас и Loudplay, и MY.GAMES Cloud (ех. Playkey), GFN.ru. Мобильные операторы связи тоже находят свою выгоду и заключают партнерские соглашения с перечисленными сервисами, запуская собственные проекты. Так поступила «Вымпелком», запустив Beeline Gaming, а вслед за ней — МТС, Мегафон и Tele2. Особых проблем запуск таких сервисов не доставляет — ведь они реализованы на основе платформ партнеров, которые давно отлажены и работают как нужно.

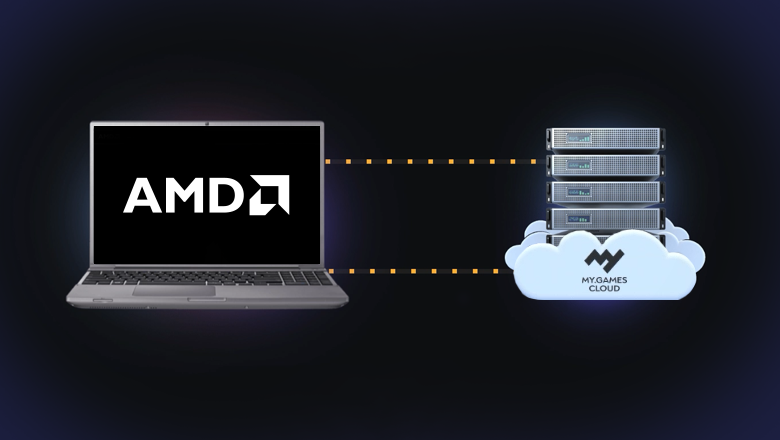

Год назад мы в Playkey стали частью MY.GAMES, вложив технологию своего облачного сервиса в основу MY.GAMES Cloud. Все это время сервис находится в состоянии soft launch. А недавно объявили о своем партнерстве с AMD, в рамках которого адаптировали протокол передачи видеопотока сервиса и будем тестировать видеокарты AMD Radeon™ RX 6700 XT на своих серверах. В чем профит этого партнерства для конечного пользователя, почему мы остановились именно на AMD, а не NVIDIA с их мощной трассировкой лучей, а также о том, насколько эта технология критична для игр, запускаемых через стриминговые сервисы, разбираемся в статье.

Что такое Radeon RX 6700 XT: характеристики и бенчмарки

Radeon RX 6700 XT — наиболее бюджетное решение новой 6000-й линейки видеокарт AMD, рассчитанное на комфортную игру в разрешении 1440p в случае растеризации и Full HD с трассировкой лучей. Строится видеокарта на базе 7-нм архитектуры RDNA 2 и обладает всеми характерными для нее преимуществами в виде аппаратной трассировки лучей и прочих функций API DirectX 12 Ultimate, нового кэша Infinity Cache, AMD FidelityFX, улучшенного доступа к видеопамяти Smart Access Memory, 12 ГБ памяти в противовес максимальным 10 ГБ у NVIDIA и многого другого.

По данным AMD, в играх без рейтрейсинга Radeon RX 6700 XT обгоняет GeForce RTX 3060 Ti и где-то RTX 3070. Впрочем, в зависимости от поддержки AMD или NVIDIA разработчиков конкретных игр, соотношение сил здесь может быть несколько различным. Тем не менее, результаты тестов подтверждают, что для комфортной игры в 2.5К Radeon RX 6700 XT вполне подходит.

Что же касается игры через облако, благодаря индивидуальной настройке энкодера под оборудование игрока и комплексу механизмов для борьбы с потерями данных, таких как помехоустойчивое кодирование, пользователь практически защищен от потери пакетов, а вместе с ними от лагов, фризов и «мыльной» картинки. А значит, внешний вид игры на локальном ПК и в облаке практически идентичен. Посудите сами: здесь игра в DOOM при максимальных настройках и качественном устойчивом интернет-соединении происходит на Core i3, 4 GB RAM, MSI GeForce GTX 750:

Смотреть видео

Что подразумевается под «качественным соединением»? Скажем, на нашем сервисе MY.GAMES Cloud рекомендованы следующие параметры скорости:

10 Мбит/сек для запуска игр в 30 FPS, HD (1280х720);

15 Мбит/сек — 30 FPS, Full HD (1920х1080);

20 Мбит/сек — 60 FPS, Full HD (1920х1080);

25 Мбит/сек — 120 FPS, Full HD (1920x1080).

Логично возникает вопрос: главный тренд передовых AAA-проектов — трассировка лучей, о которой все так много говорят, — как она будет ощущаться при игре в облаке в Full HD?

Ответить на него чуть сложнее, потому как у GPU NVIDIA под эту задачу выделены отдельные ядра для real-time вычислений, а технология DLSS только снижает нагрузку от трассировки. Но так ли это существенно на заре 2022 года, когда игр с рейтрейсингом вышло еще не так много, и насколько реально в принципе получить full path-tracing в 4K и 60 FPS даже на локальном ПК — в этом мы разберемся далее.

Трассировка лучей в современных играх — must-have для геймеров?

Вообще говоря, трассировка лучей — явление далеко не новое и само по себе не требующее специализированного оборудования. Но с появлением серии RTX видеокарт от NVIDIA в 2018 году появилась ее аппаратная поддержка, которая дала мощный буст дальнейшему развитию технологии.

Впервые этот алгоритм был описан Артуром Аппелем из IBM в 1968 году. И уже начиная с 1970-ых годов благодаря CG-специалистам из Lucasfilm, CalTech и других компаний трассировка лучей стала стандартом в индустрии кино и компьютерной графики для создания реалистичного освещения в изображениях. Однако до 2018 года почти вся трассировка лучей выполнялась оффлайн — и даже сегодня CGI в кино требует обширных специализированных серверных ферм на CPU. При этом рендериться один такой кадр может минутами, часами и даже днями, если речь идет о какой-то исключительной детализации. Такой роскоши у видеоигр, требующих частого обновления кадра здесь и сейчас, просто нет.

GPU, напротив, могут работать намного быстрее благодаря большему числу вычислительных ядер для более быстрого выполнения сложных задач.

Традиционно они использовали — и используют до сих пор в подавляющем числе случаев — другую технику для отображения трехмерных объектов на двумерном экране посредством представления объектов в виде треугольников — растеризацию. Пусть результаты ее вычислений и их визуализации дают не такую впечатляющую картину, как трассировка лучей, но зато происходит она в разы быстрее.

Первая программная трассировка лучей — вышедшая в 2009 году NVIDIA OptiX — была реализована как раз-таки с ускорением на GPU. В течение следующего десятилетия OptiX демонстрировала неуклонный рост скорости, обеспечиваемый сменой поколений графических процессоров NVIDIA.

Программную трассировку лучей с ускорением на GPU поддержала и Microsoft, в начале 2018 года представив DXR, который обеспечивает полную поддержку программного обеспечения NVIDIA RTX для трассировки лучей через Microsoft DXR API. Одновременно с ними на помощь в задачах рейтрейсинга пришли специальные тензорные ядра RT, позволившие NVIDIA повысить скорость обработки алгоритмов трассировки в 6 раз в случае RTX 2080 про сравнению с предыдущей GTX 1080 Ti. Затем ту же практику переняла и AMD, начав самостоятельную работу над этой технологией.

Наибольшим откровением трассировка лучей стала, пожалуй, с ее релизом в Minecraft и Quake II, где на фоне довольно примитивной графики улучшенная технология освещения возводит общую картинку на совсем другой уровень. Смотрите:

Смотреть видео

Что же касается более современных тайтлов с фотореалистичной графикой, ответ на вопрос необходимости трассировки лучей является уже не столь однозначным.

Возьмем, к примеру, Shadow of the Tomb Raider. Конечно, с трассировкой лучей тени становятся более естественными. Но если сравнить картинку с включенной трассировкой и ее отсутствием, разница не кажется столь существенной. При этом сравним падение FPS с включенной трассировкой лучей и без нее: 100 до 60 (либо 120 до 70) — почти в два раза:

Смотреть видео

То же самое в плане детализации можно увидеть на скриншотах со сравнением трассировки лучей в трех режимах и при отключенной совсем. Найдите 10 отличий:

Другой пример — Metro Exodus. Здесь первый скриншот выполнен с включенной трассировкой лучей, второй — снят без нее:

И она же в динамике:

Смотреть видео

Напоследок, DOOM Eternal. И снова разница между режимами с включенной и выключенной трассировкой лучей если и видна, то далеко не в каждом кадре:

Смотреть видео

Разница в качестве графики, конечно, есть, однако реализм картинки не сильно страдает от отсутствия трассировки лучей — особенно в динамике, когда игрок больше сосредоточен на геймплее, нежели рассматривании деталей освещения. А учитывая, какой процент от производительности и значений FPS эта технология отъедает даже на самых топовых видеокартах, актуальность ее включения каждый решает сам для себя.

Здесь стоит оговориться: когда мы говорим о трассировке лучей в современных киноблокбастерах, речь идет о так называемой технологии full path tracing — полной трассировки пути. На самом деле в рейтрейсинге есть множество других методов:

Тени с трассировкой лучей (именно так она реализована в Shadow of the Tomb Raider);

Глобальное освещение с помощью трассировки лучей (как в Metro Exodus);

Отражения с помощью трассировки лучей (например, в Wolfenstein Youngblood).

Святой Грааль трассировки лучей — полная трассировка пути, включает все эти методы. Однако стоит помнить, что чем сложнее метод, тем больше затраты на производительность. Даже в случае Minecraft и Quake II с их довольно примитивной графикой. Взглянем, к примеру, на это видео:

Смотреть видео

Падение FPS более чем в 3 раза до значения 35-40 кадров в секунду — сами понимаете. В таком случае ни о каком 4K лучше не вспоминать вовсе.

Конечно, вместо частоты кадров можно пожертвовать разрешением, и это отчасти решит проблему, но детализация от этого тоже пострадает — отчего, опять-таки, возникает вопрос, а стоит ли оно того, если разницы вы все равно не увидите, если не играть в 4K. Для которого еще необходимо иметь подходящий дорогостоящий монитор.

При всем при этом стоит еще помнить, что игр, которые поддерживают технологию трассировки лучей, на данный момент вышло всего несколько десятков: вероятно, будущее действительно за этой технологией, но пока совсем немногие разработчики еще приспособились к ее внедрению, а из геймеров далеко не все могут себе позволить видеокарты ценой $1000+, это будущее еще явно не настало.

Но неужели все действительно так плохо в программным рейтрейсингом?

Хотя тензорные ядра дают хороший буст ускорению трассировки лучей на топовых видеокартах, развитие софтового рейтрейсинга на этом не остановилось. Так, в 2019 году на конференции GDC Crytek представила демо Neo Noir, показывающее возможности версии движка CryEngine 5.7, позволяющей теперь производить расчет отражений через трассировку лучей. Вот оно:

Смотреть видео

Да, программная трассировка лучей использует отражения с более низким разрешением, меньше типов поверхностей поверхностей количество полигонов упомянутых отражений, однако все еще выглядит впечатляюще.

Со слов Crytek, реализация Neon Noir не зависит от аппаратного обеспечения и «будет работать на большинстве современных графических процессоров AMD и NVIDIA, тогда как другие методы трассировки лучей обычно привязаны к решениям на GPU с выделенными ядрами RT». Для программного обеспечения он использует DirectX 11 в качестве API, поэтому теоретически любая современная карта с его поддержкой может использовать Neo Noir.

Посмотрите, как справляется с трассировкой лучей Neon Noir предшественница RX 6700 XT, RX 5700:

Смотреть видео

Впоследствии Crytek представила бенчмарк Neon Noir. Приведем результаты тестов ресурса WCCFTech на видеокартах предыдущих поколений — ведь если Neon Noir позиционируется как технология, которая отлично справляется с рейтрейсингом даже на старых видеокартах без RT-ядер, интересно посмотреть на бенчмарки именно для них:

Как видно, в разрешении Full HD при максимальных настройках качества графики с задачей справляются действительно все протестированные видеокарты, если принимать за стандарт значение выше 30 FPS. Что же касается 1440p, ситуация ожидаемо хуже, однако по той же планке в 30 FPS проходит даже самая слабая из видеокарт.

Все это к тому, что в теории вам наверняка будет достаточно и софтового рейтрейсинга для зрелищной игры — не обязательно для этого заводить новейшие карты RX и RTX: Neon Noir является действительно хорошей альтернативой аппаратного рейтрейсинга, доступной для более старых и бюджетных моделей видеокарт. И это отличный задел на будущее для новых игровых проектов, как сделать трассировку лучей более доступной для игроков с самым разным железом.

Подводя итоги

Итак, мы рассмотрели множество различных реализаций трассировки лучей на обширном пуле карт обоих конкурирующих производителей — AMD и NVIDIA — и даже затронули вопросы программного рейтрейсинга. И можно прийти к выводу, что в большинстве случаев нет существенной разницы, играешь ли ты на RX 6700 XT, RTX 3070 или даже RTX 2080, если речь идет о клауд-гейминге.

Поэтому RX 6700 XT — оптимальное решение для игр в 1440p в разрезе клауд-гейминга, которое в рамках нашего партнерского соглашения с AMD поможет снизить косты на содержание оборудования. Как следствие, сервис станет доступнее для конечного пользователя: увеличится количества серверов, а вместе с ним — географический охват.

Комментарии (41)

gxcreator

06.12.2021 12:39+3Зашел почитать про сравнение NVENC и амудечного аналога - про PSNR, латенси кодеков и так далее, а получил рерайт статьи про RTX.

MYGAMES Автор

06.12.2021 12:50+3Раз есть такой запрос, рассмотрим эту тему в будущих статьях, спасибо за наводку!

rrrrex

06.12.2021 23:31А что с виртуализацией, получится пробросить одну карту на несколько машин? Quadro так могут.

lykovaleksey

07.12.2021 12:16Да, мы так и делаем, это технологи vGPU, но только не используем именно Quadro. Ещё важный нюанс, что при пробросе видеокарты на несколько машин, мы делим мощности видеокарты на соответствующее число, и тут стоит вопрос, нужна ли такая мощность для игр. Ведь важна не только видеопамять, которую уже научились добавлять в больших размерах, но и производительность чипа, чтобы игры в половине ресурсов работали хорошо. По нашим исследованием, половина карты уже не подходит для топовых игр, а вот для средних вполне себе.

ObitoUchiha1985

08.12.2021 13:31Хотите верьте, хотите нет, по моим тестам кодер в AMD - дно, по сравнению с Nvidia, по крайней мере во всём, что до rx 6000, по сравнению с rtx 2000. А HEVC (h265) у АМД вообще мёртвый, он у них даёт качество хуже чем AVC (h264), тогда как hevc Nvidia даёт лучше качество чем их же avc и он на уровне avc закодированного кодером х264. RX 6000 я не тестировал, но сомневаюсь, что там они внезапно сделали кодер лучше чем у Nvidia. Nvidia постепенно улучшала свой кодер начиная с gtx 600 и только в rtx 3000 они оставили такой же кодер, как в rtx 2000.

gxcreator

08.12.2021 14:15Да, я охотно верю, часто натыкался на сырой AMF и посредственное качество кодировния в контесте стриминга VR и домашних медиасерверов. Потому и удивился, что это не осветили в статье.

ObitoUchiha1985

08.12.2021 14:24Мне тоже не понятно почему в статье про это ни слова, тогда как именно от этого зависит итоговое качество картинки. Плюс кодера/декодера АМД в том, что он потребляет в разы меньше чем у Nvidia, он так сказать более аппаратный, тогда как у Nvidia используются cuda ядра, а не только аппаратный блок.

Так же, разница качества между АМД и Nvidia, может быть минимальная, за счёт оптимизаций кодера под низкую задержку, тогда как я тестировал наоборот с максимально возможным качеством, что даст задержку кодирования минимум 70мс, а по факту скорее всего в разы больше, что не подходит для таких сервисов.

picul

06.12.2021 12:45+11TLDR: сделали на AMD, потому что договорились с AMD. Договорились бы с NVidia - сделали бы на NVidia.

lykovaleksey

06.12.2021 13:30С Nvidia уже давно и плодотворно сотрудничаем, сейчас сервера почти на Nvidia, мы лишь расширяем технологические возможности сервиса.

emashev

06.12.2021 13:15+1Ну, не знаю. На мой субъективный взгляд Metro Exodus Enhanced Edition выглядит заметно лучше, чем стандартная версия.

Hait

06.12.2021 13:17А почему лучи в метро просто сравниваются, а не с enchanced edition? Там выглядит всё намного лучше, да ещё и производительность выше.

"а технология DLSS только снижает нагрузку от трассировки" это же неправда. Можно сравнить производительность в играх с DLSS и без. Даже без лучей процентов 10 даст на качестве.

MYGAMES Автор

06.12.2021 14:43А почему лучи в метро просто сравниваются, а не с enchanced edition? Там выглядит всё намного лучше, да ещё и производительность выше.

Да, вы правы, студия действительно проделала монументальную работу по улучшению трассировки лучейМожно посмотреть здесь, например<iframe width="560" height="315" src="https://www.youtube.com/embed/YA0jhM-l7uo" title="YouTube video player" frameborder="0" allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture" allowfullscreen></iframe> «а технология DLSS только снижает нагрузку от трассировки» это же неправда. Можно сравнить производительность в играх с DLSS и без. Даже без лучей процентов 10 даст на качестве.

Тезис был скорее о том, что благодаря DLSS повышается производительность трассировки, но да, вы правы, что действительно — не только ее.

V1ck

06.12.2021 14:05+2Как человек, который использует на Nvidia Now уже более 3х лет скажу, что основа любого облачного сервиса это впервую очередь то, как он кодирует изображение и справляется с нестабильностью соеденения. часто, картинка может "развалится" и на 30 Мбит/сек в такую "труху" что смотреть нереально. РТХ и прочие радости действительно вторичны. Особенно для человека у которого облако единственная точка входа в ПК гейминг в целом. Ему нужна комфортная игра в первую очередь.

За собой заметил, что поначалу использования сервиса лез выкручивать все ползунки на максимум, но потом стало как-то всёравно. Ибо у тебя вечер и есть полтора часа до сна а AC Vallhala большая и себя не пройдёт сама.

Так что, если карточки АМД помогут лучше и качественней транслировать картинку в экран конечного потребителя это будет "пушка". РТХ же это дополнение, которое отлично играет для тех людей, которые уже "наелись" графикой и хотят уже чего-то свыше. Уверен, что среди пользователей в облака таких юзеров действительно минимум.

ObitoUchiha1985

08.12.2021 13:23Аппаратный кодер у АМД - дно, по сравнению с Nvidia, по крайней мере на всём, что до rx 6000, а rx 6000 я не тестировал, но сомневаюсь что там внезапно сильно подняли качество кодера, что оно стало лучше чем у Nvidia.

DeepFakescovery

06.12.2021 18:33у вас безлимит за 3600р/мес. А майнить разве не выгоднее?

Alexey2005

06.12.2021 20:28Так ведь на одной карточке больше хэшрейта не намолотишь, тогда как игроков, которые будут играть по 24 часа в сутки весь месяц, вряд ли сильно много. И одна карточка таким образом может обслуживать сразу нескольких игроков. А дальше уже богатые возможности для организации оверселлинга.

Victor91rus

06.12.2021 18:56Странно, что вы не рассматриваете преимущество в наличии DLSS. С учетом сжатия-пережатия это будет неотличимо от натива, а бонус в производительности позволит намного дольше прожить на имеющейся видюхе.

MYGAMES Автор

07.12.2021 12:04Мы упоминаем DLSS, как преимущество NVIDIA. Однако отталкиваемся от того, что гейминг через облачные сервисы обычно происходит в разрешении Full HD, AMD же отлично подходит и для комфортной игры в 1440p, так что выходит, для описанных целей в DLSS нет особой нужды.

Victor91rus

07.12.2021 13:46какая разница в каком разрешении играет юзер? Вы, видимо, не понимаете как работает DLSS.

И почему же вы в качестве аргумента о производительности берете рекламные материалы заинтересованной стороны - AMD? Вас не смущает, что в их тесте 3060ti подозрительно выдает одинаковый результат с 3070? Вас не смущает, что при тестировании на AMD почему-то включен SAM, а на NVIDIA не включен RBAR? Посмотрите комплексные тесты на независимых ресурсах, где выставляются одинаковые условия, подбираются все игры подряд, а не только которые лучше там или там, и вы поймете, что как минимум 3070 не хуже в 1440p даже без учета DLSS. А с DLSS даже 3060ti оставляет решение от AMD далеко позади.

Tipa_Tip

07.12.2021 11:48Добавьте поддержку Ultrawide мониторов. Будет конкурентным преимуществом.

Уже несколько лет как задумываюсь над переходом в облачный гейминг, но ни у кого нет поддержки, а играть с чёрными полосами по бокам совсем не то.

lykovaleksey

07.12.2021 12:19Сейчас основным блокером является скорость работы енкодера и декодера, которые не поддерживают кастомные расширения. Т.к. используются аппаратные кодер и декодер, для повышенной производительности, то это ограничение со стороны железа, которое мы самостоятельно не сможем обойти.

ObitoUchiha1985

08.12.2021 13:14Только 1 вопрос. Какой максимальный битрейт вы можете отдать клиенту? То что написано в статье (20 мбит 60 фпс 1080р) - это, в зависимости от настроек кодера, либо мыльцо лютое, либо квадратики. Это и близко не то, что будет на локальной машине, на локальной машине и 720р будет лучше чем такое шакальное 1080р.

Давно пробовал playkey, диспетчер задач показывал скорость 30-35 мбит - картинка дичь, просто не хочется в такое играть и всё, лучше играть на минималках на своём ПК, чем в это. Такое качество подойдёт разве что для мобилок и планшетов, даже на ноуте с экраном 15.6 уже так себе, про мониторы 24-32 дюйма и тем более телевизоры и говорить нет смысла.

У меня интернет 250 мбит, торренты качает стабильно 25 МБ/с (200 мбит), бывает поднимается до 35 МБ/с (280 мбит) в зависимости от сидов, поэтому нужен поток хотя бы 80 мбит (в идеале 120-150 мбит), иначе только если бесплатно.

maiden666

08.12.2021 21:52все пишут про облачный гейминг, но я не смог найти информацию, можно ли организовать локальный облачный гейминг у себя дома, чтобы с 1 сервера можно было на разных машинах запускать разные игры?

Tarakanator

Как то вы лукавите.

1)да я согласен что время RTX ещё не настало, но такое впечатление, что вы специально выбрали кадры в которых толку от RTX нет. На RTX надо смотреть тени\освещение\отражения. А на ваших скриншотах только тени... и похоже от статичного источника освещения.

2)так почему AMD?

3)Вы сами в пример приводите DOOM, а не какую-нибудь стратегию. Что с инпут лагом?

а)если мы патчкордом подрубимся к серверу на сколько инпут лаг от мышки до монитора будет больше, чем если та-же 6700 стоялы бы напрямую в компе?

б)В случае с реальной сетью достаточно ли к инпут лагу из пункта "а" добавить время отклика сервера, или нужен поправочный коэффициент (большие пакеты дольше идут).

4)В VR шлемах есть интересная технология, которая позволяет крутить камеру независимо от входного сигнала (т.е. в шлем прилетел видеокадр, а уж в каком месте его отобразить решает шлем на основании того как его повернули). Что сводит к 1/fps шлема инпут лаг поворота. Есть ли у вас похожие технологии?

lykovaleksey

Выбрали популярную и достаточно требовательную игру, кажется пример вполне релевантный. Конечно же можно выбрать специальную игру с изобилием трассировки лучей, но мы взяли что-то среднее.

На рынке не так много решений графических ускорителей, расширяем технологическую базу, в статье описали преимущества, конечно же помимо технологических пунктов, есть ещё и рыночные, рынок сейчас очень нестабилен, как в поставках, так и в ценах и надо иметь альтернативное решение, уверен это будет на благо всем участникам рынка. Кстати один из Глобальных конкурентов работает на AMD.

Инпутлаг будет на любой видеокарте, он никуда не исчезнет, т.к. технология его закладывает по определению, при прочих равных, видеокарта не сильно на это влияет. Ориентировочны цифры 5-10мс, но есть важные моменты связанный с измерением. Большие пакеты действительно могу идти дольше, но в рамках UDP всё достаточно прямолинейно, и тут уже важнее, дойдут или нет пакеты по сети, и можно ли будет из того, что дойдёт, показать такую же прекрасную картинку, как при выходе с сервера. Именно поэтому, в облачном гейминге очень важно качество канала между серверов и клиентом, т.е. идеальный провод, с неперегруженными коммутаторами, и широкими каналами без шейминга.

Если я правильно понял, Вы говорите о рендеринге 3D на клиентском устройстве, т.е. запуск идёт на компьютере и передаётся только видеопоток, то такой технологии нет. Но если говорится, что игра как-то передала 3D картину мира на VR очки, и поэтому в очках этот мир нарисован заранее и рендерит по какой-то причине быстрее чем компьютере, то это можно реализовать, просто данные будут точно также передаваться по сети. Какой-то эксклюзивной поддержки VR сейчас нет, кажется рынок ещё не сформировался.

Tarakanator

Претензия не к выбору игры, а к выбору сцены.

Я не увидел именно описания преимуществ AMD vs Nvidia. Максимум что в некоторых играх превосходит 3070.

5-10мс это хорошо. думал будет хуже.

Нет я про другое. Вот вы передали видеокадр с сервера клиенту. Вопрос: Данный кадр гвоздями к монитору прибит, или если скажем соединение прервётся (клиент не получит кадр N+1) то игрок двигая мышкой сможет хотябы смещать текущий кадр? Т.е. в идеальном случае, если игрок смотрит на неподвижную сцену, он даже не заметит, что видеопоток прервался.

tzlom

Пункт 4 имеет смысл только для VR, там 2 картинки и хитрым преобразованием можно их поменять так, чтобы компенсировать небольшие повороты головы без перерисовки кадра. И это делается на источнике сигнала а не в шлеме.

Для обычных игр это не возможно т.к. во первых нет обязательного буфера глубины, а во вторых не понятно что делать с интерфейсом. Да и ввод управляется игрой, сторонняя система не сможет угадать чувствительность мыши например.

vikarti

Возможны варианты если у шлема есть свои мощные мозги.

Например https://uploadvr.com/virtual-desktop-synchronous-spacewarp/ например

Tarakanator

1)Это делается именно на шлеме.(в случае oculus quest 2. Был случай свет моргнул, комп ушёл в ребут. В шлеме картинка зависла, но при повороте головы она смещалась

2)В шлеме буфера глубины нет и он тоже не используется. Это заметно когда крутишь головой, а сигнал намертво завис. Если же надо достроить 1 кадр, то 2д сдвиг выглядит нормально.

3)Думаю нет ничего сложного в калибровке мыши.

4)Интерфейс да, проблема. Но я же не говорил что будет легко? Но технология для облачного гейминга выглядит интересной. Ну и потом думаю не так уж сложно поставить перед нейросетью задачу. А нука найди мне где тут интерфейс.

5)https://uploadvr.com/virtual-desktop-synchronous-spacewarp/ это не то, как вы видите на ролике тут вообще не про поворот камеры.

YegorVin

5) там скорее заранее отрендерено с избыточностью (что то вроде сферического изображения как в роликах для обзора в 360 градусов) для возможности моментально показать нужный ракурс картинки в зависимости от положения головы.

Tarakanator

ну да. Но за область отрендеренного тоже позволяет перемещаться.

YegorVin

Ну вы же понимаете что в 2021 даже нейросети не могут дорисовать моментально то что за кадром да еще и достоверно. А значит там кадр рендерится значительно большего размера чем виден в текущем положении камеры. Так как инпут лаг при повороте головы приведет к тошноте. Там это критично важно.

Tarakanator

А в случае с облачным геймингом критически важно время отклика.

И тут, пусть и с нюансами, но можно получить выигрышь. И мне непонятно почему не пробуют (если не пробуют).

Mr-VIT

2) для 60fps если очередь кадров на рендер удерживают на 0 (а скорее всего там 1-2, т.е. + 16-33мс) = 16мс+енкодинг+пинг+

3) для ВР шлема проще, так как координаты шлема в реальности совпадает с координатами камеры в игре. С мышью все не так. Тут нужно, что бы движок игры сообщил клиенту, как искажать кадр при смещении мыши, а это не реализовано в играх, и даже если и будет, то остаётся проблема сильного искажения изображения, так как монитор занимает в вашем зрении небольшой угол, а отображают большой игрового/виртуального пространства. В ВР шлеме наблюдаемый угол обзора равен виртуальному, т.е. смещение и искажения кадра не значительны и быстро замещаются нормальным новым кадром.

Tarakanator

3)Достаточно калибровки. Типа N движения мыши соответствует смещению на M пикселей. Я конечно могу придумать ситуации в которых это не будет работать, но я это к тому, что технически такое реализовать можно. Это как DLSS. Конечно не настоящие 4к, но что делать если на настоящие производительности не хватает?

domix32

2. AMD хоть как-то доступен, NVIDIA скуплен майнерами. Скорее всего в этом весь ответ почему AMD.

gxcreator

А как вы добились 5-10 мс лага? Как кодирование+декодирование удалось уместить в 5мс?

ObitoUchiha1985

Наверное убрали буферы, убрали b-кадры, оставили 1 референсный кадр и получили дичь, а не качество, иначе никак. Или буферы и иерархическая структура референсных кадров с b-кадрами, или низкая задержка и кодек обрезан под корень. А когда кодек так обрезан, нужно использовать х2 битрейт, чтобы качество не страдало.

GregGoodenough

RTX это название проприетарной технологии nvidia. Будущее не за ней, а то что вы приравниваете ее к RT/RTRT/PathTracing говорит о том что вы не понимаете о чем рассуждаете и/или сильно подвержены влиянию отдела маркетинга корпорации nvidia.

Рекомендую вам решить эту проблему как можно скорее, тк уязвимость к корпоративной пропаганде приводит к неверным потребительским решениям.