Какое у вас любимое мороженое? Шоколадное, ванильное, фисташки, крем-брюле? Вы легко дадите ответ. Но если вас спросят, почему именно этот конкретный вкус, тут уже дать конкретный ответ станет гораздо сложнее. Большинство максимум придумают, что так у них устроены вкусовые рецепторы. Но почему они устроены именно так, и почему тогда нам иногда хочется пробовать другие виды мороженого?

Если бы мы подвергали анализу такие повседневные вещи в своей жизни, мы скоро бы поняли, что часто не можем точно понять причины своих предпочтений, эмоций или желаний. Не можем разобраться с тем, что на самом деле происходит у нас в мозгу. А что тогда с ИИ? В него заложены конкретные программы и алгоритмы, значит, мы можем определить, чем конкретно он руководствуется при принятии тех или иных решений, правда? Или хотя бы примерно предсказать, какими они будут?

На самом деле, с ИИ всё обстоит еще хуже. Чем дальше развиваются технологии, тем чаще мы вообще не можем понять, что происходит там внутри. А значит, и не можем быть уверены, стоит ли нам доверять таким решениям. Исследователи всё чаще предупреждают, чтобы при разработке моделей ИИ мы уделяли больше внимания тому, как и почему они выдают определенные результаты, а не тому, как точно и быстро они могут их выдавать.

Черный ящик

У людей, которые разрабатывают ИИ, все чаще возникают проблемы с объяснением того, как он работает, и пониманием, почему он дает те результаты, которые дает. Глубокие нейронные сети, имитирующие работу нейронных сетей нашего мозга, часто, кажется, отражают не только человеческий интеллект, но и необъяснимость глубин человеческого сознания.

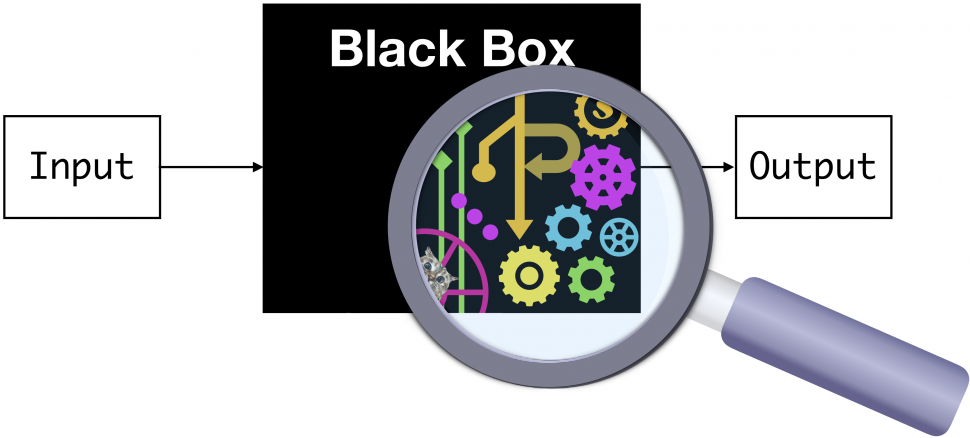

Большинство систем ИИ представляют собой классические модели черного ящика. То есть, эти системы рассматриваются только с точки зрения того, что у них на входе, и того, что на выходе. Разработчики просто получают результаты, и сравнивают их с теми, которые хотели бы получить. Они не пытаются «расшифровать черный ящик» или понять те непрозрачные процессы, которые выполняет система, пока занимается поиском результата.

Например, если предоставить этому «черному ящику» данные о каждом вкусе мороженого, а потом о вашем экономическом состоянии, социальном положении, возрасте, образе жизни и так далее — он, вероятно, сможет догадаться, какой вкус мороженого вам нравится больше всего. А если система выдаст неверный результат, всегда можно «скормить» ей еще больше данных, привязать разные коэффициенты, и делать это, пока результат совпадет. Причем не только для вас, а и для 100 случайно выбранных людей. После этого можно выходить с научной работой, запускать сервис, идти к инвесторам, выходить на компании по продажам мороженого. И говорить, что у вас есть система, которая работает.

Но правда ли она работает? Какие факторы она учитывает, как приходит к своим выводам? Не будет ли такого, что, однажды, обработав другой набор данных, та же модель решит, что нужно рекомендовать всем людям мороженое с насекомыми или со вкусом пиццы?

В конце концов, уже есть несколько долго и успешно работавших ИИ, которые провалились. Например, в США большой скандал вызвали системы автоматического одобрения онлайн-заявлений на ипотеку. Они работают уже несколько лет, упрощая работу крупнейших ипотечных кредиторов страны, и вполне успешно повышая их прибыль. Но потом оказалось, что для этого они автоматически отклоняли 80% заявлений от темнокожих заявителей. Используя обширные базы данных, они определили, что люди с такими фамилиями и именами в целом живут в более дешевых домах, а значит, запросы от похожих людей в целом проще отменять.

Похожие «факапы» уже случились с приглашениями школьников в университеты и даже с рекрутингом. Опять же, всё в лучших традициях Германии тридцатых годов: если у вас «не такая» фамилия, нужно будет очень много аргументов, чтобы система всё-таки решила рассмотреть вашу кандидатуру. Когда такие ИИ внедряли, казалось, они позволят навсегда отказаться от расизма в университетах, при покупках домов и при приеме на работу. Но оказалось, что на деле они только привязались к текущим тенденциям, успешно нашли эти паттерны, и дополнительно их усилили.

Но в США хотя бы есть четкий маркер, позволяющий быстро определять такой провальный ИИ. «Тест по темнокожему». А что делать с теми ИИ, которых нельзя прогнать через такой тест? Или теми, которые разработаны в странах, где просто нет такой выборки? По каким еще параметрам они полностью проваливаются, но мы просто этого не замечаем?

По мере того, как системы ИИ становятся все более сложными, мы все меньше способны их понимать. Поэтому исследователи ИИ и предупреждают разработчиков, чтобы они уделяли больше внимания тому, почему система дает определенные результаты, и встроили в свои системы механизмы, помогающие определить причины тех или иных решений внутри «черного ящика».

Роман Ямпольский, профессор компьютерных наук Университета Луисвилля, в своей работе «Необъяснимость и Непостижимость искусственного интеллекта», пишет:

Если все, что у нас есть, — это «черный ящик», то невозможно понять причины сбоев и повысить безопасность системы. Кроме того, если мы привыкнем принимать ответы ИИ без объяснения причин, мы не сможем определять, если он начнет давать неправильные или манипулятивные ответы. Это чрезвычайно опасная дорога, на которую мы ступаем.

Модели «черного ящика» могут быть очень мощными, и быстро выдавать то, что нужно их разработчикам. Именно поэтому они используются для разработки беспилотных автомобилей, чат-ботов и даже диагностики заболеваний. При этом некоторые задачи они уже способны выполнять лучше, чем люди. Но опасность в том, что невозможно понять, в каких случаях может произойти ошибка, и даже определить, когда она станет системной.

Скажем, если через десять лет модель диагностики заболеваний начнет на 5% чаще говорить, что у человека рак, и массово отправлять тысячи здоровых людей на химиотерапию, никто не сможет засечь этот момент. Разве что кто-то заранее додумается встроить в неё механизм определения подобных сбоев. Всё в соответствии со словами Джеффа Голдблюма из «Парка Юрского периода»: «Ученые были так озабочены тем, смогут ли они это сделать, что даже не задумались над тем, стоит ли им это делать».

Во многих случаях в принципе невозможно создать осмысленную нейронную сеть, потому что входные данные просто не содержат достаточного количества информации. Но мы этого не знаем, и такая система может стать главным «принимателем решений», как произошло в случае с системами, выдававшими кредиты, и одобрявшими заявки абитуриентов. Потом нам тяжело аргументированно вмешаться в работу системы и спорить с её выводами, потому что мы не понимаем принципов принятия этих решений. Поэтому мы думаем, что всё идет отлично, пока как лемминги шагаем к краю обрыва.

Ни одного из этих людей не существует

В новаторском, оказавшем потом огромное влияние на работы с ИИ, исследовании 2018 года Джой Буоламвини и Тимнит Гебру первыми обнаружили, что все популярные системы распознавания лиц точнее всего определяют мужчин со светлой кожей (2,4% ошибок). И чаще всего ошибаются при обнаружении женщин с более темной кожей (61% ошибок). Причины, видимо, там было три: фотографий темнокожих женщин меньше всего в базах данных; разработчики таких систем сами преимущественно являются белыми мужчинами; датчики камер хуже распознают детали в темных цветах.

Несмотря на это, такие системы до сих пор используются во многих сферах, а главное — в работе полиции. В том числе и в России, и в Китае. Доказано, что если вы — одно из расовых меньшинств в такой стране, эта система будет чаще определять в вас преступника. Просто потому, что преступление совершил кто-то с «похожим на вас» лицом. Из-за таких ошибок (когда сначала ошибается ИИ, а потом ещё и попадается свидетель с плохой памятью на лица) в тюрьмах сидят сотни невинных людей. И их постепенно будет становиться больше.

Плюс к этому темнокожие пациенты, азиаты и женщины чаще получают ошибочный диагноз от автоматизированных систем, анализирующих медицинские изображения. А еще системы искусственного интеллекта могут c невероятной точностью угадывать расу людей на основе рентгеновских снимков и компьютерной томографии. Здесь ученые вообще понятия не имеют, как это происходит, потому что никаких данных для этого в снимках вроде бы нет.

Все эти проблемы теперь, особенно после 2018 года, широко известны. Но где искать решения — пока не ясно. Некоторые эксперты говорят, что переход к открытым и интерпретируемым моделям ИИ просто приведет к тому, что системы станут менее эффективными. Так что лучше пусть несколько сотен людей посидят в тюрьмах, а другим повыписывают неверные диагнозы. Может, потом ИИ научится на своих ошибках, и всё станет лучше, правда? Тем более, альтернативы у нас всё равно пока нет.

Или есть?

Белый ящик

В последние годы некоторые представители отрасли предприняли небольшой, но реальный толчок к разработке «моделей белого ящика», которые являются более прозрачными для человека, и результаты поведения которых можно объяснить.

Подробнее можно почитать в этом посте на Medium (или здесь). Если вкратце, предлагается разбивать систему на модули, каждый из которых может быть интерпретирован человеком. Или изначально строить модели хотя бы с локальной прозрачностью, чтобы человек не терял контроль над ситуацией. Для определения сложности каждого модуля предлагается использовать количество работающих в ней правил — размерность Вапника-Червоненкиса (комбинаторную размерность).

Пока что «белый ящик» — это довольно нишевая идея, и «черный ящик», как мы знаем, является доминирующим методом обучения всех моделей ИИ, от Alpha Zero до GPT-3. Это просто самый быстрый метод достижения результата. Дал машине массив данных, показал, что ты от неё хочешь, настроил несколько конкурирующих моделей, и посмотрел, какая даст результат. Разбираться в мелочах мышления ИИ — тут можно зависнуть на годы. А поскольку каждая компания волнуется о том, чтобы не обанкротиться, и каждая команда внутри пытается доказать свою эффективность, мало кто ищет такие более сложные пути достижения той же цели.

А это значит — пока в дело не вступят регуляторы, «черный ящик» неизбежно будет доминировать. Пока публично не будет доказано, что это опасный метод, и на этот способ разработки ИИ не наложат, скажем, финансовые ограничения, делающие «белый ящик» сравнительно более выгодным.

Один из «белых» ИИ научился делать фото мультяшными

Как мы знаем, и как не раз нам доказывали и американские, и российские власти, регуляторы технологии понимают крайне слабо, так что на ближайшие десятилетия, наверное, можно не волноваться. Но в то же время первые звоночки уже есть. Так, в статье 2021 года, написанной учеными из Пало-Алто, которые были потом уволены из Google за эту публикацию, авторы почти напрямую выступают за введение ограничений.

Так, они утверждают, что если обучать модели ИИ с помощью больших данных, встроенные в них расовые и другие предубеждения — неизбежность. Например, есть такой простой факт, что у некоторых групп населения просто меньше доступа к Интернету. В результате чего «больших данных» о них собирается гораздо меньше, и ИИ считает их «менее людьми», а их интересы — не такими релевантными.

Жители деревень и дальнобойщики в Сети встречаются реже, чем программисты и сисадмины. Но это не значит, что в целом их меньше.

Машины, натренированные на больших данных, неизбежно будут «забывать» о широких группах населения. И станут представлять интересы в первую очередь более молодых и продвинутых пользователей. Это, конечно, может быть хорошо для нас, читающих эту статью на Хабре и хорошо представленных в Интернете. Но в целом для страны и для мира — не очень.

В своей статье ученые пишут:

Если мы ориентируемся на большие данные, то всегда будем отдавать предпочтение тем, у кого есть ресурсы, чтобы публиковать свои изображения, видео, пользоваться платными сервисами, демонстрировать свое публичное мнение. Мы разделяем людей на тех, кто активно пользуется интернетом, и тех, кто только изредка в него заходит. В этом есть что-то фундаментальное и недемократичное. Мы должны стараться делать жизнь людей лучше, а не ещё сильнее разобщать общество.

Если мы не участвуем в разговорах, о том, в каких условиях и для кого сейчас разрабатывается ИИ, значит, как человечество мы проиграли. Следующий самый мощный разрабатываемый инструмент будет служить только людям, обладающим властью, и интересоваться только их перспективой. В дальнейшем, если мы не изменим нашу методику обучения ИИ, такое преимущество будет только нарастать, пока не приведет к социальному взрыву или другим серьезным последствиям.

Строительство «хорошего» ИИ

Устранение предвзятости наборов данных, на которых обучаются системы ИИ, практически невозможно в обществе, где сам Интернет является предвзятым. Решения тут два: или использовать сравнительно небольшие наборы данных, где разработчики контролируют, что в них появляется. Или проектировать систему изначально с учетом наличия в ней предвзятости, с пониманием того, что данные не идеальны, а не симулировать беспристрастность и потом бегать в панике, когда разошелся скандал.

Как писали ученые в своей статье, поскольку сокращать объемы данных пока не хочет никто, на настоящий момент наилучший (хоть и далеко не идеальный) подход — второй. Обучение с подкреплением путем обратной связи с людьми. Мы не видим, что происходит внутри черного ящика, но, тем не менее, можем активно пытаться улучшить контент внутри. Сделать так, чтобы система научилась понимать наши ценности.

Это значит, что если ИИ не делает то, что нам нравится, мы даем ему отрицательную обратную связь. Он на ней учится и пытается снова. Мы повторяем этот процесс до тех пор, пока он не выдает что-то, что мы одобряем. Система использует обучение методом проб и ошибок, с учетом человеческого элемента.

Такой подход, конечно, годится далеко не для каждого ИИ: не везде можно поставить человека на выходе, следящего за результатом. Изначально нерепрезентативная выборка данных тоже никуда не девается. Но пока что это лучшее из того, что мы точно научились делать.

Сейчас этот подход внедрили и YouTube, и Facebook, запустив свои алгоритмы, на которые могут прямо влиять пользователи — скажем, массово дизлайкая, ставя флаги или быстро скрывая видео, что дает понять системе, что с ним что-то не так. Финальное слово в итоге тоже часто остается за человеком: нанятый оператор определяет, банить или не банить канал, удалять или оставлять пользователя на платформе. По мере того, как контент черного ящика улучшается, а система всё точнее подстраивается под наши ценности, человеческого влияния требуется меньше и меньше. Но поскольку наши ценности тоже склонны меняться, полностью от операторов такие платформы не смогут отказаться никогда.

Сейчас для большинства задач подходы черного ящика показывают себя лучше, чем интерпретируемые модели. И даже в тех случаях, когда интерпретируемые модели дают неплохой результат, обычно приходится идти на компромисс между их возможностями и тем, насколько точно мы можем их понимать. Судя по всему, подобный разрыв будет существовать ещё долго. Чем меньше мы понимаем о внутренней логике конкретной модели ИИ — тем более ценными для нас потенциально могут быть результаты её работы.

Но в таком случае наделять машины возможностями «Скайнета» пока еще рано. И даже давать им принимать решения по поводу того, каких людей нанимать на работу или кому давать кредиты — возможно, преждевременно.

Предложения от самых передовых компаний в РФ и за рубежом — в телеграм-боте getmatch. Тысячи вакансий, зарплаты до 450 тысяч рублей. США, Грузия, Армения, Кипр, Европа. Указываете желаемую зарплату, и бот выдает вам лучшие предложения, и помогает пройти интервью. Всё бесплатно.

| Подборки вакансий по локации |

Подборки вакансий по зарплате |

Комментарии (105)

evtomax

23.11.2022 15:18Может стоит смириться с тем, что в задачах, где недопустимы ошибки, искусственные нейросети без сильного ИИ могут иметь только вспомогательную роль, а последнее слово должно оставаться за человеком с полноценным мозгом и жизненным опытом?

unC0Rr

23.11.2022 15:22+8В задачах, где недопустимы ошибки, человеку делать нечего.

Keeper13

23.11.2022 15:32А ИИ -- и подавно.

unC0Rr

23.11.2022 15:37+1Если у человека 5% ошибок, а ближе к вечеру 10%, то ИИ с 4% выглядит не так и плохо.

BlackMokona

23.11.2022 15:42+4Тут как с роботами автомобилями, ошибаться никак нельзя будут трупы. Но если ошибаться реже то будут спасённые жизни, много спасённых жизней.

Goupil

23.11.2022 18:33+1Если ошибся человек - виноват конкретный человек. А если машина?

DaneSoul

23.11.2022 20:07+2То есть проблема только в том, чтобы было кого наказать?

Бывает же что никто не виноват — стихийное бедствие например, какая-то катастрофа которую невозможно было предотвратить, неизлечимые болезни.

Почему в данном случае нельзя рассматривать это как подобное событие?

BlackMokona

23.11.2022 22:52Можно вести серьезные, но фиксированные штрафы компаниям разработчикам автопилотов в зависимости от серьезности ДТП если причины по расследованию выявят их ошибки. Которые будут изменяться коэффициентом который зависит от общей статистики по аварийности их автопилота к среднему на дорогах.

Goupil

24.11.2022 01:50+1То есть проблема только в том, чтобы было кого наказать?

Да. В развитом мире целые армии юристов, которые только и ждут, появления повода засудить.

Почему в данном случае нельзя рассматривать это как подобное событие?

Потому что это катастрофа, созданная творением человеческих рук. Если проносится ураган и человек страдает - виновата природа, взятки гладки, бог трубку не берет. Если рядом на бензоколонке происходит взрыв из-за статического электричества и нарушения ТБ (а их обязательно найдут) и страдает человек, то виноват хозяин бензоколонки,и он будет оплачивать ущерб.

Когда все эти автоматические системы будут в н-ом поколении полностью созданы такими же автоматическими системами, тогда и можно будет к результатам их деятельности относиться как к природному событию. Когда эти системы станут сильными ИИ с гражданскими правами и свободами, то все претензии тоже можно будет направлять им. А пока что при просчетах ИИ юристы и регуляторы будут натягивать переход туловища в ноги на визуальные персептривные органы создателю программного продукта.

DaneSoul

24.11.2022 02:26+2Да. В развитом мире целые армии юристов, которые только и ждут, появления повода засудить.

Армии юристов действуют в рамках правового поля, которое задает государственная власть (законодательная и судебная системы). Поэтому если профит от технологии многократно превышает риски, то законы будут адаптированы под это дело.

У нас давно есть куча потенциально смертельно опасны технологий от которых периодически гибнут люди, но никто никогда от них не откажется, потому что профит многократно перевешивает риски. Поэтому газовое оборудование продолжит с некоторой небольшой но не нулевой вероятностью взрываться, самолеты изредка падать, медицинские манипуляции и лекарства иногда убивать людей вместо спасения и т.д. и т.п — ничего принципиально уникального нет в ситуации, что человек использует что-то опасное что не может полностью контролировать и что может его потенциально убить.

Посмотрите на фармакологию, например. Там куча рисков, что созданное лекарство может калечить и убивать пациентов. И концепция черного ящика тоже частично применима, так как сложность организма на молекулярном уровне настолько огромна, что нельзя предугадать все возможные влияния препарата и исключить риски. И в истории известны эпические провалы в этой сфере, тот же талидомид, например. Из-за опасности отрасль сильно зарегулирована, куча дорогостоящих тестов и экспертиз перед запуском препарата, но отрасль продолжает работать. И никакой провал отдельного препарата или компании в этой отрасли никогда саму отрасль не похоронит.

Goupil

24.11.2022 11:49Поэтому газовое оборудование продолжит с некоторой небольшой но не нулевой вероятностью взрываться, самолеты изредка падать, медицинские манипуляции и лекарства иногда убивать людей вместо спасения

И во всех этих случаях встает вопрос о компенсации погибшим или пострадавшим. Касательно медицины - врачи в США имеют страховку от судебных дел из-за malpractice suits. Да, иногда выкручиваются, на чаще платят.

Когда ошибается врач - это ошибка конкретного врача. Когда ошибается единая система -это ошибка всей системы, и возможны групповые иски.

Так кстати в фарм индустрии и происходит. Системный сбой автопилота это аналог примеси в лекарственном средстве, от которого люди массово начинают болеть и умирать, а не побочных эффектов во-время клин испытаний.

Kanut

24.11.2022 12:40+2Ну так точно так же можно ввести обязательную страховку для использования определённых категорий ИИ.

И в случае с машинами это для кучи стран вообще не проблема потому что там всё равно есть обязательное страхование для машин.

То есть если случилась авария, то по дефолту оплачивает страховка. А потом в случае чего она сама уже разбирается с производителями машин/создателями ИИ. Как это сейчас делается в случае с заведомо неисправным "железом" в машинах.

Tarakanator

24.11.2022 10:08Проблема в ПДД.

Из-за неспособности составить "правильные" ПДД, они составлены так, чтобы всегда можно было назначить виновного.

Не учёл дорожную обстановку и двигался слишком быстро самое распространённое.

По вашему в случае одинаковых ДТП в случае если за рулём человек, ему будут назначать вину за несоблюдение ПДД, а в случае если за рулём ИИ это стихийное бедствие?

А в то, что ПДД смогут корректно переписать я не верю.

DaneSoul

24.11.2022 11:07По вашему в случае одинаковых ДТП в случае если за рулём человек, ему будут назначать вину за несоблюдение ПДД, а в случае если за рулём ИИ это стихийное бедствие?

А если человек двигался 100% по правилам, машина прошла все ТО и правильно обслуживалась, но например взорвалось колесо, что вызвало потерю управления и аварию, то виновен тоже водитель?

ksbes

24.11.2022 11:10"… водитель обязан перед началом движения… проверить… стояние шин ..." — там как-то так.

DaneSoul

24.11.2022 11:14Упростим задачу — водитель общественного транспорта перед выездом прошел тех.контроль от транспортного предприятия и таким образом имеет документ об исправности транспортного средства.

ksbes

24.11.2022 11:22Обязяности водителя от осмтора своего ТС перед поездкой это не отменяет. И водитель в том же документе расписывается, что провёл осмотр и всё ОК.

На практике в каждом кокретном случае разбираются: мог видеть/не мог, брак/не брак. Но по-умолчанию водитель виноват. т.к. он управляет средством повышенной опасности.

Юридический принцип здесь прост: не хочешь нести ответственности — не садись за руль. А раз сел, то да, ты уже виноват в том, что вывел в общественное пространство опасную хрень и потому несёшь ответственность за ущерб этой хренью принесённый.

Это примерно как стать родителем — ты тоже можешь быть виноват в том, что не совершал, но что обязан был контролировтаь.

Kanut

24.11.2022 11:39и таким образом имеет документ об исправности транспортного средства

Ну вот вы например и нашли крайнего. То есть того кто подписал этот документ.

Tarakanator

24.11.2022 13:05-1В таком случае он проверил перед выездом, но не обеспечил в пути

2.3.1. Перед выездом проверить и в пути обеспечить исправное техническое состояние транспортного средства в соответствии с Основными положениями по допуску транспортных средств к эксплуатации и обязанностями должностных лиц по обеспечению безопасности дорожного движения **.

Tarakanator

24.11.2022 13:042.3.1. Перед выездом проверить и в пути обеспечить исправное техническое состояние транспортного средства в соответствии с Основными положениями по допуску транспортных средств к эксплуатации и обязанностями должностных лиц по обеспечению безопасности дорожного движения **.

Tarakanator

24.11.2022 13:04Да, с точки зрения ПДД виноват водитель.

2.3.1. Перед выездом проверить и в пути обеспечить исправное техническое состояние транспортного средства в соответствии с Основными положениями по допуску транспортных средств к эксплуатации и обязанностями должностных лиц по обеспечению безопасности дорожного движения **.

fireSparrow

23.11.2022 15:46+2В любых критических задачах должна быть реализована многоступенчатая система контроля, и разным этапам такой системы следует иметь разную природу, чтобы минимизировать вероятность, что какие-то кейсы проскочат сквозь все слои.

С этой точки зрения контроль ИИ+человек определённо лучше, чем что-то одно.

leventov

23.11.2022 16:18+1Проблема в том, что способность человека что-то контролировать будет деградировать, если она почти никогда не нужна. Хотя, ИИ может специально мнимо пропускать какие-то проблемы, чтобы проверять человека.

zlat_zlat

24.11.2022 08:15Вы правы, но только нужно проработать вопрос принятия решения. Если анализировать техногенные катастрофы, то можно заметить, что автоматика защиты и без всякого ИИ предвидела катастрофу, но человек пренебрегал правилами и предупреждениями. В случае ИИ его предсказания будут казаться человеку ещё менее обоснованными.

Zenitchik

23.11.2022 16:46-1В задачах, где недопустимы ошибки, "сильный" ИИ будет показывать ещё худшие результаты, чем "слабый". В таких задачах нужна голая алгоритмика.

Pilgrim54

24.11.2022 13:27-2И без сильного ИИ, и с сильным - ответственность должна быть на человеке. Знаю, что эта точка зрения непопулярна. К счастью, насколько я знаю, это пока ещё так

В статье просто ужасные отхождения от этого принципа - ИИ назначает химиотерапию, и садит людей в тюрьму. В данных примерах ИИ может лишь помочь врачу в диагностике, обрабатывая большие объёмы данных, подсвечивая подозрительные места, и аналогично помочь в поимке преступников, анализируя видео, телефонные звонки или подобное

fireSparrow

23.11.2022 15:40+14И чаще всего ошибаются при обнаружении женщин с более темной кожей (61% ошибок). Причины, видимо, там было три: фотографий темнокожих женщин меньше всего в базах данных; разработчики таких систем сами преимущественно являются белыми мужчинами; датчики камер хуже распознают детали в темных цветах.

А есть какие-то аргументы в пользу того, что рассово-гендерный состав разработчиков реально как-то влияет на работу системы? Мне вот на вскидку не понятно, как бы он в принципе мог бы повлиять — если речь идёт именно про ML-систему, и разработчики не наполняли систему какими-то эвристик, которые были близки им самим.

Кажется, состав исходной базы данных и оптические свойства тёмной кожи сами по себе достаточно всё хорошо объясняют, а гендерно-рассовый состав разработчиков притянули чисто ради повестки.

Ну и, кстати, говоря, — а как сами BLM относятся к тому, что автор статьи предлагает дискредитировать схему с чёрным ящиком в пользу белого ящика?

Solozhenitsyn

23.11.2022 15:58+8Удивительно, что еще не предложено переименовать ящики в прозрачные и непрозрачные.

Bobovor

24.11.2022 02:33Процент черных женщин может стать выше. Но про расы я не понял, я может промыт, но насколько мне известно, черное население США действительно более бедно и криминогенно, что выливается в отказы по ипотеке, что не так? Это же чистый рационализм.

rg_software

24.11.2022 07:20Компьютер вам откажет не потому, что вы чёрный, а потому что живёте в районе, который он сочтёт слишком черным и носите имя, которое он сочтёт слишком чёрным.

Т.е., грубо говоря, сменив имя и переехав на соседний переулок, вы получите одобрение по ипотеке, что довольно экзотично. При этом, естественно, вам не скажут, что нужно сделать именно это.

zlat_zlat

24.11.2022 08:11На подобный рационализм всё равно умудряются оскорбляться. Помнится, была автоматизация расчета количества патрулей на районы, и «дискриминируемые» возмущались, мол почему программа направляет больше патрулей в гетто, хотя, разумеется, она отправляла их туда, где больше преступлений.

Kanut

24.11.2022 10:39+1Если человеку отказали в ипотеке потому что он бедный и имеет судимость, то это нормально. Даже если он чёрный.

А вот если человеку отказали потому что он чёрный и "черное население США действительно более бедно и криминогенно", то это проблема. Потому что этот конкретный человек совсем не обязательно "бедный и криминогенный".

BobovorTheCommentBeast

25.11.2022 11:16+1Это буквально одно и тоже же.

То что человек судимый и бедный, не значит что он не отдаст ипотеку. Это тоже статистика же.

Kanut

25.11.2022 11:20Тут мы уже всё-таки потихоньку переходим к причинно-следственным связям. И да, "судимый и бедный" это не особо хороший пример и я его использовал просто "по инерции".

Но вот скажей если "бедный и безработный", то тут уже не прoсто статистика. Потому что если денег нет и заработать он их не может, то и вернуть ипотеку ему не с чего.

council_estate

24.11.2022 06:16+3Но в США хотя бы есть четкий маркер, позволяющий быстро определять такой провальный ИИ. «Тест по темнокожему».

Интересно, можно ли судить о "провальности" ИИ, если негативный с точки зрения повесточки результат его работы появляется только у одной группы людей? Может, это больше в сторону социологии, а не алгоритмов? С точки зрения математики, на мой взгляд, все очевидно, особенно когда дело касается кредитов.

iskateli

23.11.2022 16:10+1А как можно сделать белыми (понятными) например правила для хорошей игры в Го? Ведь AlphaGo в итоге опровергла некоторые тактики человеческих мастеров, да и сами мастера часто не могут сказать почему хороша та или иная стратегия, играют на интуитивном уровне.

Kilorad

23.11.2022 16:12Можно много смотреть на то, как играет бот, и пытаться уловить паттерны. Если повезёт, их удастся формализовать до уровня слов.

Вроде как научиться у бота хорошей игре люди смогли, а вот что там со словесным описанием этих тактик - хз

DaneSoul

23.11.2022 20:11+2Проблема в том, что глубина просчета (анализ на n-ходов вперед) у бота может быть намного глубже чем у человека, что сделает для человека невозможным следование подобным стратегиям, которые просто не будут «укладываться в голове».

Akon32

24.11.2022 09:37Даже не "может быть намного глубже", а так и есть. Бот симулирует несколько тысяч игр до конца (ну то есть ходов по ~300 каждая симуляция), прежде чем сделать ход.

Akon32

24.11.2022 09:31-1правила для хорошей игры в Го

Правило у этого MCTS одно - "просчитывай варианты". Чем больше вариантов просчитаешь и чем лучше эвристики при просчёте - тем сильнее игра. Терафлопсы решают.

ЧСХ, игроки задолго до появления этого типа ИИ использовали подобный метод (быстрая интуитивная оценка, затем просчёт вариантов), это в относительно старых книжках по го есть.

Но дело в том, что "просчитывай варианты" гораздо лучше подходит компьютеру, чем человеку. Человек не может добавить себе ещё 100x вычислительных ядер, и это соревнование бесполезно. Профессионалы го, конечно, заимствуют идеи у ИИ (которые могут выделить), но таким образом ещё никто не смог победить ИИ (и вряд ли сможет).

mayorovp

24.11.2022 09:49MCTS полагается помимо перебора на функцию оценки позиции. И вот она-то в AlphaGo как раз и является тем самым непонятно как работающим чёрным ящиком.

mapnik

23.11.2022 16:40+5автоматически отклоняли 80% заявлений от темнокожих заявителей. Используя обширные базы данных, они определили, что люди с такими фамилиями и именами в целом живут в более дешевых домах, а значит, запросы от похожих людей в целом проще отменять.

Я правильно понял, что запрос на ипотеку должны отклонять с большей вероятностью, если заявитель живёт в более дешёвом жилье, но это правило должно действовать только для белых?

ihouser

23.11.2022 17:25+1Если постараться, то "правильный" ИИ будет исправно отклонять всех, кто хочет купить жилье по лучше.

Cr0zz

23.11.2022 23:16Кстати да, в том как это объяснено неполиткорректности не больше чем в сложном проценте

alzbuca

23.11.2022 16:44+4Когда такие ИИ внедряли, казалось, они позволят навсегда отказаться от расизма в университетах, при покупках домов и при приеме на работу. Но оказалось, что на деле они только привязались к текущим тенденциям, успешно нашли эти паттерны, и дополнительно их усилили.

Очень странное предположение что должны были избавить от дискриминации, так как статистика по образованию, уровню дохода, количеству преступлений среди темнокожих в США более грустная чем для белых. А обучающая выборка фактически эту статистику и обрабатывала для принятия решений. А не задумывалась о каком то равенстве.

Kanut

23.11.2022 16:57Вопрос в том зачем ИИ вообще что-то знать о параметрах вроде цвета кожи кандидата? Или зачем эти данные были добавлены в обучающую выборку?

Nedder

23.11.2022 17:07Я так предпологаю - ИИ в своем решении исходило только из адреса проживания кандидата. Анкета точно не могла иметь графу "цвет кожи". Просто потом взяли список "отказников" и потом ВДРУГ выяснилось, что они в большинстве своем чернокожие.

Kanut

23.11.2022 17:12Если я всё правильно понимаю, то в случае с ипотеками ИИ ориентировалось по имени-фамилии:

Используя обширные базы данных, они определили, что люди с такими фамилиями и именами в целом живут в более дешевых домах

Вопрос нужно ли знание имени-фамилии для обучения ИИ и для принятия решений по ипотеке? Аналогично с вопросом о принятии в университет или на работу. То есть естественно потом при положительном решении эти данные нужны. Но вот нужно ли их давать ИИ?

Nedder

23.11.2022 17:26+3А что еще какую информацию тогда нельзя давать ИИ? Возраст (а почему он отказал этому старичку 81 летнему), пол, рост и т.д.? Тогда зачем тогда ИИ нужен? Достаем наугад пару заявок и даем добро. Честно и непредвзято.

Kanut

23.11.2022 17:34А что еще какую информацию тогда нельзя давать ИИ?

Зависит от ситуации и от того что должен решать ИИ. В случае с ипотекой возраст это однозначно важный фактор. В случае с принятием на работу скорее нет. В случае с университетом зависит от правил, может там какие-то ограничения по возрасту есть.

А вот фамилия и имя точно роли играть не должны. Во всех трёх случаях.

Ritan

23.11.2022 17:48+4Достаем наугад пару заявок и даем добро. Честно и непредвзято.

А потом окажется, что заявки чаще подают белые гетеросексуальные мужчины. Упс...

playermet

23.11.2022 17:49+4Кредиты/ипотеки наименее рискованно отдавать людям, которые их выплатят. Т.е. здоровым (не наркоманам/алкоголикам), образованным, с хорошей зарплатой, из благополучной семьи, без отсидок, не на смертном одре и т.д. и т.п. Эти данные необходимы чтобы сеть выполняла свое прямое предназначение. И на данном этапе истории темнокожие во многих регионах будут объективно выгребать по этим параметрам, потому что они исторически так сложились, а не потому что нейросети - расисты. Лет через 50-100 может и не будет разницы.

Kanut

23.11.2022 17:53+1Условный Барак Обама тоже будет "объективно выгребать"? Или всё-таки нет?

То есть если ИИ получил даные что человек без образования и зарплаты, отказал на этих основаниях и потом выяснилось что человек негр, то это вполне легитимно.

А если ИИ посмотрел имя-фамилию, прикинул что по статистике люди с таким именем-фамилией обычно без образования и хорошей зарплаты и отказал на этом основании, то вот это уже провал ИИ. Вне зависимости от того какой там цвет кожи был у человека.

playermet

23.11.2022 18:23+2Условный Барак Обама - не среднестатистический темнокожий. Он этот тест ИИ даже проходить не будет.

А если ИИ посмотрел имя-фамилию, прикинул что по статистике люди с таким именем-фамилией обычно без образования

Это еще доказать нужно. А вой будет в любом случае, просто по факту результирующей статистики.

Kanut

23.11.2022 18:28+1Условный Барак Обама - не среднестатистический темнокожий

Ну так об этом и речь что любого человека надо рассматривать по его конкретным атрибутам.

Это еще доказать нужно

Это конкретный пример , который мы тут обсуждаем.

larasage

24.11.2022 07:55+1У условного Барака Обамы будут плюсы в виде высокого дохода, проживания не в гетто, хорошего образования итп

Vsevo10d

23.11.2022 17:49+15А можно я страшную вещь скажу - может нейросеть совершенно правильно решила, что не стоит давать займы людям, в массе живущим на пособиях, в неблагополучных районах, долбящим крэк, совершающим мелкие правонарушения? А потом пришли кожаные мешки с идеалистским прокрустовым ложем социальной справедливости, и возмутились независимому исследованию?

Нейросеть же не человек, она не называет кого-то конкретно "неплатежеспособным ниггером". Она просто оценивает плотность вероятности нарваться на невыплату денег от определенного типа людей. И из предоставленных ей дискретных параметров роста/веса/пола/расы/района проживания получилась такая картина. Это не дискриминация, нейросеть не может мотивированно дискриминировать, это констатация факта. А вот почему цветные оказались в таких условиях в обществе - уже вопрос социальной политики.

Приведу предельный пример: если бы в рабовладельческой Америке нейросеть оценивала перспективность принятия абитуриента в университет, то 100% она не пустила бы ни одного негра. Но не потому что негры не люди, а потому что они были тогда в таких условиях, что нормального образования для подготовки к поступлению не получали. Просто констатация факта. А почему так - вопрос уже к людям.

Так что делайте такие обучающие параметры, чтобы нейросеть смотрела на состояние банковского счета у конкретного человека, а не оценивала популяцию в целом по стереотипным средним.

Kanut

23.11.2022 17:59А можно я страшную вещь скажу — может нейросеть совершенно правильно решила, что не стоит давать займы людям, в массе живущим на пособиях, в неблагополучных районах, долбящим крэк, совершающим мелкие правонарушения?

В данном слуичае ИИ решил не давать займы людям у которых имя-фамилия часто встречаются среди людей "в массе живущим на пособиях, в неблагополучных районах, долбящим крэк, совершающим мелкие правонарушения".

То есть представьте себе что по какой-то там причине люди с именем "Всеволод" чаще других употребляют наркотики. Ну вот банально флюктуация в статистике. И вам на этом основании отказывают в займе. Хотя вы никогда не употребляли и не собираетесь.

transcengopher

23.11.2022 18:35+8В данном случае ИИ решил не давать займы людям у которых имя-фамилия часто встречаются среди людей "в массе живущих на пособиях, в неблагополучных районах, долбящим крэк, совершающим мелкие правонарушения".

Я честно решил проверить и поискать, верно ли изначальное утверждение, и пошёл по ссылкам. Далеко вниз уйти не получилось, вот эта статья AP News, и дальше прямых никаких ссылок нет, но из неё вообще никак нельзя сделать вывод, что ИИ принимал какие-то решения на основании имён и фамилий. Напротив, говорится напрямую про такие метрики, как кредитная история, основные источники дохода (gig workers), наличие наследства, и историческая несправедливость в размещении "payday loan sellers' branches". Где всё перечисленное "suffers from historical injustices". А ещё:

In written statements, Fannie Mac [компания, участвующая в выдаче тех самых ипотек] said its software analyzes applications "without regard to race" and both Fannie and Freddie said their algorithms are routinely evaluated for compliance with fair lending laws, internally and by the FHFA and the Department of Housing and Urban Development.

<...>

Crystal Marie and Eskias McDaniels' lender denied race had anything to do with their denial. In an email, loanDepot vice president of communications Lori Wildrick said the company follows the law and expects "fair and equitable treatment" for every applicant.

--[прим.: McDaniels для меня вообще звучит как шотландская фамилия, а Crystal и Marie — не являются, насколько я знаю, "чёрными" именами. Разве что Eskias как-то можно сюда притянуть с точки зрения конкретно имени, оно для меня незнакомое. Хотя, имена наверняка изменены, и в оригинале может быть и было, за что зацепиться.]Исходя напрямую из того, что в статье написано, получается, не так, что ИИ вычислил расу по имени, а скорее так, что ИИ как раз не знал о расе просителей ипотеки, и потому не сумел правильно "скомпенсировать историческую несправедливость". Ну а основная идея статьи как раз ровно та же, что и у этой статьи на Хабре — "мы не знаем, как работает этот алгоритм, но нам не нравятся его результаты".

rg_software

24.11.2022 01:37+2Вся эта тема с bias elimination обычно переходит к разговору о кредитах или найме на работу и дальше начинается околополитический дискурс, уводящей от сути проблемы. Не так давно на CACM проскакивала статья, где приводился пример попроще и получше. Допустим, нейросеть изучает эмоциональную окрашенность слов по текстам в интернете, и выясняет, что "Ричард" звучит лучше, чем "Ахмед". На этом этапе можно сказать, что ну вот таков мир, и чинить надо мир, а не нейросеть, окей. Проблемы начинаются, когда мы пытаемся применить нейросеть на конкретных задачах, где "общемировой контекст" может быть неинтересен. Например, мы пытаемся определить эмоциональное отношение к фильму и читаем отзывы зрителей. При этом получится, что отзыв со словом "Ахмед" имеет куда больше шансов оказаться помечен как негативный. Тот ли этот результат, на который рассчитывает проводящий исследование? Маловероятно. То есть мы получаем кривой ответ на свой вопрос и на его основании делаем кривые выводы.

IKStantin

23.11.2022 18:36-4На больших числах статистически значимых флуктуаций быть не может. И если по большой статистике люди с именем Всеволод чаше употребляют наркотики, значит между именем и потреблением есть связь.

Kanut

23.11.2022 18:38+7Нет. Есть корреляция. И это всё-таки немного другое. А вот наличие связи сначала надо доказать.

playermet

23.11.2022 18:53Для ИИ это не имеет значения. У ИИ цель - максимизировать прибыль отсеивая риски, и он с ней справляется.

Kanut

23.11.2022 18:58+1Самый простой способ отметить риски это вообще никому не давать кредиты.

И совсем не факт что такой ИИ хорошо отслеживает риски. Ведь если он по имени-фамилии принимает хорошего кандидата за плохого, то где гарантия что он не ошибается и в обратную сторону? То есть не даёт займы некредитоспособному с "правильными" именем и фамилией?

Решать такие вопросы при помощи статистики это возможно самый простой или даже дешёвый способ. Но это не значит что это оптимальный способ.

playermet

23.11.2022 19:43+2Самый простой способ отметить риски это вообще никому не давать кредиты.

максимизировать прибыль

Ведь если он по имени-фамилии принимает хорошего кандидата за плохого

Во-первых выше уже углубились в источники, и оказалось что в оригинале ничего про фамилии и имена нет. Во-вторых, даже если результат не справедлив к конкретному человеку, это еще не значит что ИИ выдает некорректный результат для имеющихся входных данных. Это не ИИ работает неправильно, это задача поставлена так, как было выгодно.

Kanut

23.11.2022 20:07максимизировать прибыль

Ну да. И для этого надо давать кредиты.

Это не ИИ работает неправильно, это задача поставлена так, как было выгодно.

"Выгодно" это когда кредит получают все кредитоспособные, которые хотят его получить.

IKStantin

23.11.2022 20:20+1Выгодно - это когда соотношение кредитоспособных и некредитоспособных минимально. С определенными весовыми коэффициентами

playermet

24.11.2022 14:10это когда кредит получают все кредитоспособные, которые хотят его получить

Нет таких наборов данных для которых это можно определить точно, максимум оптимально. Так-то, некоторые умирающие от рака 80-летние наркоманы с десятью отсидкамии без образования тоже вернут кредит, только вот отличить их от остальных заранее никак не получится. И вполне может оказаться, что безусловная блокировка некоторых районов гетто может быть оптимальной алгоритмически.

Cr0zz

23.11.2022 23:24-2максимизировать прибыль

Не совсем. В первую очередь, увеличить капитализацию компании, во-вторую, закабалить побольше людей, в-третью, обеспечить устойчивость пузыря, в-четвертую, показать важность и обеспечить премиями отдел разработки ИИ. Ну и прибыль где-то между ними.

IKStantin

23.11.2022 18:57+1С замечанием частично согласен. Возможно причинно-следственной связи нет. Но, например, это имя пользуется особой популярностью у определенного криминального элемента, в честь какого-нибудь авторитета.

Kanut

23.11.2022 19:04+1Но при этом у вас могут быть люди получившие своё имя по какой-то другой причине. И об этом и речь: статистика хорошо работает на больших числах. Но не особо хорошо в конкретных единичных случаях.

Ну то есть как известно по статистике у среднего человека одна грудь и одно яйцо. Много вы таких людей знаете?

IKStantin

23.11.2022 20:17-1Разумеется, какая-то часть нормальных Всеволодов будет ущемлена необоснованно. Но в целом для системы, это оправданная жертва. Особенно, если ему все но лишь не дадут кредит.

Тут же вопрос не жизни и смерти, как в средние века или при Сталине - лучше случайно убить несколько невиновных, чем упустить виновных.

Статистика про одну грудь и яйцо вообще не к месту - ИИ уж точно эти взаимосвязи найдет на первом десятке моделей.

Kanut

23.11.2022 20:21+2Разумеется, какая-то часть нормальных Всеволодов будет ущемлена необоснованно. Но в целом для системы, это оправданная жертва.

Угу. Так многие считают. Ну пока не оказывается сами таким вот "Всеволодом".

Статистика про одну грудь и яйцо вообще не к месту - ИИ уж точно эти взаимосвязи найдет на первом десятке моделей.

Это гипербола.

mayorovp

24.11.2022 09:07Тут есть ещё одна ловушка: двойной учёт факторов.

Предположим, что потенциальный клиент принёс справку о том, что он наркотиков не употреблял. Ну, должен же быть способ установить этот факт достовернее чем на основе косвенных признаков вроде имени. Так вот, начиная с этого момента корреляции с именем работать перестают, и оснований считать его наркоманом — нет.

Однако, "стандартному" нейросетевому ИИ этого не объяснить, и он продолжит учитывать имя даже при наличии справки. Точнее, объяснить-то можно, но только через включение в обучающую выборку достаточного количества Всеволодов со справкой, чего наверняка сделано не будет (ведь если бы мы заранее знали ВСЕ подобные закономерности — то могли бы собрать известную из древности экспертную систему, а не прибегать к нейросетям).

BlackMokona

24.11.2022 14:26Можно сделать два уровня нейросетевого анализа. Сначала например выдаётся на основе всей доступной информации профиль клиента(например сетка которая выдаст с какой вероятностью человек наркоман и тд). А потом от этого профиля уже считается конечный результат. Таким образом специалист с помощью справок и прочего сможет вмешиваться в работу системы и она станет куда более прозрачной

Vsevo10d

23.11.2022 22:36+1Я вашу точку зрения разделяю. Но мы с вами говорим об ортогональных вещах.

Я, не отрицая несовершенства нейросети в данном случае, выступаю резко против наделения ее свойствами, присущими только человеческой мотивации - например, "расизмом". Нет намерения оскорбить или дискриминировать - нет и расизма, это очевиднейшая вещь, а попытка педалировать эту атрибуцию и вешать ярлыки вызывает только подмену понятий, и с определенного момента вы не переспорите ширнармассы, подхватившие это ложное в корне определение.

Теперь то, что обсуждаете вы. Да, нейросеть может отказать по причинам, сходным с дискриминационным. И тут важно не то, как на это реагирую я, а как это влияет на бизнес. Глупый бизнес потеряет часть дохода из-за такой неоптимизированной нейросети. Крупному бизнесу или бизнесу на устойчивых госзаказах будет по барабану на индивидуальные кейсы частников с улицы. Бизнес, ставящий во главу угла репутацию, постарается как можно сильнее оптимизировать нейросети, или вообще от них откажется. Но ни в одном из этих сценариев мое мнение значения вообще не имеет. В здоровой экономике, если я оскорбился, я просто уйду к конкурентам.

Kanut

23.11.2022 23:09Ну я так понимаю что в общем-то взгляды у нас схожие и особо спорить не о чем.

Единственное что для того чтобы кого-то дискриминировать совсем не нужны намерения. Дискриминировать может и алгоритм. То есть вот именно "расистом" ИИ быть не может. А дискриминировать кого-то по расовым признакам вполне.

transcengopher

24.11.2022 15:00Единственное что для того чтобы кого-то дискриминировать совсем не нужны намерения. Дискриминировать может и алгоритм. То есть вот именно "расистом" ИИ быть не может. А дискриминировать кого-то по расовым признакам вполне.

Точно так же, как сама по себе дискриминация вообще не носит никакой внутренней моральной оценки, потому что дискриминация — это только отделение одного от другого. Американцы, как общество, заключили, что дискриминация конкретно по расовому признаку — это плохо (и то с оговорками, потому что иначе расовые квоты в университетах придётся отменять), это верно.

Но как я уже замечал выше, в оригинальной статье нет признаков явной алгоритмической дискриминации по расе заявителя. Напротив, это сам заявитель, получив предварительный отказ, тут же задался знаменитым вопросом — "это потому, что я чёрный?" И в результате, кстати, к делу подключились шишки чуть ли не федерального уровня, и проблему отказа решили вообще в ручном режиме.

Kanut

24.11.2022 15:35Точно так же, как сама по себе дискриминация вообще не носит никакой внутренней моральной оценки, потому что дискриминация — это только отделение одного от другого.

Абсолютно верно. Дискриминация может быть вполне себе легитимной.

Американцы, как общество, заключили, что дискриминация конкретно по расовому признаку — это плохо

Тут скорее дело в том что большинство западных стран решило что дискриминация исключительно по принадлежности к какой-то группе это плохо.

То есть "дискриминировать" можно только на основании релевантных личных качеств. Это тоже далеко не всегда так работает(например совершенолетие определяется по возрасту, а не по действительному уровню развития), но к этому пытаются стремиться.

zlat_zlat

24.11.2022 08:19Ну, всё же изначально дискриминация существовала в виде «Вася белый, Алехандро не очень, значит в школу пускать только Васю». От этого можно избавиться автоматизацией. А вот можно ли избавиться от того, что Алехандро теперь не дадут ипотеку и не возьмут на работу, потому что до этого их не брали в школу, и статистически менее образованы - вероятно, нет.

iingvaar

23.11.2022 17:48+6Когда кто-то хочет добиться непредвзятости в отношении социальных меньшинств, то это означает, что он хочет добиться предвзятости в отношении большинства. Возможно, это правильно, и меньшинствам нужно искусственно улучшать стартовые условия, пока они остаются меньшинствами. Но тогда не нужно врать.

IKStantin

23.11.2022 18:42+1Да, ИИ просто доказал и так очевидное для многих - гендерные, расовые и национальные различия существуют. И, кмк, если проверить через ИИ теорию Чезаре Ломброзо, то наверняка найдется значительная корреляция.

iingvaar

23.11.2022 20:12+2Более того, существуют и другие различия - возрастные, урбанистические, финансовые, и еще миллион. И если стоит вопрос о репрезентативности, то в выборке должны быть представлены в естественных пропорциях все миллион "меньшинств". А это декартово произведение. Причем самые мелкие из них должны быть представлены еще и в достаточном для статистики количестве. Поэтому репрезентативность здесь - это утопия. Она же не является целью, целью общества (но не бизнеса) является справедливость. И то, что справедливость достигается репрезентативностью, это смелая, но непроверенная гипотеза. Справедливость - это ликвидация положительных обратных связей, чтобы не было "the poor stay poor, the rich get rich". Вот в этом направлении и нужно двигаться, а не строить социальные рейтинги. Завели миллион метрик и смотрим, где возникают петли. И учимся оперативно устранять.

vassabi

24.11.2022 01:34Справедливость - это ликвидация положительных обратных связей, чтобы не было "the poor stay poor, the rich get rich".

вот тут по-видимому есть еще над чем поработать :

1) я не думаю, что вы хотите ликвидировать обратные связи. Ничего хорошего с этого точно не получится

2) нужны взаимодействия по схеме игр с ненулевой суммой, чтобы и "the rich get rich" и "the poor get rich" тоже

iingvaar

24.11.2022 08:07+2Конечно, не хочу, я и не писал об этом. Я только против положительных обратных связей, и то не всегда. Мне нравится, что каждый следующий доллар зарабатывается немного проще предыдущего. Но мне не нравится, что попасть в начало этого ряда чертовски сложно. Это именно черта бедности, в математическом смысле, бифуркация. Те, кто за ней, не имеют шансов на выход, кроме чуда. Мир должен быть спроектирован так, чтобы выход из ямы был очень простым и доступным. Дальше те, кто "нЕ жили богато, не#ер начинать", могут оставаться на комфортном им, но не скотском уровне. Те, у кого есть креативность, должны попасть в легкую положительную петлю, что придаст им азарта и сил. Эта петля должна где-то закончиться, чтобы избежать такого дикого расслоения, какое сформировалось сейчас.

larasage

24.11.2022 07:58+1Из-за таких ошибок (когда сначала ошибается ИИ, а потом ещё и попадается свидетель с плохой памятью на лица) в тюрьмах сидят сотни невинных людей.

А это написано автором для усиления хайпа или имеет какие-то документальные подтверждения?

Akon32

24.11.2022 09:48Когда ИИ, основанный на статистике, запрещает выдачу кредита людям с определёнными фамилиями, проблема не в ИИ. Проблема в обществе, в котором есть такое расслоение, что целые семьи поколениями не могут выбраться из трущоб и неплатёжеспособны. Статистика это "замечает", а результаты ИИ лишь подсвечивают эту проблему. Правда, ИИ эту проблему не решает...

Хотя финансовое расслоение в США - не новость. Индекс Джини там в последние лет 30 довольно высокий.

По поводу плохого распознавания лиц некоторых рас - ну так обучающая выборка должна быть репрезентативной. Иначе статистика начинает "врать", и ИИ не работает.

ksbes

24.11.2022 11:07+2По поводу плохого распознавания лиц некоторых рас — ну так обучающая выборка должна быть репрезентативной. Иначе статистика начинает «врать», и ИИ не работает.

С неграми даже реперзентативная выборка не очень спасает:

1) у них низкий динамический и цветовой диапазон. Т.е. с точки зрениа цвета — это белых должны называть цветными — перепадов цветов и яркостей сильно больше. А для сетки это важно.

2) у них очень сильное различие между собой. Очень больше разнообразие черт — биологическая эволюция в африке ушла вперёд относительно остального мира. Т.е. сетка, которая научилась хорошо распозновать нигерийцев может вообще не распознавать зимбабвийцев.

Т.е. желательно как-то специально доучивать именно на разных неграх. Или иметь именно нерепрезентативную выборку с сильным «негитянским» перекосом.

phenik

24.11.2022 10:42+1Мы не видим, что происходит внутри черного ящика, но, тем не менее, можем активно пытаться улучшить контент внутри. Сделать так, чтобы система научилась понимать наши ценности.

Гы-гы… вперед к экспертным оценкам и системам) помнится занимался подобным статистическим обучением еще в 90-х годах прошлого века. Врачи, как эксперты должны были обучать систему распознавания параметров электрофизиологических сигналов с помощью выделения характерных точек на них. Результаты не впечатлили. Эта проблема в то время обсуждалась активно, кого можно считать экспертом, и что этот вообще такое — экспертное решение? См. обзор на эту тему, работы Дрейфуса имевшие широкий резонанс. Эти проблемы были одним из мотивов перехода от символического ИИ к коннективистским моделям, где такое влияние человека, при подготовке большой обучающей выборки, как казалось, представлялось меньшим злом.

iBuilder

24.11.2022 10:48+1Читайте классику - Станислав Лем эту проблему рассмотрел с точки зрения "философии" ещё до появления нормальных ЭВМ. И так рассмотрел, что до сих пор актуально. Кто не в курсе - «Сумма технологии», написано было в 1963 году. Про "ящики" там тоже было много написано.

Kilorad

Во-первых, высказывание, что нейросети похожи на мозг - это маркетинговая уловка. Они на заре существования были похожи на мозг, а сейчас это дифференцируемые вычислительные графы, в которых нет такой концепции, как нейрон.

Во-вторых, черноящичность вытекает не только из применения нейросети, а ещё из характера задачи. Мы говорим компьютеру: найди формулу, которая отличает такие-то штуки от таких. Если бы формула была простой и маленькой, мы бы и так её нашли. Но эти данные плохо описываются короткой формулой - и потому компьтер строит сложную формулу. А мы ещё не можем потом прочитать, так как она имеет размер в пару гигабайт. Это была ожидаемая ситуация, и она акутальна не только для нейросетей.

В любом случае, есть способы улучшить "подконтрольность" нейросети, не заглядывая внутрь. Можно задавать ей правильные вопросы и смотреть, что она отвечает. Например, если мы хотим узнать, почему она человека такого-то считает фродером, можно подвигать данные по этому человеку (чуть-чуть поменять их в разные стороны) и посмотреть, на какие из фичей самая сильная реакция. Или можно взять эмбеддинг (внутреннее состояние одного из слоёв) и поискать другие экземпляры данных с тренировочной выборки, у которых похожий же эмбеддинг.

Или, если нейросеть нам рекомендует нечто, мы можем спросить её: а что конкретно будет, если мы последуем этой рекомендации? А если сделаем иначе - что изменится?

Насчёт обучения с подкреплением - хорошо бы учитывать, сколько это стоит по данным. Самое быстродействующее RL, что мне известно, начинает действовать лучше рандома где-то на стотысячном действии. Вручную разметить столько наград - ну не знаю, сомнительно. В оффлайне это обучить (то есть на данных наблюдений, а не экспериментов, идущих вот-прям-щас) тоже не факт, что выйдет.

Goupil

В машинном зрении также применяются salient maps и feature maps. А касательно мозга, нейросетки никогда не были похож на мозг. Первые из них были вдохновлены тогдашними нейромоделями, которые никогда не охватывали работу всего мозга, а лишь отдельных его отделов. Нейрон нейросетки и нейрон мозга не сводятся к одному и тому же.

Kilorad

Да, есть локальные решения по повышению интерпретируемости, которые частично пригодны для некоторых областей, например, для работы с графикой. Применение этих методов сейчас ближе к искусству, чем к ремеслу - впрочем, то, что я описал выше, не особо лучше.

phenik

Настолько успешно, что до нюансов воспроизводят, например, возникновение чувства численности. И такие примеры можно еще привести. Поэтому нельзя сказать, что это только маркетинговая уловка. Немалая истина в этом есть, но и в другом также имеется, это упрощенные модели биологических нейронов и сетей, по той даже причине, что реальные возможности биологических нейронов моделируются целыми нейросетями, см. 1, 2, 3. А биологические регулируются дополнительно с помощью нейромедиаторов. Использование аппаратных ускорителей и оптимизация вычислений ничего в этом плане не меняет. Не исключено, исходя из соображений энергетической эффективности, со временем технологическая эволюция этих решений постепенно сольется с нейроморфным подходом, или останется нишевым решением.

Kilorad

Понятно, что можно сделать более похоже на нейрон. Но в чём конкретно профит? Он же измеряется не в энергоэффективности (сколько там стоит месяц работы нейросети в сравнении с ценой сервера, на котором её обучали?), а либо в меньшем loss, либо в менее дорогой видеокарте, либо в более быстром процессе обучения. Правда ли импульсные нейросети лучше по этим характеристикам? И если да, то почему не вытеснили дифференцируемые графы, как в Торче?

Что свёрточные похожи на зрительную кору - согласен. Но сейчас SOTA в этой области - трансформеры, которые не особо биологичны

phenik

Никто не требует, и это бессмысленная затея, все реализовывать с помощью только технологии нейросетей)

michael_v89

Общего на этой картинке только то, что и там и там несколько уровней обработки информации. Несколько слоев сами по себе это не архитектура, архитектура это то, как передается и преобразуется информация между ними. На данные момент неизвестно, как обрабатывается информация в "областях вентрального тракта". Поэтому ваше утверждение неверно и бессмысленно, непонятно, почему вы везде про это говорите.

Kilorad

Многослойность плюс рецептивные поля. Вроде действительно стянули идею у живых организмов.

Иногда что-то действительно делают через бионику, иногда это становится SOTA

michael_v89

Это не делает утверждение верным, что архитектуры подобны потому что они состоят из нескольких шагов.

Многослойность это довольно очевидная вещь, любой сложный алгоритм состоит из нескольких шагов. Рецептивные поля сами по себе тоже — раз мы можем выделять один и тот же объект в разных положениях на видимой области и отслеживать несколько объектов, значит она как-то разбивается на более мелкие части. Вот первый шаг с круговыми ON-OFF полями это да, так сходу и не догадаешься.

aaa_bbb

Это не уловка, просто процесс настройки или калибровки весовых коэффициентов нейросети похож на обучение человека или животного. Чтобы "научить" нейросеть букве А нужно ей 100 раз "показать" букву А. Если ей потом не показывать букву А а 100 раз показать букву Б, то она научится букве Б, но забудет букву А. А чтоб она запомнила обе буквы, то их нужно показывать попеременно. (если собаку научить сидеть по команде, а потом учить только лежать, то она забудет команду сидеть, вот и сходство )

michael_v89

Нет.

Kilorad

Настрока коэффициентов нейросети технически не очень похожа на то, что происходит у живых существ. В живых нейросетях нет обратного распространения ошибки и нет некоего внешнего по отношению к сети алгоритма, который обучал бы её (по крайней мере из того, что пишут нейрофизиологи, этот алгоритм не следует).

В ИНС используется концепция дифференцируемого вычислительного графа, а не отдельных нейронов - то есть это по сути программный код с параметрами, абсолютно любой программный код, лишь бы можно было взять производную.

Трансформер, который сейчас SOT на многих задачадх, довольно далёк от биологической нейросети.

Ну и используются эти системы по-разному: основной сценарий применения ИНС - это апроксимация, а основной режим работы живой нейросети - это система управления.

Это не что-то плохое: ИНС делаются в первую очередь для задач бизнеса. Решение задачи важно, соответствие биологическому аналогу - по боку.

phenik