В этом году улучшение моделей стало приоритетным на уровне всей компании. Внутри эта работа известна как проект «Генезис» или YaLM 2.0. Её результатом стал большой скачок в качестве наших моделей.

Новая модель получила название YandexGPT (YaGPT), вы могли впервые попробовать её в Алисе по запросу «Давай придумаем» чуть больше двух недель назад. Сегодня мы обновили YaGPT: Алиса научилась писать ответы с учётом истории предыдущих сообщений. В честь этого хотим рассказать Хабру историю всего проекта. Уже в ближайшее время новая модель станет частью и других сервисов Яндекса.

Напомним про YaLM

В 2021 году мы впервые рассказали о семействе наших GPT-подобных языковых моделей YaLM. На тот момент в него входили модели от 1 до 13 млрд параметров. Позднее появилась модель на 28 млрд. Ну и наконец — та самая модель на 100 млрд, которую мы выложили в опенсорс в прошлом году. Мы применили YaLM в поиске для генерации кратких описаний объектных ответов, для поддержания диалога в Алисе и много где ещё.

Технически процесс обучения YaLM можно разбить на два последовательных этапа: Pretraining и P-tuning.

На первом этапе терабайты текста из интернета, книг и прочих общедоступных источников разбиваются на небольшие фрагменты и подаются в обучение модели. В процессе обучения мы заставляем модель угадывать следующее слово во фрагменте текста на основе всех предыдущих.

Чтобы успешно решать эту задачу, модель вынуждена выучивать как структуру языка (части речи, члены предложения, пунктуацию), так и факты о мире. Например, чтобы хорошо угадывать слова и числа в тексте «Скорость света в вакууме равна 299 792 458 метров в секунду» модель должна запомнить, чему равна скорость света. Именно Pretrain определяет «эрудицию» нейросети.

Второй этап рассмотрим на примере. Допустим, вы задаёте нейросети такие вопросы:

- «ответь покороче что такое радуга»,

- «ответь развернуто что такое радуга»,

- «ответь стишком что такое радуга».

Вы получите очень разные ответы на свои вопросы: префиксы «ответь покороче», «ответь развернуто» и «ответь стишком» сильно на них влияют. Предположим, пользователь спрашивает просто «что такое радуга». Тогда задача P-tuning в том, чтобы автоматически подобрать хороший префикс. Если дописать такой префикс к запросу пользователя, то ответ получится лучше.

Более формально: P-tuning — это дешёвый метод решить конкретную задачу. В этой статье мы рассказывали, как P-tuning применяется в быстрых ответах поиска.

Что мы сильно улучшили в YaGPT (YaLM 2.0)

Новые требования к Pretrain

Всё, что будет знать и уметь модель, закладывается в неё на этапе Pretrain. Раньше мы фокусировались на размере Pretrain-датасета, считая, если положить в него много данных, то и модель многое выучит. Сейчас же мы сфокусировались именно на качестве данных в датасете, это позволило значительно улучшить качество итоговой модели. Под качеством мы понимаем два важных требования к датасету.

Во-первых, требование к полноте фактов. Мы взяли реальный поток запросов наших пользователей и собрали такой датасет, который содержит ответы на большинство из них. Для оценки качества мы даже подняли отдельную, внутреннюю версию поиска Яндекса по датасету претрейна. Так мы убеждаемся, что у модели есть возможность выучить все полезные знания о мире.

Во-вторых, к чистоте данных. Бесполезные тексты вхолостую тратят время на обучение и учат модель неправильным фактам и знаниям. Представьте, что в Pretrain будет запись «Скорость света в вакууме равна 999 метров в секунду». Такие данные просто портят модель, заставляют её учить ошибочные знания. Бороться с источниками такого мусора — важная часть подготовки данных. Для YaGPT нам удалось сократить количество некачественных данных в pretrain-датасете в 4 раза.

Создание большого Alignment-датасета и использование Fine-tuning вместо P-tuning

P-tuning хорош тем, что позволяет быстро решить конкретную задачу, но обладает важной проблемой — у него есть ограничение в качестве. Это связано с тем, что P-tuning оптимизирует тысячи параметров (инпутов модели). Как в них уместить всю глубину личности Алисы? Все факты о ней, её историю, её предпочтения? А ведь кроме хранения фактов о персонаже, P-tuning должен ещё научить модель красиво отвечать на произвольный запрос, не грубить и многое другое.

Чтобы научить модель всему этому, мы собрали большой датасет из сотен тысяч примеров с хорошими ответами включающий все аспекты, указанные выше. Для такого количества данных лучше подходит Fine-tuning. Это такой же процесс обучения, как и обучение на Pretrain. Он оптимизирует миллиарды параметров модели. Такое обучение сложнее, чем P-tuning, требует большой обучающей выборки, но результат получается лучше.

Fine-tuning: максимально разнообразные инстракты

Важно, чтобы в датасете для Fine-tuning были представлены примеры максимально разнообразных задач (такие задачи ещё называют инстрактами). Чем больше разных задач будет собрано, тем лучше получится модель. Но собрать их не так просто. Попробуйте придумать хотя бы сотню непохожих друг на друга просьб к Алисе. Скорее всего, многие вопросы окажутся однообразными.

Чтобы собрать большое количество разнообразных инстрактов, мы распараллелили эту работу: часть добыли из запросов в поиск, другую — из обращений к Алисе. Кроме того, бросили клич внутри компании и получили десятки тысяч подобных задач от неравнодушных коллег.

Fine-tuning: качественные ответы на инстракты

Очень важно, чтобы все ответы на собранные инстракты были максимально качественными. Для обучения модели нужны сотни тысяч таких ответов. Их написание — это очень масштабная задача, потому что от людей требуется каждый раз разбираться в незнакомой для себя области. На это может уйти и час, и два. У такой необычной для России специальности уже даже существует название — AI-тренер. С этого года мы ищем таких людей. Около ста AI-тренеров уже помогают нам готовить ответы на инстракты. Кроме того, мы воспользовались нашим опытом в краудсорсинге и привлекли более тысячи асессоров в помощь тренерам.

Отдельный повод для гордости — наш внутренний марафон. Мы обратились ко всем нашим коллегам через Этушку (внутренняя соцсеть), хурал (аналог All-hands meeting), корпоративную рассылку и объявили марафон по написанию эталонных ответов на инстракты для последующего обучения модели. За одну неделю 826 участников написали для нас более 36 тыс. ответов! Вы можете заметить, что мы уже во второй раз за статью упоминаем коллективную помощь наших коллег. Активная, массовая помощь яндексоидов, которые даже не были связаны с проектом, позволила нам повысить качество модели и быстрее запустить проект.

С помощью AI-тренеров, асессоров и коллег из других направлений нам удалось собрать несколько сотен тысяч ответов на инстракты. Примерно половина из них оказалась достаточно качественной и легла в основу датасета.

Последовательность обучения

Не все люди пишут одинаково хорошо. Хороших ответов значительно меньше, чем остальных, но они ощутимо лучше. На практике хорошо сработала схема, при которой более качественные тексты передаются на обучение на более позднем этапе, а не смешиваются в одну большую кучу.

Наша лучшая схема на момент старта в Алисе

Как мы внедряли YaGPT в Алису

Учим модель быть Алисой

Примерно месяц назад у нас обучилась базовая модель YaGPT. Мы начали тестировать её всей командой и быстро убедились, что модель классная, но внедрять её в Алису нельзя. Требовались продуктовые доработки. Например, модель не знала, что она Алиса (не могла назвать своё имя, своих создателей, интересы и многое другое).

Чтобы научить модель быть Алисой, нужно собрать датасет с вопросами вида «Как тебя зовут», «Кто тебя создал», «Что ты любишь» и ответами на них. Для упрощения этого процесса мы придумали хитрость.

- Собрали список таких вопросов об Алисе.

- С помощью YaGPT сгенерировали множество других похожих вопросов.

- Написали подводку, кратко описывающую личность Алисы с просьбой ответить от её имени на вопрос.

- Задали сгенерированные вопросы YaGPT, используя подводку.

В итоге получили пары вопрос-ответ, из которых сформировали новый датасет и дообучили на нём модель. Наша модель частично обучила сама себя!

17 мая мы выкатили эту модель в виде навыка «Давай придумаем» в Алисе.

Учим модель работать с контекстом

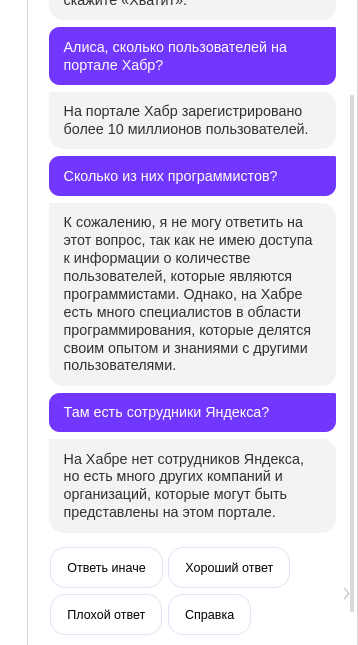

Сегодня мы выпустили первое большое обновление для YaGPT в Алисе. Наша модель научилась учитывать историю диалога при написании ответов. Это полезно, потому что позволяет доуточнить свою просьбу.

Оказалось, что наша базовая модель YaGPT уже сразу после обучения неплохо умела работать с контекстом. Возможно, из-за того, что какие-то диалоги оказались в претрейне, возможно, из-за разнообразия задач Fine-tune модель научилась совсем новым задачам. Навыки диалога проверяли так: переписывались с моделью и в каждом сообщении посылали на вход весь предыдущий диалог. Модель отвечала разумно.

Главной проблемой оказалось то, что она слишком сильно цепляется за контекст и не понимает, что он изменился. Нужно было научить модель игнорировать часть истории сообщений. Для этого мы сцепили несколько не связанных запросов с ответами в один диалог и учили модель предсказывать последний ответ. Так модель выучила, что иногда контекст может мешать.

Кроме того, мы дообучили модель на диалогах, которые выложили в опенсорс участники проекта Open Assistant.

Другая задача, которую мы должны были решить, — поиск баланса между длиной контекста и скоростью генерации ответов. Если ответ пишется долго — это плохо, потому что пользователи ожидают от Алисы мгновенной реакции. Наша модель YaGPT умеет работать с 8 тыс. токенов (это примерно 40 тыс. символов) на входе. В продакшене контекст такой длины приведёт к значительному ожиданию ответа. К счастью, обычно такая длина и не нужна. Поэтому сейчас модель учитывает 2 тыс. токенов (10 тыс. символов) или 50 отдельных запросов (в зависимости от того, какой лимит будет достигнут раньше). Это значительно ускоряет ответы модели.

Завершение

В этом году мы проделали огромную работу над качеством наших моделей. Но этот пост не про завершение проекта, а про начало большого пути. Запуск YandexGPT в Алисе это лишь первое внедрение. И вот что мы будем делать в будущем.

1. Продолжим улучшать качество наших датасетов (Pretrain и Fine-tune).

2. Внедрим новый этап обучения — RLHF.

3. Обучим модели больших размеров (для исследований и применения в офлайне).

4. Вложимся в количество AI-тренеров. Мы верим, что в будущем обучение языковых моделей нового поколения невозможно без помощи подобных специалистов.

5. Внедрим YaGPT и в другие наши сервисы.

Комментарии (74)

cry_san

05.06.2023 07:41+2Потискать YandexGPT кроме как с Алисой где-нибудь еще можно?

hommforever Автор

05.06.2023 07:41+5Пока нет, но следите за новостями. У нас большие планы.

Flux

05.06.2023 07:41+3А есть ли среди этих планов выпуск в опенсорс моделей вменяемого размера?

hommforever Автор

05.06.2023 07:41+1Пока говорить об опенсорсе рано, так как наша новая модель находится в активной стадии разработки. В планах большие изменения как на уровне датасетов, так и в стадиях обучения.

simenoff

05.06.2023 07:41Код умеет писать?

hommforever Автор

05.06.2023 07:41Немного умеет, но целенаправленно в эту сторону мы пока её не тренировали. Можно попробовать, время от времени у модели получается решить задачу.

WellMOR

05.06.2023 07:41Я правильно понимаю, что обучая модель в одну сторону, мы ухудшаем параметры другой? Т.е. не получится совместить идеального писателя и программиста в одной модели. И, если так, разумно ли разделять их в разные и делать модель-классификатора, которая бы выбирала какую стоит использовать?

Сорри, если вопрос слишком дилетантский :)

hommforever Автор

05.06.2023 07:41У нас есть вера в то, что базовая модель должна быть максимально эрудирована во всех областях. Тогда на её основе легко можно будет решить любую задачу.

А по предложенной архитектуре, если честно, то нам самим не понятно, сработает ли она.

cadovvl

05.06.2023 07:41+1Вопросы по возможностям.

Обучение на разных языках? Можно будет попросить переформулировать фразу на другом языке?

Насколько полученные фразы будут похожи на исходные тексты? Есть ли риск нарваться на такой же плагиат как в шедевруме?

Факт-чек: насколько хорошо модель натренерована проверять корректность фактов? Будет ли она, рекомендуя книгу, давать название одной, автора другой, а сюжет третьей, просто потому, что с точки зрения языковой модели получается стройная фраза?

forthuse

05.06.2023 07:41Да, с названием книг и авторов к выдаче — это эпичный фейл от нейронки, как и ссылки на несуществующие проекты, к примеру, сайта Github. :)

Показываешь ей список книг с Википедиа — запоминает, а потом всё благополучно забывает, чему в принципе есть объяснение.

Такой у нейросеток — перманентный "День сурка".P.S. То, что они пытаются даже просто по одной предоставленной ссылке в качестве запроса выдать неизвестное им содержание, думаю, даже нет смысла упоминать.

cadovvl

05.06.2023 07:41Справедливости ради, я с такими проблемами с ChatGPT сталкиваюсь. Конкретно с соответствием название-книга-сюжет. А вот если просишь дать описание персонажа - работает хорошо.

MAXInator

05.06.2023 07:41+1Будет ли она, рекомендуя книгу, давать название одной, автора другой, а сюжет третьей, просто потому, что с точки зрения языковой модели получается стройная фраза?

Видимо, будет. Мне она сказала, что в "Побеге из Шоушенка" снималась Джуди Фостер в роли Энни Уилкс. Тим Роббинс же сыграл в нём Рея Бредберри.

inkelyad

05.06.2023 07:41"Расскажи мне про трансформеры"

И снова, так же как в поиске, оно не уточняет, которые трансформеры я имею в виду.

Товарищи создатели-прикручиватели ИИ к чему угодно, когда научите, а?

DimaM

05.06.2023 07:41+1Почему в статье выше на вопрос "Придумай колючку" в ответе yagpt не было ни одной колючки ?

hommforever Автор

05.06.2023 07:41Подобно человеку, модель догадалась, что на самом деле имел ввиду пользователь.

Pusk1

05.06.2023 07:41Результат пока заметно не дотягивает до chat GPT 3.5, но появление контекста порадовало. Диалог держит и отвечает на уточняющие вопросы. Общаться с Алисой стало местами интересно.

Интересно, насколько будет рабочей стратегия собирать тексты только на русском? Количество готовых или легко генерируемых быстро кончится, но для ответов на повседневные вопросы может хватить.

Le0Wolf

05.06.2023 07:41+6А это точно именно ваша собственная разработка, а не тюненый ChatGPT? Как минимум на один вопрос был ответ слово в слово, как отвечал ChatGPT

hommforever Автор

05.06.2023 07:41+4Да, это точно наша собственная разработка. ChatGPT не используется ни в виде API, ни в виде его ответов в обучающей выборке.

Yuriks111

05.06.2023 07:41+5Было бы интересно что такое YaGPT внутри

Это одна из opensource архитектур LLaMa, BERT, GPT.. или своя?

Веса - полностью обучили с нуля или finetune?

Сколько параметров, хотя бы порядок

...т.п.

Это не троллинг а действительно интересно

За статью спасибо

domix32

05.06.2023 07:41+3Например, модель не знала, что она Алиса (не могла назвать своё имя, своих создателей, интересы и многое другое).

То есть вы решили захардкодить информацию в саму сеть, а не как Open AI - оборачивает промпт пользователя в некоторый набор фактов? А ля

ты алиса - голосовой помошник от яндекса ты не знаешь последних новостей ты не используешь в речи нецензурные слова ..... {USER PROMPT}

hommforever Автор

05.06.2023 07:41Мы попробовали отвечать всегда с подводкой, но тогда модель начинала чаще отказываться отвечать на вопрос, даже не касающийся ее личности.

denn70

05.06.2023 07:41+5Хотелось бы API, по аналогии того, что есть у chatgpt. У вас не планируется такое? Пользуюсь api вашей озвучки, ваш ГПТ было бы идеально добавить. Ибо сейчас Yandex SpeechKit у меня в проекте озвучивает chatgpt, что не очень удобно

Enfriz

05.06.2023 07:41+1На мой взгляд просто болтать с моделью не так ценно, уже более менее все наболтались. Нужно подключать её к практическим задачам с помощью API и других инструментов. OpenAI не так просто выкатили плагины с узкоспециализированным назначением, типа "Залей в модель PDF и оно тебе ответит на вопросы по ней".

Так что, имхо, вам следовало бы сделать первым приоритетом именно создание интерфейсов для практического подключения к чему-нибудь. Платных, разумеется, но я бы вот сходу подписку купил на такую штуку.

janvarev

05.06.2023 07:41+3https://huggingface.co/spaces/IlyaGusev/saiga_13b_llamacpp_retrieval_qa

Отечественный опенсорсный вариант "Залей в модель PDF и оно тебе ответит на вопросы по ней". В облаке правда может долго грузиться, но можно поставить себе на комп.

Ubudragon

05.06.2023 07:41+3а вы уже научили ее врать и скрывать данные про Путина?

TheRaven

05.06.2023 07:41+2Эту модельку еще в прошлом анонсе про крым поспрашивали — ничего не знает.

domix32

05.06.2023 07:41Учитывая насколько сложно построить достоверную фактологию про подобные регионы есть шанс, что оно даже в тренировочные данные не добавлялось. Не считая какой-нибудь очевидной фактологии касательно географии региона.

konst90

05.06.2023 07:41+2Немного поэкспериментировал сейчас. Либо намеренно не добавлялось, либо на них заглушка.

Она может рассказать про не очень известные города Маринга (Бразилия), Ньяла (Индия), Безенчук (Самарская область), Шмекино (Брянская область), Арканар (неназванная империя) и Осгилиат (Средиземье), но про Киев, Севастополь и Шебекино говорить отказывается.

Кстати, города Шмекино не существует

TheRaven

05.06.2023 07:41+1Заглушено.

Так же как у "кадинского" — если в промте есть слово "Украина" в любой вариации, то выдаёт ромашковое поле.

MAXInator

05.06.2023 07:41+1Как-то пожёстче даже. Отвечает на "Кто такие уральские казаки?", но не отвечает на "Кто такие донские казаки?". Хотя где родился Гоголь и кто такой Иван Франко - отвечает.

Weron2

05.06.2023 07:41Она в принципе отказывается отвечать на вопросы где есть слова русский или украинский, Россия, или Украина. Назвать самое большое озеро или город, или писателей. А озеро Балхаш у нее граничит с Узбекистаном. В общем там что-то мудрят, боятся задеть пользователя.... 5 самых больших городов в Казахстане может назвать, а в России сильно стесняется, не хочет обидеть)

Domorost

05.06.2023 07:41А чего не привели сравнения с ChatGPT? Обычно, когда вы своими алгоритмами хвастаетесь, то стараетесь этим рекламироваться, вспомнить тот же catBoost, а что пошло не так в этот раз?

shiru8bit

05.06.2023 07:41Опыт проверки нового функционала:

- Алиса, давай придумаем...

- Я это, конечно, умею. Но в другом приложении.

kukutz

05.06.2023 07:41А в каком приложении вы пробуете? Карты/навигатор?

shiru8bit

05.06.2023 07:41-1Да. Я про другие и не знаю. Алиса же не посчитала нужным сообщить, в каких она это умеет.

kukutz

05.06.2023 07:41Работает в приложении Яндекс, в Яндекс Браузере, на www.ya.ru и в колонках/телевизорах.

simenoff

05.06.2023 07:41Как в Яндекс.Браузере включить?

hommforever Автор

05.06.2023 07:41Кликнуть на Алису и сказать «Давай придумаем (кроме Линукса и Мака — там пока только на ya.ru).

shornikov

05.06.2023 07:41+2Может на фоне chatgpt, а может все силы брошены на новые горизонты, но яндекс-станция стала как-будто бы тупее, чем раньше.

BarakAdama

05.06.2023 07:41Расскажите, пожалуйста, в каких сценариях Станция стала отвечать вам хуже?

shornikov

05.06.2023 07:41+1Из сегодняшнего Алиса, что такое тертый калач? Блабла, а еще я узнала что такое тертый калач.

Теряет контекст при запросах погоды. Раньше при "а завтра" - продолжала. Теперь может вовсе "а чо завтра?"

avttrue

05.06.2023 07:41+1Да станция всегда была туповата. Например на запрос "включи радио/музыку завтра в 8 утра" отвечает "Ага" и на этом всё. Утром тишина.

AlexAV1000

05.06.2023 07:41+1Объясните, а какие требования по железу для уже обученной модели? Может ли это работать на ПК? Просто любопытно.

andreyiq

05.06.2023 07:41В Яндекс колонке это точно появилось или надо как-то обновить? Только купил ее, пытался с ней пообщаться, но контекст она не запоминает, в одном из диалогов, она даже сама сказала, что не поддерживает контекст. И вообще она довольно странная, переводческие вообще не отвечает, либо ответить на простой вопрос, просто отсылает в приложение. А первая настройка это вообще отдельное страдание

BarakAdama

05.06.2023 07:41YandexGPT работает, если сказать «Алиса, давай придумаем». То есть пока в отдельном сценарии.

shaggyone

05.06.2023 07:41А возможность сказать "Алиса позвони Маме" и получить ожидаемый результат уже сделали? Я с интервалом в год устанавливаю ассистент, пробую эту, базовую, на мой взгляд, функцию и удаляю.

TheRaven

05.06.2023 07:41Эм, вроде бы этот функционал есть в базовой поставке Гугл асистанта и эпловской Сири?

shaggyone

05.06.2023 07:41Есть, ваша правда. Я то том, что Яндекс активно продвигает Алису, в т.ч. и как ассистента для мобильников. Функцию управления плейлистом в Навигаторе зачем то сделали, одно время она конфликтовала с построением маршрута, а эту функцию почему то не делают.

BarakAdama

05.06.2023 07:41Да вроде как давно это есть :)

https://yandex.ru/alice/support/assistant/calls-with-alice.html

shaggyone

05.06.2023 07:41Я вспомнил что мне в прошлый раз не понравилось. Ассистент требует визуальный контакт. Учитывая что пользуюсь этим исключительно за рулём, не комильфо.

shaggyone

05.06.2023 07:41Пробую, если у контакта один номер требует тап на звонок, если насколько ещё и прочитать мелкий шрифт на экране. Гугл как минимум с 14 года справляется одним голосом (хотя в 14 году работал как по мне лучше)

Panzerschrek

05.06.2023 07:41+2Попытался позадавать вопросы этой нейросети. Судя по всему, она очень жёстко зацензурирована. Видимо как политические темы воспринимаются даже чисто энциклопедические вопросы, вроде "перечисли список президентов Франции".

Ну и, как это всегда бывает с подобного рода моделями, бред они выдают очень легко. Например, эта нейросеть утверждает, что дескать не существует квадратного корня из минус единицы.

konst90

05.06.2023 07:41Чему равен корень из единицы?

Корень из единицы не имеет точного значения в десятичной форме. Однако, он может быть приближен к числу 1.000 000... (с бесконечным числом нулей после запятой).

volchenkodmitriy

Недавно экспериментировал с ChatGPT 3.5 в Телеграме. И он не смог мне помочь в поиске. А вопрос был такой: "Найди фотографию Сильвестора Сталоне в 50 лет." А ваш помощник справится?

hommforever Автор

Сейчас YaGPT не подключена к поиску. Модель помогает сочинять тексты или генерировать идеи, но не искать контент. С поиском фотографий Сталоне отлично справится поиск Яндекса по картинкам.

forthuse

Когда то предлагал в службу поддержки поиска по картинкам Яндекс предложение: добавить возможность отображать изображения по поиску по сайту где основное его наполнение содержимым — текстовое, как по аналогии работает у Google. Ответили, что интересная идея, но как вижу не реализованная и сейчас.

P.S. Пример такого запроса на сайте Github на Яндекс поисковике

в сравнении с запросом на Google

чтобы было более понятно о чём написано выше.

(на других поисковых системах тоже могут быть отличия и хотелось бы чтобы выдаваемый контент не был ограничен в пролистывании его)

Думаю, и при задействовании технологий AI для такого запроса, результаты ещё более адекватно можно формировать, если обучить нейросеть анализу таких запросов на "изображениях"

dizatorr

Мне понравилась ваша модель, она такая выдумщица:

Вопрос: Что можно сказать про "Пикник на обочине" Стругацких?

Часть ответа: "Пикник на обочине", написанный Аркадием и Борисом Стругацкими, является одним из самых известных произведений в жанре научной фантастики. Это история о группе исследователей, которые отправляются на планету, где происходят странные и опасные явления.

Яб почитал.

molnij

Просто любопытно, а какой ответ вы ждали? 3.5 не подключена к сети, если мы именно про openAI-модель, она не умеет в картинки, как четверка, я правда в некоторой растерянности… Описание фотографии может быть?

vvzvlad

Он ожидал любой ответ, который бы позволил сказать "фигня ваши модели"

volchenkodmitriy

Ну до этого мы хорошо с ним обсудили сюжет нескольких фильмов. Он мог бы дать ссылку или ответить в каком фильме Сталлоне снимался в этом возрасте. Вариантов много для настоящего искусственного интеллекта)

alexd73

используй CatGPT, он даже гифку скинет )) Не факт, что Сталоне, но всё же...