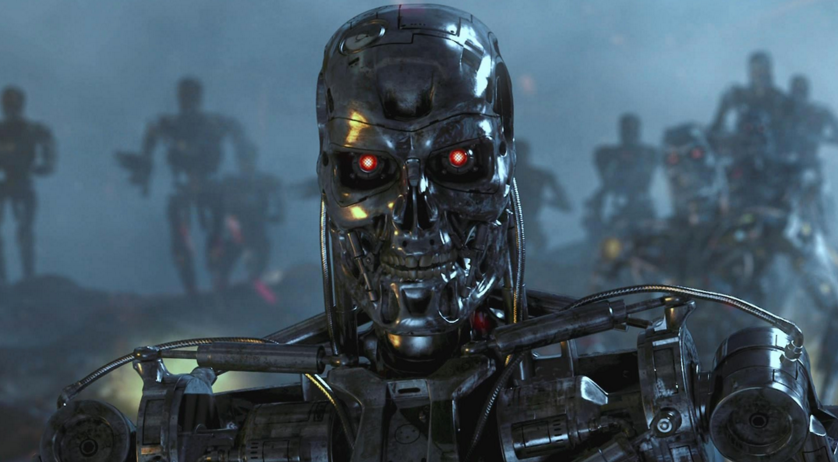

Как бы намекает

Бывший сотрудник Пентагона, который участвовал в разработке стратегии применения автономного вооружения утверждает, что в реальных условиях оно может быть неуправляемым и существует возможность взлома, подмены и манипуляций со стороны противника.

В последнее время недорогие датчики и новые технологии искусственного интеллекта стали более практичными, что сделало возможным их использование в разработках автономных систем вооружения. Призрак так называемых «роботов-убийц» уже спровоцировал международное движение протеста и дискуссии в ООН об ограничении разработки и внедрения таких систем, сообщает nytimes.com.

Доклад был написан Полом Шерри, который руководит программой по разработке приемов ведения «войны будущего» в Центре Новой Американской Безопасности (Вашингтон, Колумбия). С 2008 по 2013 годы Шерри работал в кабинете министра обороны США, где помог разработать стратегию применения автономного оружия. В 2012 году он стал одним из авторов директивы Министерства обороны, которая устанавливала военную политику по использованию подобных систем.

В докладе «Автономное оружие и операционный риск», который был опубликован в понедельник, Шерри предупреждает о ряде реальных рисков, связанных с оружейными системами, являющимися полностью автономными. Он противопоставляет полностью автоматизированные системы, которые могут убивать без вмешательства человека, оружию, которое «держит людей в курсе» в процессе выбора и поражения цели (т.е. используется оператор).

Шерри, который служил в армии США рейнджером и участвовал в операциях в Ираке и Афганистане, фокусируется на потенциальных видах ошибок, которые могут возникнуть в полностью автоматизированных системах. Чтобы подчеркнуть военные последствия, в докладе перечисляются неудачи, которые произошли в армейских и коммерческих системах с высокой степенью автоматизации.

«Любой, кто когда-либо разочаровывался в автоматизированной телефонной поддержке телефона доверия, будильнике, ошибочно установленном на „вечер“ вместо „утро“ и так далее, испытал проблему „хрупкости“, которая присутствует в автоматизированных системах», пишет Шерри.

Основой его доклада является то, что автономным системам вооружения не хватает «гибкости», т.е. в процессе выполнения такой системой задания могут возникнуть ошибки, которых люди смогли бы избежать.

Полностью автономное оружие начинает появляться в военных арсеналах различных государств. Например, Южная Корея установила автоматическую турель вдоль демилитаризованной зоны с Северной Кореей, а в Израиле стоит на вооружении беспилотный летательный аппарат, который запрограммирован атаковать радиолокационные системы противника при их обнаружении.

Военные США не используют автономное оружие. Тем не менее, в этом году Министерство обороны запросило почти $1 млрд для производства оружия корпорацией Lockheed Martin Long Range Anti-Ship Missile, которое описывается как «полуавтономное». Хотя оператор и будет сначала выбирать цель, но вне контакта с человеком оно автоматически будет идентифицировать и атаковать вражеские войска.

Основное внимание уделяется ряду неожиданностей в поведении компьютерных систем, таких как сбои и ошибки, а также непредвиденные взаимодействия с окружающей средой.

«Во время своего первого испытания над Тихим океаном в восьми истребителях F-22 полностью отказала система компьютера Y2K, так как они пересекли линию перемены даты», говорится в докладе. «Все бортовые компьютерные системы отказали, и результат был почти катастрофическим — потеря самолета. Хотя существование линии перемены дат давно известно, результат взаимодействия с программным обеспечением не был целиком протестирован».

В качестве альтернативы полностью автономному оружию, в докладе ратуют за то, что называется «Centaur Warfighting» (Комбинированное вооружение? По сути, непереводимая игра слов прим.). Термин «centaur» стал применяться для описания систем, в которых тесно интегрируют работу людей и компьютеров. В шахматах, например, команды, которые используют и людей, и программы искусственного интеллекта доминируют в соревнованиях против команд, которые используют только искусственный интеллект.

Тем не менее, в телефонном интервью Шерри признал, что просто оператора, «нажимающего на кнопки», мало. «Наличие просто „оповещенного“ о действиях машины человека недостаточно», сказал он. «Они (люди) не могут быть просто частью алгоритма работы системы. Человек должен активно участвовать в принятии решений».

Комментарии (50)

Zenitchik

02.03.2016 20:37+3Судя по статье, опасно не автономное оружие (напомню, что оно уже сто лет существует, и называется «мина»), а переусложнённое в ущерб надёжности.

Artoo-Detoo

02.03.2016 22:12Вспомнил одну книгу, фантастику естественно. Там боевая машина с ИИ, посылала запросы на въезд в частную собственность, при открытии огня запросы на разрешение открытия огня и т.д. Эффективность такой машины стремилась к отрицательным величинам.

P.S. Названия не помню, аппарат что то вроде гигантского танка с около световым орудием на борту на основе дейтерия.Zenitchik

03.03.2016 15:46Такая штука была бы хороша в качестве артиллерии. Сама разведку не ведёт, и открывает огонь только по вызову.

Artoo-Detoo

03.03.2016 16:32Разве что по целям на орбите, т.к. стрелять можно только прямой наводкой. Мало того, эти тысячи тонн могли еще и леветировать над землей, на большой скорости.

Neuromantix

02.03.2016 22:30+3Глядя на нынешний софт и количество багоглюков в нем, думаю, что автономное оружие перестреляет всех программистов еще в лаборатории.

Oxoron

02.03.2016 23:24+2«Пишите ваш код так, как будто его будет читать вооруженный психопат, знающий где вы живете». Никогда еще эта идея не была так близка к реальности.

Hellsy22

02.03.2016 22:58+1Противопехотная мина является автономным оружием. Мины регулярно убивают гражданских и "своих", но это никого не останавливает от их использования.

Что же касается более высокотехнологичного оружия, то присутствие оператора ведет к серьезным проблемам — демаскировке, возможности подавить канал связи или даже перехватить управление.

Gummilion

03.03.2016 09:43+1Вообще противопехотные мины как негуманное оружие давно пытаются запретить всякими международными конвенциями, но не особо успешно — очень уж мины дешевы и эффективны.

Zenitchik

03.03.2016 16:04+1Попытка запретить противопехотные мины — это один большой анекдот. Конвенции по этому поводу составлены технически безграмотно, чтобы вывести боеприпас из-под конвенционного определения «мина» достаточно вынуть датчик цели, поставить его отдельно и соединить с миной проводом.

Кроме того, опыт показывает, что в послевоенное время люди больше страдают от оставшихся в земле неразрывов, чем от мин, поведение которых предсказуемо.

Это не говоря о том, что «гуманное оружие» — это оксюморон.

K0styan

03.03.2016 11:21Я бы разделял автономное и автоматическое оружие (автоматическое, разумеется, не в смысле стрельбы очередями). Автономное — само принимает решение о поражении. Автоматическое — срабатывает при реализации определенных факторов, но решение о применении этого оружия в конкретном месте и времени, о выборе этих факторов (например, на какое усилие нажатия настроить противотранспортную мину — 1 тонну или 10) принимает человек.

Zenitchik

03.03.2016 15:52Не вижу принципиальной разницы между «принятием решения о поражении» и «срабатывании при реализации определенных факторов». Человек тоже «при реализации определенных факторов» открывает огонь, и факторы эти как правило выбраны за него и в устав заложены.

Coriander

03.03.2016 22:19+1Ну например, разница в возможности предсказать поведение мины. Одно дело простенький скрипт, который ты знаешь как выполнится всегда. Другое дело — нейронная сеть, поведение которой даже программист, её создавший, не способен предсказать. Ну и где-то посередине запутанная программа с высокой цикломатической сложностью, которую не могут запруфать системы автоматических доказательств.

Oroszorszag

02.03.2016 23:02-5»Во время своего первого испытания над Тихим океаном в восьми истребителях F-22 полностью отказала система компьютера Y2K, так как они пересекли линию перемены даты", говорится в докладе. «Все бортовые компьютерные системы отказали, и результат был почти катастрофическим — потеря самолета. Хотя существование линии перемены дат давно известно, результат взаимодействия с программным обеспечением не был целиком протестирован».

Что я только что прочитал?

chaloner

03.03.2016 10:50>«Любой, кто когда-либо разочаровывался в автоматизированной телефонной поддержке телефона доверия, будильнике, ошибочно >установленном на „вечер“ вместо „утро“ и так далее, испытал проблему „хрупкости“, которая присутствует в автоматизированных >системах», пишет Шерри.

Только мне кажется, что тут, скорее, дело в «прокладке между рулем и сиденьем», а не в самой автоматизированной системе. Если проанализировать его (Шерри), ВНЕЗАПНО осознаешь, что основная проблема — идиот, управляющий системой, системе же плевать какие приказы исполнять, — лишь бы в эксепшен не вывалиться.

edwardspec

03.03.2016 11:11основная проблема — идиот, управляющий системой, системе же плевать какие приказы исполнять, — лишь бы в эксепшен не вывалиться

Беда в том, что речь о военном роботе, то есть техническая грамотность и неидиотизм требуется от военных.

Которые иногда приказывают подравнять сугробы до квадратности.Zenitchik

03.03.2016 15:58+1Среди военных, имеющих достаточно звёздочек, чтобы отдавать приказы, идиотов как раз немного.

А сугробы квадратными должны быть всегда, просто потому что это красиво. Только идиоты-гражданские могут полагать, что наведение порядка и красоты на вверенной территории это идиотизм.dfgwer

04.03.2016 12:12Лыжный поход летом, покраска травы, похороны окурков и другие подобные мероприятия, имеют две цели. Выработать подчинение приказам и занять свободное время. Несколько сотен молодых бездельников = быть беде

Zenitchik

04.03.2016 18:19Подобные извращения — это элементы наказания. Впрочем, лыжный поход летом — наверно, занятное мероприятие и неплохое физическое упражнение. Покраска травы нужна для сохранения баланса во Вселенной: в армии всё должно быть либо квадратное, либо окрашено. Ну а похороны окурков, очевидно, чтобы в неположенных местах не бросали.

Raegdan

04.03.2016 22:31Слегка утрируя: ну вот, допустим, офицеры действительно хотят научить солдат чему-то полезному в бою. Хотят на стрельбище сводить — патронов нет. Хотят на технике научить ездить — запчасти разворованы, бензин слит, снарядов три штуки на часть, чтобы хотя бы показать как заряжается орудие. Хотят обучить основам РХБЗ — приборы нерабочие, противогазы драные. Остаётся физкультура (для нее не нужен никакой супер-инвентарь) и бессмысленные занятия типа покраски травы. Каким бы замечательным ни был командир части, он бессилен. Проблему можно решить только сверху — или восстановить снабжение, или еще сокращать срок службы. Но разве в министерстве это кому-то надо...

Delics

03.03.2016 23:15Военные офицеры в РФ технически грамотны. Умеют чинить электронику и т.п.

edwardspec

04.03.2016 10:37Но фабричный юнит-тест, отдающий роботу приказ подравнять сугроб и упасть-отжаться, всё равно не помешает.

Чтобы не получилось, что из-за бага такой приказ начинает восстание роботов,

а программисты не знают, поскольку ни разу не пробовали такое приказать.

KepJIaeda

03.03.2016 11:03Такое ощущение что в статье не предполагается наличие ИИ или его элементов (то есть системы принятия решений). Одно дело сделать систему которая только может распознавать свой/чужой (допустим по каким то меткам) или атаковать только тех кто вооружен (тут возможны ложные срабатывания, но от них и человек не застрахован), но если система будет более абстрактной (есть цель, а ее достижение уже рассчитывается на месте) это нечто иное чем просто автономное оружие.

amarao

03.03.2016 13:25+1Чтобы перестать ставить будильник на вечер вместо утра, надо перестать использовать 12-часовую систему. 24 часа, и никаких PM/AM.

Areso

03.03.2016 13:37+1«Во время своего первого испытания над Тихим океаном в восьми истребителях F-22 полностью отказала система компьютера Y2K, так как они пересекли линию перемены даты», говорится в докладе. «Все бортовые компьютерные системы отказали, и результат был почти катастрофическим — потеря самолета. Хотя существование линии перемены дат давно известно, результат взаимодействия с программным обеспечением не был целиком протестирован». Из той же оперы, байка — при полетах над мертвым морем, при пересечении отметки 0 высоты, компьютер перезагружался. А вот не байка: Oerlikon GDF-005 в 2007 г. открыла неконтролируемый огонь и убила нескольких человек.

Alexey2005

03.03.2016 15:25+1Можно подумать, что человек обладает 100% надёжностью, и у него в прошивке нет глюков.

Да про людей таких баек можно ещё больше понарассказывать. Есть и ошибки, и неадекват по пьяни или под наркотой, и даже просто эксепшены, когда откровенно "рвёт башню", и человек просто начинает стрелять по своим же сослуживцам.

Как только вероятность сбоя в компьютерной системе станет меньше вероятности сбоя живой системы, живых солдат можно будет заменить машинами.

А тех луддитов, которые против, можно уже сейчас отправить добровольцами в ближайшую горячую точку. Раз они хотят, чтобы за интересы каких-то левых дядь погибали живые люди вместо машин, то пусть и побудут этими людьми.

snuk182

03.03.2016 17:24А по эту сторону занавеса пугают «Периметром», уже лет шесть, наверное.

Wesha

04.03.2016 01:25+1А чего ей пугать?

«Она была разработана так, чтобы находиться в дремлющем состоянии, пока высокопоставленное официальное лицо не активирует её в кризисной ситуации. Тогда она начала бы мониторить сеть датчиков — сейсмических, радиационных, атмосферного давления — на признаки ядерных взрывов. Прежде чем запустить ответный удар, система должна была бы проверить четыре «если»: если система была активирована, сперва она попыталась бы определить, имело ли место применение ядерного оружия на советской территории. Если бы это оказалось похожим на правду, система проверила бы наличие связи c Генеральным штабом. Если связь имелась, система бы автоматически отключилась по прошествии некоторого времени — от 15 минут до часа — прошедшего без дальнейших признаков атаки, в предположении, что официальные лица, способные отдать приказ о контратаке, по-прежнему живы. >>>>>Но если бы связи не было, «Периметр» решил бы, что Судный день настал, и незамедлительно передал право принятия решения о запуске любому, кто в этот момент находился бы глубоко в защищённом бункере, в обход обычных многочисленных инстанций<<<<<.»

Это не система автоматического ответного удара. Это система *делегирования решения об ответном ударе* в случае, если Генштаб замочили.

snuk182

04.03.2016 11:47Это объяснение появилось сильно потом. А пугали в виде слухов, очень похожих на статью вверху — "если мы умрем, оно само включится, и вы умрете тоже. ну и остальные умрут, на всякий случай".

Zenitchik

04.03.2016 18:38Ну, это тоже нестрашно. Того, кто не собирался бомбить нас первым, это пугать не может.

Wesha

04.03.2016 20:11> «если мы умрем, оно само включится, и вы умрете тоже. ну и остальные умрут, на всякий случай».

А где тут противоречие с приведённой мной цитатой?

«Если мы умрём, (то всё равно останется в живых кто-нибудь, кто сможет её включить), и вы умрёте тоже (и далее по Вашему тексту)». Без этих ваших роботов.

snuk182

04.03.2016 22:54Я не говорил про противоречие, зато говорил про "оно само включится".

Разгонялся факт полностью автоматической реакции, основанный неизвестно на чем. Последний человеческий фактор, сидящий в бункере, появился уже потом. Но параноиков перепугать успели.

Wesha

04.03.2016 23:25После того, как автоматика облажалась несколько раз, потому что программисты опять упустили какой-нибудь edge case ( https://ru.wikipedia.org/wiki/%D0%A1%D0%BB%D1%83%D1%87%D0%B0%D0%B8_%D0%BB%D0%BE%D0%B6%D0%BD%D0%BE%D0%B3%D0%BE_%D1%81%D1%80%D0%B0%D0%B1%D0%B0%D1%82%D1%8B%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F_%D1%81%D0%B8%D1%81%D1%82%D0%B5%D0%BC_%D0%BF%D1%80%D0%B5%D0%B4%D1%83%D0%BF%D1%80%D0%B5%D0%B6%D0%B4%D0%B5%D0%BD%D0%B8%D1%8F_%D0%BE_%D1%80%D0%B0%D0%BA%D0%B5%D1%82%D0%BD%D0%BE%D0%BC_%D0%BD%D0%B0%D0%BF%D0%B0%D0%B4%D0%B5%D0%BD%D0%B8%D0%B8 ) человека исключать достаточно неумно…

dfgwer

Опасность автономного оружия, в том, что управляется она малой группой людей и подчиняется всегда. Если человеческой армии отдать преступный приказ, "убить всех" Человек откажется. Автономная армия убьет всех

Автономная армия, даст верхушке общества Абсолютную Власть

ivlis

Как показывает история никто обычно от приказов не отказывается.

Coriander

Вы уж определитесь, «обычно» или совсем «никто»? Иногда человечность и эмпатия пробивают брешь в броне пропаганды.

Vlad_Hm

Именно что иногда. Очень редко. И большинство таких "добреньких" ждёт весьма жёсткое наказание. Как правило, кстати — заслуженное. Ибо они ставят своё локальное понимание добра и зла выше стратегического плана, который привёл к отданному приказу.

Не нужно переоценивать автоматы — армия, используя веками отшлифованные психологические методики, уже давно научилась делать автоматы из людей.

dfgwer

Примеров отказа полно. Сирия та же

К тому же, "не отдавай приказы которые не будут выполнены", этой мудрости придерживаются все успешные руководители

potan

За то те, кто не отказались, часто выполняют приказы слишком рьяно.

Apatic

Для военных немного другие правила действуют.

Metus

Если бы это действительно так, у нас в мире никогда не было бы гражданский войн, переворотов, восстаний и всего прочего.

Армия это не 2 полюса: рядовые и абстрактная отдавалка приказов.

Это иерархия. И чем выше в иерархии армии находится человек, тем менее он предрасположен к слепому выполнению приказов.

И если даже самые бесчеловечные приказы многие солдаты готовы с радостью выполнять в отношении населения иной страны, всё меняется во время войны гражданской.

И даже выполняя их в таком случае, человек будет понимать, что так поступать не стоит. Это будут видеть и понимать остальные.

И как только объявится какой-либо мятежный генерал, именно он будет пользоваться основной поддержкой армии. Просто потому, что солдатам захочется «смыть» с себя всё что они сделали или не сделали.

Истинные причины и мотивы его могут быть разными. И такие ситуации, как раз-таки, не редкость.

Именно поэтому отдают только те приказы, которые будут выполняться без серьёзных угрызений совести.