МЕГА Accelerator был запущен в начале года, и в прошлом посте мы познакомили вас с десятью стартапами, ставшими резидентами нашего акселератора и уже начавшими работу в коворкинге PO2RT. Теперь можно рассказать подробнее о каждом из проектов. Почему бы не начать с Surfancy?

Эта статья об истории развития тачскрина от 50-х годов XX века до наших современников, стартаперов Surfancy, которые придумали, как отделить тачскрин от экрана. Почему это не случайное решение, а правильное и закономерное развитие всей истории тачскрина? Здесь нужно разобраться в истории.

Пока запомните эти две белые планки, мы вернемся к ним в конце статьи:

Как же столь важное технологическое решение как тачскрин смогло практически мгновенно захватить наш мир? Путь тачскринов был довольно тернист и потребовал упорного труда нескольких поколений лучших инженерных умов, а сама технология имеет в своей истории уже целых десять (!) поколений выдающихся устройств!

Первое, что поражает — тачскрин очень долго никого не интересовал, инженеры воспринимали его как костыль и непрактичную игрушку. Даже в кино тачскрин появился только в 1965 году, когда экипаж корабля из «Star Trek» начал нажимать пальцами прямо на экраны вместо кнопок — тогда это воспринималось как гротеск и не получило широкого распространения. В самом Стар Треке к тачскринам вернулись только в 1987 году…

Но история реального тачскрина берет начало в 1950-х. Только сначала вместо пальца приходилось использовать нечто более электропроводящее.

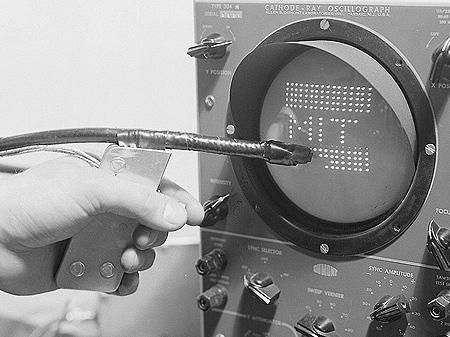

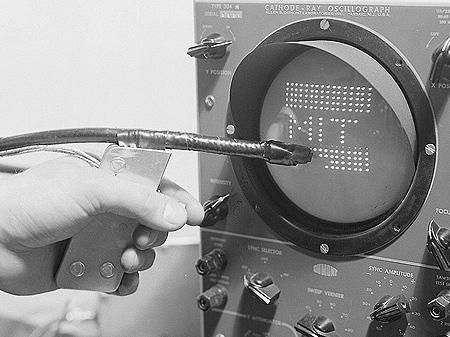

В 1954 году Роберт Еверетт из американской Lincoln Lab предложил использовать световую пушку для выбора и управления иконками самолетов на авиарадаре. Если у вас были световой пистолет и приставка Денди, то теперь вы знаете, откуда у неё ноги растут.

Знаменитый центр управления из фильма Dr.Strangelove — это как раз центр управления SAGE.

Скажем спасибо холодной войне — операторам требовалось как можно скорее реагировать на советские самолеты и ракеты в воздухе, поэтому правительство потратило $12 миллионов на разработку системы SAGE, которая оказала очень большое влияние на развитие информационных технологий — впервые всё воздушное пространство управлялось 27 300-тонными компьютерами, соединенными аналоговыми модемами, алгоритмы автоматически реагировали на угрозы и предлагали меры для контратак. Для создания системы были привлечены 20% программистов всего мира, которые написали 250 000 строк самого сложного кода в истории.

SAGE получилась настолько сложной и надёжной, что управляла системой противоракетной обороны США до 1983 года (!!!). По иронии судьбы в последние годы работы системы выходившие из строя вакуумные лампы было нечем заменить — их уже не выпускали с 50-х, поэтому ЦРУ пришлось провести огромную операцию по покупке нужных ламп… в СССР. Но это уже совсем другая история, упоминаю о ней просто, чтобы показать, какие масштабы материальных и научных вложений потребовались для создания самоочевидной вещи — компьютера, способного понимать движения пальцев.

В системе SAGE оператор действовал мгновенно — вместо ввода координат с клавиатуры он просто указывал световым пером на точку, оптико-электрическое перо передавало сигнал компьютеру, и тот уже сам вычислял координаты. Это позволило вести управление в реальном времени и исключить ошибки.

К 1957 году световая пушка была улучшена до светового стилуса. Теперь можно было не только выделять самолеты, но и рисовать на экране, словно ручкой. Тогда ученые решили, что идеал достигнут.

Один из программистов IBM тайно зашил в систему такое изображение для процесса диагностики синхронизации удаленных компьютеров. Наверное, эту заставку можно считать первым скринсейвером.

В 1963 году корпорация RAND по заказу DARPA создаёт универсальный графический планшет со стилусом. Который принципиально ничем не отличается от современных Wacom’ов.

Наиболее интересная часть планшета RAND скрывалась под залитой эпоксидной смолой поверхностью. На тончайший слой полиэфирной плёнки с двух сторон был нанесён тонкий слой меди, на котором и была вытравлена координатная сетка планшета. Верхняя поверхность содержала 1024 дорожки координат Х, а нижняя — 1024 дорожки координат Y. Таким образом, планшет RAND содержал миллион X-Y координат и обеспечивал беспрецедентное для того времени разрешение — 100 дорожек на дюйм.

Планшет использовал сетку проводников под сенсорной поверхностью, на которые подавались закодированные троичным кодом Грея электрические импульсы. Ёмкостно связанное перо принимало этот сигнал, который затем мог быть декодирован обратно в координаты. Особое внимание уделялось работам с картами и целеуказанию на них. И всё это всего за какие-то $18 000. Недостатки? К планшету нужен полноценный компьютер со своим экраном и вот такой блок питания:

К сожалению, все данные о применении системы засекречены, всего два экземпляра 6ыли переданы гражданским университетам.

В 1965 году технология тачскрина становится действительно тачскрином. Эдвард Джонсон из Royal Radar Establishment создаёт тот тип тачскрина, который на долгие годы станет основным — ёмкостный тачскрин. Теперь диспетчеры в аэропорту могли просто дотрагиваться до экрана пальцем без всякого стилуса.

Технология проста, как всё гениальное — экран кинескопа покрывается проводящей прозрачной пленкой, прикосновение пальца к экрану меняет сопротивление и система получает сигнал — есть замыкание. Простота и надёжность позволили этой системе управлять всеми авиаперелётами в Англии до самого конца 1990-х!

Правда, простота системы не позволила ей стать коммерческим решением — на такой пленке нельзя замерить силу нажатия и что важнее — никакого мультитача. Только один палец за раз.

В отличие от ёмкостных, резистивные тачскрины были открыты вообще случайно. Его автор Самуэль Херст так описывает этот случай:

Для изучения атомной физики исследовательская группа использовала перегруженный работой ускоритель Ван де Графа, который был доступен студентам только в ночное время. Утомительный анализ данных с бумажных лент сильно замедлял исследования. Сэм придумал способ, чтобы решить эту проблему. Он, Парки, и Турман Стюарт, ещё один докторант, использовали электропроводящую бумагу, чтобы прочитать пару х- и у- координат. Эта идея привела к первому сенсорному экрану для компьютера. С помощью этого прототипа его ученики могли бы сделать нужные вычисления в течение нескольких часов, хотя раньше для достижения этой же цели требовалось несколько дней.

Забросив свои исследования, в 1970 году Херст с девятью коллегами укрылись в его гараже и довели случайное изобретение до совершенства. В результате родилась технология «электрического сенсора плоских координат»:

Два электропроводящих слоя задавали X и Y координаты соответственно. Давление на экран позволяло току течь между X и Y слоями, что легко измерялось на выходе и сразу конвертировалось в числовые координаты. Поэтому такой тип экрана и называется резистивным — он реагирует на давление (resist — сопротивление) а не электропроводимость.

Такая технология оказалась удивительно дешевой и именно ей мы сейчас все и пользуемся.

В 1971 году все это было запатентовано и продано калифорнийским предпринимателем под названием Elographics.

Реально же мультитач родился там, где и должен был — в CERN. Мало кто понимает, что основная проблема CERN — управление коллайдерами. В чем эта проблема? Большой Адронный Коллайдер (LHC); ежесекундно будет происходить около миллиарда столкновений, в каждом из которых будут рождаться десятки частиц разных типов. Годовой объём экспериментальных данных оценивается в 10 петабайт (1 Пб = 10 15 байт) — LHC будет давать 1% информации, производимой человечеством. Для обработки и хранения такого потока данных в 1994 году в CERN придумают Интернет. Но в 1973 году перед инженерами встает совсем неожиданная задача.

Запуск протонного суперсинхротрона упёрся в невозможность оперативного управления. Будучи в 10 раз больше, мощнее и сложнее предыдущего ускорителя, он требовал практически бесконечное количество кнопок и переключателей на приборной панели, а управлять всем этим должны всего несколько человек — иначе не получится осуществлять централизованное управление. Как быть?

Выводить от каждого из ста тысяч переключателей отдельный тумблер или… переложить всю работу на компьютеры, которые будут выводить только нужные данные оператору на экран. Для этого нужно лишь придумать эти суперкомпьютеры и экраны, которые позволят легко переключать кнопки нажатием пальцев.

Как вы понимаете, CERN выбрал второй вариант и создал емкостные экраны с поддержкой мультитача — именно их решением мы пользуемся сегодня, когда держим в руках свой айфон.

А начиналось все вот с этих сенсорных матриц. Слева о6разец 1977 года, справа — 1972:

В записке, датированной 11 марта 1972 года, Берн Стампе представил своё решение — емкостной сенсорный экран с фиксированным числом программируемых кнопок, находящихся на дисплее. Экран должен был состоять из множества конденсаторов, вплавленных в плёнку или в стекло медных проволочек, каждый конденсатор должен быть построен так, что поблизости находящийся проводник, такой как палец, приведет к увеличению мощности на значительную величину. Конденсаторы должны были быть проволочками меди на стекле — тонкими (80 ?m) и достаточно далеко друг от друга (80 ?m), чтобы быть невидимыми. В конечном устройстве экран был просто покрыт лаком, который предотвращал касание пальцами конденсаторов.

Пленка была практически прозрачной и совершенно незаметной:

В результате протонный синхротрон управлялся вот с этого пульта всего тремя операторами:

Система настолько опережала своё время, что в ней не было ни одного коммерческого компонента — все элементы производились самим CERN и воспринимались не как узкоспециализированые решения, а скорее даже как «костыли» — вместо гордости инженеры считали, что их решение это «чит» и развлечение, а не серьёзная работа. После коллайдера технология была использована в «Дринкомате» кафетерия — аппарат позволял пальцами на экране смешивать себе коктейль и получать его из аппарата.

Поразительно, что, по сути открыв мультитач, в CERN его так ни разу и не использовали — никаких жестов или знакомых нам функций — мультитач тогда воспринимался просто как возможность нажимать на экране несколько кнопок одновременно. В сторону замечу, что ничего не мешало церновскому тачскрину определять ещё и силу нажатия на экран.

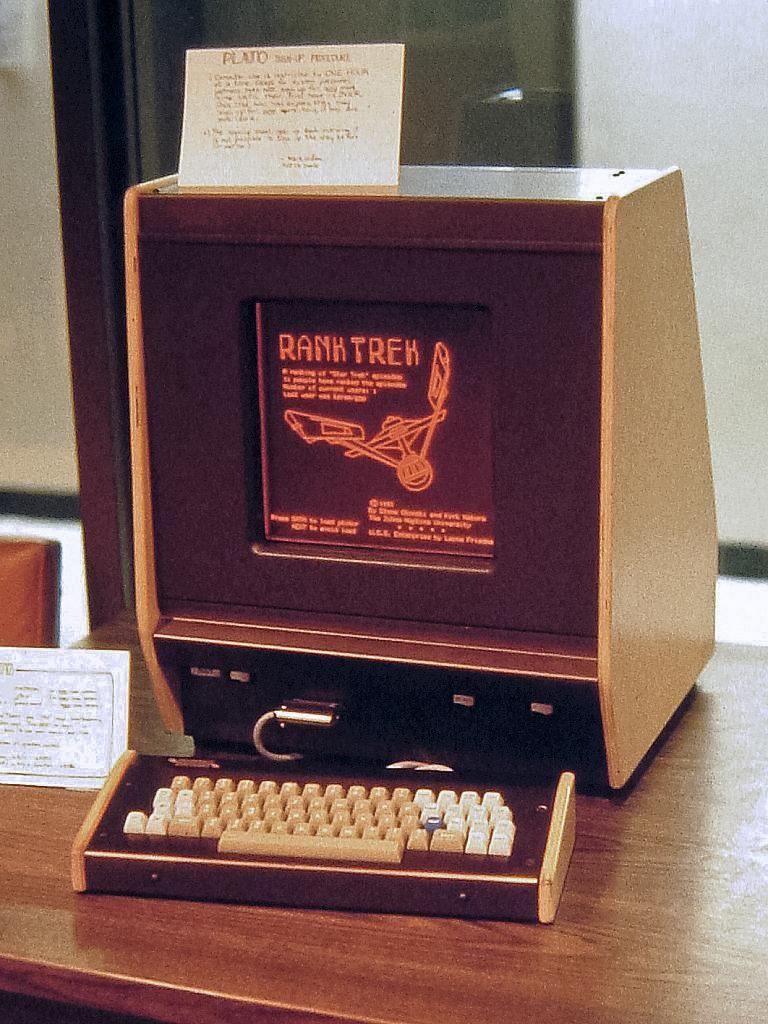

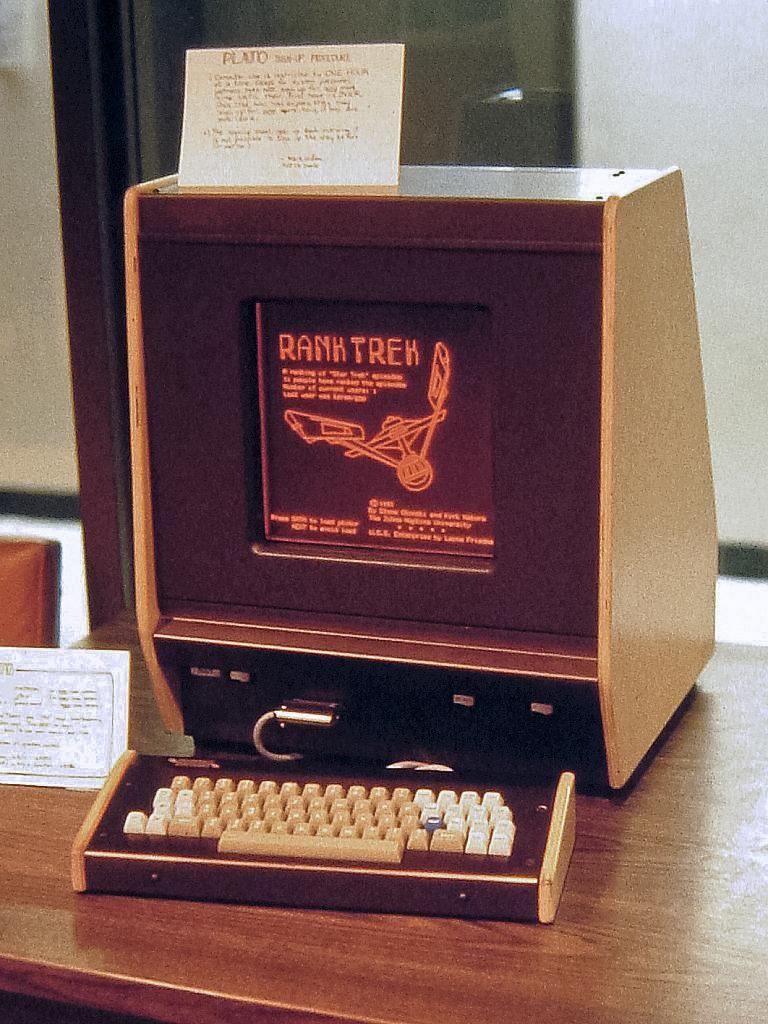

Под впечатлением успеха европейских ученых американцы выбивают у правительства грант на конверсию военных тачскринов в образовательных целях. Programmed Logic for Automated Teaching Operations (PLATO) — первая система электронного обучения, к концу 70-х годов состоявшая из нескольких тысяч терминалов по всему миру и более десятка мейнфреймов, соединённых общей компьютерной сетью. Система PLATO была разработана в Университете Иллинойса и использовалась в течение 40 лет. Она была первоначально создана для выполнения простых курсовых работ студентами университета Иллинойса, местными школьниками и студентами ряда других университетов.

Но нас интересует, как именно функционировали терминалы этой системы. Дисплей PLATO IV также имел сетку инфракрасной сенсорной панели размером 16х16, что позволяло студентам отвечать на вопросы касанием пальца в любом месте экрана.

С появлением микропроцессоров были разработаны новые, более дешёвые и обладающие большими возможностями терминалы. Микропроцессоры Intel 8080, встроенные в терминалы, позволяли системе выполнять программы локально, как в наше время выполняются Java-апплеты или элементы управления ActiveX, а также загружать небольшие модули программного обеспечения в терминал, чтобы разнообразить учебные курсы за счёт сложной анимации и других возможностей, недоступных в обычных терминалах. Отдельно отметим оранжевый газо-плазменный экран, дававший впечатляющую картинку.

Любопытно, что в 1972 году в университете штата Иллинойс исследователям компании Xerox PARC была продемонстрирована система PLATO. Были показаны отдельные модули системы — такие, как программа генератора изображений для PLATO и программа для «отрисовки» новых символов. Многие из этих инноваций стали дальнейшим фундаментом для разработки других компьютерных систем. Некоторые из этих технологий в усовершенствованном виде появились в системе Xerox Alto, которая, в свою очередь, стала прототипом для разработок компании Apple.

К 1975 году система PLATO, выполнявшаяся на суперкомпьютере CDC Cyber 73, обслуживала почти 150 мест, включая не только пользователей системы PLATO III, но и гимназии, лицеи, колледжи, университеты и военные объекты. В PLATO IV в составе учебных курсов предлагались текст, графикa и анимация. Кроме того, имелся механизм разделяемой памяти («общие» переменные), что позволяло с помощью языка программирования TUTOR передавать данные между различными пользователями в реальном времени. Так стали впервые создаваться программы для чата, а также первый многопользовательский авиасимулятор. Все это за 30 лет до интернета!

Недостатки? Разрешение сенсора всего 32 квадрата, все еще нет мультитача и стоимость в $12 000.

К 1980-м всем стало очевидно, что без мультитача тачскрин не сможет выйти на рынок. Как известно еще из античности, человек — мера всех вещей. А у человека на руках десять пальцев.

В 1983 году было много обсуждений мультитач-экранов, которые привели к разработке экрана, использующего для управления больше чем одну руку. Bell Labs сфокусировались на разработке софта для мультитач и добились значительных успехов на этом поле, представив в 1984 году сенсорный экран, на котором можно было пролистывать изображения двумя руками.

Следующим шагом в развитии оптических сенсоров стало появление «сенсорных рамок», разработанных в 1985 году в Университете Карнеги-Меллона. Принцип действия подобных дисплеев состоял в том, что рамка дисплея подсвечивалась ИК-лучами, а касание определялось по изменению рассеяния света на границе «стекло-воздух». Подобные дисплеи могли распознавать одновременные касания тремя пальцами.

Находят оптические сенсорные дисплеи свое применение и в наши дни. Их главный плюс – отсутствие дополнительного слоя прозрачного материала. В частности ИК-тач используется в «читалке» Sony PRS-350 и различных промышленных устройствах. Главный минус — избыточная точность и сложность таких систем — и дорого, и обидно тратить ресурсы, которые никогда не будут использованы.

В 1985 году в Университете Торонто группа ученых разработала небольшие емкостные сенсоры на смену громоздким камерам на основе оптических сенсорных систем.

Изобретатели пытаются решить проблему через всякие костыли — кто-то использует тень от рук для определения координат, цветные проекторы или даже микрофоны для эхолокации. Эти системы не получили никакого распространения, но именно на них были созданы все современные известные нам жесты управления. Единственное, чего не могли сделать эти системы — регистрировать нажатия на экран, что их и погубило.

Первая попытка выхода сенсорных технологий на массовый рынок произошла в 1983 году, когда HP решает захватить рынок персоналок, выпустив легендарный HP-150. Крепкая добротная персоналка за $3000 на Intel 8088 с частотой в 8Мгц была в два раза быстрее стандартных персоналок тех дней с частотой в 4,77Мгц, кроме того на борту было от 256 до 640 килобайт оперативки и система MS-DOS 3.20, но главное — экран. Поверх экрана расположились инфракрасные излучатели, образующие сенсорную рамку, 40 горизонтальных на 24 вертикальных сенсоров.

Этот компьютер не смог дать настоящий мультитач и вообще оказался коммерческим провалом — отверстия для сенсоров снизу быстро заполнялись пылью и переставали работать, один палец на экране перекрывал сразу две линии. В 1984 году Боб Бойл из Bell Labs смог усовершенствовать систему, заменив лучи и сенсоры на прозрачный слой поверх экрана, что позволяло реализовать настоящий мультитач, но все было безнадежно… очень быстро оказалось, что человеческие руки совершенно не приспособлены к «тыканию» пальцем в вертикальный экран на весу больше 10-15 минут. То есть вот такие интерфейсы невозможны в принципе:

Это странно и неожиданно — подержать на весу руку десять минут не проблема (но тоже не сахар), а вот тыкать на весу пальцем в стену — невозможно. Рука отекает и очень устает, исследователи назвали этот эффект «Gorrilla Arm», то есть «лапа гориллы».

Борьба с синдромом «Горильей лапы» проливает свет на историю Apple и Стива Джобса, во всяком случае делает ее понятной. Стив Джобс был убежден, что победить этот недостаток можно только одним способом — перенести тачскрин прямо на руку. Положить экран в ладонь или еще каким способом ликвидировать расстояние между пальцами и экраном, заставляющее держать руки на весу. Помните, как Стив специально объяснял, почему на макбуках никогда не будет тачскринов?

Стив настаивает, что нужно не просто ликвидировать этот промежуток, но идти дальше — дать пользователям чистый, интуитивно понятный мультитач без всяких посредников. Мультитач и ничего кроме него!

Но Стива не слушают — его идеи принимают, но его самого «уходят» из Apple. В результате Apple делает свой первый айфон в 1987 году — Newton MessagePad получается лишь пародией на мечту Джобса — да, его можно держать в руке, но никакого мультитача и управление через стилус. В результате пользоваться им неудобно, распознавать рукописный ввод он не может и все тормозит. Критики в восторге, пользователи проклинают сырой продукт. Но Apple идет напролом и выпускает свой планшет еще шесть лет, что ставит корпорацию на грань банкротства.

Этим пользуется Palm, выпуская свой наладонник — единственное его отличие в том, что он делает то, что обещает — например, худо-бедно распознает рукописный текст. Но так же никакого мультитача и работа только через стилус. Все это работает на резистивных экранах.

Несмотря на то, что первая поверхность с поддержкой мультитач появилась в 1984 году, когда в Bell Labs разработали подобный экран, на котором можно было манипулировать изображениями при помощи более чем одной руки, эта разработка не получила продвижения.

Начиная с 2000 года стартует гонка за мультитачем. Сони запускает проект SmartSkin, Microsoft делает совместно с IKEA стол Surface, система FTIR становится хитом на YouTube.

Продолжение данный метод получил лишь спустя двадцать лет — в начале 2000-х компания FingerWorks разработала и стала выпускать эргономичные клавиатуры с возможностью использования мультикасаний/жестов, для которых разработала специальный жестовый язык. Спустя несколько лет (2005) она была куплена… компанией Apple.

Вернувшись на пост CEO, Джобс направил все ресурсы Apple на одну простую задачу — сделать продукт, который целиком и полностью будет построен вокруг технологии мультитач. Он борется за каждый грамм веса и миллиметр размера будущего айфона, чтобы победить «лапу гориллы». Он принципиально ненавидит стилусы, и подчиняет весь софт и дизайн одной задаче, даже не задаче, а лишь одному жесту, который он покажет на презентации и взорвет индустрию. Вот этот жест:

На знаменитой презентации 2007 года он разблокирует айфон простым свайпом и пролистывает списки таким же простым движением пальца. Это естественно и очевидно — мы даже не понимаем, насколько круто это было всего десять лет назад!

Именно простота и естественность стали залогом успеха айфона — под это подстроен и весь дизайн интерфейса, имитирующий естественные поверхности — т.н. скевоморфизм. И к тому же, теперь вы знаете, откуда такая ненависть к стилусам.

Итак, нам потребовалось 50 лет, чтобы проделать путь от светового ружья до айфона. Что дальше? Ответ на этот вопрос пытается нащупать московский стартап Surfancy.

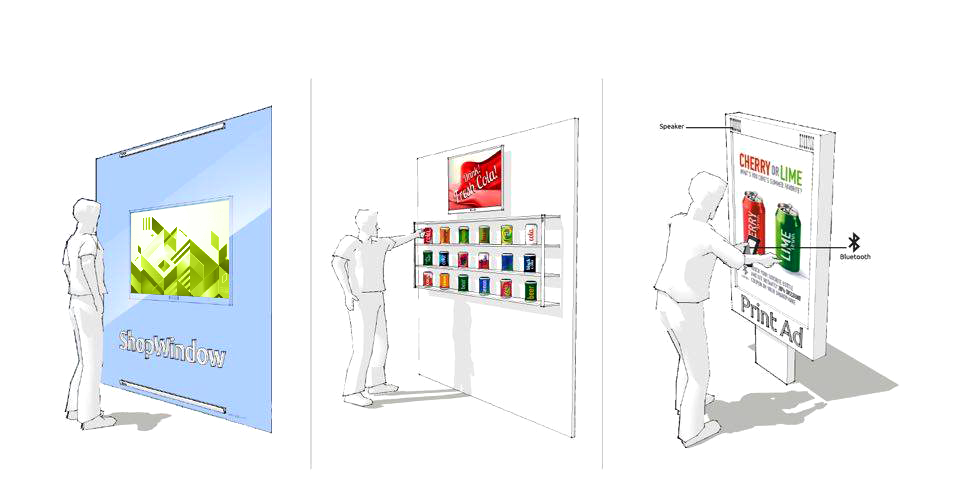

Все предыдущие 50 лет мы пытались избавиться от клавиатуры и перенести органы управления прямо на экран. В результате сегодня сенсорные решения оказались заложниками своих экранов. А что, если сделать еще один шаг и… отказаться от экрана? Нетрудно видеть, что именно в этом направлении пошли все крупные корпорации — достаточно вспомнить Nintendo Wii или Microsoft Kinect. Но и они крайне ограничены — им нужно особое помещение со строго определенными параметрами освещенности, несколько метров пространства, да и распознавать движения пальцев они не способны.

А что, если представить решение, которое сможет очень дешево и просто делать сенсорным любую ровную поверхность вне зависимости от внешних условий, да и от наличия самой поверхности? Так и родилась идея Surfancy.

Главными особенностями устройства являются легкость монтажа, масштабируемость сенсорной области и высокая помехоустойчивость, система не накладывает рамки (в прямом и переносном смысле) на то, что хочется сделать сенсорным. «Нашу систему можно закрепить на любой поверхности и получить интерактивный рекламный плакат, большой сенсорный экран или умную доску. Но формат при этом задаем не мы, а человек, который пользуется Surfancy. После реализации первого прототипа не могу избавиться от желания «нажать» на нарисованную кнопку на бумажных плакатах в лифтах или вагонах метро», — смеется Дмитрий. Кроме того, система надежна. Среди существующих оптических систем только Surfancy не накладывает какие-либо требования к внешней освещенности и кривизне.

Идея создания нового типа сенсорной панели зародилась у одного из членов команды во время его работы в одной крупной российской фирме, производящей игровые аппараты. Высокая точность, обеспечиваемая используемыми в них сенсорными панелями ультразвукового принципа действия, являлась весьма избыточной, что и дало толчок к разработке более простого и дешевого устройства.

И такое устройство было разработано. В первоначальном варианте оно представляло собой печатную плату, охватывающую край монитора с установленными на ней фототранзисторами, которые поочередно подсвечивались двумя разнесенными вдоль поверхности монитора инфракрасными диодами. Касание поверхности экрана вызывало пересечение оптических потоков инфракрасных диодов и появление при этом соответствующих теней на поверхностях фототранзисторов. Фактически все это напоминает устройство давно известных инфракрасных рамок, т.е. устройств, формирующих сетку лучей, оптически связанных с набором фотоприемников. Однако существенное отличие новой схемы – только 2 излучателя. Новизна данного технического решения была подтверждена патентом РФ на изобретение № 2278423.

На рисунке 1 приведена функциональная схема, защищенная данным патентом.

Рисунок 1

В силу известных причин производство игровых аппаратов было прекращено, и данный проект сенсорной панели был надолго похоронен. Интерес к данному устройству вновь возник, когда на Западе появилось успешное коммерческое решение, позволившее определять положение пальцев руки человека – оператора в пространстве. Речь идет о Kinect фирмы Microsoft. Сразу надо отметить главное достоинство Kinect – ее масштабируемость. Т.е. систему можно встроить в любое приложение, управление которым возможно осуществлять пространственным манипулированием руками человека-оператора. И еще – систему легко установить в любом месте – стоит лишь правильно выбрать зону обзора окружающего пространства, в котором разворачивается сценарий интерактивного взаимодействия пользователя с программным обеспечением.

У новой команды разработчиков появилась идея – занять свою нишу в области пространственного манипулирования и управления, и так же, как ранее в случае с ультразвуковой сенсорной панелью, исключить избыточность, присущую конкурирующей системе.

Под избыточностью в данном контексте надо понимать, что для построения 3D-интерфейса пользователя с программным обеспечением траектория пользовательского жеста может быть однозначно распознана и двумерной измерительной системой. Главное требование при этом – плоская сенсорная область должна быть оптимально локализована в 3D-пространстве. Большой недостаток Kinect, вытекающий из избыточной функциональности, связан с ее принципом функционирования. Как любая активная оптико-локационная система, к которой и относится Kinect, измерение положения объекта требует зондирующей подсветки с последующим приемом отраженного от объекта излучения. Это делает ее чувствительной к паразитным засветкам, отражений от бликующих поверхностей и пр. Таким образом, не удастся поместить Kinect на улице и заставить работать в условиях яркой солнечной засветки.

Последующее развитие технологии «теневой локации», как кратко решили называть запатентованную подсветку объекта контроля двумя пространственно разнесенными излучателями, привело к следующей оптико-геометрической схеме измерений, приведенной на рисунке 2.

Рисунок 2

Сенсорное поле S образуется попарным пересечением оптических потоков ?1, ?2, ?3, ?4 на поверхностях L1 и L2 расположения фотоприемников. При этом, в отличие от схемы на рис.1, появление второй фотоприемной линейки позволило значительно увеличить размер сенсорной области. Помехоустойчивость данной схемы предельно высока, т.к. в ней отсутствует прием отраженного излучения, а высокое быстродействие фотоприемников позволило нам перейти на высокочастотную модуляцию зондирующих излучений светодиодов D1…D4. Данная схема защищена патентом РФ №2575388 и реализована в виде, изображенном на рисунке 3.

Рисунок 3

Надо отметить, что работоспособность данной технической реализации системы сохраняется даже при прямой солнечной засветке линеек, при расстоянии между ними до 6 м.

В заключение следует отметить, что различные типоразмеры данной системы (от 1 до 2-х метров длины боковых линеек) формируются на основе базового фотоприемного модуля, содержащего процессор, набор фотоприемников и от 2-до 4-х излучателей. В функционал устройства заложена возможность распознавания не менее 4-х одновременных касаний. На следующем этапе будет решена задача определения скорости вхождения объекта в сенсорную область.

Команда Surfancy видит будущее сенсорных систем в следующем:

Над всеми этими технологиями сейчас работает команда. Надеемся, что коллектив Surfancy в скором времени продемонстрирует решения этих задач.

Начиная с этих выходных мы запускаем первый тестовый прототип прямо в торговом центре МЕГА Химки, и уже через месяц сможем сделать выводы по эффективности системы — поедете за покупками, обязательно потрогайте наш экран. Пока это просто проектор с сенсором, но он работает!

Таким образом, Surfancy должна стать логичным продолжением многодесятилетнего развития сенсорных технологий и, наконец, подарить им свободу от экранов. Сенсорным может стать буквально все, и это открывает бесконечные возможности как для частного использования, так и для рекламы, и особенно розничной торговли.

У нашей команды нет сомнения в успехе проекта — а поддержка от такого гиганта как МЕГА придает нам известную долю уверенности, что в скором будущем с помощью подобных систем посетители торговых центров всегда смогут получить любую справочную, контекстно связанную с интересующим товаром, информацию.

Эта статья об истории развития тачскрина от 50-х годов XX века до наших современников, стартаперов Surfancy, которые придумали, как отделить тачскрин от экрана. Почему это не случайное решение, а правильное и закономерное развитие всей истории тачскрина? Здесь нужно разобраться в истории.

Пока запомните эти две белые планки, мы вернемся к ним в конце статьи:

Как же столь важное технологическое решение как тачскрин смогло практически мгновенно захватить наш мир? Путь тачскринов был довольно тернист и потребовал упорного труда нескольких поколений лучших инженерных умов, а сама технология имеет в своей истории уже целых десять (!) поколений выдающихся устройств!

Первое, что поражает — тачскрин очень долго никого не интересовал, инженеры воспринимали его как костыль и непрактичную игрушку. Даже в кино тачскрин появился только в 1965 году, когда экипаж корабля из «Star Trek» начал нажимать пальцами прямо на экраны вместо кнопок — тогда это воспринималось как гротеск и не получило широкого распространения. В самом Стар Треке к тачскринам вернулись только в 1987 году…

Но история реального тачскрина берет начало в 1950-х. Только сначала вместо пальца приходилось использовать нечто более электропроводящее.

Первое поколение

В 1954 году Роберт Еверетт из американской Lincoln Lab предложил использовать световую пушку для выбора и управления иконками самолетов на авиарадаре. Если у вас были световой пистолет и приставка Денди, то теперь вы знаете, откуда у неё ноги растут.

Знаменитый центр управления из фильма Dr.Strangelove — это как раз центр управления SAGE.

Скажем спасибо холодной войне — операторам требовалось как можно скорее реагировать на советские самолеты и ракеты в воздухе, поэтому правительство потратило $12 миллионов на разработку системы SAGE, которая оказала очень большое влияние на развитие информационных технологий — впервые всё воздушное пространство управлялось 27 300-тонными компьютерами, соединенными аналоговыми модемами, алгоритмы автоматически реагировали на угрозы и предлагали меры для контратак. Для создания системы были привлечены 20% программистов всего мира, которые написали 250 000 строк самого сложного кода в истории.

SAGE получилась настолько сложной и надёжной, что управляла системой противоракетной обороны США до 1983 года (!!!). По иронии судьбы в последние годы работы системы выходившие из строя вакуумные лампы было нечем заменить — их уже не выпускали с 50-х, поэтому ЦРУ пришлось провести огромную операцию по покупке нужных ламп… в СССР. Но это уже совсем другая история, упоминаю о ней просто, чтобы показать, какие масштабы материальных и научных вложений потребовались для создания самоочевидной вещи — компьютера, способного понимать движения пальцев.

В системе SAGE оператор действовал мгновенно — вместо ввода координат с клавиатуры он просто указывал световым пером на точку, оптико-электрическое перо передавало сигнал компьютеру, и тот уже сам вычислял координаты. Это позволило вести управление в реальном времени и исключить ошибки.

К 1957 году световая пушка была улучшена до светового стилуса. Теперь можно было не только выделять самолеты, но и рисовать на экране, словно ручкой. Тогда ученые решили, что идеал достигнут.

Один из программистов IBM тайно зашил в систему такое изображение для процесса диагностики синхронизации удаленных компьютеров. Наверное, эту заставку можно считать первым скринсейвером.

Второе поколение

В 1963 году корпорация RAND по заказу DARPA создаёт универсальный графический планшет со стилусом. Который принципиально ничем не отличается от современных Wacom’ов.

Наиболее интересная часть планшета RAND скрывалась под залитой эпоксидной смолой поверхностью. На тончайший слой полиэфирной плёнки с двух сторон был нанесён тонкий слой меди, на котором и была вытравлена координатная сетка планшета. Верхняя поверхность содержала 1024 дорожки координат Х, а нижняя — 1024 дорожки координат Y. Таким образом, планшет RAND содержал миллион X-Y координат и обеспечивал беспрецедентное для того времени разрешение — 100 дорожек на дюйм.

Планшет использовал сетку проводников под сенсорной поверхностью, на которые подавались закодированные троичным кодом Грея электрические импульсы. Ёмкостно связанное перо принимало этот сигнал, который затем мог быть декодирован обратно в координаты. Особое внимание уделялось работам с картами и целеуказанию на них. И всё это всего за какие-то $18 000. Недостатки? К планшету нужен полноценный компьютер со своим экраном и вот такой блок питания:

К сожалению, все данные о применении системы засекречены, всего два экземпляра 6ыли переданы гражданским университетам.

Третье поколение

В 1965 году технология тачскрина становится действительно тачскрином. Эдвард Джонсон из Royal Radar Establishment создаёт тот тип тачскрина, который на долгие годы станет основным — ёмкостный тачскрин. Теперь диспетчеры в аэропорту могли просто дотрагиваться до экрана пальцем без всякого стилуса.

Технология проста, как всё гениальное — экран кинескопа покрывается проводящей прозрачной пленкой, прикосновение пальца к экрану меняет сопротивление и система получает сигнал — есть замыкание. Простота и надёжность позволили этой системе управлять всеми авиаперелётами в Англии до самого конца 1990-х!

Правда, простота системы не позволила ей стать коммерческим решением — на такой пленке нельзя замерить силу нажатия и что важнее — никакого мультитача. Только один палец за раз.

Четвёртое поколение

В отличие от ёмкостных, резистивные тачскрины были открыты вообще случайно. Его автор Самуэль Херст так описывает этот случай:

Для изучения атомной физики исследовательская группа использовала перегруженный работой ускоритель Ван де Графа, который был доступен студентам только в ночное время. Утомительный анализ данных с бумажных лент сильно замедлял исследования. Сэм придумал способ, чтобы решить эту проблему. Он, Парки, и Турман Стюарт, ещё один докторант, использовали электропроводящую бумагу, чтобы прочитать пару х- и у- координат. Эта идея привела к первому сенсорному экрану для компьютера. С помощью этого прототипа его ученики могли бы сделать нужные вычисления в течение нескольких часов, хотя раньше для достижения этой же цели требовалось несколько дней.

Забросив свои исследования, в 1970 году Херст с девятью коллегами укрылись в его гараже и довели случайное изобретение до совершенства. В результате родилась технология «электрического сенсора плоских координат»:

Два электропроводящих слоя задавали X и Y координаты соответственно. Давление на экран позволяло току течь между X и Y слоями, что легко измерялось на выходе и сразу конвертировалось в числовые координаты. Поэтому такой тип экрана и называется резистивным — он реагирует на давление (resist — сопротивление) а не электропроводимость.

Такая технология оказалась удивительно дешевой и именно ей мы сейчас все и пользуемся.

В 1971 году все это было запатентовано и продано калифорнийским предпринимателем под названием Elographics.

Пятое поколение

Реально же мультитач родился там, где и должен был — в CERN. Мало кто понимает, что основная проблема CERN — управление коллайдерами. В чем эта проблема? Большой Адронный Коллайдер (LHC); ежесекундно будет происходить около миллиарда столкновений, в каждом из которых будут рождаться десятки частиц разных типов. Годовой объём экспериментальных данных оценивается в 10 петабайт (1 Пб = 10 15 байт) — LHC будет давать 1% информации, производимой человечеством. Для обработки и хранения такого потока данных в 1994 году в CERN придумают Интернет. Но в 1973 году перед инженерами встает совсем неожиданная задача.

Запуск протонного суперсинхротрона упёрся в невозможность оперативного управления. Будучи в 10 раз больше, мощнее и сложнее предыдущего ускорителя, он требовал практически бесконечное количество кнопок и переключателей на приборной панели, а управлять всем этим должны всего несколько человек — иначе не получится осуществлять централизованное управление. Как быть?

Выводить от каждого из ста тысяч переключателей отдельный тумблер или… переложить всю работу на компьютеры, которые будут выводить только нужные данные оператору на экран. Для этого нужно лишь придумать эти суперкомпьютеры и экраны, которые позволят легко переключать кнопки нажатием пальцев.

Как вы понимаете, CERN выбрал второй вариант и создал емкостные экраны с поддержкой мультитача — именно их решением мы пользуемся сегодня, когда держим в руках свой айфон.

А начиналось все вот с этих сенсорных матриц. Слева о6разец 1977 года, справа — 1972:

В записке, датированной 11 марта 1972 года, Берн Стампе представил своё решение — емкостной сенсорный экран с фиксированным числом программируемых кнопок, находящихся на дисплее. Экран должен был состоять из множества конденсаторов, вплавленных в плёнку или в стекло медных проволочек, каждый конденсатор должен быть построен так, что поблизости находящийся проводник, такой как палец, приведет к увеличению мощности на значительную величину. Конденсаторы должны были быть проволочками меди на стекле — тонкими (80 ?m) и достаточно далеко друг от друга (80 ?m), чтобы быть невидимыми. В конечном устройстве экран был просто покрыт лаком, который предотвращал касание пальцами конденсаторов.

Пленка была практически прозрачной и совершенно незаметной:

В результате протонный синхротрон управлялся вот с этого пульта всего тремя операторами:

Система настолько опережала своё время, что в ней не было ни одного коммерческого компонента — все элементы производились самим CERN и воспринимались не как узкоспециализированые решения, а скорее даже как «костыли» — вместо гордости инженеры считали, что их решение это «чит» и развлечение, а не серьёзная работа. После коллайдера технология была использована в «Дринкомате» кафетерия — аппарат позволял пальцами на экране смешивать себе коктейль и получать его из аппарата.

Поразительно, что, по сути открыв мультитач, в CERN его так ни разу и не использовали — никаких жестов или знакомых нам функций — мультитач тогда воспринимался просто как возможность нажимать на экране несколько кнопок одновременно. В сторону замечу, что ничего не мешало церновскому тачскрину определять ещё и силу нажатия на экран.

Шестое поколение

Под впечатлением успеха европейских ученых американцы выбивают у правительства грант на конверсию военных тачскринов в образовательных целях. Programmed Logic for Automated Teaching Operations (PLATO) — первая система электронного обучения, к концу 70-х годов состоявшая из нескольких тысяч терминалов по всему миру и более десятка мейнфреймов, соединённых общей компьютерной сетью. Система PLATO была разработана в Университете Иллинойса и использовалась в течение 40 лет. Она была первоначально создана для выполнения простых курсовых работ студентами университета Иллинойса, местными школьниками и студентами ряда других университетов.

Но нас интересует, как именно функционировали терминалы этой системы. Дисплей PLATO IV также имел сетку инфракрасной сенсорной панели размером 16х16, что позволяло студентам отвечать на вопросы касанием пальца в любом месте экрана.

С появлением микропроцессоров были разработаны новые, более дешёвые и обладающие большими возможностями терминалы. Микропроцессоры Intel 8080, встроенные в терминалы, позволяли системе выполнять программы локально, как в наше время выполняются Java-апплеты или элементы управления ActiveX, а также загружать небольшие модули программного обеспечения в терминал, чтобы разнообразить учебные курсы за счёт сложной анимации и других возможностей, недоступных в обычных терминалах. Отдельно отметим оранжевый газо-плазменный экран, дававший впечатляющую картинку.

Любопытно, что в 1972 году в университете штата Иллинойс исследователям компании Xerox PARC была продемонстрирована система PLATO. Были показаны отдельные модули системы — такие, как программа генератора изображений для PLATO и программа для «отрисовки» новых символов. Многие из этих инноваций стали дальнейшим фундаментом для разработки других компьютерных систем. Некоторые из этих технологий в усовершенствованном виде появились в системе Xerox Alto, которая, в свою очередь, стала прототипом для разработок компании Apple.

К 1975 году система PLATO, выполнявшаяся на суперкомпьютере CDC Cyber 73, обслуживала почти 150 мест, включая не только пользователей системы PLATO III, но и гимназии, лицеи, колледжи, университеты и военные объекты. В PLATO IV в составе учебных курсов предлагались текст, графикa и анимация. Кроме того, имелся механизм разделяемой памяти («общие» переменные), что позволяло с помощью языка программирования TUTOR передавать данные между различными пользователями в реальном времени. Так стали впервые создаваться программы для чата, а также первый многопользовательский авиасимулятор. Все это за 30 лет до интернета!

Недостатки? Разрешение сенсора всего 32 квадрата, все еще нет мультитача и стоимость в $12 000.

Седьмое поколение

К 1980-м всем стало очевидно, что без мультитача тачскрин не сможет выйти на рынок. Как известно еще из античности, человек — мера всех вещей. А у человека на руках десять пальцев.

В 1983 году было много обсуждений мультитач-экранов, которые привели к разработке экрана, использующего для управления больше чем одну руку. Bell Labs сфокусировались на разработке софта для мультитач и добились значительных успехов на этом поле, представив в 1984 году сенсорный экран, на котором можно было пролистывать изображения двумя руками.

Следующим шагом в развитии оптических сенсоров стало появление «сенсорных рамок», разработанных в 1985 году в Университете Карнеги-Меллона. Принцип действия подобных дисплеев состоял в том, что рамка дисплея подсвечивалась ИК-лучами, а касание определялось по изменению рассеяния света на границе «стекло-воздух». Подобные дисплеи могли распознавать одновременные касания тремя пальцами.

Находят оптические сенсорные дисплеи свое применение и в наши дни. Их главный плюс – отсутствие дополнительного слоя прозрачного материала. В частности ИК-тач используется в «читалке» Sony PRS-350 и различных промышленных устройствах. Главный минус — избыточная точность и сложность таких систем — и дорого, и обидно тратить ресурсы, которые никогда не будут использованы.

В 1985 году в Университете Торонто группа ученых разработала небольшие емкостные сенсоры на смену громоздким камерам на основе оптических сенсорных систем.

Изобретатели пытаются решить проблему через всякие костыли — кто-то использует тень от рук для определения координат, цветные проекторы или даже микрофоны для эхолокации. Эти системы не получили никакого распространения, но именно на них были созданы все современные известные нам жесты управления. Единственное, чего не могли сделать эти системы — регистрировать нажатия на экран, что их и погубило.

Первая попытка выхода сенсорных технологий на массовый рынок произошла в 1983 году, когда HP решает захватить рынок персоналок, выпустив легендарный HP-150. Крепкая добротная персоналка за $3000 на Intel 8088 с частотой в 8Мгц была в два раза быстрее стандартных персоналок тех дней с частотой в 4,77Мгц, кроме того на борту было от 256 до 640 килобайт оперативки и система MS-DOS 3.20, но главное — экран. Поверх экрана расположились инфракрасные излучатели, образующие сенсорную рамку, 40 горизонтальных на 24 вертикальных сенсоров.

Этот компьютер не смог дать настоящий мультитач и вообще оказался коммерческим провалом — отверстия для сенсоров снизу быстро заполнялись пылью и переставали работать, один палец на экране перекрывал сразу две линии. В 1984 году Боб Бойл из Bell Labs смог усовершенствовать систему, заменив лучи и сенсоры на прозрачный слой поверх экрана, что позволяло реализовать настоящий мультитач, но все было безнадежно… очень быстро оказалось, что человеческие руки совершенно не приспособлены к «тыканию» пальцем в вертикальный экран на весу больше 10-15 минут. То есть вот такие интерфейсы невозможны в принципе:

Это странно и неожиданно — подержать на весу руку десять минут не проблема (но тоже не сахар), а вот тыкать на весу пальцем в стену — невозможно. Рука отекает и очень устает, исследователи назвали этот эффект «Gorrilla Arm», то есть «лапа гориллы».

Восьмое поколение

Борьба с синдромом «Горильей лапы» проливает свет на историю Apple и Стива Джобса, во всяком случае делает ее понятной. Стив Джобс был убежден, что победить этот недостаток можно только одним способом — перенести тачскрин прямо на руку. Положить экран в ладонь или еще каким способом ликвидировать расстояние между пальцами и экраном, заставляющее держать руки на весу. Помните, как Стив специально объяснял, почему на макбуках никогда не будет тачскринов?

Стив настаивает, что нужно не просто ликвидировать этот промежуток, но идти дальше — дать пользователям чистый, интуитивно понятный мультитач без всяких посредников. Мультитач и ничего кроме него!

Но Стива не слушают — его идеи принимают, но его самого «уходят» из Apple. В результате Apple делает свой первый айфон в 1987 году — Newton MessagePad получается лишь пародией на мечту Джобса — да, его можно держать в руке, но никакого мультитача и управление через стилус. В результате пользоваться им неудобно, распознавать рукописный ввод он не может и все тормозит. Критики в восторге, пользователи проклинают сырой продукт. Но Apple идет напролом и выпускает свой планшет еще шесть лет, что ставит корпорацию на грань банкротства.

Этим пользуется Palm, выпуская свой наладонник — единственное его отличие в том, что он делает то, что обещает — например, худо-бедно распознает рукописный текст. Но так же никакого мультитача и работа только через стилус. Все это работает на резистивных экранах.

Девятое поколение

Несмотря на то, что первая поверхность с поддержкой мультитач появилась в 1984 году, когда в Bell Labs разработали подобный экран, на котором можно было манипулировать изображениями при помощи более чем одной руки, эта разработка не получила продвижения.

Начиная с 2000 года стартует гонка за мультитачем. Сони запускает проект SmartSkin, Microsoft делает совместно с IKEA стол Surface, система FTIR становится хитом на YouTube.

Продолжение данный метод получил лишь спустя двадцать лет — в начале 2000-х компания FingerWorks разработала и стала выпускать эргономичные клавиатуры с возможностью использования мультикасаний/жестов, для которых разработала специальный жестовый язык. Спустя несколько лет (2005) она была куплена… компанией Apple.

Вернувшись на пост CEO, Джобс направил все ресурсы Apple на одну простую задачу — сделать продукт, который целиком и полностью будет построен вокруг технологии мультитач. Он борется за каждый грамм веса и миллиметр размера будущего айфона, чтобы победить «лапу гориллы». Он принципиально ненавидит стилусы, и подчиняет весь софт и дизайн одной задаче, даже не задаче, а лишь одному жесту, который он покажет на презентации и взорвет индустрию. Вот этот жест:

На знаменитой презентации 2007 года он разблокирует айфон простым свайпом и пролистывает списки таким же простым движением пальца. Это естественно и очевидно — мы даже не понимаем, насколько круто это было всего десять лет назад!

Именно простота и естественность стали залогом успеха айфона — под это подстроен и весь дизайн интерфейса, имитирующий естественные поверхности — т.н. скевоморфизм. И к тому же, теперь вы знаете, откуда такая ненависть к стилусам.

Итак, нам потребовалось 50 лет, чтобы проделать путь от светового ружья до айфона. Что дальше? Ответ на этот вопрос пытается нащупать московский стартап Surfancy.

Десятое поколение

Все предыдущие 50 лет мы пытались избавиться от клавиатуры и перенести органы управления прямо на экран. В результате сегодня сенсорные решения оказались заложниками своих экранов. А что, если сделать еще один шаг и… отказаться от экрана? Нетрудно видеть, что именно в этом направлении пошли все крупные корпорации — достаточно вспомнить Nintendo Wii или Microsoft Kinect. Но и они крайне ограничены — им нужно особое помещение со строго определенными параметрами освещенности, несколько метров пространства, да и распознавать движения пальцев они не способны.

А что, если представить решение, которое сможет очень дешево и просто делать сенсорным любую ровную поверхность вне зависимости от внешних условий, да и от наличия самой поверхности? Так и родилась идея Surfancy.

Главными особенностями устройства являются легкость монтажа, масштабируемость сенсорной области и высокая помехоустойчивость, система не накладывает рамки (в прямом и переносном смысле) на то, что хочется сделать сенсорным. «Нашу систему можно закрепить на любой поверхности и получить интерактивный рекламный плакат, большой сенсорный экран или умную доску. Но формат при этом задаем не мы, а человек, который пользуется Surfancy. После реализации первого прототипа не могу избавиться от желания «нажать» на нарисованную кнопку на бумажных плакатах в лифтах или вагонах метро», — смеется Дмитрий. Кроме того, система надежна. Среди существующих оптических систем только Surfancy не накладывает какие-либо требования к внешней освещенности и кривизне.

Идея создания нового типа сенсорной панели зародилась у одного из членов команды во время его работы в одной крупной российской фирме, производящей игровые аппараты. Высокая точность, обеспечиваемая используемыми в них сенсорными панелями ультразвукового принципа действия, являлась весьма избыточной, что и дало толчок к разработке более простого и дешевого устройства.

И такое устройство было разработано. В первоначальном варианте оно представляло собой печатную плату, охватывающую край монитора с установленными на ней фототранзисторами, которые поочередно подсвечивались двумя разнесенными вдоль поверхности монитора инфракрасными диодами. Касание поверхности экрана вызывало пересечение оптических потоков инфракрасных диодов и появление при этом соответствующих теней на поверхностях фототранзисторов. Фактически все это напоминает устройство давно известных инфракрасных рамок, т.е. устройств, формирующих сетку лучей, оптически связанных с набором фотоприемников. Однако существенное отличие новой схемы – только 2 излучателя. Новизна данного технического решения была подтверждена патентом РФ на изобретение № 2278423.

На рисунке 1 приведена функциональная схема, защищенная данным патентом.

Рисунок 1

В силу известных причин производство игровых аппаратов было прекращено, и данный проект сенсорной панели был надолго похоронен. Интерес к данному устройству вновь возник, когда на Западе появилось успешное коммерческое решение, позволившее определять положение пальцев руки человека – оператора в пространстве. Речь идет о Kinect фирмы Microsoft. Сразу надо отметить главное достоинство Kinect – ее масштабируемость. Т.е. систему можно встроить в любое приложение, управление которым возможно осуществлять пространственным манипулированием руками человека-оператора. И еще – систему легко установить в любом месте – стоит лишь правильно выбрать зону обзора окружающего пространства, в котором разворачивается сценарий интерактивного взаимодействия пользователя с программным обеспечением.

У новой команды разработчиков появилась идея – занять свою нишу в области пространственного манипулирования и управления, и так же, как ранее в случае с ультразвуковой сенсорной панелью, исключить избыточность, присущую конкурирующей системе.

Под избыточностью в данном контексте надо понимать, что для построения 3D-интерфейса пользователя с программным обеспечением траектория пользовательского жеста может быть однозначно распознана и двумерной измерительной системой. Главное требование при этом – плоская сенсорная область должна быть оптимально локализована в 3D-пространстве. Большой недостаток Kinect, вытекающий из избыточной функциональности, связан с ее принципом функционирования. Как любая активная оптико-локационная система, к которой и относится Kinect, измерение положения объекта требует зондирующей подсветки с последующим приемом отраженного от объекта излучения. Это делает ее чувствительной к паразитным засветкам, отражений от бликующих поверхностей и пр. Таким образом, не удастся поместить Kinect на улице и заставить работать в условиях яркой солнечной засветки.

Последующее развитие технологии «теневой локации», как кратко решили называть запатентованную подсветку объекта контроля двумя пространственно разнесенными излучателями, привело к следующей оптико-геометрической схеме измерений, приведенной на рисунке 2.

Рисунок 2

Сенсорное поле S образуется попарным пересечением оптических потоков ?1, ?2, ?3, ?4 на поверхностях L1 и L2 расположения фотоприемников. При этом, в отличие от схемы на рис.1, появление второй фотоприемной линейки позволило значительно увеличить размер сенсорной области. Помехоустойчивость данной схемы предельно высока, т.к. в ней отсутствует прием отраженного излучения, а высокое быстродействие фотоприемников позволило нам перейти на высокочастотную модуляцию зондирующих излучений светодиодов D1…D4. Данная схема защищена патентом РФ №2575388 и реализована в виде, изображенном на рисунке 3.

Рисунок 3

Надо отметить, что работоспособность данной технической реализации системы сохраняется даже при прямой солнечной засветке линеек, при расстоянии между ними до 6 м.

В заключение следует отметить, что различные типоразмеры данной системы (от 1 до 2-х метров длины боковых линеек) формируются на основе базового фотоприемного модуля, содержащего процессор, набор фотоприемников и от 2-до 4-х излучателей. В функционал устройства заложена возможность распознавания не менее 4-х одновременных касаний. На следующем этапе будет решена задача определения скорости вхождения объекта в сенсорную область.

Команда Surfancy видит будущее сенсорных систем в следующем:

- Появление технологии, позволяющей придать свойство сенсорности поверхностям любой формы.

- Сенсорная ткань, в том числе одежда и обувь.

- Телевизионный проектор с функцией виртуального Touchscreen-а. Т.е. сенсорное поле создается одновременно с формируемым изображением.

Над всеми этими технологиями сейчас работает команда. Надеемся, что коллектив Surfancy в скором времени продемонстрирует решения этих задач.

Начиная с этих выходных мы запускаем первый тестовый прототип прямо в торговом центре МЕГА Химки, и уже через месяц сможем сделать выводы по эффективности системы — поедете за покупками, обязательно потрогайте наш экран. Пока это просто проектор с сенсором, но он работает!

Таким образом, Surfancy должна стать логичным продолжением многодесятилетнего развития сенсорных технологий и, наконец, подарить им свободу от экранов. Сенсорным может стать буквально все, и это открывает бесконечные возможности как для частного использования, так и для рекламы, и особенно розничной торговли.

У нашей команды нет сомнения в успехе проекта — а поддержка от такого гиганта как МЕГА придает нам известную долю уверенности, что в скором будущем с помощью подобных систем посетители торговых центров всегда смогут получить любую справочную, контекстно связанную с интересующим товаром, информацию.

Комментарии (6)

tormozedison

28.04.2016 22:25+2Забыли конкурирующее устройство ввода — световое перо и один из многочисленнных примеров его применения — ПЭВМ «Криста».

sergeykalenik

29.04.2016 12:13+1Криста и аналоги появились только в 1980ых и были основаны на американских решениях по этому о них и не написали — им отдельный пост нужен, а здесь как я вижу только ключевые девайсы определившие ход развития тачскринов, КРИСТА конечно была крута, но уже не успела ничего определить и попала в раздел вымерших систем(

dennyoi

01.05.2016 22:38а зачем? мы как то делали виртуальный футбол в торговом центре, когда дети могли пинать проецируемый на пол мяч. тогда справилось два кинекта и проектор. какой смысл изобретать велосипед для «виртуального» мультитача без экрана?

WebConn

Эм… А про резистивные и емкостные — ничего часом не напутали?

AntonioKharchenko

Было про емкостные чуть-чуть)

> Как вы понимаете, CERN выбрал второй вариант и создал емкостные экраны с поддержкой мультитача — именно их решением мы пользуемся сегодня, когда держим в руках свой айфон.