Концепция ИИ восходит к гораздо более ранним временам, чем время появления современных компьютеров – ещё к греческим мифам. Гефест, греческий бог ремесленников и кузнецов, создал автоматы, работавшие на него. Ещё один мифический персонаж, Пигмалион, вырезал статую прекрасной женщины из слоновой кости, в которую затем и влюбился. Афродита наградила статую жизнью в качестве дара Пигмалиону, который женился на уже живой женщине.

В истории постоянно встречались мифы и легенды об искусственных существах, наделённых интеллектом. Они разнились от просто сверхъестественных источников (греческие мифы) до более научных методов, таких, как алхимия. В художественных произведениях, в частности, в научной фантастике, ИИ стали всё чаще появляться в XIX веке.

Но только когда математика, философия и научные методы развились достаточно для того, в XIX и XX веках ИИ начали принимать всёрьёз в качестве реальной возможности. Именно тогда такие математики, как Джордж Буль, Бертран Рассел и Альфред Норт Уайтхед начали предлагать теории формализации логических рассуждений. С разработкой цифровых компьютеров во второй половине XX века эти концепции нашли практическое применение, и вопрос ИИ начали исследовать по-настоящему.

«Пигмалион», Жан-Батист Реньо, 1786 год

За последние 50 лет интерес к разработке ИИ подкреплялся общественным интересом и успехами, а также неудачами, этой индустрии. Иногда предсказания исследователей и футурологов не соответствовали реальности. Обычно это можно было списать на ограничения компьютеров. Но более глубокая проблема, понимание, что же такое интеллект, стала источником активных споров.

Несмотря на эти неудачи, исследования и разработка ИИ продолжились. Сейчас их проводят технологические корпорации, видящие экономический потенциал таких улучшений, а также академические группы всего мира. На каком этапе находятся эти исследования, и что можно ожидать от ближайшего будущего? Перед ответом на эти вопросы необходимо попытаться определить, что же такое ИИ.

Сильный, слабый и обобщённый ИИ

Возможно, вас удивит, что принято считать, что ИИ уже существует. Как пишет исследователь ИИ из Кремниевой долины под псевдонимом Альберт: «ИИ отслеживает транзакции по вашей кредитке на предмет странных трат, считывает числа, которые вы пишете на ваших банковских чеках. Если вы ищете „закат“ среди картинок в вашем телефоне, именно зрение ИИ находит их». Такой тип ИИ в индустрии называют «слабым ИИ».

Слабый ИИ

Слабый ИИ работает над узкими задачами, к примеру, как Siri от Apple. Считается, что Siri – это ИИ, но она способна работать только в предопределённом диапазоне, комбинирующем небольшой набор задач. Siri обрабатывает язык, интерпретирует запросы и выполняет другие простые задачи. Но у Siri нет сознания, она не разумна, и поэтому многие считают, что её нельзя определять, как ИИ.

Альбрет же считает, что ИИ – нечто вроде движущейся мишени: «В сообществе исследователей ИИ есть внутренняя шутка, согласно которой, когда мы решаем какую-нибудь проблему, люди тут же объявляют, что это не настоящий ИИ». Несколько десятилетий назад возможности такого ассистента, как Siri, посчитали бы ИИ. Альберт продолжает: «Люди считали шахматы вершиной интеллекта, пока мы не победили чемпиона мира. Тогда они сказали, что мы никогда не победим в го, потому что у неё слишком большое пространство для поиска, требующее „интуиции“. Пока мы в прошлом году не победили чемпиона мира».

Сильный ИИ

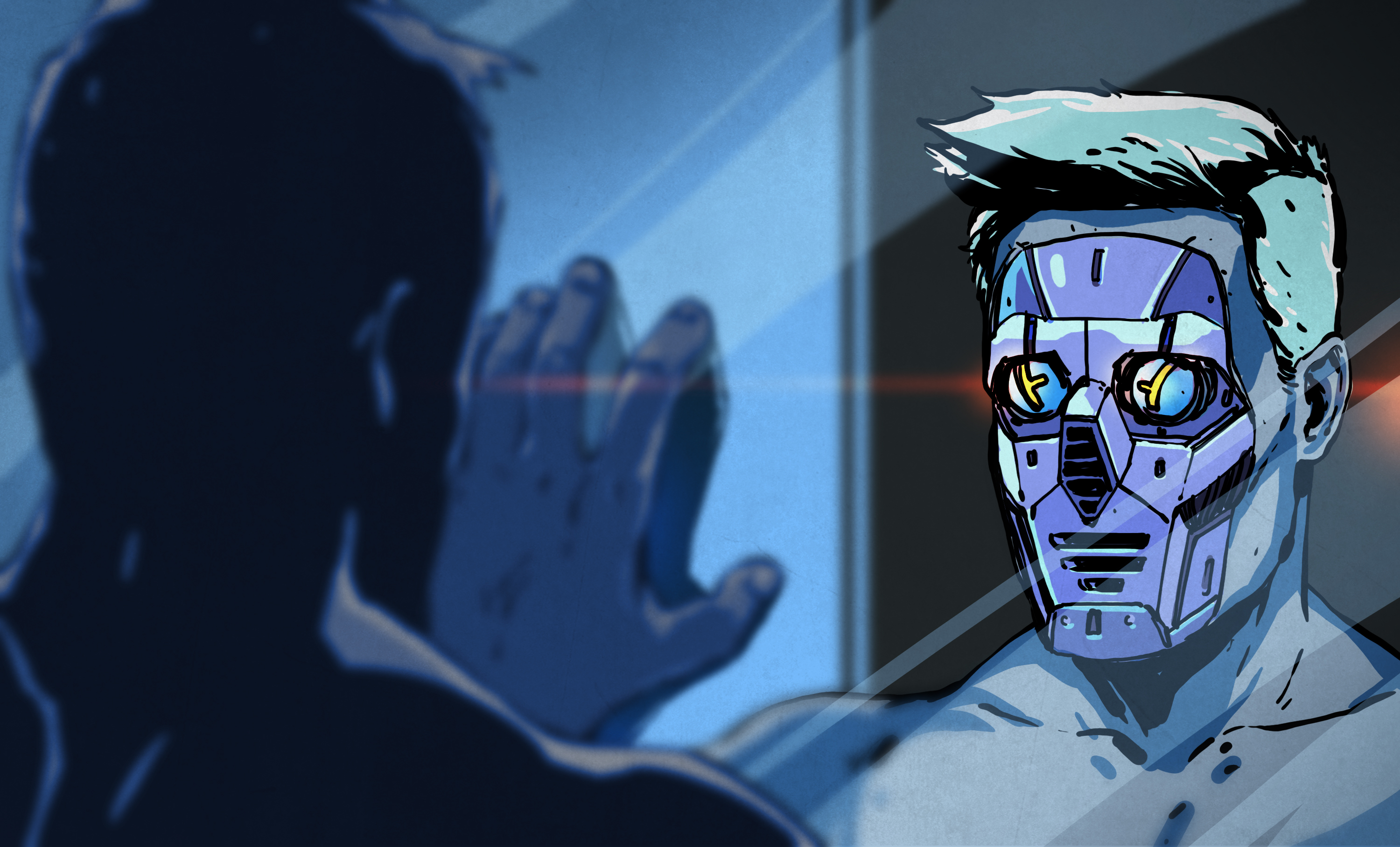

И всё же Альберт определяет такие системы, как слабый ИИ. Сильный ИИ – то, что представляют себе непрофессионалы, когда разговор заходит об ИИ. Сильный ИИ был бы способен на реальные размышления и рассуждения, обладал бы сознанием и разумностью. Такого рода ИИ определил персонажей НФ типа HAL 9000, KITT и Cortana (из игры Halo, а не Microsoft Cortanta).

Обобщённый ИИ

Что же определяет сильный ИИ, и как проверить и определить такую сущность – эта тема всё ещё противоречива и служит источником горячих споров. В любом случае, мы пока ещё не приблизились к созданию сильного ИИ. Но есть ещё один тип систем, ОИИ – это нечто вроде мостика между слабым и сильным ИИ. У ОИИ не будет сознания, присущего сильному ИИ, но он будет гораздо более способным, чем слабый ИИ. Настоящий ОИИ будет обучаться на основе получаемой им информации, и сможет ответить на любой вопрос по ней (а также выполнить связанные с ней задачи).

И хотя большая часть современных исследований сконцентрирована на ОИИ, конечной целью многих служит сильный ИИ. После того, как десятилетия, и даже столетия, сильный ИИ был центральной темой НФ, большинство из нас считают само собой разумеющимся то, что когда-нибудь будет создан разумный ИИ. Однако многие не верят, что это в принципе возможно, и большая часть дебатов по этому вопросу идёт вокруг философских концепций разума, сознания и интеллекта.

Сознание, ИИ и философия

Споры начинаются с очень простого вопроса: что есть сознание? Хотя вопрос прост, каждый, прослушавший курс «введение в философию», скажет вам, что ответ на него совсем не прост. Над этим вопросом все мы коллективно ломали голову тысячелетиями, и мало кто на самом деле пытался дать удовлетворительный ответ.

Что есть сознание?

Некоторые философы даже предположили, что сознания, как его обычно представляют, не существует. К примеру, в книге "Consciousness Explained" Дэниел Денет доказывает, что сознание – это сложная иллюзия, создаваемая разумом. Это логическое расширение философской концепции детерминизма, утверждающей, что всё есть результат единственно возможного следствия из причины. Если довести идею до крайности, то детерминизм скажет, что каждая мысль, а следовательно, и сознание – физическая реакция на предыдущие события, вплоть до взаимодействий атомов.

Большинство людей считают такое объяснение абсурдным – наш опыт сознания так плотно связан с нашим существованием, что мы его не признаём. Однако, даже если принять идею того, что сознание возможно, и что некто им обладает – как доказать, что другая сущность тоже обладает ею? Это переходит в интеллектуальную область солипсизма и философских зомби.

Солипсизм утверждает, что человек может доказать существование только своего сознания. Вспомним знаменитую цитату Декарта «Cogito ergo sum» – я мыслю, следовательно, существую. Хотя многим она кажется обоснованным доказательством наличия сознания у человека, она ничего не говорит о существовании сознаний у других людей. Популярный мысленный эксперимент, иллюстрирующий эту загадку – возможность существования философских зомби.

Философский зомби

Философский зомби – человек без сознания, способный имитировать его наличие. Цитата с Википедии: «К примеру, философский зомби может получить укол острого предмета и не ощутить боли, но вести себя так, будто он её ощущает (сказать „ой“, отпрянуть от стимула, и сообщить, что ему больно)». Это гипотетическое существо может даже считать, что чувствует боль, хотя на самом деле оно её не чувствует.

Нет, не такой зомби

Расширяя этот мысленный эксперимент, предположим, философские зомби родились в какой-то ранний момент человеческой истории, и получили эволюционное преимущество. Со временем это преимущество позволило им размножаться и в результате полностью заменить всех разумных людей. Можете ли вы доказать, что все окружающие вас люди обладают сознанием, или, может быть, они просто хорошо имитируют его наличие?

Эта проблема лежит в центре дебатов по поводу сильного ИИ. Если мы даже не можем доказать наличие сознания у другого человека, как мы можем доказать, что оно есть у ИИ? Джон Сёрл не только продемонстрировал это в своём знаменитом мысленном эксперименте "Китайская комната", но и выдвинул соображение, что в цифровом компьютере невозможно создать разумный ИИ.

Китайская комната

В изначальной редакции Сёрла эксперимент с китайской комнатой описан так: представим, что был разработан ИИ, принимающий на вход китайские символы, обрабатывающий их, и выдающий китайские символы в качестве выходных данных. Он даже проходит с этим тест Тьюринга. Значит ли это, что ИИ «понимает» китайские символы, обрабатывая их?

Сёрл считает, что нет, и что ИИ просто работает так, будто он понимает китайский. Доказывает он это так: если человека, знающего только английский, поместить в изолированную комнату, то он, на основании корректной инструкции, сможет делать то же самое. Человек может получить запрос на китайском языке, выполнить инструкции, написанные по-английски, объясняющие, что делать с этими символами, и выдать на выход китайские символы. Человек не понимает китайского, а просто следует инструкциям. Таким же образом, говорит Сёрл, и ИИ не понимал бы на самом деле того, что он обрабатывает, а просто действовал бы так, будто понимает.

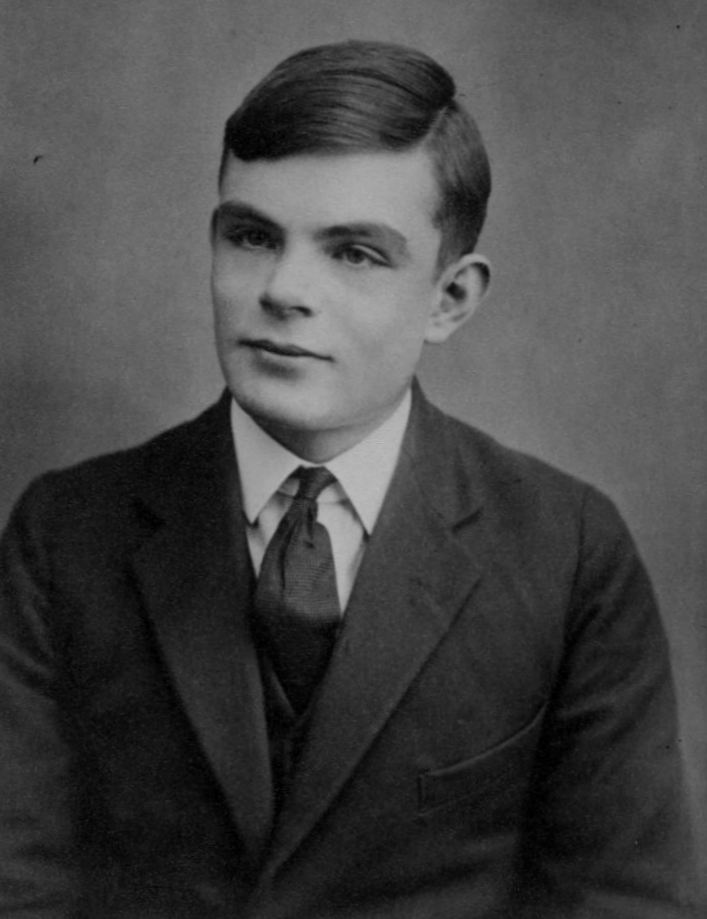

Идея китайской комнаты не случайно походит на идею философского зомби, поскольку обе они рассуждают о разнице между сознанием и внешними признаками сознания. Тест Тьюринга часто критикуют за упрощённость, но Алан Тьюринг до того, как представить свой тест, тщательно рассматривал проблему, схожую с китайской комнатой. Это происходило за 30 лет до публикаций Сёрла, но Тьюринг предвидел такую концепцию, как расширение «проблемы иных разумов» (лежащей в основе солипсизма).

Вежливое соглашение

Тьюринг подошёл к этой проблеме, заключив с машинами "вежливое соглашение", заключаемое нами с другими людьми. Хотя мы не можем знать, обладают ли на самом деле другие люди таким же сознанием, как и мы, из соображений практичности мы предполагаем, что так и есть – мы ничего не достигли бы, ведя себя по-другому. Тьюринг считал, что отвергать ИИ на основании таких проблем, как китайская комната, значило бы применять к нему стандарты более высокие, чем к людям. Поэтому, тест Тьюринга уравнивает подражание сознанию с настоящим сознанием из практических соображений.

Алан Тьюринг

Современные исследователи ИИ считают, что этот отказ от определения того, что является «истинным» сознанием, будет наилучшим подходом для философов. Тревор Сэндс (исследующий ИИ в компании Lockheed Martin, уточняющий, что высказывает личное мнение, а не мнение работодателя), говорит: «Сознание, по-моему, не является необходимым условием для ОИИ, а просто появляется как результат интеллекта».

Альберт соглашается с Тьюрингом, говоря: «если что-то ведёт себя достаточно убедительно, демонстрируя наличие сознание, мы были бы вынуждены относиться к нему, как будто так и есть, даже если на самом деле это может быть не так». И пока учёные спорят с философами, исследователи продолжают свою работу. Вопросы сознания отложены в сторону в пользу разработки ОИИ.

История разработки ИИ

Современное исследование ИИ началось в 1956 году, на конференции в Дартмутском колледже. Многие её участники впоследствии стали экспертами в области ИИ, и отвечали за раннюю разработку ИИ. За следующее десятилетие они разработали ПО, подстегнувшее всеобщее возбуждение по поводу растущей области исследований. Компьютеры могли играть (и выигрывать) в шахматы, проводить математические доказательства (в некоторых случаях создавая более эффективные, чем у математиков, решения), и демонстрировать рудиментарные способности по обработке языка.

Неудивительно, что потенциальное военное применение ИИ привлекло внимание правительства США, и к 60-м годам министерство обороны вливало в исследования финансы. Из-за высокой степени оптимизма эти исследования не сильно ограничивали. Считалось, что вскоре должен произойти серьёзный прорыв, и исследователи работали так, как считали нужным. Марвин Мински, плодотворный исследователь ИИ того времени, в 1967 году заявил, что «в нашем поколении задача создания „искусственного интеллекта“ будет в основном решена».

К несчастью, обещания по созданию ИИ никто не выполнил, и к 70-м оптимизм поутих, а государственное финансирование было уменьшено. Отсутствие финансов серьёзно замедлило исследования, и в последующие годы было достигнуто очень мало. Только в 80-х прогресс «экспертных систем» в частном секторе породил стимулы для финансирования этой области.

В 80-е разработка ИИ вновь хорошо спонсировалась, в основном американским, британским и японским правительствами. Часто встречался напоминающий 60-е оптимизм, и вновь были сделаны крупные обещания по поводу скорого появления ИИ. Японский проект компьютерных систем пятого поколения должен был обеспечить платформу для разработки ИИ. Но неудачи этой системы и другие провалы привели к усыханию финансирования исследований.

На исходе столетия практические подходы к разработке и использованию ИИ выглядели многообещающими. С доступом к большому количеству информации через интернет и мощным компьютерам, слабый ИИ показывал свои преимущества для бизнеса. Такие системы с успехом использовались на финансовом рынке, для обработки данных и логистики, и в области медицинской диагностики.

За последнее десятилетие прогресс нейросетей и глубинного обучения привёл к возрождению области ИИ. Сейчас большинство исследований занимается практическим применением слабого ИИ и потенциально ОИИ. Слабый ИИ уже используется повсеместно, в создании ОИИ совершаются прорывы, и оптимизм по поводу ИИ снова на высоте.

Текущий подход к разработке ИИ

Сегодняшние исследователи активно занимаются нейросетями, примерно повторяющими работу биологического мозга. И хотя изучается возможность настоящей виртуальной эмуляции биологического мозга с моделированием отдельных нейронов, на деле используется более практичный подход – глубинное обучение нейросетей. Идея в том, что способ обработки мозгом информации важен, но не обязательно реализовывать его биологически.

Альберт, как специалист по глубинному обучению, пытается обучить нейросети отвечать на вопросы. «Мечта в этой области – заполучить оракула, способного переварить все человеческие знания и умеющего ответить на любой вопрос о них». И хотя это пока невозможно, он говорит: «Мы дошли до того, что можем дать ИИ прочесть документ и вопрос, и извлечь из документа простую информацию. Самое интересное из передовых достижений в том, что мы начинаем видеть, как эти системы начинают пытаться рассуждать».

Тревор Сэндс работает над схожими вещами с нейросетями в Lockheed Martin. Он создаёт «программы, использующие технологии ИИ, чтобы люди и автономные системы работали, как одна команда». Как и Альберт, Сэндс использует нейросети и глубинное обучение для умной обработки больших объёмов данных. Он надеется придумать правильный подход и создать систему, которой можно было бы задать направление для самостоятельного обучения.

Разницу между слабым ИИ и современными нейросетями Альберт описывает так: «До того одни люди занимались зрением, другие – распознаванием речи, третьи – обработкой естественных языков. Но сейчас все они начинают использовать нейросети, по сути, одну и ту же технику для разных задач. Я нахожу прекрасной такую универсализацию. Особенно потому, что существуют люди, считающие, будто мозг и интеллект – результат единственного алгоритма».

В идеале, нейросеть в качестве ОИИ должна работать с любыми данными. Как и человеческий разум, это был бы истинный интеллект, способный обработать любые полученные данные. В отличие от современных слабых ИИ, его не нужно было бы разрабатывать для определённой цели. Система, способная отвечать на вопросы по истории, одновременно могла бы давать советы по инвестициям в ценные бумаги или поставлять разведывательную информацию.

Будущее ИИ

Однако, текущие нейросети недостаточно развиты для этого. Их нужно «тренировать» на тех данных, с которыми они работают, и объяснять, как их перерабатывать. Альберт говорит, что успех – вопрос проб и ошибок: «Получив данные, мы должны разработать архитектуру нейросети, которая, по нашему мнению, хорошо справится с задачей. Обычно мы начинаем с реализации известной из научной литературы модели, которая работает хорошо. После этого я пытаюсь придумать, как её улучшить. Затем я провожу эксперименты, чтобы посмотреть, улучшили ли работу модели мои изменения».

Главная цель, конечно, же, состоит в нахождении идеальной модели, работающей везде одинаково хорошо. Такой, которую не нужно держать за руку и тренировать особым способом, и которая может учиться по данным сама. Когда это случится, и система сможет реагировать надлежащим образом, у нас на руках будет обобщённый искусственный интеллект.

Альберт и Тревор неплохо представляют себе будущее ИИ. Я подробно обсуждал это с ними, и в следующей статье мы поговорим о будущем ИИ и некоторых других интересных вопросах из этой области. Не переключайтесь.

Комментарии (25)

lavmax

04.03.2017 17:15+2Можете ли вы доказать, что все окружающие вас люди обладают сознанием, или, может быть, они просто хорошо имитируют его наличие?

А в чем разница? В имитации либо не хватает деталей, либо есть погрешности. Если имитация также детальна как оригинал и точно его воспроизводит, то это уже не имитация, а копия.

drafff

06.03.2017 11:54«Если что-то выглядит как утка, плавает как утка, и крякает как утка — это утка и есть» (с)

Никогда не понимал ни концепцию «философского зомби», ни «китайскую комнату». Если что-то выглядит как сознание, и достаточно хорошо его имитирует, то оно обладает сознанием. Все эти имитации — просто лишние сущности.

Так что, по моему, никакой разницы нет.

Наверное, людям неприятно от того, что что-то еще может сознанием обладать.

gerahmurov

06.03.2017 14:59Слова всё-таки имеют смысл, и понятие имитация нужно для простых систем, у которых поведение тоже простое. Или для того, чтобы отделить что-то, существуюшее в природе от подобного, созданного по другим принципам.

InterceptorTSK

07.03.2017 16:56«Если что-то выглядит как утка, плавает как утка, и крякает как утка — это утка и есть» (с)

А еще это может быть хорошая подделка утки, купленная на али…

Вы говорите об имитации не совсем верно… Если вы имитируете некий результат деятельности, т.е. получаете нечто, что вы и хотите получить на выходе, то это вовсе не значит, что получившееся нечто было получено в результате работы интеллекта, сознания и т.д. Примеров же полно, обезьяна может простой комбинаторикой «написать» «Войну и Мир». Все зависит от времени, и кол-ва обезьян. Но это же вовсе не значит, что обезьяны написали «Войну и Мир» сознанием, подобным сознанию Льва Толстого. При этом, конечно же, результат будет идентичен. Но какими путями достигается этот результат?

holyhope

07.03.2017 02:35А почему считают, что у китайской комнаты нет интеллекта? Да, человек, сидящий в ней и исполняющий инструкции, не знает китайского. Но тот, кто создал эти инструкции — определенно знал китайский. И неправильно рассматривать только человека, надо рассматривать комнату в целом, включая и инструкции, и исполнителя — эта система, на мой взгляд, обладает сознанием.

P.S. Зомби — симпатичная :)

rvt

13.03.2017 11:48Зомби — симпатичная :)

А как же! Тонкий расчет создателей фильма. У зрителя начинают возникать всякие неоднозначные ветвящиеся мысли…

А насчет философского зомби или «Китайской нации»… Тут недалеко и до идеи субъективного идеализма и, в частности, солипсизма. Интересная тема.

И еще. У Анатолия Днепрова есть рассказ «Игра» (давно написан, еще, наверное, в начале 1960-х), где множество людей, играя роль элементов ЭВМ, перевели фразу с португальского на русский, не зная, естественно, португальского.

gerahmurov

Спасибо за филосовского зомби — почитал про него, а то пример с болью показался очень противоречивым. И действительно, есть у такого подхода и критика.

Просто если рассматривать боль как сигнал для ответа на раздражитель, то даже в случае филосовского зомби получается, что он получил раздражение, получил сигнал об этом, и ответил на ситуацию. В таком случае не очень понятно, что значит «не чуствует боли». Возможно, его ощущения отличаются от моих, но такое можно сказать про всех, так как неизвестно, как чувствует боль другой человек.

DrZlodberg

Тут есть занятный момент. Люди при определённых неврологических повреждениях могут терять частично или полностью чувствительность тела к тем или иным раздражителям (боли, например). Однако иногда остаётся фантомная чувствительность в том случае, если человек верит, что должен чувствовать и видит подходящий раздражитель. Так же возможна просто имитация в аналогичной ситуации (вспомнилась серия Др. Хауса про девочку, у которой полностью отсутствовала чувствительность кожи к раздражителям, однако она неплохо притворялась при необходимости).

Куда эти варианты отнести?

gerahmurov

Насчёт фантомной чувствительности я не силён, там свои физические процессы наверное. А вот если имеет дело осмысленное притворство для достижения цели, то это уже не зомби.

DrZlodberg

Притворство не обязательно должно быть осмысленным. Машина точно так-же может притворяться, что чувствует боль хотя даже (например) физически неспособна на это (отсутствуют какие либо датчики в том месте).

gerahmurov

Я не уверен, что тут есть притворство, если речь о машине. Либо получается, что машина преследует свои цели методом притворства, либо она запрограммирована на притворство, и тогда это выглядит как рефлекс — в таких-то условиях сделать то-то. Просто датчики другие работают, например, зрительные, и так она заявляет о контакте.

DrZlodberg

Вообще мы тут погружаемся в мутные дебри. Как бы рефлекс есть, и выглядит, как будто оно чувствует боль. Однако ни того, ни другого нет. Имитация наличия ощущений которые могли бы позволить имитировать чувство боли :)

По сути у зомби рефлексы тоже есть (или их имитация) однако зомби они быть не перестают.

gerahmurov

Я к тому, что мне кажется не очень важным, чувствует ли существо боль прямо или опосредовано объявляет её наличие. Либо это корысть, а следовательно — не зомби, либо это зомби, но не имитация, потому что зомби не «притворяется», а такова его программа действий. Боль — всего лишь электрический сигнал, если заменить этот сигнал на сигнал глаза о столкновении с другой материей, и построить систему обработки столкновений на этом, то тоже будет работать.

gerahmurov

Ну т.е. я к тому, что если это не преднамеренная мистификация, то можно назвать систему зомби тем же рефлексом, которого в общем случае зомби избежать нельзя. Как и человеку боли. В некоторых возможно преодолеть, если более высокоуровневые программы вмешаются (или технологии), но по сути боль — лишь средство познания мира и проверки целостности своей системы. Если, конечно, в неё не вкладывать некий высший смысл.

InterceptorTSK

В каком то смысле вы правы. Терминатор, например, «чувствовал» ущерб, и даже неоднократно об этом сообщал окружающим. Чувством в человеческом понимании это назвать сложно. Но суть от этого не меняется. Если есть некий обособленный объект, который способен манипулировать абстракциями типа «боль», «ущерб» и т.д., что одно и то же в данном контексте, на действия некого раздражителя, и по определенной программе выдавать реакцию, т.е. как минимум «чувствовать» «боль», то все в прядке.

Тут конечно же надо добавить, что бывают сбои в программах, как у людей, так и у терминаторов. Программы работают исключительно в рамках «железа». Если «железо» начинает сбоить, то и программы выдают неверные результаты. Например, отпилите у человека ногу (это гипотетически, разумеется), и т.к. нервная система человека достаточно инертная и меняется не так быстро как хотелось бы (а точнее катастрофически медленно меняется), то и получите всяческие фантомные боли в том, чего уж нет давно…

Prome_T

На самом деле не совсем понятно к чему был создан гипотетический философский зомби, по моему было бы удачнее рассматривать людей с аутизмом, синдромом Аспергера, психопатией. Они могут не понимать как вести себя в некой ситуации, так как для них все внешние раздражители, символы, словом вся информация равносильна китайским иероглифам, с которыми человек в изолированной комнате управляется посредством инструкций. Так же им требуются инструкции к неким ситуациям выходящим за рамки их понимания, иначе некая задача, условно, не будет выполнена. Но получив инструкции, они начинают действовать точно так же как нормальный человек, но фактически это и будет тот самый акт имитации.

maslyaev

"Философский зомби" был придуман для пояснения понятия "квалиа". Соответственно, в отрыве от квалии говорить о нём особого смысла нет.

red75prim

А зачем там философский зомби? Просто представьте, что у вас нет квалиа зеленого. Смотрите, значит, вы на стену, и говорите: "Да, зеленая краска потускнела, надо перекрасить". Но квалиа зеленого у вас нет. Но отличить зеленый от не зелёного можете. Но квалиа нет. Восхититься яркостью зеленой травы весной можете. Но квалиа нет.

Примерно такая же история и с философским зомби.

maslyaev

У меня не было бы квалии зелёного, если бы я был слепым. Притом с рождения.

К теме "квалиа" и к связанной с ней теме "филозомби" у меня двойственное отношение. С одной стороны, лучше так, чем совсем ничего. С другой стороны, качество получившейся времяночки так себе.

red75prim

Да. То есть представить себе идентичного вам человека, у которого отсутствует часть квалиа, вы не можете.

В то же время многие считают, что представить философского зомби, у которого отсутствуют все квалиа, но который действует точно также как если бы они были, более того, который физически ничем не отличается от обычного человека — ничего сложного.

Из-за этого я и отношусь с подозрением ко всем рассуждениям с участием философского зомби.

maslyaev

Бихевиоризм утверждает, что такая постановка вопроса некорректна, и если значения характеристик под А подходят, то мы обязаны утверждать, что а — это А баз разговоров. Но по жизни мы понимаем, что это чушь. Если я по всем приметам похож на разыскиваемого убийцу, то из этого ведь не следует, что я это он и есть, правда ведь?

sim31r

Для любого человека можно привести пример с радиоактивным излучением, (или ядом) боли нет, но за минуты можно получить повреждения не совместимые с жизнью. Человек будет вести себя как философский «зомби», осознавая опасность, но без болевого сигнала.

Интереснее с тараканами, опасности нет, но инстинкты и фобии столь сильны, что многие люди предпочтут небольшую дозу радиации «общению» с тараканами или пауками, эксперименты и опросы такие были.

Тема ИИ интересна уже тем, что изучая ИИ, люди больше понимают самих себя.

gerahmurov

>Человек будет вести себя как философский «зомби», осознавая опасность, но без болевого сигнала.

Вот мне кажется, что если опасность (или любая другая выгода в ситуации) осознана, то это уже не зомби.