Новая работа Google предлагает архитектуру нейронных сетей, способных имитировать врожденные инстинкты и рефлексы живых существ, с последующим дообучением в течении жизни.

А также значительно уменьшающую количество связей внутри сети, повышая тем самым их быстродействие.

Искусственные нейронные сети, хоть и похожи по принципу действия на биологические, все же слишком отличаются от них, чтобы их можно было применить в чистом виде для создания сильного ИИ. Например, сейчас нельзя создать в симуляторе модель человека (или мыши, или даже насекомого), дать ему "мозг" в виде современной нейронной сети и обучить ее. Это просто так не работает.

Даже отбросив отличия в механизме обучения (в мозге нет точного аналога алгоритма обратного распространения ошибки, например) и отсутствие разномасштабных временных корреляций, на основании которых биологический мозг строит свою работу, у искусственных нейронных сетей есть еще несколько проблем, не позволяющих им в достаточной степени имитировать живой мозг. Вероятно, из-за этих врожденных проблем используемого сейчас математического аппарата, обучение с подкреплением (Reinforcement Learning), призванное максимально имитировать обучение живых существ на основе награды, на практике работает далеко не так хорошо, как хотелось бы. Хотя в его основе лежат действительно хорошие и правильные идеи. Сами разработчики шутят, что мозг — это RNN + A3C (т.е. рекуррентная сеть + алгоритм актер-критик для ее обучения).

Одним из самых заметных отличий биологического мозга от искусственных нейронных сетей является то, что структура живого мозга преднастроена миллионами лет эволюции. И хотя неокортекс, отвечающий за высшую нервную деятельность у млекопитающих, имеет примерно однородную структуру, общая структура мозга явно задана генами. Более того, отличные от млекопитающих животные (птицы, рыбы) вообще не имеют неокортекса, но при этом демонстрируют сложное поведение, недостижимое современными нейронными сетями. У человека тоже имеются физические ограничения в структуре мозга, которые сложно объяснить. Например, разрешение одного глаза примерно 100 Мп (~100 млн светочувствительных палочек и колбочек), а значит от двух глаз видеопоток должен быть около 200 Мп с частотой не менее 15 кадров в секунду. Но в реальности зрительный нерв способен пропустить через себя не более 2-3 Мп. И его соединения направлены вовсе не к ближайшей части мозга, а в затылочную часть в зрительную кору.

Поэтому не умаляя значения неокортекса (его, грубо говоря, при рождении можно считать аналогом случайно инициированных современных нейронных сетей), факты говорят о том, что даже у человека огромную роль играет заранее заданная структура мозга. К примеру, если младенцу родом всего несколько минут показать язык, то благодаря зеркальным нейронам, он тоже высунет язык. Аналогично происходит с детским смехом. Хорошо известно, что у младенцев с рождения "вшито" превосходное распознавание человеческих лиц. Но что еще важнее, нервная система всех живых существ оптимизирована для условий их жизни. Младенец не будет часами кричать, если голоден. Он устанет. Или испугается чего-то и замолчит. Лиса не будет до полного изнеможения вплоть до голодной смерти тянуться за недоступным виноградом. Она сделает несколько попыток, решит что он горький(с) и уйдет. И это не процесс обучения, а заранее заданное биологией поведение. Причем у разных видов разное. Некоторые хищники сразу бросаются за добычей, а другие долго сидят в засаде. И они этому выучились не в процессе проб и ошибок, а такова их биология, заданная инстинктами. Аналогично, многие животные имеют вшитые программы избегания хищников начиная с первых минут жизни, хотя они физически еще не могли их выучить.

Теоретически, современные способы обучения нейросетей способны из полносвязной сети создать подобие такого предобученного мозга, обнулив ненужные связи (по сути, обрезав их) и оставив только нужные. Но для этого нужно огромное количество примеров, неизвестно как их обучать, а главное — на данный момент не существует хороших способов зафиксировать эту "начальную" структуру мозга. Последующее обучение изменяет эти веса и все портится.

Исследователи из Google тоже задались этим вопросом. Нельзя ли создать начальную структуру мозга, аналогичную биологической, то есть уже хорошо оптимизированную для решения задачи, а потом лишь дообучить ее? Теоретически, это резко сузит пространство решений и позволит быстрее обучать нейросети.

К сожалению, существующие алгоритмы оптимизации структуры сети, такие как Neural Architecture Search (NAS), оперируют целыми блоками. После добавления или удаления которых, нейросеть приходится обучать заново с нуля. Это ресурсоемкий процесс и не полностью решает проблему.

Поэтому исследователи предложили упрощенную версию, которая получила название "Weight Agnostic Neural Networks" (WANN). Идея заключается в том, чтобы заменить все веса нейросети одним "общим" весом. И в процессе обучения подбирать не веса между нейронами, как в обычных нейросетях, а подбирать структуру самой сети (количество и расположение нейронов), которая с одинаковыми весами показывает наилучшие результаты. А после еще и оптимизировать ее, чтобы сеть хорошо работала со всеми возможными значениями этого общего веса (общим для всех соединений между нейронами!).

В итоге это дает структуру нейронной сети, которая не зависит от конкретных значений весов, а работает хорошо со всеми. Потому что работает за счет общей структуры сети. Это похоже на еще не инициализированный конкретными весами мозг животного при рождении, но уже содержащий вшитые инстинкты за счет своей общей структуры. А последующая тонкая настройка весов во время обучения в течении жизни, делает эту нейросеть еще лучше.

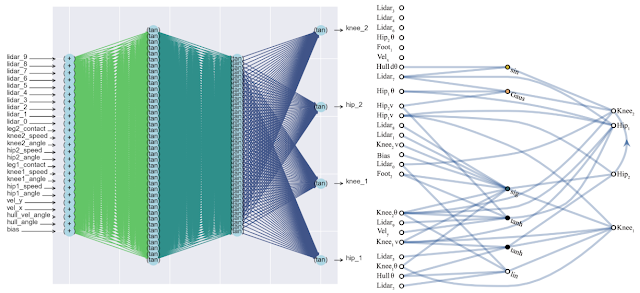

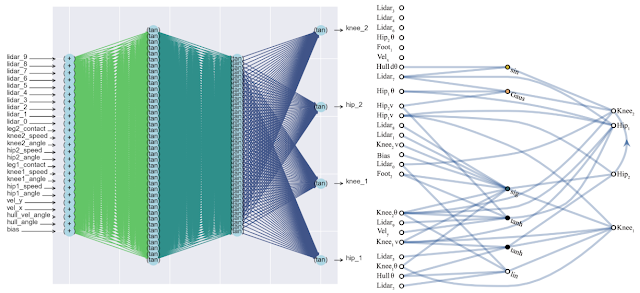

Побочным положительным эффектом такого подхода является значительное уменьшение числа нейронов в сети (так как остаются только наиболее важные соединения), что увеличивает ее быстродействие. Ниже сравнение сложности классической полносвязной нейросети (слева) и подобранной новой (справа).

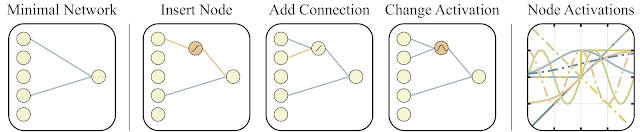

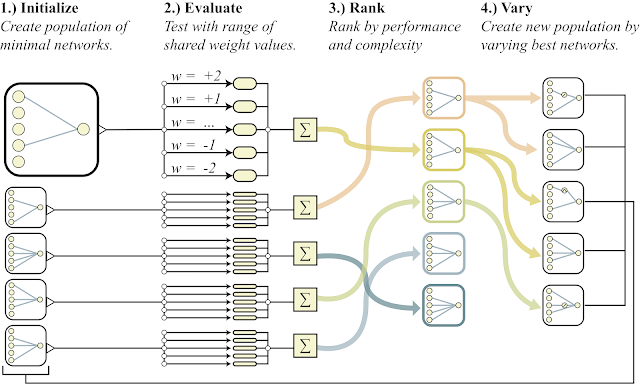

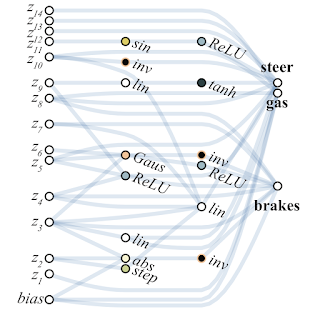

Для поиска такой архитектуры исследователи воспользовались алгоритмом Topology search algorithm (NEAT). Сначала создается набор простых нейросетей, а потом делается одно из трех действий: добавляется новый нейрон в существующее соединение между двумя нейронами, добавляется новое соединение со случайными другим нейроном, либо меняется функция активации в нейроне (см. рисунки ниже). А дальше, в отличие от классических NAS, где ищутся оптимальные веса между нейронами, здесь все веса инициализируются одним единственным числом. И оптимизация осуществляется для поиска структуры сети, которая лучше всех работает в широком диапазоне значений этого одного общего веса. Таким образом получается сеть, которая не зависит от конкретного веса между нейронами, а хорошо работает во всем диапазоне (но все веса по-прежнему инициируется одним числом, а не разными как в обычных сетях). При этом в качестве дополнительной цели для оптимизации стараются минимизировать число нейронов в сети.

Ниже представлена общая схема алгоритма.

- создается популяция простых нейросетей

- каждая сеть инициализирует все свои веса одним числом, причем для широкого диапазона чисел: w=-2...+2

- полученные сети сортируются по качеству решения задачи и по числу нейронов (в сторону уменьшения)

- в части лучших представителей добавляется один нейрон, одна связь или меняется функция активации в одном нейроне

- эти модифицированные сети используются в качестве начальных в пункте 1)

Все это хорошо, но для нейронных сетей предложены сотни, если не тысячи разных идей. Работает ли это на практике? Да, работает. Ниже пример результата поиска такой архитектуры сети для классической задачи тележки с обратным маятником. Как видно из рисунка, нейросеть неплохо работает со всеми вариантами общего веса (лучше с +1.0, но с -1.5 тоже пытается поднять маятник). А после оптимизации этого единственного веса, начинает работать вообще идеально (вариант Fine-Tuned Weights на рисунке).

Что характерно, дообучать можно как этот единственный общий вес, так как подбор архитектуры делается на ограниченном дискретном числе параметров (в примере выше -2,-1,1,2). А получить можно в итоге более точный оптимальный параметр, скажем, 1.5. А можно лучший общий вес использовать как начальную точку для дообучения всех весов, как в классическом обучении нейросетей.

Это похоже на то, как обучаются животные. Имея при рождении близкие к оптимальным инстинкты, и используя эту заданную генами структуру мозга как начальную, в процессе своей жизни животные дообучают свой мозг под конкретные внешние условия. Подробнее в недавней статье в журнале Nature.

Ниже пример найденной WANN сети для задачи управления машинкой на основе пикселей. Обратите внимание, что это езда на "голых инстинктах", с единым общим весом во всех соединениях, без классической точной настройки всех весов. При этом нейросеть получается крайне простой по своей структуре.

Другим вариантом использования WANN исследователи предлагают создавать ансамбли из WANN сетей. Так, обычная случайно инициализированная нейросеть на MNIST показывает точность около 10%. Подобранная единичная WANN нейросеть выдает около 80%, но ансамбль из WANN с разными общими весами, показывает уже >90%.

Как итог, предложенный исследователями из Google способ поиска начальной архитектуры оптимальной нейросети не только имитирует обучение животных (рождение со встроенными оптимальными инстинктами и дообучение в течении жизни), но также позволяет избежать симуляции всей жизни животных с полноценным обучением всей сети в классических эволюционных алгоритмах, создавая сразу простые и быстрые сети. Которые достаточно лишь слегка дообучить, чтобы получить полностью оптимальную нейросеть.

Ссылки

Комментарии (68)

Emulyator

29.08.2019 00:26+1Давно хотел написать что-нибудь простенькое с использованием генетических алгоритмов для эволюции нейронных сетей, но представлял, что кроме вычислительных затрат на просчет «жизни» каждой особи из большой популяции умноженных на число поколений, потребуется еще просчитывать продолжительное взаимодействие со сколько-нибудь интересной окружающей средой. Радует, что появляются интересные подходы в этом направлении, упрощающие задачу.

Но все же, где гарантия, что даже имея в наличии большие вычислительные мощности, мы не застрянем на уровне «насекомых», нейронные сети которых быстро и прекрасно справляются с решением многих задач, но весьма не пластичны и вряд ли потянут на звание ИИ.

ИМХО, нужно как-то разобраться и «украсть» у природы базовые принципы, функции, механизмы взаимодействия различных отделов мозга хотя бы на уровне птиц. Затем попытаться реализовать «в цифре» минимально необходимый набор аналогично взаимодействующих модулей (конечно на уровне распространения простых цифровых сигналов, а не физически реалистичных симуляций всяких натрий-калиевых насосов и потенциалов действия). А дальше уже на эту базу «натравливать» генетические алгоритмы в симуляторах реальности. Среди идей, которые стоит «украсть» у природы, я вижу, например, механизм «опережающего возбуждения», известные виды торможения нейронной активности, «центры боли и удовольствия», механизмы «внимания» и возникновения «автоматизмов» и т.д. И все это должно работать как устойчивая, но динамическая система, постоянно взаимодействующая с меняющимся окружением. Интересно, существуют ли работы в таком направлении?

Xander_Vi

29.08.2019 12:04+1нужно как-то разобраться и «украсть» у природы базовые принципы, функции, механизмы взаимодействия различных отделов мозга хотя бы на уровне птиц

Если провести аналогию с авиацией, то в плане разработки ИИ человечество сейчас на уровне Античности/Средневековья, когда древние инженеры пытались строить летательные аппараты по аналогии с птицами («красть у природы»).

Думаю, невероятный прорыв в этой области произойдет, когда найдутся аналоги братьев Райт в математике и computer science и смогут применить для разработки ИИ принципы, которые отличны от устройства человеческого мозга. Вот тогда можно ожидать сверхстремительного развития этой области и появления полноценного ИИ «с реактивным двигателем».

DesertFlow Автор

29.08.2019 16:36Полностью согласен. Только есть проблема. Именно с такого подхода и начинались работы по ИИ еще пятьдесят лет назад ). Понять принципы интеллекта, не копируя в буквальном смысле мозг животных/людей. Но результата как бы нет… Поэтому изучать и брать что-то из биологии это просто параллельная ветвь исследований, а вовсе не то, к чему мы в итоге пришли. Ничто не мешает продолжать пытаться создать ИИ из первых принципов, так сказать.

phenik

29.08.2019 17:14Поэтому изучать и брать что-то из биологии это просто параллельная ветвь исследований, а вовсе не то, к чему мы в итоге пришли.

Не совсем так. Недавно делал перевод небольшого обзора на тему взаимоотношения нейросетевого ИИ и нейробиологии. Моделирование с помощью ИНС дает весьма серьезные результаты в понимании работы разных систем мозга и даже происхождения чувств, несмотря на их отличие от реальных нейросетей. Влияние взаимное, и эта тенденция, очевидно, будет нарастать.

DesertFlow Автор

29.08.2019 17:18Я имел ввиду, что это не обязательно должно быть финалом исследований ИИ. Я вполне верю, что можно создать сильный ИИ чисто алгоритмически, без всех этих плясок с черными ящиками. Просто не знаю как. А тут вполне видно направление. Раз животные смогли пройти этот путь, то и мы можем повторить за ними.

О пользе нейронных сетей для изучения человеческого мозга (и что можно взять что-то полезное и из него), полностью согласен. Тут еще огромное и неисследованное поле деятельности.

trapwalker

29.08.2019 17:18Забавно будет когда получив сносный ИИ небиологическими методами человечество спустя какое-то время подтянется в аддитивных нано-технологиях и репликации, после чего народ станет баловаться создавая простенькие «живые» ИИ, как сейчас энтузиасты строят вполне работающие махолёты.

daiver19

29.08.2019 20:52Да ладно вам, те же нейросети из общего с реальными нейронами имеют разве что название. А так это чисто математическая конструкция.

COKPOWEHEU

29.08.2019 12:44Но все же, где гарантия, что даже имея в наличии большие вычислительные мощности, мы не застрянем на уровне «насекомых»

Это тоже будет существенным шагом вперед. А там, глядишь, и новые знания получим.

хотя бы на уровне птиц

Ничего себе «хотя бы». А чего не «хотя бы» у человека? Поведение птиц не менее разнообразное, чем у млекопитающих, а структура мозга, где-то слышал, даже более оптимальная (меньше вес при той же вычислительной мощности). Нет, если уж с чего и начинать, то именно с простейших беспозвоночных.

Среди идей, которые стоит «украсть» у природы, я вижу, например, механизм «опережающего возбуждения»

Костыли-то зачем воровать? Это в природе важнейшие ограничения на скорость реакции и скорость обмена импульсами в нейронах. В технике же скорость передачи сигнала на много порядков выше, а приоритете скорее в точности.

Emulyator

29.08.2019 18:14Костыли-то зачем воровать?

Я знаком с основами нейрофизиологии довольно поверхностно и давно не отслеживал последних новостей. Есть достоверные данные или общепринятое мнение, что это только лишь «костыли» и в ИИ не потребуется?

Просто в моей (исключительно субъективной, обывательской) картине устройства мозга этот механизм выполняет принципиально важную функцию — позволяет «узнав» ситуацию, в которую субъект попадал ранее, подготовится к ней оптимальным образом (например, грубо говоря, повторить действия, если предыдущий опыт был удачный либо поступить как-то иначе, если прошлый опыт не порадовал).

COKPOWEHEU

30.08.2019 10:20Сразу скажу что я не биолог, так что выводы будут из простейших соображений.

Насколько я понимаю, механизм опережающего возбуждения похож на предсказание ветвлений в современных процессорах. То есть предварительная подготовка «медленного» блока к заранее предсказанным данным, чтобы ему осталось только уточнить детали. И причина появления такого механизма вполне понятна: «медленный» блок на то и медленный, его надо как-то ускорить. В живой природе от скорости реакции будет зависеть выживаемость, но эта скорость ограничена в первую очередь скоростью биохимии, которая по сравнению с техникой крайне низка. Поэтому и приходится придумывать разнообразные хаки и костыли вроде реконструкции изображения с глаза (на этом основаны обманы зрения). В технике же проблема пока не со скоростью обработки информации, а с точностью и предсказуемостью. То есть и так никто не знает как работает конкретная нейронная сеть. К каким результатам приведет изменение веса конкретного нейрона. А вы предлагаете встраивать еще и механизм предсказания.

Впрочем, именно в силу обучения сети, подобный механизм прекрасно возникнет и сам, если среди требований будет скорость.

Emulyator

30.08.2019 17:35Ну, тогда как неспециалист неспециалисту скажу, что большинство попыток провести аналогию работы мозга с чем-то понятным и известным, будь то, компьютеры, процессоры, операционные системы, известные алгоритмы и шаблоны проектирования зачастую больше вводят в заблуждение, чем улучшают понимание. Но даже если рассматривать аналогию с предсказанием ветвлений в процессорах, то можно заметить, что, процессор в случае ошибочного прогноза к моменту «действия» просто откатится к состоянию «до ветвления» и чуть медленнее, но с неизменными результатами пройдет по единственно правильной ветке. Все предопределено, и, действительно, возможная разница только в скорости исполнения набора команд.

В случае же с живым мозгом нет единственно правильной последовательности инструкций которые нужно просто исполнить с той или иной скоростью, нет возможности сбросить состояние, даже нет возможности точно просчитать результат движения не по той ветке. Собственно говоря, «правильной» ветки тоже нет, потому что в природе нет (прости Господи) программиста, который знает как правильно. Вероятно критерием, который в природе можно в некотором роде принять за НЕправильность выбранной ветки — это исчезновение особи вместе с головным процессором без благодарных потомков.)

Окружающая среда не является частью мозга, с ней надо взаимодействовать напрямую (что чревато) или обращаться к предыдущему опыту такого взаимодействия. А как обратится к предыдущему опыту? — Подать на входы нейронов внешние образы текущей ситуации (например горячий чайник), прогнать их через нейросеть отключив моторику(чтоб случайно рукой не хватануть, но отголоски былой боли вспомнить) и потом уже по прогностическому отклику «выбирать ветку».

Не берусь категорично утверждать и поставлю вопрос: получается, что без механизма опережающего возбуждения (в широкой интерпретации) в нейросетях тяжеловато обратится к предыдущему опыту?

DesertFlow Автор

30.08.2019 21:51Вероятно критерием, который в природе можно в некотором роде принять за НЕправильность выбранной ветки — это исчезновение особи вместе с головным процессором без благодарных потомков.)

И то не всегда, есть стратегии альтруистического поведения. Когда отдельные особи жертвуют своей жизнью ради выживания популяции. И это характерно не только для человека. Если не ошибаюсь, подобное поведение есть даже у некоторых бактериальных колоний.

Emulyator

30.08.2019 23:57Согласен, пусть непрямые потомки тут как бы есть, но вот на их благодарность рассчитывать приходится далеко не всегда, по крайней мере у человеков. )

Alonerover

29.08.2019 12:50«Но все же, где гарантия, что даже имея в наличии большие вычислительные мощности, мы не застрянем на уровне «насекомых»»

«Застряли» насекомые на своей эволюционной ветке не из-за структуры их нейросетей, а по совсем другим причинам:

1 — отсутствие полноценных лёгких,

2 — не замкнутая кровеносная система,

3 — твёрдый внешний скелет.

Как результат — это в целом налагает структурные и метаболические ограничения как на размер тела в целом, так и на размер самого мозга.

Emulyator

29.08.2019 18:55То, что насекомые «застряли» — не страшно, у них тоже много чего можно позаимствовать для прогресса, в том числе из структуры нейросети, но раз уж в статье упоминался «сильный ИИ», то насекомые не вариант.

COKPOWEHEU

30.08.2019 10:22А в чем принципиальная разница нейросети насекомого и высшего позвоночного? Именно принципиальная, то есть не количество нейронов или связей.

Emulyator

30.08.2019 18:28+1Освежив по википедиям старые знания докладываю): Есть мнения, что заметный отрыв в когнитивных способностях человека от меньших братьев обусловлен хорошо развитой новой корой. У млекопитающих этот неокортекс есть, но развит меньше, у птиц нашли какой-то его аналог. А насекомые — это существа с ганглионарной нервной системой. Это, грубо говоря, обученные эволюцией, но «замороженные» нейросети с очень ограниченными способностями к обучению, но способные реализовать весьма сложные программы поведения. Еще механизмы этого обучения похоже отличаются от таковых у высших животных, поэтому сделать шустрый дрон-убийцу на базе нервной системы насекомого самое то, а сильный ИИ нужно растить из чего-то посложнее.

phenik

29.08.2019 07:28Эволюцию тоже можно считать этаким «учителем» обучающим мозговые нейросети живых организмов своим специфическим методом — отбором наиболее удачных с точки зрения выживания вида. Но вовсе необязательно копировать ее подход, если только не ставится задача исследования биологической эволюции нейросетей. Эволюция действует методом проб и ошибок, до некоторой степени целенаправленный подход человека может скомпенсировать этот случайный поиск по результатам и времени. Это как селекционный отбор, он эффективнее в достижении целей, нежели ждать, когда вдруг появится порода коров с большими удоями молока естественным образом. ИНСы, действительно, только моделируют свойства естественных нейросетей. Но это не значит, что для достижения практических результатов нужно стремиться сделать их как можно точнее похожими на нейросети мозга, включая способ обучения. Если только не решаются исследовательские задачи, например, связанные с выяснением, как их функционирование приводит к возникновению различных ментальных феноменов. Поэтому предобучение, аналогичное инстинктам в биологических организмах, кот. выработаны эволюцией, можно реализовать в большой сети в общем порядке обучения с учителем. Затем исследовать структуру сети, и по заранее заданным критериям точности, удалить из нее не задействованные участки и участки мало влияющие на результат обучения, с целью повышения ее эффективности и времени реагирования при использовании. Эффект должен быть приближенно таким же, какой добились в статье.

Alex_ME

29.08.2019 11:22ИМХО, генетические алгоритмы, RL и так далее — это именно селекция, ведь мы заедем фитнес-функцию. Например, у коров была фитнес-функция — удои молока, а у нейросети, обучающей управлять обратным маятником — время удержания. И правильный выбор фитнес-функции является критическим важным для подобных алгоритмов, чтоб достичь результата.

phenik

29.08.2019 13:14И правильный выбор фитнес-функции является критическим важным для подобных алгоритмов, чтоб достичь результата.

Об этом и речь, человек задает критерий отбора, и это эффективнее, чем делает эволюция, даже если речь о селекции. Кроме того мой пример с удойными коровами не совсем удачный) природе они не нужны, поэтому вряд-ли появятся, они нужны человеку, и он задает такой странный, с точки зрения эволюции, критерий отбора. Но и продолжая дело эволюции человек может достичь лучших успехов и быстрее, чем она. Человек результат миллионов лет эволюции, если брать точкой старта примитивных гоминид. Человек за тысячелетия, с тех пор как появилась наука в современно виде, вполне вероятно, сможет создать более совершенный ИИ на новой технологической основе, превосходящий человеческий биологический интеллект. Надеюсь хотя бы вначале они будут в симбиотических отношениях, глобальная эволюция не отбрасывает своих полезных наработок просто так) Звучит несколько противоречиво, но считаю, что человек это не только биологический вид, но и воплощение самой эволюции, кот. его руками и интеллектом будет действовать более эффективно и быстрее, нежели старым методом отбора.

sdfleod

29.08.2019 15:33Удаления связей из обученной сети хорошая мысль, но ее намного проще реализовать на таких сетях как в статье, мне кажется можно использовать тот-же механизм. Вначале идет эволюция и сложность сети увеличивается, затем начинается этап регресса когда связи и нейроны удаляются, до тех пор пока могут выполнять свою работу. Повторяя цикл несколько раз может получится примерно такая же структура как в мозге с древними старыми и новыми структурами.

DesertFlow Автор

29.08.2019 16:51Недавно была такая работа: MorphNet. Там как раз сеть расширялась, потому сужалась и так несколько раз. В итоге получалась более компактная сеть, не уступающая по точности оригинальной. Но вообще, за последние пару лет было предложено много вариантов как делать distillation сетей (т.е. сжатие, выделение знаний). В нейросетях ведь по определению огромная избыточность. И это очень интересная область, потому что похоже, что проще обучать сложные сети, а потом делать из них выжимку, которая будет работать на слабых устройствах. Сейчас вот достигнуто стабильное примерно 10-20-кратное уменьшение без потери точности. И это явно далеко не предел.

IrmaVeoll

30.08.2019 00:15Да, в NEAT такой подход («фазовый поиск») применяется: sharpneat.sourceforge.io/phasedsearch.html

Второй способ получения простой и компактной сети — мультикритериальная оптимизация (он, кстати, упомянут в статье). Это когда отбор производится сразу по двум критериям: высокий фитнес и низкая сложность сетки. Вот тут есть видео, где мы подбираем сеть для вычисления XOR'а как раз этим способом. Минимизируем только число связей, а не кол-во нейронов, как в статье.

morincer

29.08.2019 08:50+4Все новое — это хорошо и основательно забытое старое. Обзор методов эволюции нейронных сетей — я эту статью написал 9 лет назад, картинок там, к сожалению, нет, зато есть описание и сравнение разных подходов.

Кстати, NEAT был предложен еще в 2002 году и потом еще дорабатывался (в частности, есть его вариация HyperNEAT).

DesertFlow Автор

29.08.2019 16:55Ага. Сюда только добавили одинаковые веса по всей сети, и оптимизировали дополнительно чтобы сеть работала в широком диапазоне этих чисел (и минимальный размер еще). Чтобы получить нечувствительность сети к начальным весам. К чему это может привести, хороший вопрос. Сами авторы в оригинальной работе говорят, что это только первый шаг в исследовании этого направления. Есть какие-то успехи, это заработало, вот и хорошо, можно продолжать изучение. Тут больше эмпирики и творчества, чем строгой науки.

amarao

29.08.2019 10:22+2К примеру, если младенцу родом всего несколько минут показать язык, то благодаря зеркальным нейронам, он тоже высунет язык.

Брехня. Младенец несколько минут родом нифига не видит и не умеет фокусироваться, так что никакого языка он не покажет.

DesertFlow Автор

29.08.2019 16:00Эксперимент Мелцоффа, 10-минутный новорожденный повторяет высовывание языка за взрослым: www.youtube.com/watch?v=k2YdkQ1G5QI

amarao

29.08.2019 16:02А теперь у меня есть два варианта:

- Поверить ютубу

- Поверить эмпирическому опыту.

DesertFlow Автор

29.08.2019 17:11Дело не в этом. У низших животных почти все задано инстинктами, причем довольно сложное поведение. У человека же почти все эти функции перешли к неокортексу. Который не содержит никаких инстинктов. Он как чистый лист, обучается целиком в процессе жизни. Это дало офигенные преимущества в адаптации, хоть и потребовало более долгого обучения. Ну и чисто за счет своего размера, позволил обучиться большему числу вещей. Но какие-то низкоуровневые вещи остались и у человека. Вроде этих зеркальных нейронов, или navigation cell (навигационные нейроны, формирующие карту знакомого пространства). Это большой и открытый вопрос, формируют ли эти физические предустановки возможности интеллекта?

Сейчас RL весьма слаб в общей обучаемости. Скажем, есть пример в OpenAI Gym где человечек в симуляторе учится быстро бегать. Там целевая функция скорость бега. Загружаете этот пример, все работает, все обучается. Но если в начальный момент человечек будет не стоять, а лежать на земле, т.е. должен сначала встать, а потом побежать, то этот же пример никогда не обучится! Ни одним из существующих самых современных алгоритмов RL! Да что там, даже изменив какой-нибудь гиперпараметр, уже с большой вероятностью ничего не обучится.

Поэтому возникло что-то вроде иерархического подхода. Давайте сначала обучим его вставать. А потом, используя эту сеть как начальную, обучим бегать. От простого к сложному. Но и тут возникают проблемы, сеть переучивается, катастрофическое забывание и так далее. Пока никому не удалось реализовать такой последовательный подход.

Эта статья примерно из той же оперы — может попробовать базовые рефлексы (способность бегать, ну или как на картинке в статье — способность машинки удерживаться на дороге) задать структурой сети, а более сложное обучение продолжить поверх нее? Тем более, что похожий процесс мы видим при обучении у животных. Я конечно забегаю вперед, это только предположения. В реальности все может оказаться совсем не так, и этот подход тоже не сработает. Но хочется верить в лучшее.

yatanai

29.08.2019 18:28Сколько я ни пытался следить за этим, ни разу не видел нейросети построенные по типу нейрогенеза.

Давным-давно у меня была идея что при приходе данных от узла, если данные «новые» то появлялся новый нейрон и обучался постепенно и подстройка постепенно спадает… *отложено*

Тем более, что похожий процесс мы видим при обучении у животных.

А ещё, сколько бы я ни читал, не могу найти нейросети которые работают с картинками как у животных. Всмсл, вроде, зрительная информация нехило так обрабатывается ещё до того как она поступит в зрительную кору. (Освещение, границы объектов и направления, цвета и прч)

phenik

30.08.2019 07:33А ещё, сколько бы я ни читал, не могу найти нейросети которые работают с картинками как у животных. Всмсл, вроде, зрительная информация нехило так обрабатывается ещё до того как она поступит в зрительную кору.

Автоэнкодеры не рассматривали?

yatanai

30.08.2019 08:38Это немного не то, но интересно… Какбы после всего этого.

Ммм…

Я про то, еслиб вместе с видео потоком в 1080 шла «карта» насколько линии горизонтальны или вертикальны в 480. Какбы вспомогательная информация. Насколько я знаю, подобные вещи есть в нашем моске.

Или как лучше понять что объект освещён, через карту освещения или через картинку 3-мя компонентами цвета? Надеятся что ИНС может сама догадаться до этого, лучше не стоит.

DesertFlow Автор

30.08.2019 15:56Насколько я знаю, эти упрощённые «карты» горизонтальных и вертикальных линий формируются, но уже в зрительной коре, а не до нее. Рецептивные поля, вот это все. В сверточных нейронных сетях это называют «features» — содержание внутренних и выходных слоев в сверточной сети. Вроде как доказано, что эти карты фич в искусственных сетях совпадают с теми, что формируются в зрительной коре животных.

Про нейрогенез интересно, но разве он имеет аналоги в природе? Нейроны ведь формируются как и все клетки — за счёт градиентов растворов внутри клетки и давления от соседних клеток, а вовсе не от сигнала. А вот аналог того, как в природе формируются аксоны и дендриты, то есть связи между готовыми нейронами в зависимости от частоты сигнала, был разработан ещё на заре компьютерной техники. Это правило Хэбба и его модификации. Но такое обучение нейросетей не показало хороших результатов, градиентные методы оказались намного эффективнее.

yatanai

30.08.2019 19:29Ладно, просто про «карты» линий я имелл ввиду, что в глазе есть большие клетки для определения направления границы светло\темно… Ладно, фиг с ним, я мог что-либо забыть.

Простите, но я уже не помню про нейрогенез. Помню лишь что при рождении он достаточно активный и важен в дальнейшем развитии(иначе патологии). И всё к тому что моск появляется не сразу готовый, а достраивается постепенно и также модифицируется во время работы. Это не отменяет того, что он может учится. Просто при исчерпании запасов начнутся разного рода «трудности».

Я пытался сделать свою ИНС… Да, там было ограниченное пространство которое я задавал, что не позволяло ей разрастаться слишком сильно. Надеялся это поможет ей в само оптимизации… Вообще я туда много фич пытался запихнуть, к примеру — можно было обрывать\понижать связи\веса нейронов по критерию, или делать нейроные группы задавая им номер(-а) «нейромедитора»и как они влияют на них. Все эти, и многие другие, «костыли» казались лучшим подходом, чем чистая «математика».

Этот клеточный автомат который делал… На моём селероне если клеток 50+ так дико всё лагало, что я бросил эту идею :) (Я тогда писал под .NET) Сама ИНС была «обучение с учителем» использовал так чтоб учить их жрат, размножаться и не умирать.

(Копания в железе (FPGA\asm) меня больше увлекало, туда и ушёл потом бросив это всё)

phenik

30.08.2019 08:27У человека же почти все эти функции перешли к неокортексу. Который не содержит никаких инстинктов. Он как чистый лист, обучается целиком в процессе жизни.

Тут можно такую философию развести) Заранее не известно, что считать базовыми способностями, и использовать их как инстинкты, и каким остальным способностям обучать потом. Эволюция делала эту декомпозицию методом проб и ошибок, и можно конечно позаимствовать результаты ее работы. Но возможно это не самое лучшее решение. Почему? Потому что у эволюции были ограниченные возможности, ее решения основаны на возможностях и ограничениях биологии, и соответствующей энергетике. Помним, что ~2% массы мозга потребляет ~20% всей мощности организма. А есть еще ограничения на скорость распространения информации в нейронных сетях, и производительность. Процессоры и коммуникационные сети тоже имеют подобные проблемы и ограничения, физика та одна кругом) Но мы можем, в отличии от природы, варьировать технологическими решениями, а не завязываться на одну. И соответственно получать преимущества по всем эти показателям производительности вычислений. Поэтому для мощного ИИ на нейросетях можно использовать большую однородную сеть для обучения, и сильно не париться иерархической декомпозицией входных данных, сеть сама ее произведет. Условно говоря в такой сети появятся аналоги специализированных отделов мозга в виде связанных подсетей. Далее необходимо произвести оптимизацию сети, удалив не используемые или малоиспользуемые участки по определенным критериям, чтобы улучшить показатели производительности и энергоэффективности.

Имеется важный вопрос со структурой такой сети. В мозге она иерархическая, и информация подвергается непрерывной интеграции по мере движения в верхние уровни. Фактически это сжатие информации с потерями. Действительно, на самом верхнем уровне абстрактного мышления исходные образы кодируются понятиями, кодируемыми символами или звуками. Этого эффекта можно добиться структурой сети с уменьшающимся числом нейронов в слоях. Такая структура решает сразу две проблемы — сжатия информации и повышения энергоэффективности. У животных это меньше выражено, условно говоря, у них структура сети более прямоугольная, и они оперирую целыми образами, и в целом образным мышлением. У человека оно тоже осталось, и преобладает в в первые годы жизни, но затем, по мере обучения, уступает абстрактной форме мышления. Тут можно пофантазировать. А нельзя организовать искусственную сеть, как у животных, и получить ИИ базирующийся на образном мышлении? Преимущества очевидны. Из-за того, что нет сжатия с потерями, или они не большие, сохраняется полный контекст информации. Возникает меньше неоднозначностей в коммуникациях и понимании. Одно дело сказать яблоко, и каждый человек представит свое яблоко, и чтобы они у все были одинаковыми нужно как можно точнее передать контекст, т.е. доп. информацию для согласования. И другое дело передать образ конкретного яблока, и не нужно затрат на передачу контекста. Но все это потребует затрат на производительность и энергетику таких сетей. Эволюция обошла эту проблему, развив абстрактное мышление, в угоду точности. Но технологии возможно позволят решить эту проблему. Как-то так)

morincer

29.08.2019 17:18Оба варианта неправильные, когда речь идет о науке. Верить лучше результатам правильно поставленного эксперимента, опубликованным в рецензируемом научном журнале с хорошей репутацией, желательно воспроизведенном независимыми исследователями.

Справедливости ради стоит отметить, что эксперимент Мелцоффа (Andrew N. Metlzoff) не является стопроцентным фактом, и в некоторых исследованиях не воспроизводился.

https://en.wikipedia.org/wiki/Intermodal_mapping — см. разделы Criticism и Replication

amarao

29.08.2019 17:20Вы как-то странно науку описываете. Мне кажется, по сравнению с верой в авторитетные журналы с хорошей репутацией надо куда больше верить воспроизведению эксперимента своими силами.

А эксперимент примитивен — показал младенцу язык, он показал его в ответ.

… Или мне обязательно надо делать два независимых ракурса, которые потом склеивать — на лицо исследователя и на младенца, показывающего язык?

morincer

29.08.2019 17:42Нормально описываю, антивакцинщикам назло :)

Все, к сожалению, гораздо сложнее. Результаты "примитивного" эксперимента можно трактовать очень по-разному.

Может быть, данный конкретный младенец так реагирует на данное конкретное лицо — просто потому, что нейрончики так сцепились? Может быть, во время открывания рта взрослый рефлекторно нажимал на ребенка или тот реагировал не на какой-то другой фактор (хотя бы — запах изо рта)? Может быть, экспериментатор принял шевеление губ ребенка за высовывание языка и, желая успешно отчитаться, поставил плюсик там, где не надо? И куча других вопросов и побочных факторов, множество из которых субъективны.

Поэтому эксперимент нужно ставить на многих младенцах, разных возрастов, рас, полов и т.п. и с которыми работают разные взрослые — мужчины, женщины, старые, молодые. И контакт между ними исключить до только визуального (например, прозрачная ванна с крышкой). Крайне желательно при этом применять "двойной слепой метод" (см. https://ru.wikipedia.org/wiki/%D0%A1%D0%BB%D0%B5%D0%BF%D0%BE%D0%B9_%D0%BC%D0%B5%D1%82%D0%BE%D0%B4) — т.е. оказывается, что два независимых ракурса, как раз-таки, обязательны — одна камера снимает малыша, одна камера снимает взрослого. Потом при расшифровке независимое лицо пишет — на 0:35 секунде ребенок открыл рот, на 0:48 — высунул язык, а другой — делает то же самое с записью взрослого.

И только потом, когда все эксперименты окончены, все результаты сводятся в одну таблицы и, собственно, экспериментатор начинает их смотреть и пытаться как-то трактовать результаты.

amarao

29.08.2019 17:46Но при этом у нас есть обратное: если новорождённые чаще всего не высовывают язык в ответ, то эксперимент можно считать успешно негативным.

morincer

29.08.2019 18:00Именно — это и есть трактовка результатов эксперимента :) Обычно, формулировку исходной гипотезы постепенно сужают (где-то на днях видел картинку: теория всего => теория чего-то => теория ничего), и это и есть суть научного поиска.

Правда, при публикации результатов в популярном виде, журналисты обычно краевые условия для краткости и пущей важности опускают и вместо "у новорожденных детей в возрасте от 45 минут до 72 часов наблюдается статистически значимая корелляция между собственными мимическими действиями и мимическими действиями, демонстрируемыми взрослым объектом" получаем "младенцы младше часа от роду уже высовывают язык вслед за папой и мамой" — даже, если таковой младенец в положительных результатах был всего один :)

dim2r

29.08.2019 10:32У нас инстинкты устроены по принципу мультиагента. Если ты голоден, то смотришь на еду. Если больно, то внимание переключается на место боли. Если еще чего-то хочется, то глаза и мысли как-бы начинают управляться из какой-то подсистемы. То есть существует некий брокер, который включает то одну подсистему, то другую. Эта подсистема начинает управлять органами чувств, руками, ногами в своих интересах.

DrunkBear

29.08.2019 11:03Причём, брокер с багами: например, когда кажется, что ты хочешь есть, но вроде ел недавно — на самом деле, организму не хватает жидкости. Просто брокер не в курсе, что уже можно безопасно попить воды и привык жидкость получать с едой.

Или известный баг с вытеснением мыслей о неприятных делах.

dim2r

29.08.2019 11:16Брокер обучаемый, поэтому есть привычки, которые в новых условиях могут не работать.

Или известный баг с вытеснением мыслей о неприятных делах.

Это уже более высокоуровневый механизм.

yatanai

29.08.2019 16:02А как же «баги» у котиков? Если кинуть на морду квадратную лепёшку плавленного сыра, то, больше половины (по моим экскрементам), попытается сбросить лепёху, а потом «зависает». Не-не у меня кот так минут 5 стоял пока я её не снял :D (Потом перестал у меня еду просить...)

Если поискать и у меньших братьев тоже «баги» найдутся

Alonerover

29.08.2019 13:00«То есть существует некий брокер»

— А может нет никакого «брокера»? Попадалась статья, указывающая на возможность участия в выполнении функций настройки живых НС механизма эмоций. Вот статья:

Сергей Мурик — О природе эмоций, или Что чувствует амёба в горячей воде, «Наука и жизнь», №6, 2006

elementy.ru/nauchno-populyarnaya_biblioteka/430317/O_prirode_emotsiy_ili_Chto_chuvstvuet_amyoba_v_goryachey_vode

dim2r

29.08.2019 13:05Может и нет, просто какая-то система активируется и захватывает контроль.

Если голоден, будешь искать еду. Если зачесалась спина, то начнешь чесать.

Мультиагентность есть, сходите на семинар по психологии с названием «самостоятельные единицы сознания». После небольшого погружения в свою психику довольно легко различить подсистемы.

yatanai

29.08.2019 17:31Это называется фокус внимания. Из-за особенностей методов обучения в моске, он не может сразу «думать» о нескольких вещах и принимать сразу несколько решений. Поэтому различная информация концентрируется и вводится по степени важности.

Вся эта концентрация свойственна на всех уровнях в моске, от всяких сенсоров до образов в вышей НС.

И да, вы не можете держать в фокусе сразу несколько вещей (Многозадачности в мозге нет). Но можете анализировать несколько вещей с малой задержкой и позже суммировать результаты.

dim2r

29.08.2019 17:49Что-типа шины данных с возможностью приоритезации сигнала. Некоторые сигналы идут с большим приоритетом, особенно что касается сигналов выживания. Некоторые с меньшим приоритетом, например что-то может обработаться ночью во сне.

DesertFlow Автор

29.08.2019 23:26А как реализован этот механизм внимания? Вот в мышечных двигательных нейронах если активен нейрон, отвечающий за определенную мышцу, он автоматически тормозит соседние нейроны, отвечающие за мышцы с противоположной стороны (иначе мы вообще не смогли бы согнуть руку, например). Скорее всего и тут так же. Мозг думает всегда сразу о нескольких вещах параллельно, но победитель забирает все. Наиболее активные в данный момент нейроны либо тормозят специальным нейромедиаторами остальные, либо через положительную обратную связь сверхвозбуждаются и тоже забирают себе все лавры. Все кровоснабжение, например. А когда стимул удовлетворен, наиболее активной группой оказываются какие-то другие нейроны из оставшихся параллельных. Получается и внимание, и автоматическая сортировка по важности.

dim2r

30.08.2019 09:21Мозг думает всегда сразу о нескольких вещах параллельно, но победитель забирает все.

Еще вопрос — на что это похоже и какую модель можно запрограммировать?

У меня образ возник мультиагента и брокера. Каждый агент получает и обрабатывает свои сигналы. Потом, когда надо реагировать, то посылает брокеру запрос на получение управления. Брокер проанализировал всех миниагентов и выбрал самого главного. Тогда этот агент временно захватывает контроль над мышцами и например начинает чесать, где чешется. Потом другой агент может получить управление и тогда человек будет смотреть на проходящую девушку.

Брокер и агенты должны быть предобучены и потом дообучаться.

DesertFlow Автор

30.08.2019 15:39Да кто ж знает, на что это похоже ). Технически там просто электрические сигналы, распространяющиеся по разветвленной сети. Причем часть с обратными связями, как отрицательными, так и положительными. Дополнительно каждый из нейронов усиливает сигнал до максимального (поэтому мозг отчасти цифровое устройство, а не просто аналоговое: сигнал не затухает, а передается как цифровой независимо от дальности). А на пути между нейронами возникает препятствие в виде синаптической щели, в которой дальнейшее прохождение электрического сигнала, да и вообще, вся работа последующих нейронов регулируется двумя десятками молекул-нейромедиаторов. А ещё каждый нейрон постоянно качает ионы из внешней среды с помощью своих натрий-кальциевых насосов, и когда набирает достаточный потенциал, выпускает электрический сигнал (точнее, целую серию коротких импульсов), даже если вокруг ничего не происходит.

И вот как все это богатство привести к брокерам и агентам, я понятия не имею ). То есть, вызывает сомнения даже сама правомерность подобных аналогий.

phenik

30.08.2019 19:46То есть, вызывает сомнения даже сама правомерность подобных аналогий.

Так это эмерджентные феномены, их описание не сводится к нейронной импульсации. Как пример подобного доказательства эта работа из области физики, в кот. доказывается не сводимость описания макроскопических свойств магнитных материалов к их микроскопическому описанию. Для мозга найти неразрешимость и доказать эмерджентность ментальных конструкций не сложнее, эмуляцией той же машины Тьюринга с помощью нейронных сетей. Вопрос в правильном выборе этих конструкций. Каждая наука связанная с исследованием мозга решает их по своему. Главное не запутаться) эмерджентность относится именно к несводимости описания этих конструкций к свойствам нейросетей, но объясняется процессами их функционирования. Говоря по другому — объясняется структурно-функциональной редукцией, никаких дополнительных мистических сущностей для объяснения ментальных феноменов не требуется. Это можно проиллюстрировать на примере игры Жизнь. С использованием глайдеров доказывается ее полнота по Тьюрингу. То есть свойства глайдеров нельзя непосредственно вывести из правил игры, и в этом смысле глайдеры эмерджентные феномены. Но можно объяснить их появление, если задать начальные условия игры и пошагово проследить историю ее ходов. Однако в применении к мозгу мы не можем это выполнить точно, для этого историю нужно отмотать, видимо, до Большого взрыва) Но приближенно можно выделить нейро-динамические процессы (фМРТ, как пример их визуализации), кот. связаны с ментальными феноменами, с их началом и концом. На этом и строится экспериментальная наука о процессах в мозге, и их теоретическое объяснение.

dim2r

30.08.2019 21:42+1Да, это очень философский вопрос — что человек видит, смотря на картину художника? Если он подойдет с лупой и начнет вглядываться, то увидит только какие-то пятна. Если отойдет на нужное расстояние, то пятна сложатся в картину.

То есть человека тоже надо рассматривать только с определенного расстояния, тогда он является человеком, а не набором атомов. Если рассматривать слишком близко, то найдем кучу каких-то элементов, которые взаимосвязаны, но общую картину не увидим.

dim2r

30.08.2019 21:35Я немного с более выскооуровнего входа зашел. Обяснить трудно, если не в теме. Есть например теория субличностей. Иногда какая-то субличность активируется и человек как бы становится под её контролем. На работе мы одеваем субличность «работник», дома субличность «член семьи» и тп. Есть определенная иерархия таких подпрограмм от низкоуровневых, которые ответственны за разные ощущения до высокоуровневых, которые контролируют социальное поведение.

После прочтения порядка десятка книг на эту тему мне показалось, что этот внутренний цирк похож на мультагента, в котором есть еще общая шина, позволяющая каждому агенту временно брать контроль над органами чувств и направлять человека.

yatanai

30.08.2019 23:21Скорее паттерны поведения, которые зависят от целевой задачи и окружения, которые управляют механизмом выборки задач, которые влияют на сортировку важности задач. :]

dim2r

31.08.2019 14:55Можно сказать, что паттерны поведения одной системы. Но можно разделить на подсистемы, которые эти паттерны поддерживают.

darkAlert

29.08.2019 12:42Я верно понял, что процесс обучения это некая разновидность генетического алгоритма? В таком случае, такие сети будут учиться весьма долго. Простота backpropagation как раз и делает его таким эффективным. Ну я пишу это с точки зрения применения сеток в компьютерном зрении.

dim2r

29.08.2019 12:57Похоже, что да. Предобученная сеть готовится через генетический алгоритм. Главная задача, чтобы несмнотря на то, что все веса одинаковые и равны какой-то величине, она могла слегка выполнять нужные действия вне зависимости от величины.

Salos2

29.08.2019 15:34Статья очень интересная. Я как раз изучаю подход обучения бота. Я хотел бы пообщаться с автором на эту тему. Не знаю как написать. Если есть желание, моя почта salos at mail dot ru

DistortNeo

29.08.2019 15:59+1Единственное, что ограничивает применение таких нейросетей на практике — высокие вычислительные затраты. Такие нейросети будут реальностью, но лет так через 20-30.

Wundarshular

29.08.2019 20:45Возможно, я что-то упустил, но описанное в статье — точь-в-точь генетические алгоритмы. «Мы создаём набор вариантов решений на задачу, смотрим, какие справляются лучше, играемся с их настройками».

Кое-какие свежие идеи в направлении, но ничего принципиально нового.

dim2r

29.08.2019 21:27Создается сеть, которая у которой одинаковые веса и результат работы мало зависит от выбора какого-то значения для всех весов. В этом новизна

svanichkin

Это восхитительно! Гугл сильно продвинулся…

LeshaVH

абсолютно бесползеное абстрактное рассуждение в статье)

ни капли не приближает к ИИ и не дает ничего на практике — поэтому и выложи в открытый доступ)

просто чтобы сбить с толку конкурентов и не более того)

еще б рассказали как вся сложность и преднастроенность структуры мозга передается через две базовые клетки…

а то народ до сих пор думает что 99% ДНК мусор)))

а мусора там нет вообще)))

DesertFlow Автор

Эта работа чем-то похожа на обычное эволюционное обучение, как [ES у OpenAI](https://openai.com/blog/evolution-strategies/) или [Deep Neuroevolution у Uber](https://eng.uber.com/deep-neuroevolution/). У эволюционного обучения есть несколько плюсов, вроде только прямого прохода (вообще без обратного распространения ошибки), устойчивости к шумам и исследования структуры сети. Кстати, эффективные эволюционные алгоритмы вроде CMA-ES, по сути, спускаются по градиенту, поэтому совмещают достоинства чисто градиентных способов.

Отличие этой работы от предыдущих в том, что на выходе получается нейросеть, малочувствительная к весам. Но при этом выполняющая свою работу. Это похоже на то, как генами задается общая структура мозга, например, сколько нейронов выделить на каждую из областей мозга. По мне, так это просто снижает размерность пространства, где потом нужно искать решение. Что-то вроде подбора гиперпараметров заранее, чтобы обучение потом лучше сошлось.

Это не панацея, конечно. Просто попытка есть слона по частям, от простого к сложному. Сначала научить простейшим рефлексам, вроде ходьбы, потом более сложной мотивации, потом еще сложнее и так далее. Повторить путь, пройденный животными до человека. Но у такого подхода, мотивированного копированием физиологии (не буквально, а принципов), сразу видится минус: можно застрять в ограничениях, наложенной этой же физиологией/инстинктами! Структурой сети, в данном случае. Здесь нет четкой дороги к сильному ИИ, люди просто пробуют разные подходы. Посмотрим, что из этого получится…