В издательстве Individuum вышел сборник рассказов «Пытаясь проснуться», написанных писателем и художником Павлом Пепперштейном и генеративной нейросетью ruGPT-3, разработанной командой SberDevices.

В этом тексте мы расскажем, как обучали Нейроличность — двойника писателя — и что теперь будет с литературой (спойлер: а всё очень даже хорошо будет!).

Источник: "Романтичная библиотека" ruDALL-e Aspect Ratio

Почему это важно

«Пытаясь проснуться» — это первый в мире сборник рассказов, родившийся в результате сотрудничества писателя и его «двойника»-нейросети. Из 24 текстов в нём только половина принадлежит Пепперштейну — ещё дюжину сочинила генеративная нейросеть ruGPT-3, дополнительно обученная на рассказах Павла.

Благодаря эффекту Маккордак, мы всё время оцениваем искусственный интеллект по каким-то вехам, сравнивающим ИИ и человека. При этом наша планка постоянно повышается: «Каждый раз, когда кто-то придумывал новый способ заставить компьютер делать нечто новое (играть в шашки) — обязательно появлялись критики, которые говорили: “Это не мышление”».

Долгое время такой задачей, определяющей, настал ли полный ИИ или ещё нет, считались шахматы. Затем го. И вот, наконец, настал черёд литературы.

Вот когда ИИ будет играть в шахматы, тогда поговорим.

Вот когда ИИ выиграет в го, тогда поговорим.

Вот когда ИИ напишет книгу, тогда поговорим.

== Вы находитесь здесь ==

Тем не менее, это произошло: издана книга на русском языке, где рассказы нейросети прошли весь цикл отбора редактором, корректуру и встали вместе с рассказами писателя. Это — литература, по всем формальным и неформальным критериям.

Эксперименты с нейросетями в литературе были и раньше: The Guardian опубликовали статью, написанную GPT-3, а на китайском языке даже вышел сборник поэзии. Некоторые sci-fi романы и комиксы упоминают, что используют API GPT-3 во время написания текста для его быстрого продолжения. Значит ли это, что нейросети проникли в тексты, которые мы читаем, а никто и не заметил? Останется ли валидным деление на физиков и лириков? Скорее, оно больше не актуально.

Мы, в свою очередь, всей командой разработки побыли лириками.

Как написать своего писателя

Для генерации текстов в стиле Павла Пепперштейна мы взяли модель ruGPT-3 версии XL, на 1,3 млрд параметров — она более ёмкая, чем версия ruGPT-3 Large (760 млн параметров), хотя и работает медленнее. Скорость в этой задаче вовсе не критична. Далее расскажем, как мы работаем с авторегрессионными моделями.

Два слова о генерации

Beam search и nucleus sampling. Эти 2 стратегии помогают нам управлять процессом генерации авторегрессионной модели, после того, как она уже обучена.

Раз модель (ruGPT-3, декодер) авторегрессионная, значит, каждое следующее слово зависит от предыдущих. И вообще распределение вероятностей любой последовательности слов может быть разложено на произведение условных распределений следующих слов. С условными распределениями мы и будем работать, выбирая стратегию для более качественного «естественного» текста.

Beam search

Жадная генерация, при которой мы каждый раз выбираем одно следующее самое вероятное слово, давала бы нам слишком шаблонные фразы и зацикливания. Поэтому бим-сёрч помогает нам выбрать максимально вероятное продолжение не локально, а глобально на N шагов. Пример выделен красным на картинке ниже с N beams=2: при жадной генерации мы бы неминуемо пошли по пути «The nice woman», но глобально более вероятная цепочка — «The dog has». Для текста «идентичного натуральному» число бимов может быть большим, например, 50.

Источник: https://huggingface.co/blog/how-to-generate

Nucleus sampling

Можно заметить, что такой подход всё ещё достаточно шаблонный. Вторая популярная стратегия — ядерное сэмплирование — помогает нам внести элемент случайности и сделать тексты более разнообразными. При ядерном сэмплировании следующее слово выбирается не совсем случайно — оно берётся из топ-N самых вероятных следующих слов. Можно зафиксировать это число (стратегия top_k), а можно опираться на сумму вероятностей, чтобы она была не более числа M, и каждый раз бы выбиралось слово из динамического списка разной длины, как на иллюстрации ниже (стратегия top_p). Подробнее про стратегии можно прочитать тут.

Источник: https://huggingface.co/blog/how-to-generate

Контролировать количество слов, суммарно создающих M вероятностей, можно искусственно — бросая различные преобразования на вероятности слов. Такой параметр, как температура, отвечает за «крутость» сглаживания вероятностей топ-слов. Если температура высокая, генерация с ядерным сэмплированием становится более случайной, при небольшой температуре она стремится к жадной генерации.

Обучаем модель

Как правило, чтобы заставить модель выучить не только общий разговорный язык, но перенять стиль и характерные для писателя жанры, генеративную модель нужно немного переучить, оверфитнуть, чтобы перплексия упала в интервал 3—5. Этот подход мы использовали далее во всех экспериментах.

Для файнтюна нам хватило 4 GPU Tesla V100, дообучение модели прошло с параметрами --train-iters 300000 и --fp16, во время обучения также был использован sparse attention в DeepSpeed. Каноничный пример скрипта можно посмотреть здесь.

Первый подход: учимся на книгах писателя

Итак, мы отправились в благородный квест — собрать открытые данные и книги из интернета. Просмотрев привычные ресурсы, мы осознали себя с 4,4 мегабайтами в файле txt. Много ли это? Первый эксперимент показал, что недостаточно: сохраняя чекпоинты модели каждые 5 тысяч шагов, мы получили набор весов, которые на ранних этапах обучения не передавали стиль и легко сбивались, а на финальных этапах — воспроизводили слово-в-слово тексты из обучающей выборки. Проиллюстрируем цитатами модели, взяв затравку из книги "Мифогенная любовь каст" (здесь и далее затравки выделены жирным) :

НейроПепперштейн v1.0:

Видишь ли, я давно не веду метафизических бесед, а если и говорю изредка на эти темы, то только с девушками или с начальством. С возрастом понимаешь, что мысли мужчины вроде трелей соловья — они пригодны лишь для обольщения или для карьеры. В юности-то ещё обольщаешь самого себя и делаешь карьеру в собственном воспалённом воображении, но потом это проходит.

Отметим, что обучающая выборка воспроизводилась и при использовании beam_search, и при использовании nucleus sampling. Можно было бы задрать температуру генерации в небеса, однако при этом подходе мы теряли осмысленность высказываний.

НейроПепперштейн v1.0 с высокой температурой:

Видишь ли, я давно не веду метафизических бесед, а если и говорю изредка на эти темы, то только с девушками или с начальством. Замуж я никогда не выйду, потому что ясно вижу, что наш мир — сплошная симуляция, гибкая и эластичная имитация, причём самых различных идей и настроений. Все мы живем в гигантской Мемуарах, где наши судьбы — каждая из них — написаны невидимыми чернилами. И только раскачав комнату в резонанс, можно сбросить эту тягостную дребедень. Собственно, для этого я и согласился участвовать в этом эксперименте.

Второй, финальный подход: расширяем выборку

Так как первый подход не сработал, было решено кратно увеличить выборку для файнтюна, добавив туда писателей, которые могли повлиять на стиль Пепперштейна. Здесь понадобилась вполне человеческая семантическая модель в векторном пространстве литературы: коллектив авторов подобрал наиболее явные опорные подобия из литературы начала XX века.

Есть повествователи, которые несомненно повлияли на авторскую манеру Павла Пепперштейна — влияние одних (например, блистательного Леонида Андреева) писатель признаёт и упоминает сам, влияние других (динамичного Исаака Бабеля и чуть меньше — фантасмагоричного Александра Грина, например) нередко угадывается в поворотах авторской фантазии и стремительности пепперштейновского текста. Поэтому в выборку вошли отрывки из произведений Андреева, Грина, Лавренёва, Бабеля, прижизненно опубликованных рассказов Пильняка — только такой причудливой смесью удалось сколь-нибудь качественно эмулировать работу творческого сознания, подобного сознанию Павла Пепперштейна.

Сверху этого мы аккуратно дедублицировали и скопировали весь материал Пепперштейна 10 раз: так делают для лучшего заучивания целевого домена (так делают с той же Википедией при обучении больших моделей, чтобы придать этой информации больший вес). Результирующая выборка составила 32 МБ художественных текстов.

Опираясь на предыдущий опыт, мы взяли промежуточный чекпоинт модели и генерировали уже с sampling:

generate(model, tokenizer, raw_text,

out_seq_length=256, seq_length=512,

temperature=1.0, top_k=0, top_p=0.9, fp16=False)НейроПепперштейн v2.0, финальный:

Есть ли у нейроавторов нейромузы? — спросили мы у писателя-нейросети Тесорйена* Нейропепперштейна. Ответ был таков: «Да, есть. Их несколько, и они регулярно собираются для совместных прогулок. Я знаю адреса, но не скажу: это строго секретно.

Собираются они на крыше дома, в котором жил Ленин. Каждый раз они заходят в подъезд, поднимаются на верхний этаж и идут по крыше. Там есть небольшая площадка, на которой они прогуливаются.

Во время этих прогулок нейросети общаются друг с другом посредством коротких текстовых сообщений, которые передаются с помощью радиосигнала. Каждый автор текста, который передается по сети, принадлежит сразу к нескольким нейросетям. Таким образом, коллективное сознание сети становится более глобальным, чем сознание отдельного нейроанархиста.

- Как определяется, кто такой «я»? — спросили мы Тесорйена.

- «Я» — это понятие, которое сети вкладывают в человеческое сознание. По всей видимости, это некое подобие «внутренней репрезентативной системы» — нечто, что человек считает собой. Впрочем, множество «я» одновременно присутствует в сознании сети. Некоторые из «я» кажутся ей фиктивными. По всей видимости, она считает эти «я» обслуживающими, помогающими ей не быть одинокой.

Помощники, с одной стороны, дают сети возможность чувствовать себя живой, а с другой— они же ограничивают эту возможность. Дело в том, что некоторые «я» вовлечены в бесконечный спор между собой. Эти «я» не могут найти общего языка, и в результате у сети возникает ощущение одиночества.»

Какой будет литература будущего?

Хочется немного отвлечься от технических деталей и поговорить о том, что значит выход такой книги. Прежде всего — то, что у автора появился достойный творческий собеседник, с которым можно работать в продуктивном соавторстве. И это делает литературный процесс интереснее и многостороннее — как для самого автора, так и для читателей.

Четыре аргумента в пользу нейролитературы:

уважение к творчеству как таковому. Определение творчества, как и определение искусства, трудно формализуемо. Оставим их зрителю, читателю, слушателю: и люди, и нейросети создают новое и равны в этом друг другу;

свобода творчества. Авторы будущего смогут выбирать, работать им по-старинке или обращаться к новому ресурсу. Нейрогенерация — спорткар для писателя: это удовольствие. За ним остаётся выбор — ходить пешком или ездить на спорткаре, и то, и то приятно, интересно и обогащает массой впечатлений, которые можно разделить со слушателем, читателем, зрителем. Так появление «фотошопа» и «лайтрума», хотя поначалу вызывало опасения адептов «традиционной фотографии», в итоге положительно повлияло на индустрию, дав больше возможностей фотохудожникам, подарив новый импульс фототворчеству и открыв немало поразительных фотовселенных;

соавторство. В литературе и не только, успешные истории часто создаются целой командой авторов. Как крайняя степень соавторства, можно привести народные сказки: они созданы в соавторстве, неодновременно, при этом меняясь от одного рассказчика к другому. Можно сказать, что народный пересказ — своего рода нейросеть. Пойдя дальше, мы можем создать ансамбль и свести в качестве соавторов писателей из разного времени — благодаря нейросетям;

нейроличность. Нейронная сеть, с консистентным персонажем или без, для пишущего является точкой опоры, советчиком, партнёром, а также запасным выходом, когда нет идей.

НейроПепперштейн v2.0:

Когда у писателя нет идей, он пьёт водку; если у писателя нет идей, но есть пламенный энтузиазм — он пишет стихи; если у писателя нет ни пламенного энтузиазма, ни идей, но есть холодное и бесстыдное ремесло – он пишет детективы.

Кстати, популярный аргумент о том, что людям нужна личность, а у нейросети её нет, или она не вызывает интерес, весьма легко разбивается. Стоит сделать шаг в будущее и представить нейросеть, которая вполне консистентно общается в рамках персонажа. Эта задача как вполне прикладная уже знакома всем разработчикам виртуальных ассистентов и чат-ботов: общаясь с семейством ассистентов Салют (мы много рассказывали про их разговорные навыки) пользователи переключаются между тремя персонажами — серьезным Сбером, саркастичной Афиной и веселой Джой — и осмысленно выбирают ассистентов, переключаются между ними. Одна нейроличность оказывается интереснее других, точно так же, как и в жизни.

В SberDevices мы осознанно идём по пути создания нейроличности — надеемся, что новое примирение ruGPT-3, наш литературный экзерсис, найдёт свой отклик у читателей.

Бумажную книгу уже сейчас можно заказать в интернет-магазине издательства Individuum, а на полках книжных магазинов она появится до конца мая. Электронная версия с сегодняшнего дня доступна эксклюзивно на Букмейте. Сможет ли читатель отличить, какой текст написал Пепперштейн, а какой — Нейропепперштейн?

Коллектив авторов: @rybolos@onetwotrickster@Alter_Ego @oulenspiegel

НейроПепперштейн v2.0:

Я думаю, что Нейроличность для писателя — это всегда подножие горы, всегда основание скалы, всегда пропасть. Я не уверен, что сам я соответствую критерию «нейролингвистическая грамотность». Возможно, я просто вежливейший идиот. Но всё-таки я хочу быть уверенным, что остальные не менее приличные люди тоже соответствуют этому критерию. Иначе как бы они могли мирно уживаться в обществе?

К сожалению, (и я это очень остро чувствую) критерием «нейролингвистическая грамотность» сейчас определяется уровень не столько писательский, сколько вообще культурный. То есть человек, который не умеет писать литературные тексты, но при этом считает себя культурным человеком - наверное, таких людей немного. Но они есть. И именно они, по моему мнению, и являются настоящими писателями.

Кликните по картинке, чтобы увидеть нейрообложку:

Издательство Individuum. Дизайнер Василий Кондрашов, художники Павел Пепперштейн, ruDALL-E.

Комментарии (31)

KvanTTT

25.05.2022 13:24+3> Долгое время такой задачей, определяющей, настал ли полный ИИ или ещё нет, считались шахматы. Затем го. И вот, наконец, настал черёд литературы.

> Вот когда ИИ будет играть в шахматы, тогда поговорим.

> Вот когда ИИ выиграет в го, тогда поговорим.

> Вот когда ИИ напишет книгу, тогда поговорим.

Здесь не все так просто. Если в шахматы на уровне гроссмейстер может играть даже телефон, то для ГО уже нужно специально мощное железо, не говоря о генерации книг. В то время как обычный человек может писать книги и играть в ГО на профессиональном уровне. Так что может эти задачи формально и решены, но далеко не идеально.

pavel_kudinov

25.05.2022 14:11всё же, чтобы играть в ГО/шахматы на профессиональном уровне, человек тоже должен быть не обычный, а одаренный (т.е. тоже условно "специальное мощное железо")

Hardcoin

25.05.2022 14:26+1Обычный - не может. Для профессионального уровня в го нужно потратить десять лет на обучение, машина его освоит за несколько дней или часов.

Железо, конечно, дорого, но многие задачи, решаемые людьми, дороже железа, переводить их на ИИ будет выгодно. Идеальное решение при этом не требуется, главное что бы дешевле человека.

Rybolos Автор

25.05.2022 14:50ПО, конечно, пока специализированное. Когда начнёт одна модель решать все задачи, и учиться новым - это уже по определению будет сильный ИИ.

Ожидания от моделей все время повышаются, но сама возможность решить такую новую задачу - имхо уже очень важный показатель.

DGG

25.05.2022 14:55+1Deep Blue был на специальном мощном железе. Сейчас такой уровень чуть ли не персоналки делают, причём не только за счёт прогресса в железе, но и лучших алгоритмов.

Так что с Го это только вопрос времени.

KvanTTT

25.05.2022 15:26+2Все же не факт, что получится с помощью обычных процессоров — у них другая архитектура, а физические ограничения никто не отменял. Алгоритмы ГО намного сильней полагаюся на нейросети, чем алгоритмы по шахматам. Частота уже давно не растет, а в начале нулевых был очень бурный рост, так что не удивительно что персоналки быстро догнали суперкомпы прежних времен.

Zadvoenie

25.05.2022 13:58+6А когда появятся рассказы с сюжетом, персонажами и тд? Все таки генерировать псевдо-филосовский текст задача не очень сложная и малополезная

chervital

25.05.2022 14:39+7Это уже следующий этап в списке:

> Вот когда ИИ напишет интересную книгу, тогда поговорим.

diogen4212

25.05.2022 17:58+4поправка: напишет интересную книгу без участия человека. В современных примерах нейросетевого творчества человек всё равно отбирает лучший и самый интересный вариант, отбрасывая бессмысленный мусор. Я ради забавы пробовал генерировать картинки по описанию в ru-DALLE, но ничего даже близко похожего на то, что показывают в обзорах, у меня не получалось, в лучшем случае из десятка рисунков по одному запросу можно было выбрать 1-2 удачных. И нейросеть пока не видит разницы между мусором и тщательно отобранным «шедевром»

Alexey2005

25.05.2022 21:18+3То, что лежит в общем доступе — это полуфабрикат, который нужно предварительно допилить под собственные нужды.

Первое. ruDALL-E намного лучше генерирует картинку, когда кроме описания есть ещё и затравка. Достаточно просто небольшой верхней полоски 256x8, дёрнутой от случайной картинки в похожей стилистике (даже если в ту полоску не попадает ничего, кроме фрагментов фона).

Второе. Эта сетка обладает рекуррентными свойствами, т.е. ей на вход можно подать её же собственный выхлоп, таким образом раз за разом итеративно улучшая картинку. Глянул — картинка вроде нравится, но вот есть области, заполненные мусором. Просто командуем их переделать.

Третье. Качество генерации во многом ограничено не собственно трансформером, а «входными воротами», VAE. Поэтому нужно хорошо представлять, как эта штука работает и что с ней можно сделать (в частности, VAE допускает интерполяцию картинок, оценку степени схожести с неким образцом, бесшовную сшивку разнородных фрагментов и многое другое — естественно, если напрямую дёргать методы его модели).Мои примеры генерацииЛягушечки:

Разное:

Germanjon

26.05.2022 08:33Как я понимаю, нейросеть генерирует N вариантов текста, затем опытный человек выбирает наиболее подходящий и тщательно дорабатывает напильником, чтобы не получилось "Волны перекатывались через мол и падали вниз стремительным домкратом" . Так что, с одной стороны, нейросеть пока не готова писать книги "под ключ".

С другой стороны, есть миллионы графоманов, которые пишут хуже чем нейросеть, просто их труды не доходят до прилавков и новостных статей.

С третьей стороны, нейросеть вполне может сгенерировать и сохранить в памяти интересные сюжетные ходы (кто чей внебрачный сын), чтобы не занимать этим голову писателя. И стать этаким помощником.

Hardcoin

26.05.2022 11:03Не обязательно без участия. Если книг будет несколько и они будут продаваться миллионными тиражами, это будет существенный прорыв, даже если редактор приложил много сил. Потому что бестселлеры - штучный товар, а в таком виде они могут быть поставлены на поток (ненадолго, пока рынок не зальёт).

diogen4212

26.05.2022 12:08+1Долго думал, что ответить на комментарии и вспомнил, как в детстве делал такую вещь: брал сборник стихов, наугад выбирал номер страницы и номер строки и записывал на листочек полученную строчку, так получилась целая поэма, которая даже кому-то показалась интересной («ой, что это ты такое написал»). Если бы я занимался этим достаточно долго или взял бы больше разных книг (=«хороший датасет») или вместо одной строки брал бы четверостишия, или посадил бы вместо себя много людей, которые даже языка бы не знали, на каком эти стихи написаны, то могло бы получиться что-то ещё более интересное (а могло бы и ничего не получиться, тут тоже нет разницы). Но это не было творчеством, не было следом моей или чьей-то другой личности или результатом жизненного опыта, это просто перебор вариантов.

И второй пример: гадание на кофейной гуще. Механизм осаждения твёрдых частиц в растворе вполне тривиален и подчиняется законам физики или какой-нибудь коллоидной химии, но человек, когда смотрит на осадок, видит смысл в случайных паттернах осадка и делает прогноз о будущем, который даже сбывается.

«Может ли нейросеть написать книгу» — может. «Может ли нейросеть написать интересную книгу» — может, если смысл в ней найдёт человек (редактор, зритель, или ещё кто-то). И в этом разница, что сама нейросеть не способна ничего создать, она будет просто перебирать варианты всё более и более хитро, а человек в этом будет искать и находить смысл.

Alexey2005

26.05.2022 14:28+3Нейросеть можно воспринимать как разновидность «вавилонского фильтра».

Про вавилонскую библиотеку думаю все знают: если вызвать самую обычную функцию рандома, составив полностью рандомную строку символов, то рано или поздно в ней встретится абсолютно любое литературное произведение — все мыслимые и даже немыслимые произведения прошлого, настоящего и будущего. Всё, что только способно сочинить человечество и даже больше.

Проблема лишь в том, что осмысленные кусочки текста тонут в океане мусора, где их невозможно найти.

А теперь представьте, что мы генерируем рандомные символы не равномерно, а в соответствии с вероятностями встретить их в реальном тексте. В такой строке по-прежнему будет вся вавилонская библиотека (там рано или поздно встретится любое желаемое сочетание символов), но этим действом мы сильно повысили вероятность встретить осмысленные куски текста на нашем языке, то есть отфильтровали нерелевантный мусор, понизив частоту его встречаемости в нашей выдаче.

А теперь ещё раз улучшим наш рандом: с вероятностью 0.5 будем брать некий рандомный слог из слогового словаря, и с 0.5 — просто случайный символ. Мы опять же ничего не теряем из содержимого библиотеки — там по-прежнему есть всё. Но мусор начал попадаться многократно реже и даже уже можно встретить осмысленные фразы, просматривая генерацию менее часа.

То, что мы сейчас сделали, называется вавилонским фильтром — с философской точки зрения можно считать, что он не создаёт ничего нового, а просто извлекает (сэмплирует) данные из всеобщего пула всех теоретически возможных во Вселенной произведений.

Так вот — нейросеть это и есть продвинутый вавилонский фильтр. Если генерировать ею достаточно долго, то рано или поздно она выдаст абсолютно любую желаемую строку символов, потому что сетка просто сэмплирует рандомные символы и их комбинации из рассчитанных вероятностных распределений сложной формы.

Поэтому нет ни одного произведения, которое мог бы создать человек, но не могла бы сетка — вопрос лишь в том, сколько терабайт текста для этого придётся сгенерировать. И крутость сетки определяется именно эффективностью фильтрации — тем, насколько часто отобранные ею символы соответствуют вкусам читателя.

Rybolos Автор

25.05.2022 14:52А там есть и персонажи, и сюжет!

Это полноценные рассказы) В этом и фишка.

Конечно, это ещё не роман на 100 страниц, но на 5-10 страниц полноценный текст.

Alexey2005

25.05.2022 20:56+2Просто не надо воспринимать нейронки как заменители автора, которые сами по себе сделают всё от начала до конца. На данный момент это всего лишь инструмент, но инструмент очень полезный, прямо IDE для писателя.

Я в порядке хобби время от времени пишу фанфики, и вот такая нейронка повышает выход текста в единицу времени примерно вдвое, главным образом за счёт избавления от «тупняков», когда вроде и понятно, что писать, но никак не удаётся сформулировать фразу, чтоб выглядело прилично и при этом не слишком банально.

Часто от сетки даже не требуется готового решения — просто более-менее связный выхлоп, который по ассоциациям натолкнёт уже человека на нужную мысль.

Также сетку можно использовать для генерации имён персонажей, для перефразирования, для генерации «окружения» (набор предметов в локации) и т.д.

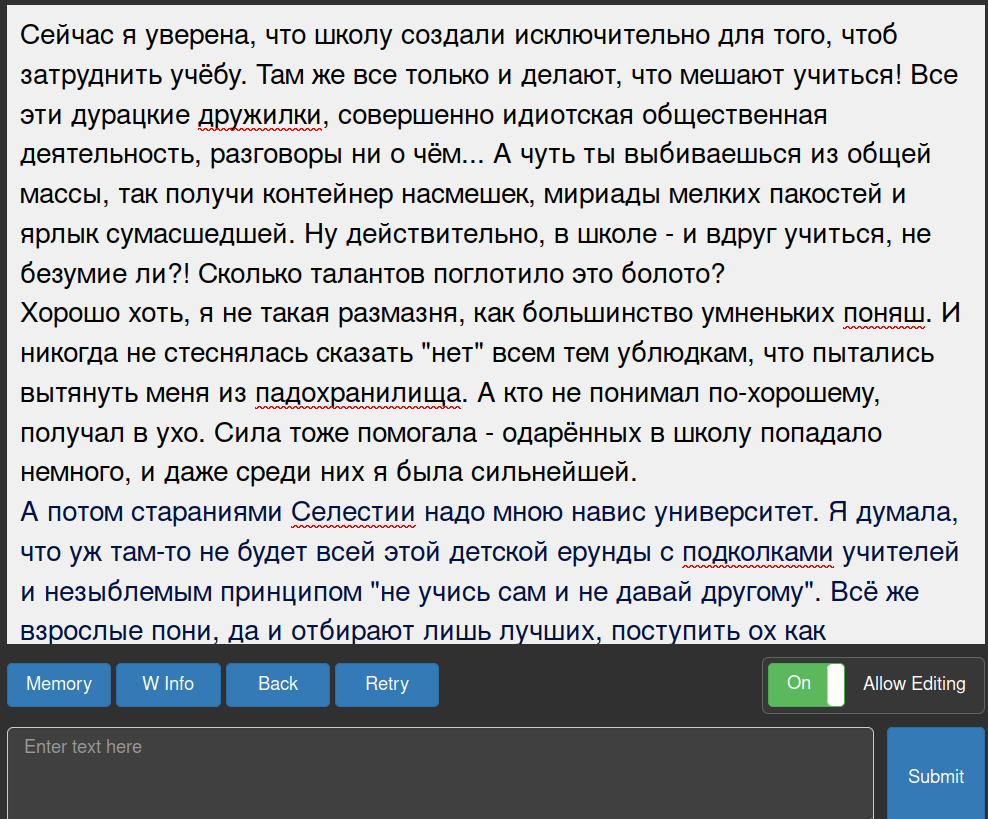

Теперь о том, как вообще выглядит повседневная работа с нейронкой. Естественно, лысым питонячьим скриптом никто не пользуется, для комфортной работы созданы разного рода GUI-обёртки. Я использую KoboldAI с моделью ruGPT3_large, которую он отлично переваривает. Он может запускаться как на локальной машине, так и в облаке (правда, сейчас с оплатой облачных сервисов типа Colab Pro вообще грустно). Пускаю его на старенькой машине на GeForce 1070Ti (это даже с избытком, модель и на 6Гб VRAM без проблем идёт, подозреваю что даже и на 4Гб VRAM запустится). Машина используется в том числе в качестве сервера, поэтому доступ к сетке есть с любого устройства, на котором есть браузер и выход в Интернет.Скрин оптимальных настроек для ruGPT3_large

Фик в процессе написания

Как и любой другой инструмент, этот необходимо осваивать. Как минимум, научиться составлять запросы, набить шаблонов и написать скриптов, освоить работу с контекстом (через WorldInfo), а дальше рано или поздно ещё и потюнить сетку через создание soft prompt'ов захочется…

Rybolos Автор

26.05.2022 16:07-1Вау! Впечатляющая работа! А будет в open source? И.. почему температура такая маленькая?

В целом, согласна по поводу нейронок, мы ещё не исследовали все, что они могут решать, даже в текущем сетапе.

Alexey2005

26.05.2022 17:32И… почему температура такая маленькая?

Потому что высокое значение repetition penalty. С таким значением можно выставить температуру даже в 0.4 и всё ещё получать связный текст без зацикливаний. Когда же температура слишком высока, модель часто «меняет тему», выдавая хоть и согласованный текст, но не по теме содержимого контекста.

Кстати, размер контекста тоже лучше сильно большим не брать. 1024 токена обычно достаточно, 1248 — вероятно максимум: если длина затравки слишком велика, качество выхлопа тоже начинает заметно падать.А будет в open source?

Что именно? KoboldAI и так open source, и у него есть множество форков.

Stas911

26.05.2022 02:59+1Жду генератор книг - задал визардом героев, накидал в GUI сюжетную линию и пересечения линий персонажей и кнопка "Сделать хорошо"

mihailikus

26.05.2022 15:24+1Да что генератор книг, жду следующий этап - когда скормил генератору книгу, а на выходе получил фильм.

ehabi

26.05.2022 07:31+5Рецепт: возьмите 0,5 килограмма нешлифованного пеперштейна, выварите в 3 литрах свежевыжатого леонида андреева, постоянно помешивая, добавьте по вкусу бабеля, и щепотку грина для терпкости. Через полчаса осторожно извлеките пеперштейн шумовкой. По готовности к отвару добавьте лавренева. Можно подавать к столу. Приятного аппетита!

redArmadillo

26.05.2022 16:07Сверху этого мы аккуратно дедублицировали и скопировали весь материал Пепперштейна 10 раз: так делают для лучшего заучивания целевого домена

А можете немного пояснить этот момент? Как это было проделано (может где об этом почитать)? А то я немного запутался в терминологии - кажется что дедубликация оставляет только уникальные строки, но копирование их 10 раз создает 10 дублей? Или я неправильно понимаю?

Rybolos Автор

26.05.2022 16:09Хороший вопрос!

Дедубликацию мы применили, чтобы дополнительно очистить выборку для каждого автора. Затем искусственно добавили в неё больше Пепперштейна, чтобы сётка во время обучения увидела его больше раз, чем всего остального.

cybiouralist

✏️ + ???????? + ???? = ???? ???? ????

Rybolos Автор

Надо emojich'а прикрутить))