Тестовое оборудование

Для тестов я использовал свой личный ПК: Core i7-3930K (6 ядер @ 4.2 ГГц), 16 гигабайт достаточно редкой памяти Kingston HyperX Beast 2400 МГц в четырёхканальном режиме (быстрее на DDR3 сложно что-либо найти), все игрушки и бенчмарки стояли на PCI-Express SSD диске, чтобы минимизировать влияние остальных компонентов на результаты тестов). Всё это дело подключено к монитору с разрешением 2560х1440 точек. Как видите, упираться особо не во что: игрушек с 64 битной архитектурой и бинарниками — кот наплакал, а остальным, по идее, должно всего хватать. Разумеется, все обновления, патчи, драйвера, хотфиксы и всё такое стояло самое свежее, прямо с грядки.

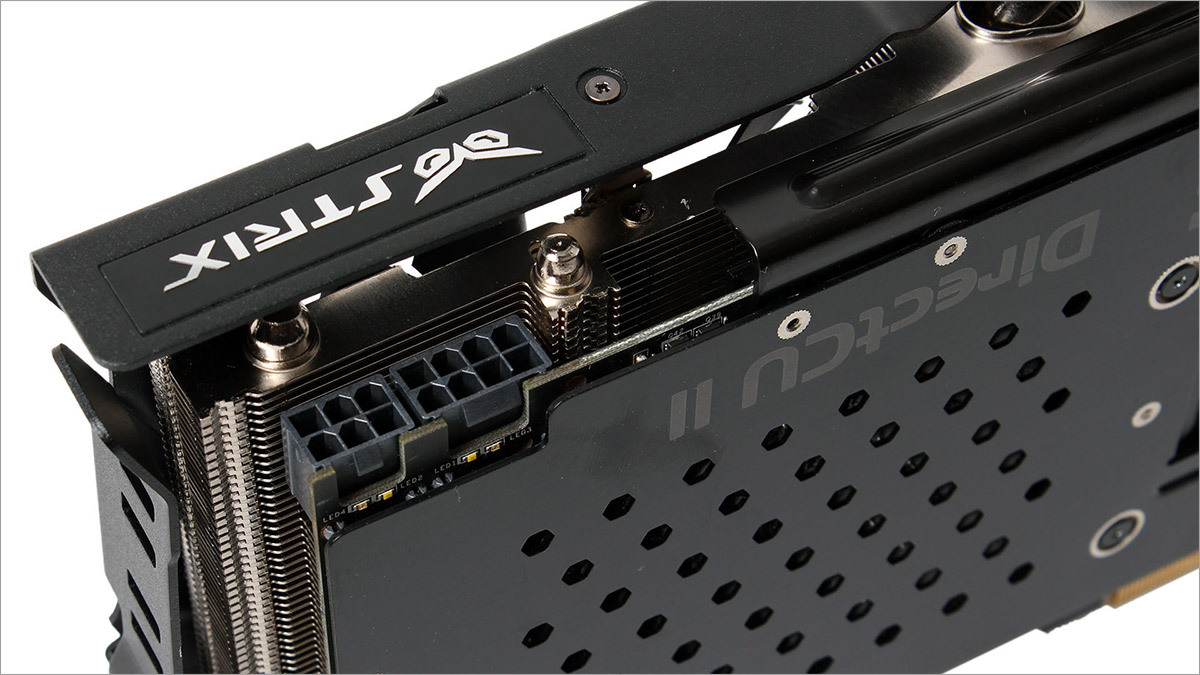

В качестве подопытного я использовал ASUS STRIX GTX 970: видеокарту с потрясающе тихой системой охлаждения и отличным железом.

На чём тестируем?

Во что там у нас нынче молодёжь играет? А то я слышал, что Battle City из моды немного вышел… В общем, для теста выбраны следующие игры:

- Batman: Arkham origins

- Battlefield 4

- Bioshock Infinite

- Company of Heroes 2

- Crysis 3

- Diablo 3

- Far Cry 3

- Far Cry 4

- Metro: Last Light

- Tomb Raider (2013)

Во всех случаях будут применяться максимально возможные настройки графики с отключённой вертикальной синхронизацией и активным сглаживанием х4. Всякие Frame Limiter’ы и прочие «сглаживатели» были выключены, после каждого теста видеокарта остывала до нормальных температур а система перезагружалась.

Специальный гость — игра, которые не отличаются фантастической графикой или оптимизацией, но может задать жару многим GPU при определённых условиях. Нам она нужна чтобы показать некоторые узкие места архитектуры Maxwell. Использовать будем Dark Souls 2 и выполнять downscale с разрешения 3840x1260 до 2560x1440 и с 5220х2880 до 2560x1440.

К сожалению, GTA V на момент проведения тестов и написания статьи ещё не

Результаты тестирования

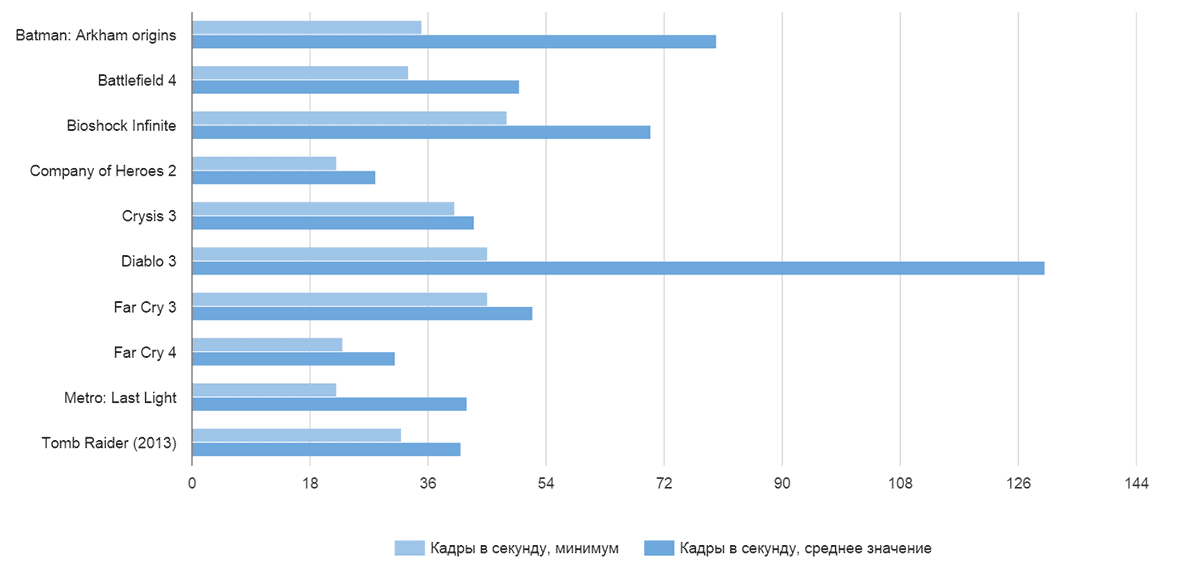

Для разрешения 2560х1440 достичь достаточно производительности достаточно сложно. Не так давно (в топике про GTA V) я нашёл человека, для котого «ниже 60 FPS — безумные лаги). Что ж, у каждого вкусы свои, но я считаю, что 30 FPS на таком разрешении с одной видеокартой — вполне играбельный вариант, особенно если в напряжённых сценах количество кадров в секунду не проседает ниже 25. Вот результаты:

Как видите, почти все игры на супер-настройках и с четырёхкратным сглаживанием показывают приемлемые результаты, за исключением откровенно прожорливых монстров с так себе оптимизацией: Metro Last Light и Company of Heroes 2 ожидаемо стали аутсайдерами чартов.

Что касается потребления памяти, то «выйти» за трёх с половиной гигабайтовый рубеж удалось только в Battlefield 4 и Far Cry 4, (видимо, магия цифры 4, не иначе). Crysis и Metro даже близко не подошли: самые сложные сцены с трудом занимали 3.2 ГБ видеопамяти.

Maxwell бонусы

Помните самый первый пост про GTX 970? Там мы рассматривали все пост-DX9 видеокарты NVIDIA и отметили, что вот уже три поколения как компания бьётся над энергоэффективностью своих чипов. С одной стороны — дело благородное, с другой — на десктопах особо потреблением можно не запариваться: чай, не от батарейки работаем. С другой — если уменьшить энергопотребление и тепловыделение, то в рамках того же теплопакета можно будет выжать больше производительности. И именно в этом Maxwell превзошёл как прошлые поколения, так и красно-белых конкурентов.

Дело в том, что энергоэффективные чипы GM-204 имеют теплопакет 165 Ватт. А ещё имеют технологию автоматического разгона: пока температура позволяет, а нагрузка — соответствует, частота ядра повышается в определённых разумных пределах. Соответственно, чем надёжнее цепи питания, лучше охлаждение, выше базовая частота чипа и памяти — тем больших результатов может достичь видеокарта на архитектуре Maxwell под нагрузкой: тем самым уменьшая просадки в FPS и увеличивая средний frame rate. Эдакий аналог Intel’овского Turbo Boost.

Штатные частоты моей видеокарты составляли:

Ядро, Normal — 1114 МГц

Ядро, Boost — 1253 МГц

Память: 7010 (1752.5 х4) МГц

После некоторого шаманства с софтовым поднятием напряжения, проверкой на стабильность и прочих ухищрений удалось получить следующие результаты:

Ядро, Normal: 1333 МГц

Ядро, Boost: 1490 МГц

Память: 8000 (2000 х4) МГц

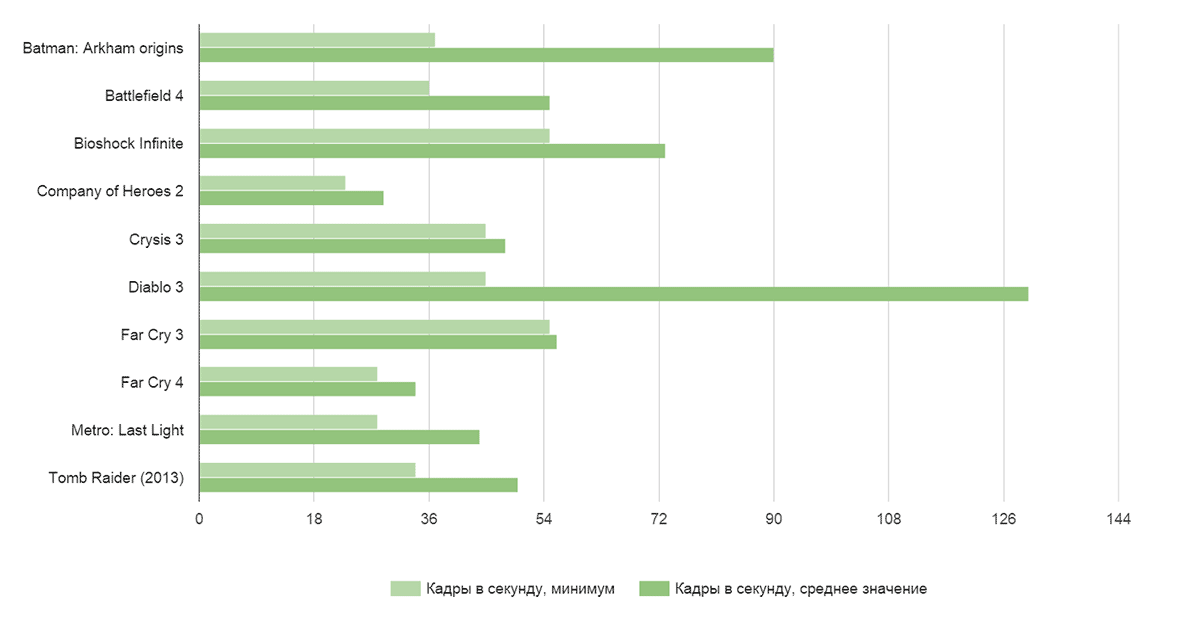

Как это сказалось на производительности? Самым лучшим образом:

Почти везде графики перевалили за рубеж «комфортных» 25 FPS. Забавно, но разгон совершенно не сказался на производительности Diablo 3: видимо, либо какой-то внутренний лимитер всё же действует, либо игра упирается во что-то другое. А кривую Company of Heroes 2 даже разгон не спас, как были унылые результаты, так и остались.

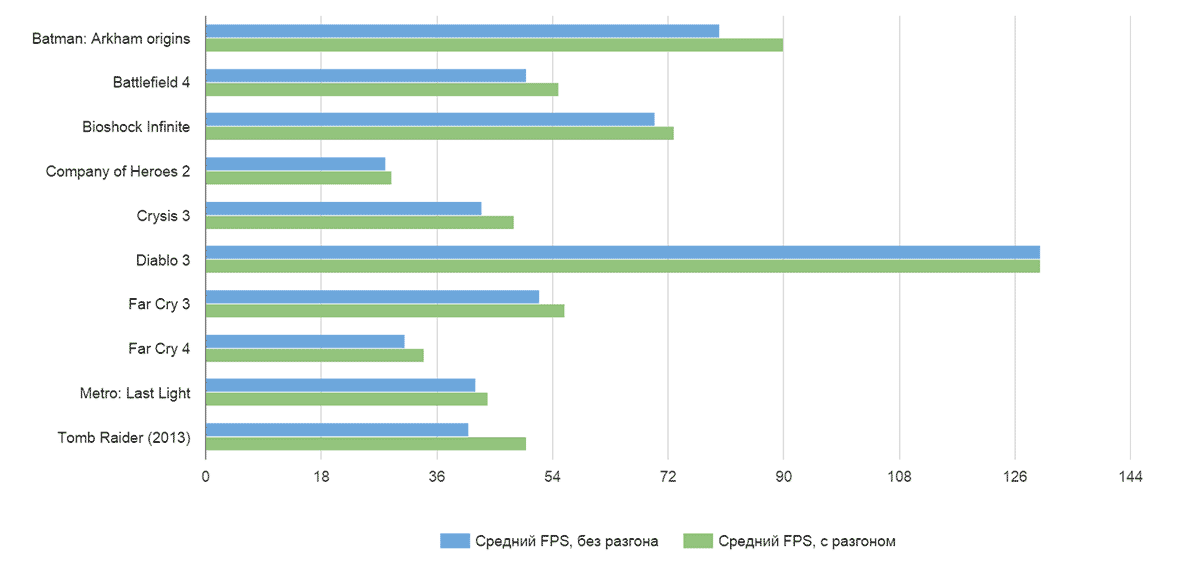

Вот сравнение минимальной частоты кадров:

Здесь прирост наиболее важен и заметен: в самый напряжённых сценах исчезли микрофризы и подлагивания, в целом картинка стала плавнее.

Средняя частота кадров тоже подросла, но не так сильно, и в целом прирост производительности, скорее, характерен для очень нагруженных сцен, чем для общей динамики:

А теперь самое главное. Что с разгоном, что без — видеокарта удивительно тихая. Нет, конечно, через час-другой игры в Crysis 3 с такими настройками будет некоторый фоновый шум, но ни в какое сравнение не идёт с шумом и нагревом монстров прошлого поколения типа AMD HD7970, GTX 780 и уж тем более воем референсных турбин. В этом плане ASUS молодцы и сделали отличную систему, которая не шумит и выполняет свою работу на пять с плюсом.

Личное мнение

В прошлом посте отдельно жаловались на Far Cry 4, мол, если игра всё же выползает за 3.5 ГБ, то начинаются всякие микрофризы, лаги, выпадения кадров, а на записи и вообще кошмар творится (вторая половина ролика):

В игре такой красоты с выпавшими кадрами и размазанными цветными пятнами вы не увидите, просто будет незначительная потеря плавности картинки. В том же Crysis 3, если его удаётся вывести за пределы потребления 3.5 ГБ видеопамяти вообще таких проблем не наблюдается и просадка производительности практически не видна, особенно если смотреть в прицел и наслаждаться геймплеем, а не пялиться в FPS-метр, ловить кратковременное падение производительности, делать скриншот и бежать на форум, жаловаться на то, какая NVIDIA плохая. :)

Для разрешения 2560х1440 и 2560х1600 видеокарты хватает во всех играх: если, конечно, вас устраивает средний показатель в 30-40 FPS. Само собой, для 4K2K видеокарты не хватает, и дело здесь не в памяти, а в самих вычислительных возможностях видеоядра. В качестве 4К2К теста я использовал Dark Souls 2 с патчем на даунскейл графики. Сам по себе Dark Souls не блещет ни графикой, ни системными требованиями. На средне-высоких настройках можно спокойно играть в FullHD разрешении с мобильной видеокартой GT650M и 1 ГБ видеопамяти. Основная нагрузка в данном случае ложится на GPU, а не на видеопамять: так как никаких супер-сложных спецэффектов не применяется, постобработка достаточно примитивная, а сама игра разрабатывалась с учётом возможностей консолей прошлого поколения (для тестов использовалась первая версия, без Scholar of the First Sin). С даунскейлом 3840х2160 до 2560х1440 NVIDIA GTX 970 выдаёт уверенных 15-18 FPS, с разгоном — 16-19. То же упражнение, но с разрешением 5120х2880 вовсе приводит к удручающим 12-14 FPS.

Для сравнения, старый AMD HD7970 с 3 ГБ видеопамяти и работающий с небольшим разгоном (1024 МГц ядро, 5600 (1400х4) МГц память) уверенно выдаёт 25-30 FPS для разрешения 3840х2160 точек и 20-22 FPS для 5120х2880.

Почему так происходит

Во-первых, архитектура видеоускорителей AMD и NVIDIA сильно отличается как с точки зрения «общей философии», так и в некоторых частных подходах.

Видеокарта GeForce GTX 970 имеет базовую частоту ядра 1050 МГц и 4 гигабайта памяти GDDR5, работающую на частоте 1750х4 МГц, подключённую по 256-битной шине, разбитой на 8 сегментов по 32 бита каждый. Общий блок в 3.5 ГБ подключён через 224-битный сегмент, дополнительные 512 МБ подключены через 32-битный сегмент, что и является причиной замедления работы видеокарты, когда приложения вылезают за пределы 3.5 ГБ видеопамяти.

Ядро видеокарты Radeon R9 280X, работает на частоте в 1000 МГц и использует память 1500х4 МГц, подключённую по 384-битной шине. Она хоть и разделена на 6 двухканальных 64-битных блоков, но ни один из них не отключён, так что вся память доступна на полной скорости, пусть её и всего 3 ГБ.

Напрямую сравнивать характеристики (например, число TMU — texture mapping units) нет смысла: различная архитектура, частота работы и прочие особенности не могут наглядно отобразить превосходство той или иной видеокарты. Если приводить абстрактную аналогию: что больше займёт места — 20 ящиков какого-то неизвестного объёма или 30 ящиков немного другого? Только измерив объёмы и умножив на число ящиков мы можем точно ответить на данный вопрос.

Так что для актуального сравнения видеокарт лучше подставим показатели производительности R9 280X (она же 7970 1GHZ Edition) и GTX 970: они уже приведены к общему знаменателю и имеют одинаковую размерность. В обоих случаях будем сравнивать референсные значения стандартных ускорителей, а не разогнанных экземпляров различных вендоров.

| R9 280X |

GTX 970 |

|

| Производительность GPU, ГФЛОПС: |

3, 482 |

3, 494 |

| Пропускная способность памяти, МБ/сек.: |

288 000 |

224 000 |

| Скорость заполнения |

||

| пиксельная, МП/сек.: |

27 200 |

58 800 |

| текстурная, МТекс./сек.: |

108 800 |

109 200 |

Как видите, основное отличие производительности в области пиксельной скорости заполнения. Она отвечает за превращение полученных вычислений в готовый кадр: чем выше пиксельная скорость заполнения (pixel fill rate), тем, по идее, быстрее видеокарта может превращать «магию» в двухмерные картинки, которые можно отправлять монитор. Было бы что отправлять, и в этом кроется весь секрет. Если мы запускаем игрушку на невысоком разрешении, скажем, 1280х800, нагрузка на память и вычислительные ядра не высока: количество готовых кадров зашкаливает и видеокарта, допустим, может выдавать 100 или даже 200 FPS в простых сценах, если сможет превратить всё то, что она насчитала в двухмерную картинку и отправить её на монитор.

Если же мы запускаем игры в высоком разрешении, то каждый кадр становится намного сложнее в расчётах, кадровая частота снижается, а на ROP’ы (модули видеокарты, которые отвечают за перевод картинки в плоский кадр) ложится дополнительная нагрузка: есть разница, считать 1280х720=921 600 точек или 2560х1440=3 686 400 точек. Частота вывода готовых кадров падает, но падение производительности на всех предыдущих этапах сильнее, чем дополнительные потери на ROP’ах, и поэтому на невысоких разрешениях большие показатели pixel fill rate дают огромный прирост к результатам бенчмарков, а на всяких SuperUltraHD и 4K2K игры упираются в производительность самой видеокарты, а не выводящих картинку модулей, и результаты выравниваются.

Видеокарта от AMD отличается более высокой пропускной способностью памяти (показатели отличаются почти на 30%) и меньшим её объёмом (3 ГБ против 3.5+0.5 у GTX 970), сравнимой производительностью ядра, чуть большим количеством шейдерных процессоров. Именно здесь красно-белые и выиграли у чёрно-зелёных: производительности ROP’ов оказалось достаточно, а вот бонусы в лице высокой пропускной способности памяти и большем количестве вычислительных блоков сделали свою работу: при штатных частотах и высокой нагрузке HD 7970 или R9 280X смогла обогнать GTX 970. С поправкой на то, что игра не требовала больше 3 ГБ видеопамяти. Правда, цена этого превосходства — чудовищное энергопотребление Radeon’ов, и, как следствие, высокий нагрев, не самый приятный акустический режим работы и так себе разгон.

Итоги

GTX 970 — отличная видеокарта, которая позволит вам играть пару-тройку лет на высоких настройках во что угодно. Ущербной её назвать язык не поворачивается. 4К2К мониторов пока мало, оптимизация под них так себе, игровые движки развиваются… В общем, через несколько лет будет польза от всех этих нововведений и улучшений архитектуры. Если же вам нужна видеокарта сегодня… Что ж, для разрешения 1920х1080 и 2560х1440 GTX 970 отлично подходит. Она тихая, отлично гонится, не занимает много места и не требует супер навороченный блок питания.

Что касается памяти и споров 4 гигабайта или 3.5 — знаете, если бы NVIDIA вообще заблокировала этот кусок памяти и написала на видеокарта 3.5 ГБ — было бы намного хуже. Будь я на месте высокого начальства — продавал бы видеокарты с заявленными 3.5 ГБ и фактическими 4, такими, какие они есть сейчас. Как только это бы вскрылось — фанаты бы на руках носили компанию, мол, дарят 512 памяти. Пусть и не быстрой. Но дарят. На халяву! Ну а производительность… честно, в пылу сражений Battlefield’а или Far Cry вы не увидите разницу между «очень высокими» настройками текстур и просто «высокими», и никогда не увидите оверхэд. А во всех остальных играх можно смело ставить максимум. :)

А для фанатов bleeding edge технологий, 4К2К и прочих прелестей неограниченных бюджетов есть всякие Titan’ы и прочие R9 295X2. Пусть покупают и радуются. :)

Выводы

Выводы каждый волен делать самостоятельно. Как по мне, так истерика с памятью в GTX 970 была надуманной: на производительности это практически не сказывается, а будущее обновление драйверов и патчи к играм позволят что-нибудь подшаманить таким образом, чтобы владельцы GTX 970 не испытывали вообще никаких неудобств.

Что касается соотношения цены и производительности, то здесь, мне кажется, вариант с R9 280X… куда вы меня тащ…

Наши обзоры:

» Подключаем оригинальные геймпады к ПК

» Razer Abyssus: самый доступный Razer

» Nikon 1 S2: однокнопочная беззеркалка

» Обзор Lenovo Miix 3-1030

» Разбираемся в арт-хаосе компании Wacom

» ASUS ZenFone 5, LG L90, HTC Desire 601 — двухсимочная война за потребителя, часть 1

» ASUS Transformer Pad

» Гарнитуры Razer Kraken

Цикл PC Buyer’s Guide:

» PC Buyer's guide: выбор видеокарты

» PC Buyer's Guide: выбор блока питания

» PC Buyer's Guide: охлаждение

» PC Buyer's Guide 2015: Материнские платы, чипсеты и сокеты

» Кручу-верчу, запутать хочу. Разбираемся в линейках HDD

Комментарии (23)

a553

17.04.2015 18:03+2Diablo 3 упирается в звуковую систему. Если не лень, можете поставить число звуковых каналов в 16, и это уже сильно повысит fps. Если ещё более не лень, в гугле есть ещё пара настроек, спасающих ситуацию.

А про меня и GTA 5 вы зря написали. Я уже обновил там, проблемы были в кривых дровах AMD, кто бы сомневался.

AlexanderG

17.04.2015 20:06+3Вот дожили. Что на Pentium 166 приходилось ковырять звук и выбирать число каналов, чтоб не лагало, что спустя 20 лет…

veam

17.04.2015 19:37А теперь самое главное. Что с разгоном, что без — видеокарта удивительно тихая.

А теперь запустите встроенный тест оценки производительности 7 винды и оцените шум там.

Вентиляторы у стрикса и msi G4 очень тихие, да.

Только вот толку с этого, если дроссели на моем экземпляре трещали раз в 20 сильнее этих тихих вентиляторов.

Shirixae Автор

17.04.2015 19:57+1На моей не свистели. Вопрос партии, поставки, условий гарантий вашего магазина. Можно было заменить видеокарту. :)

Allfar

17.04.2015 21:43А у меня не свистят, и вентиляторы, как вы уже сказали, тихие. Наконец-то собрал абсолюно беззвучный(очень тихий), даже под гагрузкой, PC.

prizzrak

17.04.2015 22:58А какой производитель? MSI?

Hertz

18.04.2015 02:31Видимо все-таки ASUS, вроде только их серия STRIX имеет адаптивный режим работы вентилятора.

У меня вообще кайф, EVGA 1000 P2 с адаптивной вентиляцией, и две GTX 980 STRIX купил в SLI — мне пока не удалось заставить их крутиться под нагрузкой, только при запуске компьютера или при ручной установке частоты вращения.

С картами правда небольшой конфуз вышел, они видимо из разных партий, немного отличаются внешне, и у них разный BIOS, одна из карт на загрузке компьютера практически сразу глушит вентиляторы, а вот вторая крутит их почти до логина в ОС.

zorge_van_daar

17.04.2015 21:48Почему вы основной упор делаете на разрешение? От разрешения зависит только количество задействованных блоков процессора для пиксельного шейдера и ROP'ов. Видеопамяти не для разрешения так много ставится, там не хранится 60 буферов кадра одновременно. При загрузке уровня, геометрия/текстуры просто погружаются в память карты, и, потом, отрисовываются не с винта/оперативки, а из внутренней памяти. Чем больше памяти, тем большую сцену можно загрузить в память и рисовать очень быстро. Если память на исходе (а 4 гига это только кажется, что много — сверхдетализированные юниты и тестура высокого разрешения, а то и не одна), то часть объектов из памяти выгружается, а загружаются другие. Тут вполне можно представить сценарий, в котором какой-либо мгновенно понадобившийся юнит будет подгружаться в медленную память, и как следствие — лаги и проседание частоты кадров.

Shirixae Автор

17.04.2015 22:01+2Если всё так просто, как вы говорите — почему на одних и тех же настройках в том же Dark Souls, в котором нет ни требовательных высокополигональных моделей, ни убертекстур на высоком разрешении GTX 970 выдаёт так мало кадров? :)

zorge_van_daar

18.04.2015 07:55Как раз потому, что буфер кадра вырос в 4 раза. Если даже предположить, что при увеличении в 4 раза на экране не будет видно больше геометрии (просто увеличится четкость картинки), то всяко учетверится количество выполняемых пиксельных шейдеров. Всякие тесселяции и сглаживания и отъедают большую часть ресурсов, а они повторяются для каждого пикселя.

Хотите увеличить в 4 раза выполняемую работу без просадки фпс? Увеличивайте частоту шейдерных процессоров или их количество в 4-6 раз. Память тут играет очень опосредованную роль, как вы сами можете посчитать — 1-2 буфера кадра поместится и в быструю часть памяти.

Да и не будем забывать, что DarkSouls просто может быть написан на движке, который плохо оптимизирован для работы с такими разрешениями, ибо движкописатели тоже знают принцип Парето и не будут стараться для считанных процентов игроков с 4к.

Hertz

18.04.2015 15:53Тесселяция выполняется для геометрии и на разрешение результирующего фреймбуфера ей в общем-то пофиг, если только ее степень искусственно не регулируется площадью (числом пикселей), которую геометрия будет занимать после отрисовки.

Стоит учитывать, что фреймбуфер это не самый крупный вкладчик в расход видеопамяти, скорее виновниками можно назвать текстуры.

zorge_van_daar

18.04.2015 18:48По поводу тесселяции — согласен, говорят там отдельный конвеер для ее выполнения. Но остаются еще кучу пиксельных эффектов, которые напрямую зависят от разрешения фреймбуфера. А ваш вывод про вклад фреймбуфера в расход памяти это ровно тот факт, чтобы донести который, я и начал эту ветку.

zorge_van_daar

18.04.2015 18:55Кстати, то ради чего была придумана тесселяция раньше делалось каким-нибудь bump mapping'ом, и не факт что теперь все отказались от него в пользу новой техники. А это именно пиксельный эффект и он зависит от разрешения.

Hertz

18.04.2015 19:12Действительно, большинство эффектов от тесселяции могут быть приближены с помощью normal/bump, parallax/parallax occlusion mapping, и зачастую это более оправдано, чем настоящая тесселяция.

Обычно пиксельный шейдер содержит самое больше из всех стадий число семплирований текстур, так что рост числа пикселей ещё и сильно повышает нагрузку на память.

А ещё можно реализовать в пиксельном шейдере настоящую трассировку лучей, и тогда разрешение имеет колоссальное влияние на быстродействие.

spanasik