Вчера ночью OpenAI выложил ещё несколько видео с OpenAI DevDAy и там довольно много интересного, как устроено то, что они анонсировали и более подробно, как они работают над новыми фичами. Видео действительно полезные для всех, кто собирается использовать их API. Сделал полный обзор.

Для погружения в основной список анонсов советую прочитать вчерашний обзор, здесь же будут более глубокие детали и частности. Но тоже безумно интересно.

Research x Product

Баррет от инженеров и Джоанна от продукта обсуждают, как они сотрудничают, чтобы вместе делать крутые вещи, особо уделяя внимание развитию диалогового интерфейса для улучшения опыта пользователя и как это помогает улучшать модели. Основное:

В OpenAI существует уникальное взаимодействие между исследовательскими и продуктовыми командами, что способствует быстрому превращению передовых исследований в ориентированные на пользователя продукты.

Команды столкнулись с проблемами при определении масштаба и характера диалогового интерфейса, в итоге выбрав универсальный подход, который стал популярным.

Сосредоточились на адаптации предварительно обученных языковых моделей для конкретных приложений, таких как ChatGPT и API, а не просто для научных целей.

До OpenAI работали над специализироваными моделями для конкретных задач, но большие, более универсальные модели, способные одновременно выполнять разнообразные задачи, оказались гораздо полезнее.

Много работают над упрощением пользовательского интерфейса

Цель - практическое применение и максимальная универсальность

Вкладываются в получение обратной связь от пользователей (палец вверх-вниз, какой ответ нравится больше, комьюнити), это даже влияет на приоритет исследований и разработок.

-

Разработка продукта отличается от традиционной компании, потому что цель - создание общечеловеческого искусственного интеллекта, а также что фокус все-таки на технолологию, а не на проблемы пользователей (да-да).

Уникальные аспекты работы инженеров и продактов в OpenAI Делают ставку на персонализацию моделей, мультимодальность (текст, звук, изображение) и решение сложных задач.

New Products: A Deep Dive

Продакт-менеджер и инженер показывают 3 демки (GPT cо знанием ML, говорящий как пират; взаимодействие с Asana через Retool API буквально копипастой формата запроса; извлечение данных из приаттаченной PDF), а потом интеграцию всего вместе, чтобы угадывать по фото настроение, через API Spotify подбирать микс и создавать для этого плейлиста обложку. И всё это на мобиле, с голосовым вводом.

А потом стали описывать типичные проблемы разработчиков (боже, как это знакомо), и для борьбы с ними сделали Assistance API

API позволяет создавать ИИ-ассистентов внутри приложений, используя возможности ChatGPT и инструменты, такие как интерпретатор кода и поиск информации. К основным функциям относятся ассистенты (ИИ с инструкциями и доступом к другим инструментам), треды (сессии или отдельные беседы) и сообщения (взаимодействия между пользователями и ассистентами). Всё это доступно уже сейчас, можно попробовать в песочнице. Механизмы очень похожие на создание GPTs без кода. Соответственно можно использовать и интерпретатор код, и извлечений знаний из загруженных файлов (в том числе обновлять их). Ну и режим вывода правильного JSON и параллельного выполнения функций тоже присутствует. А в будущем планируют включить поддержку мультимодальности, вызова вашего кода и асинхронной работы с сокетами (вау).

The New Stack and Ops for AI

Очень полезная сессия про переход от прототипа к продакшен-использованию.

UX. Интерфейс должен ставить во главу угла человека, а не AI, предлагая человеку варианты решений и инструменты уточнений, переделки, а также собирая обратную связь, которая пригодится для улучшений модели. Инструмент должен быть дружественным и надежным. И не забываем предлагать варианты, что можно спросить и ставить дисклеймер, что информацию надо проверять.

Безопасность. Обязательно промптом направлять модель в нужную сторону, запрещать отвечать вне рамок, валидировать результаты, предоставлять примеры, возможно дообучать, особенно в зарегулированных областях. Ну и используйте Moderation API (это уже от меня), чтобы в продукт не попала непотребщина всякая.

Надежная работа. Предлагают использовать режим JSON всегда, когда это нужно. А также с помощью seed валидировать результаты. Об этом писал тут

Согласованная работа. Если сталкиваетесь с галлюцинациями, лучше использовать внешние хранилища знаний (через RAG) и API, а потом уже скармливать точную информацию в промпт, чем доверять модели.

-

Оценка качества: Тут про важность создания валидированных датасетов, адаптированных к конкретным случаям использования, как оценененных человеком, так и более мощными моделями (GPT-4) для измерения качества и предотвращения падения качества. Результаты при релизах надо сохранять, и результаты после обновления моделей и промптов потом сравнивать с эталонными.

Вот, например, как сами используют Масштабирование - стоимость и задержки при работе: Предлагают семантическое кэширование для уменьшения вызовов к API и работу с менее крупными моделями, в том числе дообучение GPT-3.5 с помощью GPT-4 для ваших задач.

A Survey of Techniques for Maximizing LLM Performance

Опять же супер-полезная лекция, как улучшать работу LLM-ок. Покажите свои продакт-менеджерам, кто думает, что можно просто початиться с ChatGPT и фича готова.

-

Начинают с Prompt engineering: точные инструкции, разбиение задач на подзадачи, дать время и шаги на "подумать" и тщательно тестировать каждый шаг. Хорошо для быстрого прототипирования и создания бейзлайнов, но плохо для неизвестной для модели информации, гарантированного вывода, минимизации трат на токены.

Пример хорошего промпта

-

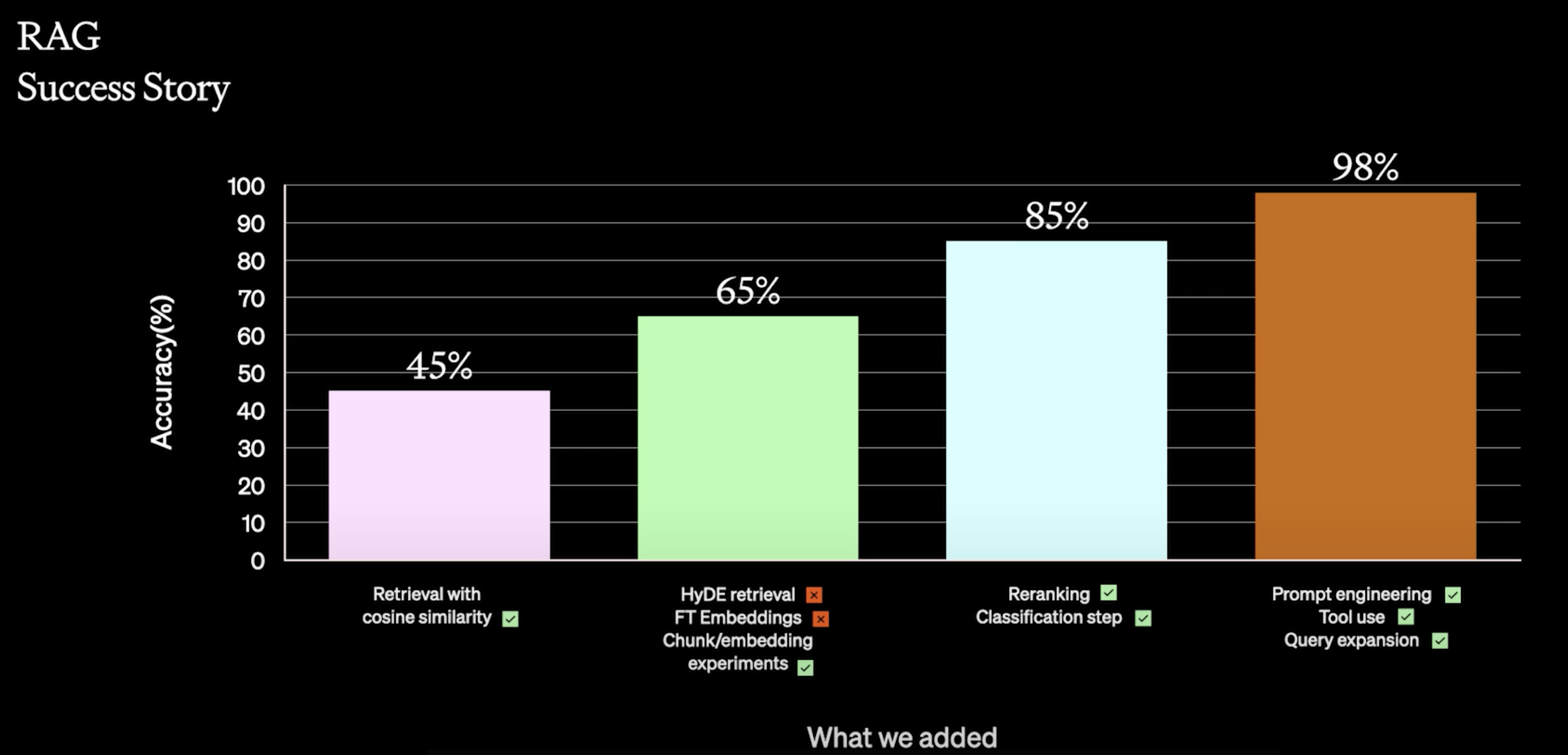

RAG (Retrieval Augmented Generation - ищем подходящую информацию во внешней базе, запихиваем в промпт, просим по ней ответить). Хорошо для уменьшения галлюцинаций и добавление в модель новой информации, но плохо для работы с очень большим доменом информации, обучение определенному стилю и минимизации трат на токены. Просит очень внимательно относится к поиску, поэтому это еще одна система, которая может загубить всю вашу работу.

Та самая картиночка, как команда разными манипуляцими с RAG допилась отличного результата

Fine-tuning. Хороший вариант для оптимизации под конкретную задачу, уменьшения потребления токенов и возможности использования более маленькую модель. Хорош для усиления знаний, которые уже есть в модели, структурирования ответов определенным образом, обучения сложным инструкциям. Плох для добавления новых знаний и быстрого прототипирования. Датасет можете из своих данных добыть, можете купить, попросить разметчиков или выжать из большой модели. Лучше использовать 100-200 качественных вопросов, чем скормить модели "все ваши данные".

Fine-tuning + RAG: Best of the best. И подходит для сложных инструкций, и деньги экономит, и позволяет новые знания добавлять. Но конечно процесс это будет небыстрый и непростой.

The Business of AI

Панельная дискуссия с 3 клиентами: Salesforce, Typeform и Shopify.

Самое сложное: двинуться дальше прототипа, согласовывая продуктовые изменения с организационными целями, рабочими процессами клиентов, а также этики и безопасности.

Стратегические запуски ИИ: Formless как отдельный продукт чатового заполнения форм для экспериментов или интеграция ИИ в Shopify в бете для сбора обратной связи

Доверие пользователей: Для B2B супер-важно, а потому лучше меньше, но точнее, безопаснее и с контролем администраторов. Для B2C - с контролем пользователей и уточнения результатов

Ценообразование: нужно найти баланс между затратами и ценностью. Много дискуссий о выборе между GPT-3.5 и 4. У каждой компании свой подход был.

Инновации: персонализированные ИИ для различных отраслей, выход ботов за пределы чатов, советуя проактивно улучшения рабочих процессов, а также предоставляя отличный пользовательский интерфейс для взаимодействия.

Метрики: обратная связь для B2B, время до получения ценности для B2C, стабильный ретеншн для маркетплейсов.

Будущее: все более глубокая интеграция во все аспекты разработки продуктов

Надеюсь, было полезно. Заходите на огонёк в телеграм-канал, там ещё больше полезного.