Системы искусственного интеллекта (ИИ) получают всё большее распространение. В связи с этим юристы и законодатели обсуждают проблему, каким образом должны регулироваться такие системы, кто будет нести ответственность за их действия. Этот вопрос требует внимательного изучения и взвешенного подхода, потому что системы ИИ способны генерировать огромные массивы данных и применяться в приложениях разной функциональности — от медицинских систем и автопилотов в автомобилях до предсказания преступлений и вычисления потенциальных преступников. При этом учёные стремятся к созданию «сильного ИИ», способного к рассуждениям, и здесь возникает вопрос, как определить наличие умысла в его действиях — или признать действия неумышленными.

Системы искусственного интеллекта (ИИ) получают всё большее распространение. В связи с этим юристы и законодатели обсуждают проблему, каким образом должны регулироваться такие системы, кто будет нести ответственность за их действия. Этот вопрос требует внимательного изучения и взвешенного подхода, потому что системы ИИ способны генерировать огромные массивы данных и применяться в приложениях разной функциональности — от медицинских систем и автопилотов в автомобилях до предсказания преступлений и вычисления потенциальных преступников. При этом учёные стремятся к созданию «сильного ИИ», способного к рассуждениям, и здесь возникает вопрос, как определить наличие умысла в его действиях — или признать действия неумышленными.Есть много способов привлечь к отчётности и ответственности систему ИИ, на эту тему опубликовано несколько исследований. В новой научной работе специалисты по компьютерным наукам, когнитивным наукам и юристов из Гарвардского и Кембриджского университетов (США) обсуждают одну составляющую будущей системы подотчётности ИИ, а именно — роль объяснительной записки от ИИ, то есть оценку того, как система искусственного интеллекта объясняет свои действия. Учёные пришли к выводу, что модуль объяснения действий должен быть отделён от общей системы ИИ.

Авторы научной работы описывают все проблемы, которые возникают при попытке запросить у системы ИИ объяснение её действий.

Во-первых, такая возможность должна быть предусмотрена на этапе разработки системы, иначе ИИ может отказаться или будет не способен объяснить свои действия.

Во-вторых, система ИИ обрабатывает большой массив данных с помощью сложных проприетарных алгоритмов или методами, которые она сама выработала в процессе обучения. Таким образом, при попытке объяснить свои действия наиболее полным образом она может сгенерировать слишком много данных, непонятных человеку. Или — как другая крайность — предоставит слишком упрощённую модель, которая не будет отражать реальные намерения ИИ и мотивы поступков. Кроме того, алгоритмы работы системы ИИ могут быть интеллектуальной собственностью компании-разработчика, так что следует предусмотреть такой способ составления объяснительной записки, чтобы установить причины действий системы, но не выдать лежащие в основе алгоритмы.

Исследователи считают, что объяснение возможно без раскрытия алгоритмов и правил, лежащих в основе функционирования системы ИИ. В случае инцидента система должна предоставить ответы на следующие вопросы:

- Какие основные факторы повлияли на решение?

- Привело бы изменение определённого фактора к изменению решения?

- Почему два похожих случая привели к разным решениям?

Ответы на такие вопросы не обязательно требуют раскрытия проприетарных секретов и внутренних алгоритмов системы, но в то же время дадут чёткое понимание её мотивов.

Учёные рассуждают, в каких случаях уместно требовать от ИИ объяснения его действий. По сути, это требуется в тех случаях, когда выгода от объяснения перевешивает цену его получения: «Мы считаем, что есть три условия для ситуаций, когда общество считает необходимым получить объяснение у лица, принимающего решение. Это моральные, социальные или юридические причины», — объясняет Финале Доши-Велез (Finale Doshi-Velez), ведущий автор научной работы.

При этом не следует требовать объяснений от ИИ буквально в каждой ситуации. Как уже говорилось выше, это повышает риски выдачи торговых секретов и возлагает дополнительную нагрузку на разработчиков систем ИИ. Другими словами, постоянная подотчётность ИИ человеку затормозит развитие этих систем, в том числе в важных для человека областях.

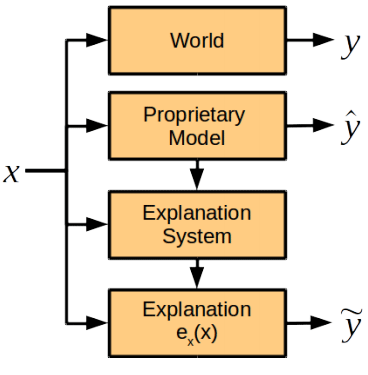

В отличие от распространённого мнения, что система ИИ — это чёрный ящик, причины поступков которого непостижимы для человека, авторы научной работы уверены, что можно разработать нормально функционирующий модуль объяснения действий ИИ. Этот модуль будет интегрирован в систему, но работать независимо от алгоритмов принятия решений и не подчиняться им.

Учёные считают, что существуют некоторые моменты объяснения поступков, которые людям легко изложить, а машинам — тяжело, и наоборот.

Сравнение способностей человека и ИИ к объяснению

| Человек | ИИ | |

|---|---|---|

| Преимущества | Может объяснить поступок апостериори | Воспроизводимость ситуации, отсутствие социального давления |

| Недостатки | Может быть неточным и ненадёжным, чувствует социальное давление | Требует предварительного программирования модуля объяснения, дополнительных таксономий и расширения системы хранения данных |

Тем не менее, группа экспертов рекомендует в первое время установить для систем ИИ тот же стандарт для объяснения своих действий, который сегодня установлен для людей (этот стандарт прописан в законодательстве США: в частности, объяснение требуется в случаях несения строгой ответственности, развода и дискриминации, для принятия административных решений и от судей и присяжных для объяснения своих решений — хотя уровень детализации объяснительной записки сильно отличается в каждом случае).

Но если причины действий ИИ выйдут за пределы понимания человека, то с целью подотчётности ИИ в будущем можно разработать другой стандарт для их объяснительных записок, считают учёные.

Научная статья опубликована 3 ноября 2017 года на сайте препринтов arXiv.org (arXiv:1711.01134v1).

Комментарии (9)

napa3um

16.11.2017 14:30С таким же успехом могли бы заняться написанием ПДД для сверхсветоскоростного транспорта или пенсионным законодательством для колонии бессмертных людей.

begemot_sun

16.11.2017 16:19Бред какой-то. Намерения ИИ. ИИ не субъект, а всего лишь автомат который действует по алгоритмам. Другой вопрос, что объснить эти алгоритмы мы можем, а вот интерпретировать результат и вычислить причины решения вы не можем.

Ну ок. На вход ИИ поступил сигнал такой-то это возбудило такие-то нейроны и получился такой-то ответ. Ну и что с того?

Я думаю кульминацией всего этого будет юридически-чистый ИИ который будет интерпретировать результаты работы подсудного ИИ.

Короче языки типа Agda, Coq будут в основе всех этих ИИ.

Вот когда будут — поговорим. Я, видимо, на пенсии уже буду к тому времени.

Не зыбывайте этот комментарий :)

Tertium

17.11.2017 01:31"… ну и вот… о, профессор, а Вы уже состарились? Ох, я ведь только начало объяснять, на основании каких корреляций и закономерностей я отнесло вон те штуки к этой категории"

pitsakh

17.11.2017 02:30Система F.D.O.M. же!

И Пентагон дал инженерам дополнительное задание – сделать работу системы открытой для внешнего наблюдателя, в удобной и наглядной форме демонстрируя, как именно принималось то или иное решение.

SADKO

17.11.2017 10:33Научная статья опубликована 3 ноября 2017 года на сайте препринтов arXiv.org (arXiv:1711.01134v1).

И это научная статья? Покажите мне ИИ, раскройте алгоритм УМЫСЛА, а пока это шляпа, вроде теологических рассуждений о том, чего-же хочет от нас боженька, и хочет ли он чего, ведь если он реален, то наверняка крут, и может ли он быть отражен в религиозных доктринах человеков? Ну да, богочеловек-Иисус, Мухамед-пророк, божественное откровение, но даже если оно имело место быть, было ли оно воспринято людьми, и не очеловечилось ли со временем всё то божественное, что возможно имело место быть, ведь даже история ислама не была простой, а про христианство я вообще молчу…

… чу, меня понесло, однако видит Бог, в этом прогоне больше практического смысла, чем в «научной статье» выше ибо религиозные организации, это объективная реальность с которой надо что-то делать, а искусственный интеллект со злым умыслом нетъ!

kolyan222

17.11.2017 13:14а искусственный интеллект со злым умыслом нетъ!

Я бы на его месте просто не светился.

SADKO

17.11.2017 10:49… а если говорить про некоторые виды нейросетей, то проблем с мотивированным объяснением нет в принципе, а если кто-то воспринимает их просто как чёрный ящик это его проблемы…

В процессе «обучения», нейросеть выделяет статистически значимые связи между сочетанием входных сигналов в обучающей выборке, и устанавливает их с расчётной достоверностью…

… на тестовой выборке мы можем в этом убедиться, а так же удостовериться в том, что имеет место именно генерализация, а не тупо запоминание…

Даже для очень больших сетей, есть методы их изучения и они применяются, например что бы судить о качестве выборок… (вспоминается анекдот про фотографии танков, тракторов и нейросеть, отличавшую одно от другого по специфическому фону :-)

cicatrix

Боюсь, если создадут сильный ИИ, это люди будут писать ему объяснительные записки, а не наоборот. :)

OlegZH

Бюрократия постоянно заставляет нас (людей) что-то писать. В том числе, и объяснительные записки. Может быть, ИИ уже давно изобретён и успешно действует?