Устная речь человека — уникальная по своей сложности система коммуникации. Ещё не изучено полностью, как язык работает на уровне человеческого мозга. Но мы знаем, как его осваивают дети, и с появлением технологий глубокого обучения (deep learning) мы впервые можем смоделировать этот процесс. Мы можем создать самообучаемую модель генеративного ИИ, которая изучает язык через звуки, а не текст. В этом посте мы чуть подробней рассмотрим этот подход к нейросетям, его целесообразность и перспективы.

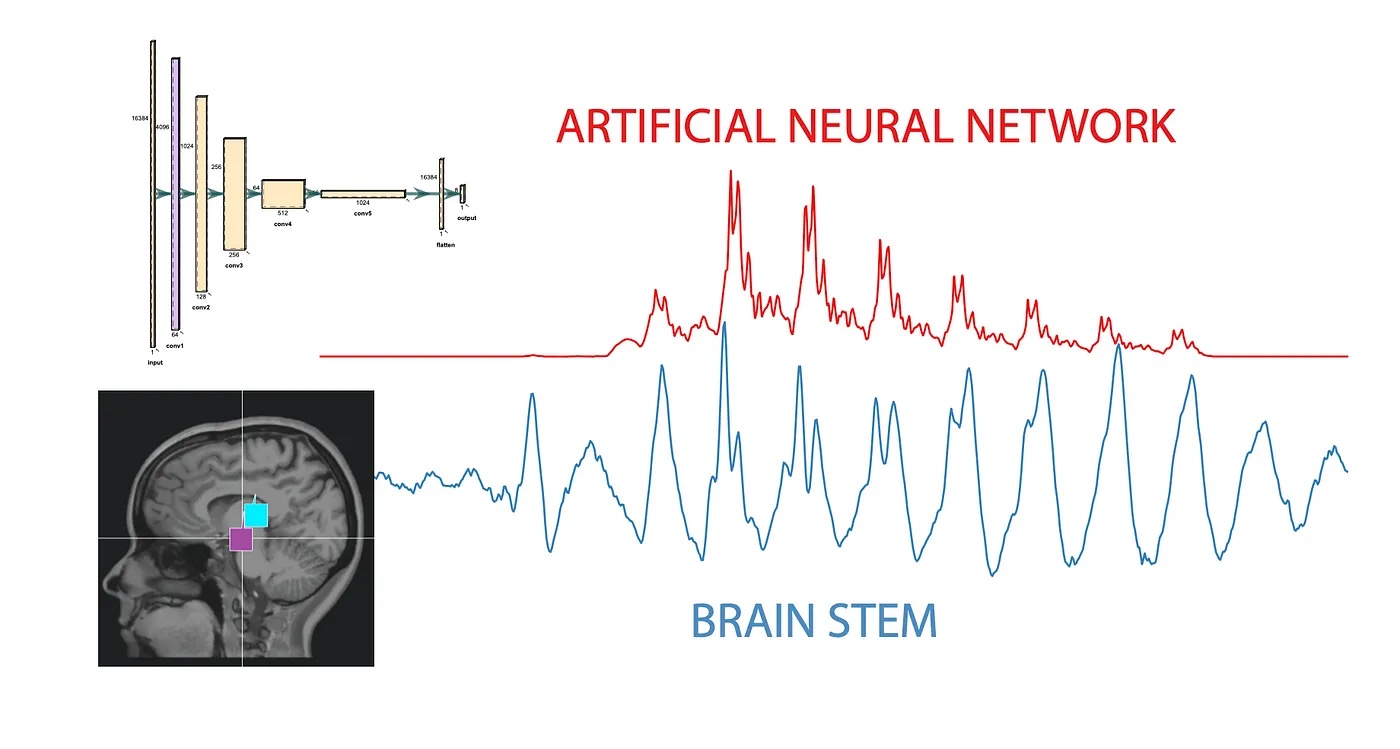

Для устного общения человеческий мозг использует свёрточные нейронные сети, которые отличаются высокой возбудимостью, особенно через зрительные раздражители. Поэтому для создания когнитивных моделей, которые должны имитировать работу человеческого мозга, используются не популярные сейчас сети-трансформеры вроде GPT-4, а именно сверточные нейросети.

Активность человеческого мозга изучают с помощью электроэнцелофалографии (ЭЭГ). Результаты мозговой активности при прослушивании информации оказываются очень схожи с результатами аналогичной работы искусственных сверточных нейросетей. Человек слышит звук, затем этот звук поступает через мозговой ствол в кору головного мозга. Именно в мозговом стволе можно зарегистрировать самую раннюю реакцию мозга на звук.

С этими сигналами вполне способны работать нейросети. Это не значит, что нейросети научились полностью имитировать человеческий мозг. Здесь для работы с ними используется метод обратного распространения ошибки — то есть отправки сигналов ошибки от выхода сети к ее входам, что невозможно реализовать в обычном мозге. Но у этой активностей, безусловно, есть общий знаменатель, на основе которого можно проводить сравнительные исследования. Интересно, что то, как мы слышим звуки, зависит в том числе и от того, какой язык был для нас первым; это же справедливо и для нейросетей, которые работают несколько по-разному в зависимости от того, на каком языке их тренируют.

Освоение языка человеком — очень интересный процесс. Дети начинают с того, что слушают все звуки вокруг, но месяцев с 11 уже начинают фокусироваться на том, что слышат поблизости. Когда они пытаются воспроизводить звуки речи, то часто путают буквы, схожие по произношению — и тот же самое происходит, когда речь осваивают нейросети. Генеративно-состязательные нейросети, обучившись на звучании десятка английских слов, изобретают собственные слова, точно как дети. В одном из экспериментов нейросеть, знавшая лишь три слова — suit, dark и water — сгенерировала слово start, совершенно обычное для английского языка.

Эксперимент по генерированию новых слов нейросетью:

Это направление интересно ещё и тем, что оно позволяет лучше понять, как работает «генеративность» нейросетей; в отличие от создания визуальных образов, взаимосвязи здесь представляются более наглядными. А что если наделить нейросеть речевым аппаратом, аналогичным человеческому? В таком случае она тоже будет изобретать новые для себя звуки.

GPT имеет огромный успех, поскольку тренируется на письменной речи, в которой заключен огромный пласт знаний человечества. Но устная речь при прочих равных содержит ещё больше информации, поскольку включает в себя и многочисленные невербальные сигналы. Услышав обычное «привет» вы можете сделать выводы о настроении человека, об отношении к собеседнику, о социальных связях между ними. Исследования этих процессов на уровне мозга можно будет применять уже в обозримом будущем, дать голос тем, кто лишен дара речи в принципе. Кроме того, нейросети открывают огромное поле для экспериментов, которые были бы невозможны на живых людях, исходя из базовых принципов морали, — экспериментов, связанных с перекраиванием связей между нейронами и другими искусственными ограничениями.

Ноам Хомский, известный американский лингвист и философ, в середине прошлого века выдвинул идею универсальной грамматики. Согласно Хомскому, в нашем мозге заложена врожденная система овладения языком, отделенная от других механизмов познавательной деятельности. Благодаря ей, они самостоятельно выводят правила языка из примеров, которые слышал от окружающих. При традиционных методах познания этих примеров для вывода общих принципов было бы недостаточно — но все дети умудряются делать это.

Моделирование с помощью нейросетей поможет понять, насколько верна концепция Хомского. Пока что исследователи добиваются значительных успехов с освоением речи нейросетями. Разница с человеческим познанием — где могла бы оправдать себя концепция Хомского — почти сводится на нет. Современные LLM способны не только говорить на человеческом языке, но и организовывать с его помощью внутренние мыслительные процессы, анализировать язык сам по себе. Концепция Хомского во многом опиралась на сравнение человека с другими животными, на его превосходство с точки зрения коммуникации. Но последние достижения в сфере нейросетей пока подтверждают, что ничего уникального именно у человека здесь нет.

Такой вывод вполне может стать аргументом в дискуссии об уникальности человеческого сознания и интеллекта. Согласно недавнему отчету Microsoft, ИИ уже начал демонстрировать метакогнитивные навыки, которые когда-то считались исключительно привилегией человека. Йошуа Бенжио, известный исследователь ИИ, лауреат премии Тьюринга 2018 года, в одном из своих докладов утверждает, что сегодня мы можем спроектировать ИИ, который способен пройти любой тест на сознание. С другой стороны, находятся и критики, которые, подобно Хомскому, верят здесь в пока необъяснимую уникальность человека.

Современные нейросети по своим когнитивным способностям приближаются к нашему уровню. Некоторые из них стремятся повторить работу нашего мозга, и эта имитация очень интересна в ракурсе лучшего понимания его работы. Но при этом они уже способны находить новые подходы к знаниям, выходить за ограничения человеческой природы. И здесь важно сосредоточиться не на сравнении машины и человека, а на том, как они достигают таких отличий. Это поможет нам выйти на горизонты знаний, недоступные нашему биологическому виду для самостоятельного освоения. В том числе — вопросы формирования сознания: если нейросети помогут нам открыть эту тайну, то мы сможем масштабировать и вывести эти модели на совершенно иной уровень. Создать тот самый «скайнет», чего уж там :) Возможно, в конце концов окажется, что сторонники панпсихизма правы, и всё вокруг нас наделено некоей формой сознания.

На пути обучения нейросетей с помощью естественного языка есть очевидные проблемы. Анализ устной речи требует гораздо больше вычислительных ресурсов, чем письменной — как мы упоминали выше, здесь нужно работать и на вербальном, и на невербальном уровне. Есть довольно простые неинвазивные способы соотносить устную речь и ответную активность мозга — через энцефалографию. Потребуется собрать очень много данных, но результат должен оправдать усилия, если мы сможем получить полную схему мозговых реакций на подобные сигналы.

Искусственные нейросети всё ещё во многом представляют собой черный ящик, как и человеческий мозг. Сравнивая их работу, мы лучше сможем понять как ИИ, так и собственную природу. В вопросе обучения ИИ для бесконечных прикладных сценариев разумно опираться на огромные пласты текстовой информации. Но если мы хотим заглянуть в суть вещей, приблизиться к фундаментальному пониманию того, как формируется сознание и функционирует мозг, в качестве исходного материала нам больше подойдет именно устная речь.

Вопросами на грани ИИ и человеческого языка занимается ряд ведущих университетов мира, в том числе Беркли, где работает Berkeley Speech and Computation Lab (лаборатория речи и обработки информации). В своих исследованиях они обозначают две глобальные цели. Первая — разработка нейросетей, более близких по модели своего развития к детям, чем другие актуальные нейросети. Вторая цель совпадает с той, что описана выше: улучшить наше понимание нейросетей за счёт использования иного типа медиа.

Комментарии (6)

nehrung

15.12.2023 14:48Чегой-то страшновато мне от таких статей... Виндж предсказал наступление технологической сингулярности не позже 30-го года, Курцвейл - не позже 40-го, но судя по таким статьям, оно наступает вот уже прямо сейчас.

И вот ведь что интересно - похоже, приключений на свою задницу люди готовят сами, из чистого научно-технического любопытства, а не потому, что назрела острая практическая необходимость.

"Шурик, а может, не надо?" (С)

MarselMM

15.12.2023 14:48Я боюсь, что GPT-5 с еще большим количеством параметров - это и есть сильный ИИ с ближайшей перспективой технологической сингулярности. Суперкомпьютеры уже перешагнули экзафлопсный уровень, а значит есть на чем запустить сильный ИИ. Есть крутые ИИ железки у того же Google. Мы уже очень близко подошли к сингулярности. Даже если OpenAI притормозит выход своего ChatGPT 5.0, то конкуренты в виде тех же китайцев вряд ли будут останавливаться, ибо сильный ИИ это решающее конкурентное преимущество перед другими странами.

markhor

15.12.2023 14:48Обучение на аудио требует на порядки больше ресурсов и поэтому нереально технически. Один условный ролик на YouTube занимает 50МБ в сжатом аудио и 10КБ в субтитрах. Даже если вычленять речь, понижать герцы, всё равно будет раз в 10 больше минимум. Есть прибыльные частные компании которые распознают речь в роликах и потом перепродают скрипты OpenAI и схожим.

Sergey_zx

15.12.2023 14:48Проблема в скорости.

Речь, это максимум два слова в секунду. Чтение текстового файла же ограничено только быстродействием системы.

DonStron

15.12.2023 14:48слова в виде аудиофайла тоже можно считывать на скорости ограниченной лишь быстродействием системы. Слушать аудиокнигу можно 12 часов в реальном времени, а скачать её можно за минуту. Соответственно и обрабатывать для обучения машина будет на сильно другой скорости.

peterjohnsons

Тоже об этом думал, что вместо текста надо обучать на аудио речи. Странно что пока нет прорывов в этом направлении. Наверное вычислительно это более затратно чем обучение на тексте. Напрашивается сам собой ИИ будущего, где можно будет говорить с ним на естественном языке.