Успех 30-ой серии видеокарт от Nvidia неоспорим. Прирост чистой мощности, Адекватная цена (в короткий период перед майнинг бумом). Тот же RTX 3070 давал почти х2 производительности в сравнении со своим младшим братом. И конечно же… От 40-ой серии ждали того же.

Но C’est la vie — и на выходе 40-ая серия, оказалась… Мощней? Слабей? Такой же?

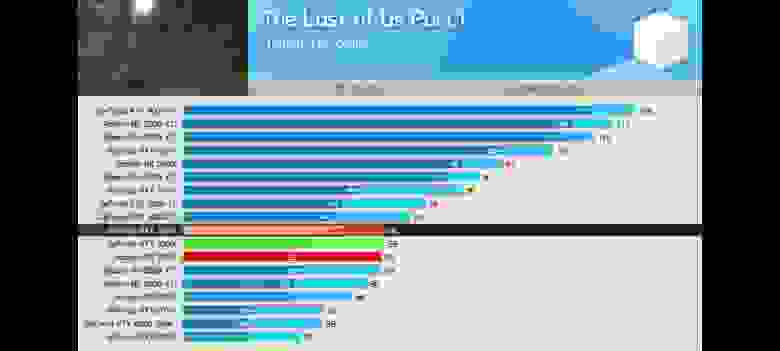

Ну смотрите сами:

Порезанная шина, но больший кеш.

Всего 10% чистой мощи? Зато DLSS 3.0.

Втрое больше транзисторов? Зато меньше Cuda ядер.

Но при этом все забывают об одной маленькой детали, которая меняет правила игры! Но о ней чуточку позже. А пока…

Видеокарты не то, чем кажутся — Парадокс нанометров

*Старческое ворчание* Вот раньше как было? Ты точно помнишь. Нужна заглушка. Берешь *30. Нужна карточка, чтобы запускала — берешь *50-ую линейку. А если хочешь играть, то уже и *60-ую.

*70-ые и *80-е нужны были кому? У кого много лишних денег. Кто берет компьютер на вырост. Монтажерам ещё, ну или кто рассматривает пиксели в лупу и сравнивает их с другими пикселями.

И *60-ую карточку можно было поставить в любое ведро. (у самого 1060 стояла на i5 3450 и не жужжала).

Но почему-то с выходом 20-ой серии все стало меняться…

Нанометры меньше. А карточки больше… И с 30-ой тоже самое…

Да и радеоны от них не отставали. И вот уже 4090-ой можно автономно отапливать квартиру, и уже не она устанавливается в материнскую плату, а материнская плата устанавливается на видеокарту.

И вот когда выходит первая нормальная видеокарта, все почему-то на неё набрасываются.

Собственно причина

Ну, настало время перейти к причине, почему Nvidia RTX 4060 — лучшая видеокарта за последние 7 лет.

А все дело в том, что это первая карта за последние 3 поколения, которая при увеличении мощности уменьшила энергопотребление, увеличила частоты и снизила теплопакет.

Да, можно сколько угодно шутить над размерами RTX 4090, в особенности её охлаждения. Но помним, что сама Nvidia разрабатывала подобное охлаждение, просто боясь чистой мощности от конкурентов. И есть версии этой видеокарты, которые значительно меньше и влезают в любой корпус.

Давайте просто сравним. Сначала GTX 1060 против RTX 2060. Да, RTX 2060 был мощней, чем 1060, и можно говорить о том, что теплопакет для RTX 2060 был оправдан. НО!

Почему тогда RTX 2060-й серии поедает больше, чем GTX 1070, при сопоставимой мощности?

При этом по чистой мощи эта карта равна GTX 1080. Но она равна ей и по потреблению, и даже по цене на момент выхода (спасибо майнерам).

При этом, давайте признаемся, что это тенденция только последних лет. Если сравнить 1060 с 760, то мы увидим нормальный процесс. Со снижением технологического процесса падает и энергопотребление, а карта становится мощней.

Но почему это проблема?

Все очень просто. Когда человек собирает компьютер, пусть и с «закосом» под игровой, он рассчитывает на определенные компромиссы. Да, карта младшая в линейке. Зато экономная, холодная, и можно сэкономить на БП и процессоре.

А тут получается, что 2060-ая требует к себе в пару и процессор, который будет её раскрывать, и теплоотведение, и блок питания такой же, как у GTX 1080.

Т.е. при том, что сама карта может быть даже дешевле, чем флагман прошлого поколения, её обслуживание выйдет значительно дороже.

И это при том, что карта на меньшем технологическом процессе. Следовательно, она должна быть более энергоэффективной на ватт. И при сопоставимой мощности должна быть холодней предыдущей. А не наоборот.

То же касается и поколения 30-ой серии.

Что здесь получается? 4 нанометра (в полтора раза сниженный техпроцесс) дали экономию всего в 5 ватт?

Да, безусловно, в меня сейчас могут полететь тапки. Т.к. 30-ая серия в два раза больше по количеству потоковых процессоров и на треть больше по количеству транзисторов. И она, безусловно, больше.

Но это все ещё здоровенная печка. И что делать в случае, если хочется поставить свежую околоигровую видеокарту в средний компьютер? Ограничивать себя RTX 3050?

Или переходить на младшие радеоны RX 6400, которые могут предложить производительность, уложив её в 50 ватт?

Если этого недостаточно, можно вспомнить шутку из ноутбучного мира, когда RTX 3050 Mobile проигрывает GTX 1660 TI Mobile по всем параметрам.

Теплопакет.

Мощность.

Стабильность.

Фактически последние несколько лет (с выхода 20-ой серии) у пользователей не было нормальной по производительности карты, которую можно было бы установить в средний компьютер, не утруждая себя покупкой блока на 700 ватт и теплоотведения с использованием воды или 40 кулеров.

Вот он… Герой!

И именно поэтому свечка и совершает свои колебания 4060 — это карта, которую мы ждали почти 7 лет.

Потому что это первая карта, которая смогла уменьшить свое энергопотребление. Уменьшить свое тепловыделение и, при прочих равных, все равно дать прирост в производительности.

При этом она больше своего предшественника вдвое. И энергоэффективней в полтора раза.

И что все это значит? Абсолютно ничего! На деле, мы снова получаем адекватную карточку с адекватной мощностью, которую можно установить в бюджетный компьютер с небольшим блоком питания и не самым шустрым процессором.

И именно эту потребность закрывала всегда 60-ая линейка в серии.

Посткриптум

Можно сколько угодно перебрасываться тапками, и рассказывать, что и на 1060-ой неплохо живется, и что вообще 50-ая серия + FSR может закрыть потребность. Но проблема заключалась в том, что раньше человек собирал компьютер и подбирал под него видеокарту. А в последние лет 6 ситуация была строго обратной, и человек сначала брал видеокарту и потом под неё собирал компьютер, что делает всю сборку значительно дороже, чем она могла бы быть.

Очень хочется верить, что после 40-ой серии видеокарт у нас снова закрепятся холодные и экономные решения для средних по мощности и бюджету компьютеров.

А, ну и да, если им удалось сделать более экономной десктопную версию, значит, им удастся донести больше чистой мощи и в мобильную версию… Но это уже что-то из области фантастики.

П.с.с. Ах да, ну а что касается мощности… Давайте признаемся, что без лучей нам уже хватает видеокарт с головой. А с всякими DLSS и FSR комфортно играть можно хоть на 1070 или даже на 1060. Поэтому что мощность 30-ой серии была избыточна, что мощность 40-ой.

Комментарии (173)

MessirB

22.07.2023 07:04+20Видеопамяти меньше чем на 3060, производительность процентов на десять выше. Эта карточка должна была бы называться 4050 в лучшем случае.

lightman

22.07.2023 07:04+1Согласен. Вообще есть ощущение что на этапе проработки серии видеокарт в инженерном отделе изначально было нормально:

4050-ti-4060-ti-4070-ti-4080-ti-4090-tiНо в маркетинговом отделе решили, что будем продавать карты дорого, но чтобы ввести потребителя в заблуждение, мы выкинем часть карт, сдвинем часть линейки вверх

И получились названия: старое→новое

4090→4090

4080→4080 16gb

4070→4080 12gb

4060→4070

4050ti→4060ti

4050→4060Правда в последний момент перед анонсом постыдились, и переименовали 4080 12 gb в 4070 ti, заставив вендоров переделывать уже напечатанные коробки. А вот на исправление остальной серии совести уже не хватило, пошла в продакшн как есть. Ведь потребители идиоты, они не будут читать тестов, а придут в магазин и слепо схватят коробку с привычными цифрами. Вот только они забыли, что шила в мешки не утаишь - о разочаровании обзорщиков производительностью 4060 и 4060 ti кричат чуть ли не из каждого утюга. А во-вторых такой обман если и прокатывает, то только один раз.

MountainGoat

22.07.2023 07:04+44060 - это 3060 с пониженным электропотреблением и псевдокадрами. Причём надо помнить, что привязка псевдокадров к 4 серии полностью искусственная и софтовая, её в любой момент могут отменить либо Нвидия, либо хакеры. А могут и не отменить.

В играх же 4060 нередко оказывается чуть-чуть хуже, чем 3060, из-за слишком удавленной памяти. И дальше будет хуже.

MountainGoat

22.07.2023 07:04+2Речь была про 8Гб. 4060 16Гб позволяет уже вздохнуть свободнее. Но у неё вопросы по цене, и по надёжности архитектуры: они натурально впихнули невпихуемое, по 2 чипа памяти на канал для одного. Как это всё себя поведёт на практике - надо ждать и смотреть.

Я думаю в Нвидии действительно шуганулись, когда этой весной по форумам стали ходить слухи что Starfield и другие крупные игры на 8Гб запускаться не будут вообще. Как верно говорят два придурка с камерой - крупные игры сейчас пилят в первую очередь под консоли. ПК идёт уже по остаточному принципу "после релиза допилим". О чём они не говорят, так это что на консолях по 12Гб видеопамяти на хорошей шине, и разработчики вполне могут взять это за базис, даже если их маркетологи так не думают.

Поэтому Нвидия сначала в июне добавили в драйвер режим своппинга, что они отказывались делать в течении 10 лет. Теперь драйвер сам сбрасывает излишние данные в системную память. Причём реализовано это так, что крупно поднасрало всем ИИ энтузиастам: модель ИИ, подогнанная под конкретный объём видеопамяти, больше туда не помещается. А теперь вот Нвидия выпускает явно на бегу придуманные 4060 с 16Гб памяти. Причём даже без нормальной процедуры рекламы релиза.

Испугались.

Opaspap

22.07.2023 07:04А где можно почитать про этот новый своп ? Быстрое гугление че-то ничего не дало.

rogoz

22.07.2023 07:04+54060 16Гб позволяет уже вздохнуть свободнее

Но такой нет в природе. ) Есть 4060 Ti 16 за оверпрайс.

truthseeker

22.07.2023 07:04+2А "два придурка" — это, случайно, не ребята с iXBT Games? Если да, то обидно за них. Очень неглупые ребята, и их шуточки очень хорошо заходят публике. Нет, конечно Дарья Островская делает видосы не хуже, есть у её видосиков весомые преимущества, но ребята с iXBT Games, ИМХО, лучшие. Шутники, немного, и шутят иногда немного не скрепно, но они определённо хороши????

SergiiDia Автор

22.07.2023 07:04+1подскажите пожалуйста источник, где 4060 оказывается хуже чем 3060... Я бегло пробежался по нескольким обзорам и видеобзорам, не нашел подобной информации... Был бы очень благодарен за ссылочку.

lightman

22.07.2023 07:04+1Hidden text

Обратите внимание на просадки до 5 кадров, по сути сильные статтеры, что делает игру неиграбельной, а всё из-за 8 гигабайт памяти. На данный момент вышел патч, исправляющий это (скрин 3), но такие просадки говорят о фундаментальных ограничениях карты, в которые она будет упираться всегда. И не факт что разрабы всегда и везде будут оптимизировать под это. Иногда вы не сможете поиграть в свежую игру, поэтому что будете ждать оптимизаций, в то время как все вокруг уже играют. Как по мне - лучше взять видеокарту с нормальной шиной и с 12+ гигами памяти, пусть и предыдущего поколения.

GennPen

22.07.2023 07:04+10На деле, мы снова получаем адекватную карточку с адекватной мощностью, которую можно установить в бюджетный компьютер с небольшим блоком питания и не самым шустрым процессором.

Бюджетный - это когда все комплектующие сравнимо дешевые, а не когда "бюджетная" видеокарта стоит дороже всех остальных комплектующих вместе взятых.

immortal555

22.07.2023 07:04Уже лет как 15 цена средней современной игровой машины составляет плюс-минус 1000 долларов. Так было и при долларе по 35, так и осталось при долларе по 90. Разница только в том, что раньше процессор стоил сопоставимо видеокарте, а сейчас баланс съехал в пользу видеокарт.

Понятие "бюджетный" это скорее к сборкам авито-стайл. Там либо сплошные компромиссы касательно понятия "игровой", либо проще доплатить и взять в магазине вышеупомянутую машину.

saboteur_kiev

22.07.2023 07:04+1Уже лет как 15 цена средней современной игровой машины составляет плюс-минус 1000 долларов

Как появились видеокарты в принципе, так и составляет. То есть уже лет 25.

Я бы сказал 30, но 30 лет назад хорошие видяшки еще не составляли массовый рынок, и соответственно производители игр хоть немного, но оглядывались на software rendering

K0styan

22.07.2023 07:04Немного? 30 лет назад был 1993 год, Doom даже до второй версии не добрался. Местами ещё EGA встречались.

saboteur_kiev

22.07.2023 07:04+1вот именно. местами. То есть современная на 1993 год машина (даже не мега-топовая) собственно и была плюс-минус 1000 долларов (хороший цветной монитор поддерживающий SVGA, видеокарточка поддерживающая 800x600 и потом выше. типа S3, процессор пентиум, а не целерон, и так далее..

PuerteMuerte

22.07.2023 07:04процессор пентиум

Комп с пентиумом внути в 1993 году стоил тыщи четыре баксов, а до первого целерона оставалось ещё полдесятилетия.

saboteur_kiev

22.07.2023 07:04Окей, ошибся на годик-другой. Пентиум в 1993 был не хорошей а топовой машиной. Возьмем тогда 486 dx какой-нить, что ближе к понятию "современный игровой комп", а не "мегатоповый для мажоров"

PuerteMuerte

22.07.2023 07:04Окей, ошибся на годик-другой.

Точнее, на третий-четвёртый :)

Возьмем тогда 486 dx какой-нить, что ближе к понятию "современный игровой комп",

Уже ближе, но 486DX в 1993-м не в совсем уж дешманской конфигурации стоил тыщи две, что по нынешним меркам в два раза больше. Это как раз самый топчик был. Пентиум в 1993-м, это уже нечто из HEDC.

edogs

22.07.2023 07:04+1Уже лет как 15 цена средней современной игровой машины составляет плюс-минус 1000 долларов.

С одной стороны - это верно не меньше чем с 93, по личному опыту, т.е. лет 30 уже.

С другой стороны последнее время видяхи так подорожали, что цена именно игровой машины в районе 1500 долларов. В районе 1000 - просто хороший офисный комп, на котором можно поиграть.

Areso

22.07.2023 07:04+1С другой стороны последнее время видяхи так подорожали, что цена именно

игровой машины в районе 1500 долларов. В районе 1000 - просто хороший

офисный комп, на котором можно поиграть.И главный вопрос - согласны ли с этим геймеры? Учитывая, что в Стиме аж на несколько лет обосновалась 1066 в топе, то нет.

Люди либо откладывали апгрейд, либо отменяли его вовсе, покупая приставку.

SergiiDia Автор

22.07.2023 07:04А здесь все очень просто. В большинстве случаев, FHD как разрешения достаточно на экранах вплоть до 24 дюймов (Понятно что 2К лучше и плотней). Если брать монитор больше, значит садиться дальше (чтобы не размахивать головой во все стороны). И следовательно, если задача просто поиграть в новинки, а не "понтоваться с тем, сколько у меня кадров, какое разрешение и какая кайфная подсветка", то 1060 достаточно... а с появлением даже FSR 2.0 её хватает с большим запасом.

И в Киберпанке без лучей на high (с FSR на quality) 50 стабильных фпс, и в паучке... Т.е. карта 7ми летней давности вполне справляется.Плюс не забывайте о двух бумах майнинга, которые сделали видеокарты дефицитным товаром.

ИМХО, если бы не майнинг. Народ вполне себе довольный сидел бы на каком-нить RTX 2070 с тем же удовольствием, как они это делают на 1060.

edo1h

22.07.2023 07:04ИМХО, если бы не майнинг. Народ вполне себе довольный сидел бы на каком-нить RTX 2070 с тем же удовольствием, как они это делают на 1060.

что-то я не улавливаю логики. из-за майнинга видеокарт было продано больше? да

сейчас майнинг на видеокартах актуален? не особо

и куда же делись те видеокарты? не закопаны же у майнеров на огородах

edogs

22.07.2023 07:04и куда же делись те видеокарты? не закопаны же у майнеров на огородах

Часть сгорела, достаточно большая часть. Часть продолжает работать, электричество окупает и дает небольшой плюс, закупать новые под это дело не закупают, но и старые не продают. Часть ушла на фермы рендеринга и нейросетей. Часть просто выкинута, т.к. с одной стороны они уже окупились, с другой стороны продавать после майнинга их тяжело.

Areso

22.07.2023 07:04Бу продаются, часть майнят в небольшой плюс, кое-кто сдаёт майнинг фермы под машин лернин

edogs

22.07.2023 07:04Во-первых, геймеры согласны, исходя из Ваших же слов что они откладывали апгрейд или уходили на приставку. То есть нужду проапгрейдиться они чуяли со своим 1060, но просто не было достаточно свободных денег, роэтому откладывали или уходили. А были бы деньги на хороший игровой - проапгрейдились бы.

Во-вторых, на стиме большая часть народу это не геймеры, это просто обычные люди с хорошим офисным компом на котором можно поиграть:) может еще немного майнеров. Под геймерами и игровым компом надо все же понимать людей которые покупают комп спецом для игр и у которых игры большая часть деятельности. Мы вот со своим ноутбучным мх150 тоже светимся на стиме и даже играем иногда, но до геймеров нам как пешком до луны.

На самом деле тут, конечно, изрядно малину испортила крипта. Иначе стоила бы сейчас 4090 дай бог 500 баксов и не было бы проблем уложить игровой комп в 1000 баксов.

Areso

22.07.2023 07:04+1Под "геймерами" я понимаю не тех, кто этим зарабатывает, а тех, кто тратит на это хобби больше других: покупает сами игры, ПК лучше "офисного" (хотя ноут для разработчика я ору сколько денег стоит), ну и наконец время.

edogs

22.07.2023 07:043060 стоит на 150 баксов дороже 1060. Геймер который тратит деньги на это хобби, покупая игры, и заметим - в основном западный геймер с его доходами, ходящий с айфоном за полтора косаря, уж всяко найдет 150 баксов хотя бы на 3060 апгрейднуться. 1060 вышла в 2016 году если что. Так что владельцы 1060 - не геймеры в этом смысле.

PuerteMuerte

22.07.2023 07:04+13060 стоит на 150 баксов дороже 1060.

Ну как 150, плюс-минус триста баксов она на Амазоне стоит, в то время как 1060 на вторичке где-то баксов 50-60. Ну т.е. даже апгрейд - это 250 баксов. Для западного геймера это тоже заметные деньги. Там далеко не все покупают айфоны за полтора косаря. Большинство покупает всякого рода реалми за две сотни, и ходят с ним три-четыре года. Точно так же, как и с видеокартой. Ну а геймер - это тот, кто любит играть, а не тот, у кого на это есть много денег в бюджете, поэтому геймеров с очень экономным железом в мире хоть отбавляй.

nidalee

22.07.2023 07:04Ну как 150, плюс-минус триста баксов она на Амазоне стоит, в то время как 1060 на вторичке где-то баксов 50-60.

Ну вы же ее не сейчас покупаете, а покупали когда-то за ее полную стоймость? Так-то 1080ti тоже сейчас на Авито можно за 15 тысяч купить.

Areso

22.07.2023 07:04Тут скорее про то, чтобы продать 1066 за 60 долларов и купить 3060 за 300 долларов.

edogs

22.07.2023 07:04Что бы иметь 250 баксов на апгрейд - достаточно было с покупки 1060 (в 2016) откладывать по 3 бакса в месяц. Не деньги для "любимого дела", особенно учитывая то, что речь идет об аудитории, достаточно богатой что бы покупать игры на стиме, а не пиратить их.

PuerteMuerte

22.07.2023 07:04достаточно было с покупки 1060 (в 2016) откладывать по 3 бакса в месяц.

И где у вас копилки, где вы откладываете по несколько баксов в месяц на видеокарту через пять лет, на стиральную машинку через 15 лет, на холодильник через 20, на джинсы через год? Нет? Вот то-то и оно :)

edogs

22.07.2023 07:04Эти копилки могут называться кредитами:)

Давайте поставим вопрос по другому. Вы знаете лично хоть кого-то, кто за 7 лет потратил бы на любимое дело меньше 250 баксов?:)

Areso

22.07.2023 07:04Тут же ещё "размазанность" трат имеет значение. То ли по 3 доллара в месяц, то ли возьми и выложи сначала 300, чтобы купить, потом 60 вернётся после продажи...

А если ипотека, а если дети?

Areso

22.07.2023 07:04Никто вам не даст кредит на 250 долларов. Кредитка - ну так это 25 до 110 дней, кому как повезло с условиями.

edogs

22.07.2023 07:04Никто вам не даст кредит на 250 долларов.

А солнце восходит на западе.

Кредитка - ну так это 25 до 110 дней

До 365 дней, плюс ее можно конвертнуть в рассрочку или загасить с другой кредитки.

PuerteMuerte

22.07.2023 07:04Вы знаете лично хоть кого-то, кто за 7 лет потратил бы на любимое дело меньше 250 баксов?

Да. Я, например, люблю играть, и вполне себя считаю геймером, но карточки за 250 баксов до последнего десятилетия не покупал. Потому что сначала было просто глупо, отдавать зарплату, или ползарплаты за баловство. Потом - ипотека. Потом играться было особо некогда, и тоже не хотел тратить на не особо востребованную вещь. Поэтому брал то, что б/у и баксов за 60-70.

А кредиты на видеокарту... ну, если только у вас не кредитная карта, это штука сильно на любителя. В моём мировоззрении, только финансовый наркоман будет брать кредит на игрушки.

edogs

22.07.2023 07:04Я, , люблю играть, и себя считаю геймером, но карточки за 250 баксов до последнего десятилетия не покупал

То есть все-таки купили. ЧТД:)

PuerteMuerte

22.07.2023 07:04То есть все-таки купили. ЧТД:)

Ну, блин, до последнего десятилетия я ещё тридцать лет был геймером, с тех пор, как в 1988-м году в "Galaxian" первый раз зарубился. Сейчас-то что там можно доказывать? Середина пятого десятка, ипотеки давно нет, свободное время есть, здоровье ещё тоже есть, интерес пока остался, доходы позволяют. Но, минуточку, много там в стиме юзеров с таким совпадением характеристик?

edogs

22.07.2023 07:04Так мы же обсуждаем промежуток 2016-2023 год, какое еще десятилетие тут обсуждается, если не последнее?:)

Но, минуточку, много там в стиме юзеров с таким совпадением характеристик?

В принципе, все Ваши характеристики сводятся к возможности потратить 250 баксов на любимое хобби за 5 лет. И это немного, т.к. кто-то купит велосипед за 60к рублей, кто-то покупает кроссовки за 200 баксов каждые полгода, кто-то побухивает на выходных блек лейбл, кто-то еще что-то. Большинство наших знакомых у которых есть хоть какое-то любимое дело - тратят на него значительно бОльшие суммы.

PuerteMuerte

22.07.2023 07:04И это немного, т.к. кто-то купит велосипед за 60к рублей, кто-то покупает кроссовки за 200 баксов каждые полгода, кто-то побухивает на выходных блек лейбл, кто-то еще что-то.

Понимаете, гейминг - такое занятие, которое вообще никак не исключает велосипеды, кроссовки, бухло, вышивание крестиком и промышленный альпинизм. Наоборот, у практически всех играющих есть и какая-то другая жизнь, и эти 250 баксов, это не "250 баксов вообще", а "ещё 250 баксов ко всему остальному".

edogs

22.07.2023 07:04Вы не геймер:) У Вас гейминг это занятие после велосипедов, кроссовок, бухла, вышивания крестиком и альпинизмом. Занятие, на которое Вы думаете найти ли 250 баксов после того как отвалили на все предыдущее несколько тысяч.

Это то, про что мы говорили в начале самом

это не геймеры, это просто обычные люди с хорошим офисным компом на котором можно поиграть

Под геймерами и игровым компом надо все же понимать людей которые покупают комп спецом для игр и у которых игры большая часть деятельности.

Мы вот со своим ноутбучным мх150 тоже светимся на стиме и даже играем иногда, но до геймеров нам как пешком до луны.

PuerteMuerte

22.07.2023 07:04Вы не геймер:)

Я геймер. Точно так же как и велосипедист, хотя не проживаю всю жизнь на велике и не покупаю убербайки с карбоновыми рамами за $5К, как мой брат. Ещё я лыжник, и тоже не посвящаю этому всю свою жизнь, а только две недели в году, а снарягу уже лет десять как не менял, кроме термобелья, и т.д. Вы же поймите, хобби - это не обязательно упарывание с погружением с головой и с просаживанием финансов. Если вы хотя бы иногда играете, если вы разбираетесь в жанрах, игровых студиях, железе - вы уже геймер. Даже если у вас вообще дома своего компьютера нет.

это просто обычные люди с хорошим офисным компом на котором можно поиграть

Если в современном компьютере есть дискретная видеокарта, он уже не офисный :) Это или профессиональная рабочая станция, или игровой компьютер.

edogs

22.07.2023 07:04Если вы хотя бы иногда играете, если вы разбираетесь в жанрах, игровых студиях, железе - вы уже геймер

Ну да, ну да, тогда я еще и ученый, ведь я в университете что-то изучаю. А еще физик-ядерщик, ведь я знаю из курса физики что у атомов есть ядра. А еще дизайнер, ведь аватарку для хабра сам задизайнил. На этом весь хабр должен встать и сказать "ягеймер" в стиле "яшарли", тем самым убивая сам смысл этого термина.

Вы же поймите, хобби - это не обязательно упарывание с погружением с головой

Не в том дело. Просто из Ваших речей следует, что именно гейминг "недостоин" в принципе ничего. Задвинули его на задворки велосипеда и альпинизма, на вышивание крестиком килобакс норма спустить, на гейминг "еще 250" - "ой ой ой че так дорого, ну на фиг".

И да, напомним, что как бы то ни было, Вы эти 250 баксов на гейминг потратили:) Даже Вы, который гейминг задвигает на самые задворки. Так сколько должны тратить тру геймеры? Для которых гейминг не на 10 месте, сразу после вышивания крестиком?Если в современном компьютере есть дискретная видеокарта, он уже не офисный

Не так давно собирали десктоп. Взяли проц без дискретки. И дискретку. Получилось дешевле чем проц с дискреткой. Маркетинг такой маркетин, все с ног на голову ставит.

PuerteMuerte

22.07.2023 07:04Не в том дело. Просто из Ваших речей следует, что именно гейминг "недостоин" в принципе ничего

Это ещё одна вещь, которую вы сами придумали, и сами оспорили :) Из моих речей следует, что гейминг, как и подавляющее большинство других хобби, прекрасно существует и без заметных трат на железо, просто потому, что кто-то не может, кто-то не хочет. Ничего более этого я не писал, и не имел в виду.

Ну да, ну да, тогда я еще и ученый, ведь я в университете что-то изучаю. А еще физик-ядерщик.

Не передёргивайте. Но вот если вы некоторое время уделяете научной работе по ядерной физике, вы действительно физик-ядерщик. Даже если вы не купили себе домой личный реактор, и вообще не копейки не вложили в это дело (хотя чёрта с два у нас так получится - то канцелярию на кафедру покупать заставят, то на подарки начальству скидываться).

Не так давно собирали десктоп. Взяли проц без дискретки. И дискретку. Получилось дешевле чем проц с дискреткой.

Ну не перегибайте. "Дешевле" может быть только для мощных райзенов предыдущих поколений, которые сами по себе ни разу не офисные.

edogs

22.07.2023 07:04Это ещё одна вещь, которую вы сами придумали, и сами оспорили :)

Дада, конечно, это же не Ваша фраза " у практически всех играющих есть и какая-то другая жизнь, и эти 250 баксов, это не "250 баксов вообще", а "ещё 250 баксов ко всему остальному". "© Поставив перед геймингом вообще все включая вышивание крестиком.

Это мы ее придумали и за Вас на хабр в Ваш же коммент вписали, ага, ага.Ну не перегибайте

Как было так и сказали, верить или нет - Ваш выбор.

Не передёргивайте.

Вы своим определением геймера записали туда вообще любого кто хотя бы пару раз игру запускал и еще пару раз запустить планирует. Так что это Вы не обобщайте, а мы не передергиваем.

PuerteMuerte

22.07.2023 07:04Дада, конечно, это же не Ваша фраза

Извините, но каким образом из этой моей фразы следует, что " гейминг "недостоин" в принципе ничего "? Человек, по вашему, на все свои занятия тратит сопоставимые суммы, что ли?

Вы своим определением геймера записали туда вообще любого кто хотя бы пару раз игру запускал и еще пару раз запустить планирует

Я своим определением геймера записал туда вообще любого, кто хотя бы иногда играет и получает от этого достаточно удовольствия, чтобы продолжать это делать и далее. Совершенно независимо от суммы, которую этот человек может/хочет себе позволить на это хобби, и независимо от наличия у него мощного железа. Есть существенная разница между моим определением, и тем, что вы себе надумали.

edogs

22.07.2023 07:04Извините, но каким образом из этой моей фразы следуе

Из нее другое следует, перечитайте еще раз наш коммент.

Я своим определением геймера записал туда вообще любого,

Да, в этом и проблема.

PuerteMuerte

22.07.2023 07:04Из нее другое следует, перечитайте еще раз наш коммент.

Перечитал ваш коммент:

Просто из Ваших речей следует, что именно гейминг "недостоин" в принципе ничего

Нет, другое не следует, вы написали именно то, что я процитировал.

Да, в этом и проблема.

Там другое следует, перечитайте ещё раз мой коммент.

Ещё вопрос, теперь уже в оффтопик: а почему вы о себе во множественном числе пишете?

fedorro

22.07.2023 07:04+4А тут получается, что 2060-ая требует к себе в пару и процессор, который будет её раскрывать, и теплоотведение, и блок питания такой же, как у GTX 1080.

Корпус, в который всё это влезет; новый стол; ИБП помощнее; отдельную проводку, медь полторашка, хотябы; автоматы помощнее;

собственная подстанция...А то что новые поколения требуют больше мощи - возможно она тратится на все эти вспомогательные технологии, типа лучей и прочего, не знаю, учтены ли они в производительности с плавающей точкой.

MountainGoat

22.07.2023 07:04"Лучи и прочее" отдельными транзисторами делаются. Когда они не используются, они обесточены.

fedorro

22.07.2023 07:04+1Ну да, но они могут на вспомогательные задачи использоваться (хотябы тензорные ядра). Ну и про мощность я, может, упустил - она указана с учетом этихотдельных транзисторов или только на основную производительность?

MountainGoat

22.07.2023 07:04+2Мощность указывается средне-хитрожопая за период времени и да, с использованием всего железа. Что важно знать - пиковая мощность превосходит среднеуказанную до трёх раз, и в просто игре карта вылетает на пиковую мощность регулярно. Если блок питания не может с этим управиться, то привет баги и вылеты. Привет диванным сборщикам с их "600 ватт хватит всем".

flashmozzg

22.07.2023 07:04Трассировка лучей может сильно цпу нагружать. Там много что на нём строится, перед тем как на гпу уйти.

GRascm

22.07.2023 07:04+3Интересно, если мощность видеокарты осталась той же, то почему к ней можно ставить процессор слабее?

12val12

22.07.2023 07:04+2Мне кажется эта видеокарта плоха для итерационных вычислений. из-за ужатой шины

где каждую итерацию надо отправлять с хоста (конечно же по шине) данные и получать обратно свежие пересчитанные

lightman

22.07.2023 07:04Угу, из-за 128 бит шины на ней распаяно всего 4 модуля памяти, соответственно пропускная способность получается печальной.

PuerteMuerte

22.07.2023 07:04+11И это при том, что карта на меньшем технологическом процессе. Следовательно, она должна быть более энергоэффективной на ватт.

А потому, что уже - не "следовательно". Ранее смена техпроцесса предполагала уменьшение затвора транзистора, следовательно, уменьшение его ёмкости, следовательно, меньший ток потребления при переключении. Сейчас затвор уменьшать уже некуда. Смена техпроцесса позволяет по-прежнему упаковать больше транзисторов на единицу площади, но сами они меньше не становятся, просто меняют геометрию. И жрут почти столько же.

SergiiDia Автор

22.07.2023 07:04Огромное спасибо за замечание, честно говоря, как пользователь — упустил момент перехода. Я пока слышал только о проблеме создания большого кристалла, но это не совсем относится к теме.

Простите, за некомпетентность, но позвольте уточнить — ожидать в ближайшие годы уменьшение затвора (даже непропорциональное техпроцессу) нам пока не стоит?

PuerteMuerte

22.07.2023 07:04Простите, за некомпетентность, но позвольте уточнить — ожидать в ближайшие годы уменьшение затвора (даже непропорциональное техпроцессу) нам пока не стоит?

Какие-то мелкие улучшения в краткосрочной перспективе, но не радикальные, и совсем не пропорциональные.

saege5b

22.07.2023 07:04+1Некуда уменьшать.

Уже упёрлись в то, что при "ещё поменьше чуть-чуть" изолятор становится плохим проводником, а проводник - плохим изолятором, и в итоге уже нет разницы где изолятор а где проводник.

Использовать что-то другое - не хватает фундаментальных исследований, а метод научного тыка - очень долгий и в таких масштабах - очень дорогой. Плюсом прилетает тот факт, что необходимо менять всю технологическую цепочку, а это вообще космические деньги.

Т.е. для маркетинга есть запас в виде повсеместного перехода на объёмные транзисторы, гафниевые (условно) разделительные слои, сжатый/растянутый кремний, объёмные проводники; но технологически мы вышли на полку.

edo1h

22.07.2023 07:04насколько я знаю, энергоэффективность таки растёт. просто не такими темпами как раньше.

иначе какой вообще резон вкладывать миллионы (или там миллиарды?) в разработку новых ТП

vtal007

22.07.2023 07:04+1первая карта за последние 3 поколения, которая при увеличении мощности уменьшила энергопотребление, увеличила частоты и снизила теплопакет.

Ну так себе достижение. Уж не знаю про частоты, поменял RXX 5700 на Rx6600 - та же производительность, но холоднее

а зеленая 4060 это кака

нам уже хватает видеокарт с головой

эти Вы с Вами сейчас в одной комнате? или Вы за пределами фуллхд других разрешений не видели? а всякий киберспорт где и 240 гц радуются

SergiiDia Автор

22.07.2023 07:04Смотрите, вы безусловно правы, когда говорите о киберспорте, 240 герцах, разрешениях свыше 1080p, но для всех этих решений, если я не ошибаюсь всегда брались старшие карты в линейках. и со стороны красных, и со стороны зеленых

Безусловно, вы можете парировать, что "лишь бы запускалось" не обязательно брать 40-ую серию. Но ИМХО, сочетание гиммика в виде Dlss 3.0 (FSR 3 ещё не пощупал), и пониженного энергопотребления, чуть-чуть делают нашу жизнь приятней. Особенно когда хочется играть в игры, а не смотреть в циферки.

vtal007

22.07.2023 07:04+1Тут можно сказать, что "всегда" был прирост с поколением у карт одной линейки = 1060-2060-3060 и тут внезапно 4060, которая местами (в том числе из-за объема памяти) чуть ли не 3060 проигрывает. а прирост относительно 3060 очень маленький. А вот прирост в цене - ощутимый

Хотя по идее рост технологий должен удешевлять ту же самую производительность

Что касается Dlss 3.0 , это ж которая генерация кадров? то есть рисовать будет 100фпс, а управление будет вялым, как на 30фпс.

для фуллхд длсс не должно требоваться.

По поводу фуллхд или выше. Мониторы 2к сейчас стали достаточно доступными, 27 дюймовые и 2к порядка 15к (ну до скачка доллара, не знаю как сейчас обстоят дела), то есть не слишком дороже то фуллхд и 24 дюйма. И статистика стима говорит о том, что растет кол-во 2к -мониторы у населения

И вот если 4060 давала бы 30% прирост, она спокойно и в 2к работала бы.

с другой стороны, Куртке плевать на потребительский рынок, у него новый рынок - тренировка ИИ, а на потребительском особо конкуренции нет. Племяха Лиза занимает 15% рынка и кажется скорее создает видимость конкуренции, чем конкурирует

V1RuS

22.07.2023 07:04-3Мониторы 2к сейчас стали достаточно доступными

Да сколько можно. 2560*1440 — это 2.5К, ну в крайнем случае 1440p, а не 2К. 2К — это 2048 или 1920 пикселей по горизонтали. Не повторяйте за безграмотными маркетологами.

PuerteMuerte

22.07.2023 07:04+6Не повторяйте за безграмотными маркетологами.

Минуточку, но вещи называются так, как их назвали маркетологи, а не так, как у них математика складывается. Называйте экран шириной 1920 пикселей FullHD, 2560 пикселей 2K, 3840 пикселей 4К, и вас поймут все, а не только кучка энтузиастов, которым не лень сидеть и переживать, какому множителю ближе соответствует 2560.

vtal007

22.07.2023 07:04так это народное название, а не академическое, 2560*1440 официально называется QHD (квад хд), но запоминать эти 3 буквы бессмысленно, ибо хд-мониторов уже наверно нет в природе. А для упрощения 1к - фуллхд, 2к- 2560*1440, 4к это понятно. А еще у маков есть 5к. Говорят вот на 5к пикселей действительно не видно

edo1h

22.07.2023 07:04+1Говорят вот на 5к пикселей действительно не видно

так это не от 4к/5к зависит, а от ppi.

на ноутбуке с 4к точно пикселей не видно.

GennPen

22.07.2023 07:04+1Вы по кол-ву пикселей считайте, тогда все встанет на свои места.

1920х1080 ~ 2.1млн.пкс.

2560х1440 ~ 3.7млн.пкс.

3840х2160 ~ 8.3млн.пкс.

metric_ghost

22.07.2023 07:04+5Собрался сменить 1660с, посмотрел на то, что нвидия выпустила в 4060ти и ниже, да и купил первый за десять лет радеон - 7600. Очень доволен. На мой диванный взгляд, нормальные вк в этом поколении у нви начинаются от 4070, но цена меня не устраивает, всегда покупал середнячки. Одно печалит, не успел ухватить асрок стил легенд за 28 на пике дешевизны, пришлось покупать фантом гейминг немного дороже. Пересидеть пару поколений хватит, а там видно будет.

ULP

22.07.2023 07:04+2я взял себе попробовать 3060 вместо 1080ti с год назад. оказалось что 3060 медленнее 5 летней 1080ti, киберпанк не поехал. пришлось найти 3090, тут все встало на место.

мне видится надо брать карту из топовой линейки что бы потом лет 5 к вопросу не возвращаться

inkvizitor68sl

22.07.2023 07:04Странно, я на ноутбучной 3060 (правда, с полноценным TDP в 115) прошёл киберпуньк в fullhd на ultra/high настройках вперемешку

ULP

22.07.2023 07:04я так и так пробовал, не заметил разницы в 4К - ну может чуть быстрее было.

inkvizitor68sl

22.07.2023 07:04+2А, ну в 4K на 3060 никто и не обещал игры -)

По всем тестам она после fullhd приседает

edogs

22.07.2023 07:04В ноутбуках энергопотребление и, немаловажно, пониженный минимальный лимит по tgp, тоже привел к огромному позитиву. Несмотря на урезанную шину в ноутбучных 4060/4070, они практически паритетны 3060/3070, при энергопотреблении в 1.5-2 раза меньше. А с появлением ноутбучных 4080/4090 так и смысл десктопных карт подупал, он десктопа они конечно отстают, но мощности уже вполне достаточно, да и цена... десктопный комп с 4070 встанет в те же деньги что ноут с 4080, при примерно равных характеристиках.

logran

22.07.2023 07:04Видимо ноуты очень сильно в цене упали. 2.5 года назад ноут с i9 + 2080S + 64Гб RAM стоил почти что вдвое дороже чем аналогичный ПК (в РБ в местных магазинах по безналу).

edogs

22.07.2023 07:04Да не, не упали. Если не говорить о раритетах или свежих моделях, то десктопный компьютер аналогичный ноуту уже лет 10 (а то и 15) не взять заметно дешевле.

Просто обычно считая цену десктопов забывают про монитор, клаву, вай-фай плату, бесперебойник... а то и корпус с блоком питания (ведь остался от предыдущего же, ага) и т.д., плюс сравнивают брендовый ноут с ноунеймным самосбором.

Другой вопрос, что поскольку ноуты по мощности от топовых десктопов отстают очень сильно, то задача купить ноут аналогичный крутому десктопному компьютеру просто нерешаема вне зависимости от цены.

Или, другой вариант, когда собственно покупка "десктопа" сводится к его апгрейду (переферия есть, бесперебойник есть, монитор есть, диск тоже есть).

edo1h

22.07.2023 07:04Просто обычно считая цену десктопов забывают про монитор,

ну давайте посчитаем, сколько там, 15"? такой монитор только у перекупщиков б/у найти, рублей за 500.

а чтобы работать нужно и к ноутбуку покупать полноценный (а некоторые и не один покупают).клаву,

аналогично. приличная клава разве что на топовых thinkpad'ах

вай-фай плату

если что-то можно подключить проводом — надо подключать проводом. dixi

ну а так wifi-адаптер стоит копейки.плюс сравнивают брендовый ноут с ноунеймным самосбором

не совсем так. обычно сравнивают со самосбором из приличных комплектующих.

в случае ноута такой опции просто нет.

edogs

22.07.2023 07:04давайте посчитаем

Так мы-то как раз считали, каждый раз при апгрейде, много лет уже. При подсчете всех нюансов без упущений - получалось что десктоп аналогичный устраивающему нас ноуту - стоит если и дешевле, то ненамного.

давайте посчитаем у перекупщиков б/у найти, рублей за 500.

Частый подход, с таким подходом шансы на победу у десктопа сильно повышаются.

не совсем так. обычно сравнивают со самосбором

Угу, сравнение по цене с набором комплектующих, а не готовым компьютером, безусловно более выигрышно.

если что-то можно подключить проводом — надо подключать проводом. dixi

Тоже метод, любую запчасть не входящую в десктоп по умолчанию объявить ненужной, хорошо влияет на понижение цены десктопа.

чтобы работать нужно и к ноутбуку покупать полноценный

Не обязательно. Мало того, если забыть о размере, то у нас все дисплеи на ноутбуках по характеристикам лучше чем монитор. А для ноутбука как монитор вообще предпочитаем телевизор, потому что помним о размере.

приличная клава разве что на топовых thinkpad'ах

Субъективно. Как по нам - приличные клавы только на ноутбуках и можно встретить.

PuerteMuerte

22.07.2023 07:04+1получалось что десктоп аналогичный устраивающему нас ноуту - стоит если и дешевле, то ненамного

Ну как, процентов на 20-30 дешевле на старте, плюс, надо учитывать бОльший срок службы. У устраивающего вас ноута, когда перестанет устраивать видеокарта, вы ничего с этим не сделаете. У десктопа - просто поменяете отдельно видяху. С памятью сейчас аналогично, многие ноуты не апгрейдабельны, у десктопа такой проблемы нет, стало не хватать - просто докупили. То же самое и с другими компонентами.

edogs

22.07.2023 07:04Ну как, процентов на 20-30 дешевле на старте

Даже если дешевле, то никак не на 20-30%. Если реально интересно, напишите в личку, кинем Вам два последних ноута которые мы купили в этом году и Вы попробуете показать десктоп который не хуже ни в чем и его цену. Еще раз - ключевое - не хуже ноутбука ни в чем, а не "круче в чем-то, а в том что не круче это просто не нужно".

У устраивающего вас ноута, когда перестанет устраивать видеокарта, вы ничего с этим не сделаете. У десктопа - просто поменяете отдельно видяху. С памятью сейчас аналогично, многие ноуты не апгрейдабельны, у десктопа такой проблемы нет, стало не хватать - просто докупили. То же самое и с другими компонентами.

Проц давно уже почти никто не меняет отдельно, обычно меняют вместе с матерью.

Память, диски, вайфай модуль - меняются в нормальном ноутбуке без проблем.

С видеокартой дважды дискуссионно. С одной стороны, к ноуту можно подключить видяху по ТБ, с другой стороны, современная хорошая видяха вполне возможно: не влезет в старый корпус, потребует замены матери что бы были скоростные порты и достаточно места для установки по слотам, и ей не хватит мощности БП.

edo1h

22.07.2023 07:04Если реально интересно, напишите в личку, кинем Вам два последних ноута которые мы купили в этом году и Вы попробуете показать десктоп который не хуже ни в чем и его цену

это же читерство с вашей стороны ;)

очевидно, что ноутбук лучше стационарного компьютера по параметрам «вес», «время автономной работы», «толщина» и т.п.

и очевидно, что для покупателей стационарных компьютеров эти параметры имеют околонулевую ценность, иначе бы они выбрали ноутбук.давайте наоборот, я напишу что я хочу собрать, а вы мне покажете такой ноут )))

- 64 гига ecc памяти с расширением до 128 гигов;

- наличие минимум 2 pcie-слотов (не занятых видеокартой), в которые можно, например, поставить адаптеры для u.2 накопителей;

- 3 (минимум 2) выхода 4к 120Гц;

- возможность подключить 3 (минимум 2) 2.5" sata-накопителя;

- пассивная работа под стандартной нагрузкой (браузер и т.п.).

Проц давно уже почти никто не меняет отдельно, обычно меняют вместе с матерью.

в лагере intel да, процессоры редко меняют отдельно, ибо сокеты слишком часто меняются. а вот на amd замена процессора вполне обыденна

Память, диски, вайфай модуль — меняются в нормальном ноутбуке без проблем.

гхм, а что, вендор-лок на вайфай уже отменили? )

С одной стороны, к ноуту можно подключить видяху по ТБ, с другой стороны, современная хорошая видяха вполне возможно: не влезет в старый корпус, потребует замены матери что бы были скоростные порты и достаточно места для установки по слотам, и ей не хватит мощности БП.

ну вот мне буквально в этом году потребовалось подключить к старому компьютеру 2x 4к монитора, купил 6500 xt и отлично подключил.

ни с одной из описываемых проблем не столкнулся.

edogs

22.07.2023 07:04это же читерство с вашей стороны ;)

Это не читерство, это изначальная постановка задачи нами, с которой и началось обсуждение, процитируем: " десктопный компьютер аналогичный ноуту уже лет 10 (а то и 15) не взять заметно дешевле."©

И тут нам стали доказывать, что на самом деле это не так, т.к. "монитор можно взять на помойке за 500р, десктоп собрать, вайфай не нужен, клаву все равно надо покупать т.к. на ноутбуках они г-но" и так далее:)очевидно, что ноутбук лучше стационарного компьютера по параметрам «вес», «время автономной работы», «толщина» и т.п.

Про вес и толщину речь не шла. По времени автономной работы - особых претензий нет, но бесперебойник для хотя бы завершения работы в цену десктопа включать надо, т.к. "надежность данных" это один из важных параметров.

гхм, а что, вендор-лок на вайфай уже отменили? )

Последний раз с этим сталкивались в 2011, понадобилось, о ужас, пискать intel-овский модуль, а не realtek. С тех пор меняем без проблем.

давайте наоборот, я напишу что я хочу собрать, а вы мне покажете такой ноут )))

Вы видимо дискуссию не с начала читали, т.к. мы в самом начале написали " поскольку ноуты по мощности от топовых десктопов отстают очень сильно, то задача купить ноут аналогичный крутому десктопному компьютеру просто нерешаема вне зависимости от цены. "© Так что сложность и/или невозможность такой задачи мы и не отрицали.

Но отвечая на Ваш вопрос по требованиям:

1) ecc это уже сервер, а не десктоп, поэтому мимо. 128гб есть, например, в msi titan-ах. clevo (eurocom) упомянуть тоже стоит, хотя это уже не ноутбук, это скорее десктоп с аккумулятором, если учитывать старшие модели.

5) будет у всех нормальных ноутбуков. У нас сейчас на 8250u ноут для разъездов и посиделок в инете. Однако полностью пассивен при работе в ИДЕ, браузерах, просмотре видео и так далее, несмотря на дохловатый и старый проц.

2,3,4) Смотрите ноуты на интеле с tb4/dp, hdmi. Насколько это будет производительно работать и сколько денег выложите за перефирию - вопрос отдельный, но само по себе это все возможно.6500 xt ни с одной из описываемых проблем не столкнулся.

4гигабайтная хилая карта от амд. В каком месте это "мощная современная видеокарта"?:) 4080 туда воткните, тогда обсудим, обсудим зачем Вы в том дряхлом году купили настолько большой корпус, мощный БП и каким образом старая мать поддерживает нужное количество линий pci-e для реализации ее производительности.

edo1h

22.07.2023 07:04И тут нам стали доказывать, что на самом деле это не так, т.к. "монитор можно взять на помойке за 500р,

настолько же непригодный для серьёзной работы? да, можно.

диагональ монитора — один из ключевых параметров.вайфай не нужен

вы так и не написали зачем нужен вайфай на стационарном компьютере

1) ecc это уже сервер, а не десктоп

нет, речь именно про десктоп.

с уходом hdd память становится, пожалуй, самым часто выходящим из строя компонентном.

я хочу чтобы система говорила мне «вот на этой планке что-то ошибки, они скорректированы, но неплохо бы поменять».

и да, повторюсь, все современные десктопные процессоры amd поддерживают ecc-память, и это правильно.2,3,4) Смотрите ноуты на интеле с tb4/dp, hdmi. Насколько это будет производительно работать и сколько денег выложите за перефирию — вопрос отдельный, но само по себе это все возможно.

и всё это будет выглядеть как клубок проводов вокруг ноутбука? нет, спасибо, не надо.

4080 туда воткните, тогда обсудим, обсудим зачем Вы в том дряхлом году купили настолько большой корпус,

гхм, а что, бывают корпуса (не считая всяких barebone), куда 4080 не полезет?

погуглил стандарт, full-length карта длиной 312мм, про 4080 гугл говорит, что 310мм. 2мм недоложили? ))))

PuerteMuerte

22.07.2023 07:04+1да, вайфай на стационарном компьютере не нужен

Бывает и нужен, в зависимости от того, в каких условиях вы живёте, но тоже штука специфическая. В общем случае, если у вас физически есть возможность протянуть шнурок от роутера к компьютеру, нет никаких мотивов этого не делать, кроме "я просто ещё не пробовал, и не в курсе, насколько это надёжнее и быстрее вайфая"

edogs

22.07.2023 07:04настолько же непригодный для серьёзной работы?

Монитор у ноутбука непригоден для серьезной работы, клавиатура непригодна, вайфай непригоден. Отличное решение задачи "как умудриться насчитать цену десктопа заметно ниже ноутбука", безусловно, забраковать все компоненты ноутбука как непригодные и/или ненужные, то десктоп выйдет дешевле. Правда это к поставленной задаче уже отношения не имеет, но кого такие мелочи волнуют?:)

и всё это будет выглядеть как клубок проводов вокруг ноутбука? нет, спасибо, не надо.

А фуллтауэр с 3 мониторами под эти нужды существенно компактнее будет, да?

а что, бывают корпуса (не считая всяких barebone), куда 4080 не полезет? погуглил стандарт, full-length карта длиной 312мм, про 4080 гугл говорит, что 310мм. 2мм недоложили? ))))

310 это референс, обычно длиннее. Но проблема не столько в длине, сколько в толщине (3-5 слотов), тяжести (в корпусе еще закрепить ее надо как-то), питании (которое надо не только найти, но и подвести) и месте (что бы кулеры видяхи ни во что не упирались - ни в отсеки для дисков спереди, ни в кулер проца).

Под 3ххх-4ххх серию многие корпуса меняли.

edo1h

22.07.2023 07:04Монитор у ноутбука непригоден для серьезной работы, клавиатура непригодна, вайфай непригоден

Ну да, примерно так. В разной степени (экран совсем плохо, с клавиатурой вы меня убедили, что это вкусовщина, wifi приемлемо для многих задач, не лучше провода, конечно, но часто и не сказать, что хуже)

Правда это к поставленной задаче уже отношения не имеет, но кого такие мелочи волнуют?

Ну если задача — подсуживать ноутбукам, то да, вы правы )

Вы поймите, все тут имеют опыт работы за ноутбуками, и переубедить других, что за ноутбуком без нормального монитора, клавиатуры и прочего удобно работать, вам будет проблематично.

edogs

22.07.2023 07:04Ну да, примерно так.

Примерно так только если хочется натянуть сову на глобус, начав решать задачу "собрать десктоп не хуже ноутбука" с того, что начать вносить изменения в ноутбук, потому что "там клава не такая какая вам нравится".

Вы поймите, все тут имеют опыт работы за ноутбуками, и переубедить других, что за ноутбуком без нормального монитора, клавиатуры и прочего удобно работать, вам будет проблематично.

Вы поймите, тут все дружат с логикой и когда Вы начинаете решать задачу с изменения ее условий (вай фай не нужен) и передергиваний (ноут считаем новый и брендовый, а десктоп ноунейм сборки из бу), то Ваше мнение по поводу возможности для десктопа оказаться ощутимо дешевле ноута становится вполне очевидным и без подсчетов.

Ну если задача — подсуживать ноутбукам, то да, вы правы

Вы сказали что ноутбуку нужна отдельная клава, т.к. ноутбучная клава г-но. Мы нигде не говорили, что для десктопа нужно купить ноутбучную клавиатуру, т.к. десктопная клава г-но.

Вы заявили что размер экрана это единственное что имеет значение и для десктопа можно и бу взять, хотя достаточно очевидно, что не только размер имеет значение и сравнивать бу и новое по цене некорректно. Мы в свою очередь никаких претензий к характеристикам монитора у десктопа не предъявляли.

Вы вдруг заявили что вайфай (который в десктопе стоит денег) необязателен, потому что он есть в ноутбуке. А мы не пытались удешевить ноутбук посчитав цену продажи вайфай модуля из него.

Так что пока подсуживаете только Вы.

PuerteMuerte

22.07.2023 07:04Вы поймите, тут все дружат с логикой

Логика предполагает, что когда вы сравниваете устройства разного класса для одного и того же применения, вы должны не бездумно натягивать их характеристики на глобус, вроде "ноут весит 1.1. кг - 10 баллов, десктоп весит 7 кг - 2 балла", а учитывать их особенности применения. Ноут без вайфая, это нонсенс. При этом я даже не приводил в пример себя, человека, который пользуется ноутом стационарно, и который подключил его шнурком к сети, я понимаю, что мой кейс не самый популярный. А вот десктоп без вайфая, это так же обычно, как ноут с вайфаем. Поэтому абсолютно корректно сравнивать обычную конфигурацию ноута с обычной конфигурацией десктопа, а не обычный ноут и нечто редкое.

PuerteMuerte

22.07.2023 07:04Даже если дешевле, то никак не на 20-30%. Если реально интересно, напишите в личку, кинем Вам два последних ноута которые мы купили в этом году

Зачем в личку? Это же не секретная информация, давайте сюда.

Еще раз - ключевое - не хуже ноутбука ни в чем

По процессору, памяти, дискам, видео. Размеры, мобильность и т.д., это к вопросу отношения не имеет, т.к. это характеристики всего класса устройства, и если вам нужно именно мобильное устройство, выбор "десктоп" или "ноут" вообще не стоит, вы выбираете ноут. Т.е. сам по себе выбор десктопа или ноута означает, что ваш компьютер будет стоять на столе/под столом, и вам мобильность не нужна.

Проц давно уже почти никто не меняет отдельно, обычно меняют вместе с матерью. Память, диски, вайфай модуль - меняются в нормальном ноутбуке без проблем.

Неправда. Купить i3 и поменять на i7 - обычное дело. Память и диски во многих ноутах не меняются, и очень вероятно, что вашего бюджета хватит только на них, т.к. большинство продаж идут как раз в low-end сегменте. А вайфай-модули в ноутах вообще не меняются, точнее, меняются, но на несколько аналогичных моделей от одного-двух производителей.

С одной стороны, к ноуту можно подключить видяху по ТБ

Да, за удвоенную стоимость, если речь идёт о самых популярных моделях. И с потерей производительности.

Что касается десктопа, то у обычных видеокарт массового сегмента нет никаких особых потребностей ни в БП, ни в размерах корпуса. А если вы покупаете убер-монстра, ну, в ноутах для него вообще нет технической возможности подключения, ни по питанию, ни по скорости интерфейса. Кстати, о питании, самые хилые блоки питания РС предлагают в два раза больше мощности, чем самые мощные блоки питания ноутов. Что соответствует почти в два раза более высокой производительности на платформах одного поколения.

edogs

22.07.2023 07:04Зачем в личку? Это же не секретная информация, давайте сюда.

И так уже оффтопим по полной, если интересно выяснить вопрос - можно и в личке, если интересно играть на публику раздувая топик - нам не интересно. Результаты обсуждения можно и выложить.

мобильность не нужна.

Естественно, мы это изначально говорили. Но вот бесперебойник извольте включить, хотя бы на 5 минут завершения работы, т.к. это уже надежность, а не мобильность.

Память и диски во многих ноутах не меняются и очень вероятно, что вашего бюджета хватит только на них

Эта надуманная мантра уже немного утомила. Раз 5 выше сказано, что во многих как раз меняются или хотя бы апгрейдятся. А даже если не меняются, то как раз обычно в дорогих моделях, в которых все принесено в жертву весу и тонкости (на вскидку: acer aspire, hp envy, dell inspirion, dell xps, asus vivibook pro, lenovo legion, lenovo legion 7, asus rog strix, hp expertbook). За последние 15 лет не купили ни одного ноута где они были бы "прибиты гвоздями" и не испытывали никаких проблем с выбором.

Неправда. Купить i3 и поменять на i7 - обычное дело

Это делают редко. Нормальный человек изначально покупает сбалансированный компьютер. А когда через 3-5 лет доходит дело до апгрейда, то выясняется что разумнее поменять все, т.к. диск подустал, сата интерфейсы стали свежие, появилсь быстрая память и т..д.. Честно говоря, из всех знакомых, за 30 лет почти никто не поменял процессор. CD драйв меняли, память добавляли, звуковую карту меняли, диски тоже, даже видяху пару раз меняли, но проц - почти никогда.

в два раза больше мощности, Что соответствует почти в два раза более высокой производительности

Это маркетологическая лапша. В зависимости от того, о чем мы говорим - двухкратная разница в поверлимите на одном процессоре/видеокарте в среднем приведет к 10-50% разнице в производительности в реальных задачах.

у обычных видеокарт массового сегмента нет никаких особых потребностей

И тем не менее эти потребности есть и огульно заявлять что любая новая видяха легко встанет в любой старый корпус - некорректно.

PuerteMuerte

22.07.2023 07:04И так уже оффтопим по полной, если интересно выяснить вопрос - можно и в личке, если интересно играть на публику раздувая топик

Обсуждать железо в комментариях к статье про железо - это вообще не оффтопик, потому я и удивляюсь, зачем нам ещё и в личке это продолжать, в два потока.

Но вот бесперебойник извольте включить, хотя бы на 5 минут завершения работы, т.к. это уже надежность, а не мобильность.

Я уже писал, это специализированный девайс. Как давно у вас были перебои с электричеством?

За последние 15 лет не купили ни одного ноута где они были бы "прибиты гвоздями"

Хе-хе. За последние 15 лет и я не особо жалуюсь. Вы за последние два-три года сколько ноутов купили?

Это маркетологическая лапша.

Простите, но это физика. Пусть зависимость и не линейная, особенно в предельных режимах, но тем не менее, один и тот же процессор с 60-ваттным охладом на максимальной нагрузке почти раза в два быстрее, чем с 30-ваттным. Да, при печати в ворде это не заметно, я и не спорю.

И тем не менее эти потребности есть и огульно заявлять что любая новая видяха легко встанет в любой старый корпус - некорректно.

Это утверждение вы сами сюда притянули и сами опровергли :)

Утверждение, что в 95% десктопов вы можете взять, и поставить этак 90% видях, присутствующих на рынке, вас устроит? В ноутах оба числа околонулевые, т.к. апгрейдабельность там есть только у дорогих штук вроде Dell Precision/Alienware, HP zBook/Omen, Clevo и т.д., апгрейдабельность сейчас только на "родные" MXM-карты, т.к. и охлад несовместимый, и формы самих карточек зачастую разные.

edogs

22.07.2023 07:04я и удивляюсь, зачем нам ещё и в личке это продолжать, в два потока.

Мы не предлагали еще и в личке это обсуждать. Если Вам важен предмет обсуждения - обсудим в личке, если Вам важно на публике поговорить - без нас пожалуйста.

Я уже писал, это специализированный девайс.

Тут специализированный девайс поэтому не надо, тут вайфай вместо которого лучше провода, тут монитор с помойки возьмем бушный, соберем все сами - окей, десктоп получится дешевле. Уровень аргументации за него тоже понятен.

Вы за последние два-три года сколько ноутов купили?

Около 80.

Простите, но это физика. Пусть зависимость и не линейная

Именно что не линейная. Совсем не линейная. Так что Ваше "в 2 раза повысили тдп в два раза выросла скорость" тихо отдыхает.

один и тот же процессор с 60-ваттным охладом на максимальной нагрузке почти раза в два быстрее, чем с 30-ваттным.

Вы бы посмотрели тесты что-ли хотя бы.

Утверждение, что в 95% десктопов вы можете взять, и поставить этак 90% видях, присутствующих на рынке, вас устроит?

Вы отлично понимаете, что апгрейд карты подразумевает покупку более мощной карты. А пример приводите как купить затычку для использования ее вместо внутреннее. Неинтересно.

PuerteMuerte

22.07.2023 07:04Мы не предлагали еще и в личке это обсуждать. Если Вам важен предмет обсуждения - обсудим в личке, если Вам важно на публике поговорить - без нас пожалуйста.

Простите, но о чём речь? Если об обсуждении - вы уже на перекидывание мяча тут потратили в несколько раз больше текста, чем потребуется на обсуждение этого вопроса. Или вы считаете, что просто написать "на публике" "я купил такую-то модель ноута за столько-то денег" - это какой-то интимный вопрос, который надо в привате обсуждать, а то вдруг другие увидят? Напишите мне в личку, если вы стесняетесь этой информации, ок. Я просто считаю это откровенно странным.

Тут специализированный девайс поэтому не надо, тут вайфай вместо которого лучше провода, тут

Эм. Вы не поверите, но да. Специализированный девайс, который не надо, а провода - несоизмеримо лучше вайфая по качеству связи. И нет никакого смысла использовать вайфай, если ваш компьютер не бегает с вами по помещению, а провода есть где протянуть.

Именно что не линейная. Совсем не линейная.

Совсем не линейная она в предельных режимах работы процессоров, там где разница между 150W и 250W даёт 10% производительности. А в ненапряжных - как раз куда ближе к линейной. Вы бы тесты посмотрели, что-ли хотя бы :)

Вы отлично понимаете, что апгрейд карты подразумевает покупку более мощной карты.

Более мощной - это в подавляющем большинствен случаев не 4090 за полтора килобакса. Это куда чаще замена 2060 на 3070.

edo1h

22.07.2023 07:04Угу, сравнение по цене с набором комплектующих, а не готовым компьютером, безусловно более выигрышно.

разумеется. и не только в цене, а и в гибкости (и при этом самостоятельная сборка фактически не имеет минусов, если вы уж не совсем гуманитарий).

хочется мне, чтобы компьютер не шелестел кулерами — у меня пассивное охлаждение. достигается в первую очередь размерами кулеров.

как мне этого достичь на ноуте?захотелось мне воткнуть накопитель на 2 или 4 ТБ — купил любой и и воткнул (вот прямо сейчас жду ответа на оффер на ebay на серверный диск sata за копейки).

в современных ноутах обычно только m.2 2280, выбор сразу резко сокращается.

и два слота — уже роскошь, а больше вообще не встречал.или я давно уже решил, что следующий компьютер будет с ecc памятью.

у amd все дескопные процессоры zen-4 умеют ecc, у intel тоже есть процессоры с поддержкой, но там куда хуже со списком поддерживающих материнских плат.

где мне купить ноутбук с ecc памятью?

более того, ноутбук просто с заменяемой памятью уже редкость, в лучшем случае сколько-то распаяно + 1 слот so-dimm.

(для кого вообще в 2023 году выпускаются ноутбуки с 8 гигабайтами без возможности расширения?!?)в этом году потребовался ноут на 2 недели, пошёл в магазин, толком и выбрать-то нечего, или стоит как крыло от боинга, или 8 гигов памяти распаяно и вообще нет слота sodimm.

купил в итоге msi на позапрошлом (11-ом) поколении intel с двумя слотами, добил до 64 гигов (просто потому, что могу, так-то мне на ноутбуке и 32 достаточно, но разница в цене оказалась смешной)… ну такое…

экран и правда неплохой, кстати, глаза не устают. но крошечный же.

вентиляторы настроил чтобы в простое не крутились, но всё равно, чуть нагрузка — прощай бесшумность.

fn в очередном рандомном месте, и стрелки слеплены с остальными кнопками, так что вслепую промахиваешься чуть ли не в 50% случаев. это к вопросу о самых лучших клавиатурах на ноутбуках.

и эта модель же не одна такая, говорю, кроме топовых thinkpad'ов вообще по клавиатуре ничего не понравилось (но столько платить ради пары недель мне жалко было).Тоже метод, любую запчасть не входящую в десктоп по умолчанию объявить ненужной, хорошо влияет на понижение цены десктопа.

в эту игру можно играть в обе стороны. мне на стационарном рабочем месте ethernet куда нужнее, где он в современных ноутбуках? )))

материнских плат с wifi, кстати, сегодня полно. когда присматривал себе варианты, где-то у половины ненужный мне wifi шёл «в нагрузку».

Мало того, если забыть о размере, то у нас все дисплеи на ноутбуках по характеристикам лучше чем монитор

серьёзно? если забыть о размере?

А для ноутбука как монитор вообще предпочитаем телевизор, потому что помним о размере.

так мне ещё к ноутбуку телевизор покупать? )))

и да, начитался хвалебных отзывов, собрался было купить для работы 42" lg oled… сходил в магазин, покрутился, нет. и ppi маловат, и wrgb убивает субпиксельное сглаживание (что усугубляет предыдущую проблему), и дикий глянец. другие телевизоры заодно посмотрел — для работы не радуют.

купил в итоге 32" 4к монитор, понравился, потом купил второй такой же.Частый подход, с таким подходом шансы на победу у десктопа сильно повышаются.

а что не так с подходом? понятное дело в дороге, там любому экрану рад, но дома за рабочим столом я за ноутбучные 12-15" и 500р не готов отдать.

резюмируя: при моём профиле использования, ноутбук только место на столе занимает (его под стол как системный блок не закинешь) и гудит.

и это я ещё не играю.

edogs

22.07.2023 07:04хочется мне, чтобы компьютер не шелестел кулерами — у меня пассивное охлаждение. достигается в первую очередь размерами кулеров. как мне этого достичь на ноуте?

Сейчас пишем коммент и ноутбук работает в пассивном режиме, кулерами не шелестит. Как мы этого достигли? Купили ноутбук.

кроме топовых thinkpad'ов вообще по клавиатуре ничего не понравилось

Именно что "не понравилось", т.е. субъективно. Поэтому нет смысла обсуждать, Вам нравится одно, нам другое, кому-то третье. Мы себе вообще клавиатуру отдельную найти уже давно не можем нравящуюся, периодически мелькают мысли взять ноутбучную и как-то в корпус ее воткнуть. Последнее приобретение a4 fbx50c .

материнских плат с wifi, кстати, сегодня полно

Полно, но они дороже, поэтому когда топят за десктопы, при подсчете цены обычно говорят нечто вроде "вайфай не нужен" и берут без него (ну вот как выше было сказано). Кстати, учитывая металлический корпус и отсутствие внешней антенны - есть серьезные сомнения можно ли учитывать такой вариант как полноценный.

серьёзно? если забыть о размере?

Нам предложили забыть о характеристиках (взяв говномонитор с помойки за 500р), мы предложили забыть о размере:) Мы, кстати, начинали работать за мониторами еще в 90-тых, 15" с 800х600 считалось шикарно, поэтому современный 18" ноут с 2560х1600 у нас презрения за "маленькость" не вызывает.

да, начитался хвалебных отзывов, собрался было купить для работы 42" lg oled… сходил в магазин, покрутился, нет. и ppi маловат, и wrgb убивает субпиксельное сглаживание (что усугубляет предыдущую проблему), и дикий глянец.

Ктож виноват что Вы выбрали неудачную модель. Если встанет еще раз вопрос, смотрите обзоры сначала https://www.rtings.com/tv/reviews/best/by-usage/pc-monitor

а что не так с подходом?

Что не так с подходом "сравнивам брендовый новый и собранный из найденных на распродаже бу запчастей и смотрим что дешевле"? Вы серьезно?

резюмируя: при моём профиле использования, ноутбук только место на столе занимает (его под стол как системный блок не закинешь) и гудит.

У всех свои задачи. Мы говорили конкретно про задачу "считаем десктоп на замену ноутбуку". Ноутбук у нас при обычной работе не гудит, под столом занимает места меньше чем системник.

PuerteMuerte

22.07.2023 07:04+2Просто обычно считая цену десктопов забывают про монитор, клаву, вай-фай плату, бесперебойник... а то и корпус с блоком питания (ведь остался от предыдущего же, ага) и т.д., плюс сравнивают брендовый ноут с ноунеймным самосбором.

Это и есть справедливое сравнение в целом. Ноуты, когда старого перестало хватать, меняют целиком, десктоп - апгрейдят. При этом и монитор, и клава, и корпус с блоком питания остаются старые. И покупая десктоп, ты обычно покупаешь брендовые комплектующие, а не брендовый ящик, это как раз и есть "мейнстримовая" альтернатива. Бесперебойник... ну, это сильно частный случай. Кому-то он может быть нужен, кому-то нет. Я не помню, чтобы мне эта штука была нужна когда-то после 90-х годов.

JPEGEC

22.07.2023 07:04+1Давайте признаемся, что без лучей нам уже хватает видеокарт с головой. А

с всякими DLSS и FSR комфортно играть можно хоть на 1070 или даже на

1060. Поэтому что мощность 30-ой серии была избыточна, что мощность

40-ой.Нет не признаемся. Мощности и количества памяти даже у 3090 совершенно недостаточно для обычного Stable Diffusion.

xsevenbeta

22.07.2023 07:044090 в VR даёт в среднем ~80, при неплохом таком разрешении на глаз. Излишков мощностей точно пока не наблюдается.

SergiiDia Автор

22.07.2023 07:04+1Ну, здесь позвольте с вами не согласиться. Видеокарта как устройство изначально не проектировалась под глубокое обучение нейросетей. а значит это не её основная задача. Возможно с появлением специализированных решений (что конечно маловероятно, но в моем мире с радугой и розовыми пони, желаемо) вопрос обучения значительно упроститися/ускорится...

logran

22.07.2023 07:04Если уж подходить к вопросу чисто вывода картинки — 3090/4090 тривиально нагружается на полную в любых задачах, требующих большого объема видеопамяти и достаточной степени мощности будь то 4k 200+Hz с текстурами высокоро разрешения или набирающий популярность VR с всё возрастающим разрешением на глаз. А в VR хочется кроме этого еще и картинку уровня монитора (а то и выше) со всеми модными эффектами (включая RTX), и в идеале бы дальность прорисовки (БЕЗ ЛЕСЕНОК!) по-более чем на мониторе, иначе погружение ломается.

А для FullHD в 60-90Hz без лучей и прочих радостей на мониторе конечно и древней 1080 за глаза...

SergiiDia Автор

22.07.2023 07:04+1полностью с вами соглашусь, "но" 1080 поедает 180 ватт, а rtx 4060 только 115. Я старался отразить что у нас последние 3 поколения, карты становились все больше, прожорливей и горячей, и это не совсем нормально. При том, что до этого несколько поколений тенденция была обратной.

metric_ghost

22.07.2023 07:04Так надо сравнивать сравнимое, 1060 с 4060, а не с 1080. Чего ж тогда 1030 не сравнить по потреблению?

SergiiDia Автор

22.07.2023 07:04+1Ну здесь я вас расстрою, 1060 (120ватт) поедает больше, чем 4060 (115 ватт)... И если вы внимательно прочитаете статью, там как раз есть сравнительные характеристики, и весь этот парадокс, который и стал идеей для статьи

Уважаемый Logran написал, что 90 герц можно поиграть и на 1080. Но для 1080 нужен более мощный блок питания.

Я понимаю его точку зрения, что человек стремиться к наилучшей производительности, и конечно в этом случае смотреть на базовую 4060, не самый оптимальный вариант.

В своей статье я не пытаюсь доказать, что 4060 это самая лучшая карта. я не говорю о 4060 Ti, все что я указываю, что это первая карта с 2016-го года, у которой потребление стало меньше чем у предшественника, и это хороший знак.

metric_ghost

22.07.2023 07:04Так нужно учесть прогресс в техпроцессе. Только вот 1060 - 12 нм, а 4060 - 4 нм, вижу повод для расстройства скорее в плане ухудшения тепловых характеристик, тп улучшен втрое, а потребление упало меньше 5%. Говорю же, сравнимое надо сравнивать, а не подтягивать факты под доводы.

SergiiDia Автор

22.07.2023 07:04+2Да, но у 3060, 170 ватт при 8 нанометровом техпроцессе.

поэтому я и радуюсь, ибо 4060 это просто прорыв по сравнению с предыдущими видеокартами. этому и посвящена вся статья, я ни в коем случае никого не принуждаю покупать 4060, и уж тем более не Ti версию. Вся статья посвящена исключительно энергопотреблению карт.

Если вы внимательно взглянете в комментарии, уважаемый Puerte Muerte описал парадокс с техпроцессом, тем что размер затвора транзистора не изменяется, а только его геометрия.

metric_ghost

22.07.2023 07:04+1Тем не менее потребление транзисторов на новых тп уменьшается. Не вижу ничего парадоксального.

JPEGEC

22.07.2023 07:04Компьютер как устройство тоже изначально не проектировался под интернет и игры. Но сложилось так как сложилось.

И раз уж поднялся вопрос нейросетей, не нужно даже про обучение (которое занимает недели), рассмотрим, к примеру, обычное использование готовых обученных моделей. Выставьте в той же Stable Diffusion размер изображения 4К и убедитесь что 24М памяти (а это как бы не максимум для всей линейки) тупо не хватает для генерации картинки. Обладатели карт с памятью 6М и 12М просто вздыхают.

Нет у видеокарт излишков мощности, и не будет видимо никогда. Просто у вас лично не те задачи.

aik

22.07.2023 07:04+3Вот если бы у 4060 было пассивное охлаждение (как на 1050 в своё время), то я бы даже перешел на неё с 3070. А так — плюс-минус 50 ватт в теории приятно, но вот в реальной жизни это заметно только в каких-то единичных случаях.

Толковый БП не так уж дорог, чтобы на нём можно было много сэкономить, взяв дешевый хлам.

В 2Д-режиме все видеокарты едят примерно одинаково, а в игры обычно играют не круглосуточно, так что заметной экономии электричества тоже не будет.Так что, хоть теоретически снижение энергопотребления — это хорошо, с практической точки зрения пользы от него не особо много. Мне больше нравится, что AMD со встроенной графикой делает сейчас.

Roland21

22.07.2023 07:04-1Экономия на БП на 2000р (сомнительная кстати) ради того, чтобы купить урезанную, но новую видюху? Но зачем?

Жирные БП нужны для действительно мощных флагманских карт, что зеленых что красных - причем даже не столько именно ватты, сколько стабильность и сила тока.

На личном примере 6700xt не потребляет больше 150вт и занимает чуть больше 2 слотов.

Раздражает ТДП флагманов в виде 3х и более слотовой толщины :)

Dr9vik

22.07.2023 07:04+5цена этой карточки 200 уё

я свою 580 радик покупал за 200

теперь вопрос, а что я за 200 вечно зеленых могу купить теперь? а ничего

иди докладывай и ты в лучше случае за 300 купишь видик который будет на 50% быстрее

классно правда? и это через 3-4 года покупки своего радика....ПРОГРЕСС!!!1

ATHMOSPHEROS

22.07.2023 07:04Как же хорошо, что я больше не игранутый!!! И мне не нужно теперь тратить кучу

лишнегобабла на всякие там микрухи-переростки. А бабки всегда есть куда потратить, идей куча!!!

logran

22.07.2023 07:04+2Мне карточка расчеты считает да картинки рисует. Вот только для этого на неё к сожалению бабла отваливать приходится еще больше чем для игрушек...

nidalee

22.07.2023 07:04+7Ни в коем случае не берите 4060!

За эти же деньги лучше возьмите либо карту постарше из прошлого поколения, либо AMD.

Все карты из 4ХХХ поколения, кроме 4090 — провал и попытка маркетологов в последний (надеюсь) раз втюхать не понимающим ничего покупателям меньше видеопамяти, чем есть в консолях текущего поколения (со всеми вытекающими). ВСЕ карты с обьемом видеопамяти ниже 12 гигабайт — мертворожденные, что доказывают такие игры как Hogwarts Legacy и TLOU, лагающие на 8 гигах даже в 1080Р.

А у 4060 еще и ширина шины — 128 бит. Для сравнения — столько было у двухгиговой 1050. У 1060 — 192. Все проблемы, связанные с этим, гуглятся.

Энергопотребление — это вообще для РФ не проблема, а рисовалка кадров работает почти нигде (говорю как владелец 4090).

Видео по теме: тыц, тыц, тыц.

Areso

22.07.2023 07:04+4что доказывают такие игры как Hogwarts Legacy и TLOU, лагающие на 8 гигах даже в 1080Р.

может, это в очередной раз доказывает, что создатели упомянутых игр решили болт положить на оптимизацию своих игр для ПК? Ну типа "и так сойдёт".

nidalee

22.07.2023 07:04-1Может. И что вы хотите с этим сделать? ПК — вторичная платформа.

Kneqj

22.07.2023 07:04+3@nidalee

Странно, что если где-то дроп фпс, всё, "вторичная" платформа и т.д.

Ладно, давайте я вам помогу быть более внимательным:Игроки на PS5 по-прежнему сталкиваются с проблемами при установке CoD: Modern Warfare

https://3dnews.ru/1072575Патч 1.05 для Diablo II: Resurrected на PS5 откатили из-за невозможности запустить игру

https://3dnews.ru/1051290/Недавний патч Assassin's Creed Valhalla испортил производительность на PS5

https://shazoo.ru/2020/11/28/102685/nedavnij-patch-assassins-creed-valhalla-isportil-proizvoditelnost-na-ps5Критический баг Anthem выключает PlayStation 4

https://informator.ua/ru/kriticheskij-bag-anthem-vyklyuchaet-playstation-4После патча 1.3 в Cyberpunk 2077 на PS4 вернулась старая проблема с текстурами

https://3dnews.ru/1048957/Такая вот лишь малая часть.

Ну вот, теперь вы видите вторичную и умирающую (не шучу) платформу соне с оптимизацией по остаточному принципу.

nidalee

22.07.2023 07:04Я от консолей далек настолько, насколько это возможно: последней консолью, которая у меня была, являлась PS1.

Но все, что вы привели — это баги, которые так или иначе исправлены.

"Исправлять" и уменьшать текстуры никто не будет. Нет, ну может кто-то будет, еденицы, но в целом такой задачи не стоит. Проще зарядить в рекомендуемые 3080 12GB и отдыхать. И попытки NVIDIA раскрутить свой дефицит шины и VRAM, как что-то не страшное, "да и вообще не нужна вам эта память, мы кешей добавим!" — никак ситуацию не улучшают, скорее наоборот.

А у NVIDIA никакого интереса добавлять памяти на потребительские карты нет — они ужеобосралисьобожглись с 3060 12GB которую каждый любитель потрогать неиронки покупал. Теперь памяти будет ровно столько, сколько хватит, чтобы откровенно не подыхать в лагах из-за прогрузки текстур, но как можно меньше, чтобы брали карты подороже для ML.

А "вторичная" она обьективно — почти все игры делаются в первую очередь под консоли, что видно обычно даже по интерфейсу и управлению. А вообще, много ли вы видели ПК-эксклюзивов? Я кроме таркова и россыпи стратежек (в основном от парадоксов) ничего и не припомню.

DuckyMomo

22.07.2023 07:04Теперь памяти будет ровно столько, сколько хватит, чтобы откровенно не подыхать в лагах из-за прогрузки текстур, но как можно меньше, чтобы брали карты подороже для ML.

Это не совсем верно: это как конвейер, у которого есть такие, характеристики как размер КЭШа, количество КП, ширина шины, частота видеопамяти и объём видеопамяти. Всё это влияет на производительность: если вы на конвейер большей длинны загрузите больше продукции, это не значит, что она быстрее будет доходить до конечного потребителя - ГПУ. Если смотреть шире, то текущая проблема с низкой "производительностью" заключается в том, что текущие игры писались и будут писаться концептуально "старые" поколения ВК, где все характеристики подбирались с т.з. баланса транзисторного бюджета (т.е. лишних транзисторов под КЭШ память нет, лучше наращивать количество CUDA ядер, соответственно чем больше КП, тем шире шина и больше частота памяти и объём памяти - тем лучше). Правда, AMD тоже уже вступила на эту "тёмную сторону силы", поэтому, очевидно, вектор развития графики у них будет такой же как и у NVIDIA. Дестктопные Нави 3.5 не будут принципиально более производительными, чем ВК 7XXX серии (в отличии от мобильных решений). Пока ситуацию спасает только то, что в консолях используют ГПУ АМД на старой архитектуре, но уже поговаривают, что PS5 и XBOX S - уже устарели и надо бы их обновить. :)

tommyangelo27

22.07.2023 07:04россыпи стратежек (в основном от парадоксов

Парадоксы и то хотели бы на консоли перейти, вон Стелларис уже портировали.

Areso

22.07.2023 07:04+6И что вы хотите с этим сделать?